Pythonでウェブスクレイピングによるニュース記事の取得(2026年ガイド)

Sora Fujimoto

AI Solutions Architect

26-Jan-2026

ウェブスクレイピングによるニュース記事の収集は、単純なHTMLパースから高度なエンジニアリングの課題へと進化しました。2026年現在、AIトレーニング、感情分析、市場インテリジェンスに必要なリアルタイムニュースデータの価値は過去最高です。このガイドでは、Pythonを使用して現代のアンチボット対策を回避し、スケールに応じたデータの整合性を維持する本番環境で使用可能なフレームワークを提供します。この記事の終わりには、一時的なスクリプトから信頼性の高いデータパイプラインへの移行方法を理解し、今日のデジタルメディアの複雑なセキュリティ層を効果的に扱うことができるようになります。

2026年のニューススクレイピングの現状

ニュース業界は、自動化されたクローラーに対する防御を大幅に強化しました。現在、主要な出典は行動分析、TLSファイントプリント、高度なCAPTCHAを含むマルチレイヤーのセキュリティを採用しています。ヘッドライン、著者、コンテンツの抽出という基本的な目的は変わっていませんが、実行方法は大きく変化しています。2026年において成功するためには、「ステルス最優先」のアプローチが求められ、スクレイパーは人間の行動を模倣して即時のIPブロックやレートリミットを回避しなければなりません。

| 課題 | スクレイピングへの影響 | 2026年の解決策 |

|---|---|---|

| 動的コンテンツ | JavaScriptの裏に隠されたコンテンツ | PlaywrightまたはSeleniumにステルスプラグインを組み合わせて使用 |

| 高度なアンチボット | ヘッダーに基づく即時のブロック | 適切な最適なUser-Agent管理とcurl-cffiの使用 |

| CAPTCHAの壁 | 自動スクリプトの硬い停止 | CapSolverなどの専門的な解決サービスの統合 |

| IPの評判 | データセンターのIPはすぐにブロックされる | 住宅用プロキシのローテーションとスマートリトライ |

ニュース抽出に必要なPythonスタック

信頼性の高いスクレイパーを構築するには、伝統的なパースライブラリと現代の自動化ツールの組み合わせが必要です。requestsやBeautifulSoupはまだ簡単なサイトで有効ですが、本番環境では数千の記事を効率的に処理するための非同期機能が求められます。

高性能なスクレイピングには、aiohttp-pythonが推奨されます。これは、メインの実行スレッドをブロックすることなく、複数の記事を同時に取得できるためです。現代のニュースサイトで使用される複雑なシングルページアプリケーション(SPA)に対処するには、Seleniumの統合方法やPlaywrightの知識が不可欠です。

コアライブラリ

- Beautiful Soup 4: HTMLパースの業界標準。Advanced Selector Strategiesを参照してください。

- Playwright: Seleniumよりも高速で信頼性が高く、2026年の基準に合ったブラウザ自動化ツール。

- Pandas: 抽出されたデータのクリーニングと構造化に不可欠です。

ニュースサイトでのreCAPTCHA v2とv3の回避方法

高トラフィックのニュースポータルをスクレイピングする際、最も頻繁に遭遇する課題の一つはreCAPTCHAの出現です。これは、インタラクティブな「I'm not a robot」チェックボックス(v2)または非表示のスコアリングシステム(v3)のいずれかであり、自動スクリプトを停止するように設計されています。

データフローを継続させるために、これらの課題をプログラム的に処理する信頼性の高いソリューションが必要です。CapSolverは、reCAPTCHA v2とreCAPTCHA v3の両方を解決するシームレスなAPIを提供します。このサービスを統合することで、スクレイパーはこれらのチェックを回避するための必要なトークンを取得でき、強力なセキュリティプロンプトに直面してもデータ収集プロセスが中断されません。

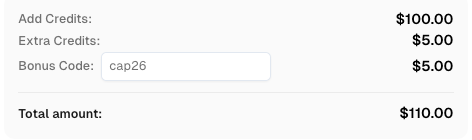

CapSolverに登録する際、コード

CAP26を使用してボーナスクレジットを取得してください!

本番環境で使用可能なスクレイピングワークフロー

プロフェッショナルなニューススクレイパーは、構造化されたライフサイクルに従います。単なるGETリクエストではなく、そのリクエストが行われる全体の環境が重要です。

- リクエストの初期化: 実際のブラウザに一致するヘッダーを設定します。これには

User-Agent、Accept-Language、Refererの設定が含まれます。現在のブラウザ文字列形式については、MDN User-Agentガイドを参照してください。 - アンチボットナビゲーション: プロキシのローテーションとリクエスト間のジッターデリーやスマートリトライを実装してIPブロックを回避します。

- コンテンツ抽出: CSSセレクターやXPathを使用して、

article_body、published_time、author_nameなどの特定のデータポイントをターゲットにします。 - データ正規化: 抽出されたテキストをクリーニングし、日付をISO形式に変換し、欠損フィールドを適切に処理します。

例: ステルスとCAPTCHA解決によるスクレイピング

以下は、現代のニューススクレイパーの概念的なワークフローです。現実的なシナリオでは、CAPTCHAが検出された時点でCAPTCHA解決サービスを統合します。

python

import asyncio

from capsolver_python import RecaptchaV3Task

async def scrape_protected_news(url):

# 1. reCAPTCHA v3用にCapSolverを初期化

solver = RecaptchaV3Task(api_key="YOUR_CAPSOLVER_API_KEY")

task = solver.create_task(

website_url=url,

website_key="TARGET_SITE_KEY",

page_action="news_article"

)

result = await solver.join_task(task.get("taskId"))

token = result.get("solution", {}).get("gRecaptchaResponse")

# 2. トークンを使用して記事コンテンツを取得

# ... トークンを含むリクエスト送信のロジック ...

print(f"成功裏に保護を回避しました: {url}")

# 例の使用方法

# asyncio.run(scrape_protected_news("https://example-news-site.com/article-1"))ニューススクレイピングインフラのスケーリング

10記事から10,000記事への要件の拡大に伴い、インフラもそれに応じてスケーリングする必要があります。これは、ローカル実行からクラウドベースの分散システムへの移行を意味します。RabbitMQやRedisなどのメッセージキューを使用して、複数のワーカーノードでスクレイピングタスクを管理できます。

スクレイパーの維持には継続的なモニタリングが必要です。ニュースサイトは頻繁にHTML構造を変更するため、セレクターが破損する可能性があります。スクレイパーが「headline」要素を見つけることができなくなったときにアラートを送信する自動テストを実装することは、2026年の重要なベストプラクティスです。詳細については、ブロックされずにスクレイピングする方法に関するガイドを参照してください。

主なポイント

- ステルスは必須です: 2026年現在、単純なスクレイパーは即座にブロックされます。TLS準拠のクライアントと現実的なヘッダーを使用してください。

- CAPTCHA解決は不可欠です: 高価値なニュースデータはreCAPTCHA v2/v3で保護されていることが多く、本番環境での信頼性にはCapSolverなどのツールが必要です。

- 非同期は効率的です:

aiohttpやhttpxを使用して、パフォーマンスのボトルネックを回避しながら高容量のスクレイピングを処理してください。 - 構造が重要です: いつでもデータを標準フォーマット(JSONやSchema.org)に正規化して、AIや分析ツールに準備を整えてください。

よくある質問

2026年のニュース記事のウェブスクレイピングは合法ですか?

一般的に、個人または研究目的で公開されているニュースデータをスクレイピングすることは許可されていますが、サイトのrobots.txtに準拠し、サービス妨害を起こさないことを確認してください。商業的な使用は、EU AI Actなどの地域の規制に従う必要があります。

- 詳細については、このブログを参照してください: ウェブスクレイピングは合法ですか?

ニュースホームペーの「無限スクロール」をどう処理しますか?

無限スクロールには、Playwrightなどのブラウザ自動化ツールが必要です。新しい要素がDOMにロードされるまでスクロールアクションをシミュレートし、その後リンクを抽出するロジックを実装する必要があります。

スクレイピング中にreCAPTCHA v3を解決する最良の方法は?

最も効果的な方法は、CapSolverなどのAPIベースの解決サービスを使用することです。これは、正当なユーザーを模倣する高スコアのトークンを提供し、手動の介入なしに非表示のチェックを通過させることができます。

スクレイパーのセレクターをどのくらい頻繁に更新すべきですか?

サイトによって異なりますが、主要なニュースポータルは3〜6か月ごとにレイアウトを変更します。これらの変更を即座に検出するには、自動モニタリングが最善の方法です。

ペイウォールの裏側のニュースをスクレイピングできますか?

ペイウォールの裏側のニュースをスクレイピングするには、アクティブなサブスクリプションとセッション管理(クッキー)が必要です。スクレイピング活動が提供者の利用規約に準拠していることを常に確認してください。

ベーシックセレクターを超えた高度なデータ抽出

2026年において、CSSセレクターに依存することはリスクの高い戦略です。現代のニュースプラットフォームは、単純なスクレイパーを妨げるためにオブfuscatedなクラス名や動的ID生成をよく使用します。真正に耐障害性のあるシステムを構築するためには、「ハイブリッド抽出」モデルを実装することを検討する必要があります。これは、伝統的なDOMトラバーサルと機械学習ベースのパースを組み合わせたものです。

例えば、多くのニュース記事はSchema.orgの語彙に従っています。itemprop="articleBody"やitemprop="headline"をターゲットにすることで、下層のHTML構造にかかわらずクリーンなデータを抽出できます。サイトに構造化データがない場合、HTMLをクリーン化したバージョンから主要なコンテンツブロックを識別する軽量なLLMを使用することで、手動でセレクターをメンテナンスする時間を節約できます。このアプローチにより、サイトが大幅にリデザインされても、データパイプラインが最小限の調整で機能し続けます。

マルチメディアとリッチコンテンツの処理

ニュース記事はもはやテキストだけではありません。埋め込み動画、インタラクティブなチャート、ソーシャルメディアの投稿を含みます。このような「リッチ」データを抽出するには、これらの埋め込みのソースURLを識別し、追跡する必要があります。画像の場合、altテキストとsrcset属性に記載されている最高解像度のソースURLを取得することがベストプラクティスです。このレベルの詳細は、テキストと視覚的文脈の両方を必要とするマルチモーダルAIモデルのトレーニングに特に価値があります。

分散アーキテクチャでのスケーリング

スクレイピングのニーズが拡大するにつれて、単一のマシンは最終的にボトルネックになります。企業レベルのニュース収集には、分散アーキテクチャへの移行が必然的です。これには、「発見」フェーズと「抽出」フェーズの分離が含まれます。

- 発見ボット: この軽量なボットは、RSSフィード、サイトマップ、ホームペーの継続的なモニタリングを行い、新しい記事URLを中央キューにプッシュします。

- 抽出ワーカー: これらはリソースを多く消費するワーカーで、実際の取得とパースを担当します。DockerとKubernetesによるコンテナ化アプローペーを使用することで、現在のニュース量に応じてワーカーのスピンアップ/スピンダウンが可能になります。

- プロキシ層: 高度なプロキシ管理システムは、あらゆる分散スクレイパーの基盤です。これは、自動ローテーション、異なるIPプールの成功レートのトラッキング、およびターゲットサイトの感度に応じてデータセンタープロキシと住宅用プロキシの切り替えを処理する必要があります。

未来に向けての構築に関する最後の考え

ウェブスクレイピングの分野は、継続的な猫と鼠のゲームです。アンチボット技術がさらに高度化するにつれて、使用するツールも適応する必要があります。2026年において、成功するデータプロジェクトと失敗するプロジェクトの差は、通常、回避戦略の信頼性にかかっています。ヘッドレスブラウザの高評判スコアを維持するか、CapSolverなどの専門サービスを活用してreCAPTCHA v2/v3を処理するか、どちらかにかかっています。あなたのスタックのあらゆるレイヤーが耐障害性を最適化する必要があります。

ニューススクレイパーの構築は、単なるコーディングタスクではありません。逆エンジニアリングとインフラ管理の実践です。このガイドで提示された原則—ステルス、スケーラビリティ、倫理的責任—に従うことで、時代に耐えられるデータパイプラインを構築し、次世代のAIと分析アプリケーションに必要な高品質な情報を提供できるようになります。

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

即時データスカッパーのツール:コードなしでウェブデータを高速に抽出する方法

2026年用の最高のインスタントデータスラッパーのツールを発見してください。コードなしでウェブデータを迅速に抽出する方法を学びましょう。自動抽出用の最高の拡張機能とAPIを使用して。

Nikolai Smirnov

28-Jan-2026

2026年のIPブロック:仕組みと実用的な回避方法

2026年においてIPブロックを回避する方法を、当社の包括的なガイドを通じて学びましょう。現代のIPブロック技術や住宅プロキシーやCAPTCHAソルバーなどの実用的な解決策を発見してください。

Sora Fujimoto

26-Jan-2026

Pythonでウェブスクレイピングによるニュース記事の取得(2026年ガイド)

2026年にPythonでニュース記事のウェブスクリーピングをマスターする。reCAPTCHA v2/v3をCapSolverで解く方法を学び、スケーラブルなデータパイプラインを構築する。

Sora Fujimoto

26-Jan-2026

MaxunでCapSolver統合を使用してCaptchaを解決する方法

CapSolverとMaxunを統合して実際のウェブスクレイピングを行うための実用的なガイド。reCAPTCHA、Cloudflare Turnstile、およびCAPTCHAで保護されたサイトを扱う方法を、事前認証とロボットワークフローを使用して学びましょう。

Sora Fujimoto

21-Jan-2026

Captchaをブラウザ4で解く方法とCapSolverの統合

高スループットブラウザ4の自動化と、大規模なウェブデータ抽出におけるCAPTCHAチャレンジを処理するためのCapSolverの組み合わせ。

Sora Fujimoto

21-Jan-2026

スクレイピングボットとは何か、そしてどのように構築するか

スクレイピングボットとは何かを学び、自動データ抽出用にそれを構築する方法を学びましょう。最高のツール、セキュリティナビゲーションのテクニック、および倫理的なスクレイピングの実践を探ってみましょう。

Emma Foster

16-Jan-2026