WebスクレイピングのCheerioとNode.js 2026

Sora Fujimoto

AI Solutions Architect

20-Nov-2025

ウェブスクラッピングは、ウェブサイトからデータを抽出するための強力な技術であり、データ分析、市場調査、コンテンツ集約で広く使用されています。2026年現在、ウェブスクラッピングにCheerioとNode.jsを活用し続けることは、人気があり効率的なアプローチです。この記事では、CheerioとNode.jsを用いたウェブスクラッピングのプロセスについて詳しく説明し、包括的なガイドと実践的な例を提供します。

目次

- Cheerioとは何ですか?

- 前提条件

- プロジェクトのセットアップ

- CheerioのセレクターAPI

- スクレイピングスクリプトの作成

- スクリプトの実行

- Cheerioによるウェブスクラッピングの課題

- ウェブスクラッピングにおけるCAPTCHAの処理

- ダイナミックページの処理

- 結論

Cheerioとは何ですか?

Cheerioは、サーバーサイドアプリケーション向けに設計された、コアjQueryの高速で柔軟かつ軽量な実装です。Node.js環境でHTMLドキュメントを解析および操作するため、jQueryに似た構文を使用できます。ブラウザベースのツールとは異なり、Cheerioは実際のウェブレンダリングを行わず、HTML文字列を直接操作するため、多くのスクラッピングタスクにおいて非常に効率的です。ちなみに、Puppeteerは、Cheerioスクラッピングの優れた代替手段です。

前提条件

コードに取り組む前に、システムにNode.jsとnpm(Nodeパッケージマネージャー)がインストールされていることを確認してください。まだインストールされていない場合は、Node.js公式サイトからダウンロードしてインストールできます。

プロジェクトのセットアップ

ステップ1: 新しいプロジェクトディレクトリを作成する

まず、プロジェクト用の新しいディレクトリを作成し、Node.jsプロジェクトとして初期化してください:

bash

mkdir web-scraping

cd web-scraping

npm init -y-yフラグは、すべてのプロンプトに「はい」を自動的に選択し、デフォルトのpackage.jsonファイルを設定します。

ステップ2: 依存関係をインストールする

次に、HTTPリクエストを行うためのaxiosとHTMLを解析するためのcheerioなどの必要な依存関係をインストールしてください:

bash

npm install axios cheerio繰り返し失敗する面倒なCAPTCHAを解決することができないのでは?

CapsolverのAI駆動の自動ウェブアンブロッキング技術で、スムーズなCAPTCHAの解決を実現してください!

トップCAPTCHAソリューションを手に入れるための< u >ボーナスコード< /u >を入手してください;CapSolver. |: WEBS。コードを redemption した後、各充電で追加の5%のボーナスが得られ、無制限です。

CheerioのセレクターAPI

Cheerioは、サーバーサイドアプリケーション向けに設計された、コアjQueryの高速で柔軟かつ軽量な実装です。Node.js環境でHTMLドキュメントを操作するため、jQueryに似た構文を使用できます。

以下は、CheerioのセレクターAPIの詳細な説明とコード例です:

-

HTMLドキュメントの読み込み:

javascriptconst cheerio = require('cheerio'); const html = ` <html> <head> <title>例</title> </head> <body> <h1 class="title">こんにちは、世界!</h1> <div id="content"> <p>これは段落です。</p> <a href="https://example.com">リンク</a> </div> </body> </html> `; const $ = cheerio.load(html); -

要素の選択:

-

要素セレクター:

javascriptconst h1 = $('h1'); // すべての<h1>要素を選択 console.log(h1.text()); // 出力: こんにちは、世界! -

クラスセレクター:

javascriptconst title = $('.title'); // class="title"を持つ要素を選択 console.log(title.text()); // 出力: こんにちは、世界! -

IDセレクター:

javascriptconst content = $('#content'); // id="content"を持つ要素を選択 console.log(content.html()); // 出力: <p>これは段落です。</p><a href="https://example.com">リンク</a> -

属性セレクター:

javascriptconst link = $('a[href="https://example.com"]'); // 特定のhref属性を持つ<a>要素を選択 console.log(link.text()); // 出力: リンク

-

-

要素の移動と操作:

-

要素の移動:

javascript$('p').each((index, element) => { console.log($(element).text()); // 各<p>要素のテキストコンテンツを出力 }); -

要素コンテンツの変更:

javascript$('h1.title').text('新しいタイトル'); // <h1>要素のテキストコンテンツを変更 console.log($('h1.title').text()); // 出力: 新しいタイトル -

要素の追加と削除:

javascript$('#content').append('<p>別の段落。</p>'); // #content内に新しい<p>要素を追加 console.log($('#content').html()); // 出力: <p>これは段落です。</p><a href="https://example.com">リンク</a><p>別の段落。</p> $('a').remove(); // すべての<a>要素を削除 console.log($('#content').html()); // 出力: <p>これは段落です。</p><p>別の段落。</p>

-

これらの例は、Node.js環境内でjQueryに似た方法でHTML要素を選択、移動、操作する方法を示しています。

スクレイピングスクリプトの作成

プロジェクトディレクトリにscraper.jsという名前のファイルを作成してください。このファイルには、ターゲットウェブサイトからデータをスクレイピングするスクリプトが含まれます。scraper.jsに次のコードを追加してください:

javascript

const axios = require('axios');

const cheerio = require('cheerio');

// ターゲットURL

const url = 'https://example.com';

async function fetchData() {

try {

// HTTPリクエストを送信してHTMLコンテンツを取得

const { data } = await axios.get(url);

// HTMLドキュメントをCheerioにロード

const $ = cheerio.load(data);

// HTMLからデータを抽出

const title = $('title').text();

const headings = [];

$('h1, h2, h3').each((index, element) => {

headings.push($(element).text());

});

// 抽出されたデータを出力

console.log('タイトル:', title);

console.log('見出し:', headings);

} catch (error) {

console.error('データ取得エラー:', error);

}

}

fetchData();コードの説明

- モジュールのインポート: スクリプトは

axiosとcheerioモジュールのインポートから始まります。 - ターゲットURLの定義: スクレイピング対象のウェブサイトのURLが定義されます。

- データの取得:

fetchData関数はaxiosを使用してターゲットURLにHTTP GETリクエストを送信します。応答データ(HTMLコンテンツ)はCheerioにロードされます。 - HTMLの解析: CheerioのjQueryに似た構文を使用して、<title>タグや

、

、

タグのコンテンツが抽出されます。

- 結果の出力: 抽出されたデータはコンソールにログ出力されます。

スクリプトの実行

スクレイピングスクリプトを実行するには、ターミナルで次のコマンドを実行してください:

bash

node scraper.jsすべての設定が正しい場合、コンソールにスクレイピングされたウェブページのタイトルとすべての見出しタグのコンテンツが表示されるはずです。

Cheerioによるウェブスクラッピングの課題

Cheerioはウェブスクラッピングにおいていくつかの利点を提供しますが、開発者にとっていくつかの課題もあります:

-

ダイナミックウェブサイトとJavaScript: Cheerioの主な課題の一つは、JavaScriptに依存するダイナミックなウェブサイトの処理です。現代のウェブサイトは、初期ページロード後にJavaScriptを使ってコンテンツを動的に読み込むことが一般的です。Cheerioは静的HTMLを解析するため、動的に生成されたコンテンツをキャプチャできない可能性があり、スクラッピングの効果を制限する可能性があります。

-

スクラッピング防止策: スクレイピングを防ぐために、ウェブサイトはさまざまな技術を採用しています:

- CAPTCHA: スクレイピング中に遭遇する大きな問題であり、人間とロボットを区別するように設計されています。CAPTCHAは画像認識やテキスト入力などのタスクを完了する必要があります。

- IPブロック: スクレイピング活動に関連するIPアドレスをブロックすることで、過剰なリクエストを防止します。

- User-Agentの検出: 非標準的または疑わしいUser-Agentを検出することで、ウェブサイトはスカッパーを識別しブロックします。

- ダイナミックウェブページ: JavaScriptで動的にコンテンツを生成するウェブサイトは、Cheerioの静的解析では直接アクセスできない可能性があるため、課題になります。

ウェブスクラッピング開発者として、これらの課題を理解することは、効果的に対処するために重要です。これらの問題の解決策には多くの戦略があります。次のセクションでは、スクラッピングにおける最大の2つの問題の解決方法、CAPTCHAの処理とダイナミックページの対処方法について説明します。

ウェブスクラッピングにおけるCAPTCHAの処理

CAPTCHAは、ウェブスクラッピングにおいて大きな課題です。これは、人間とロボットを区別するように設計されています。遭遇した場合、スクリプトはそれらを解決する必要があります。スケーラブルなウェブスクラッピングのために、CapSolverのようなソリューションは、高い精度と高速なCAPTCHA解決能力を提供します。

CAPTCHAソルバーの統合

スクリプティングスクリプトにさまざまなCAPTCHA解決サービスを統合できます。ここでは、CapSolverに焦点を当てます。

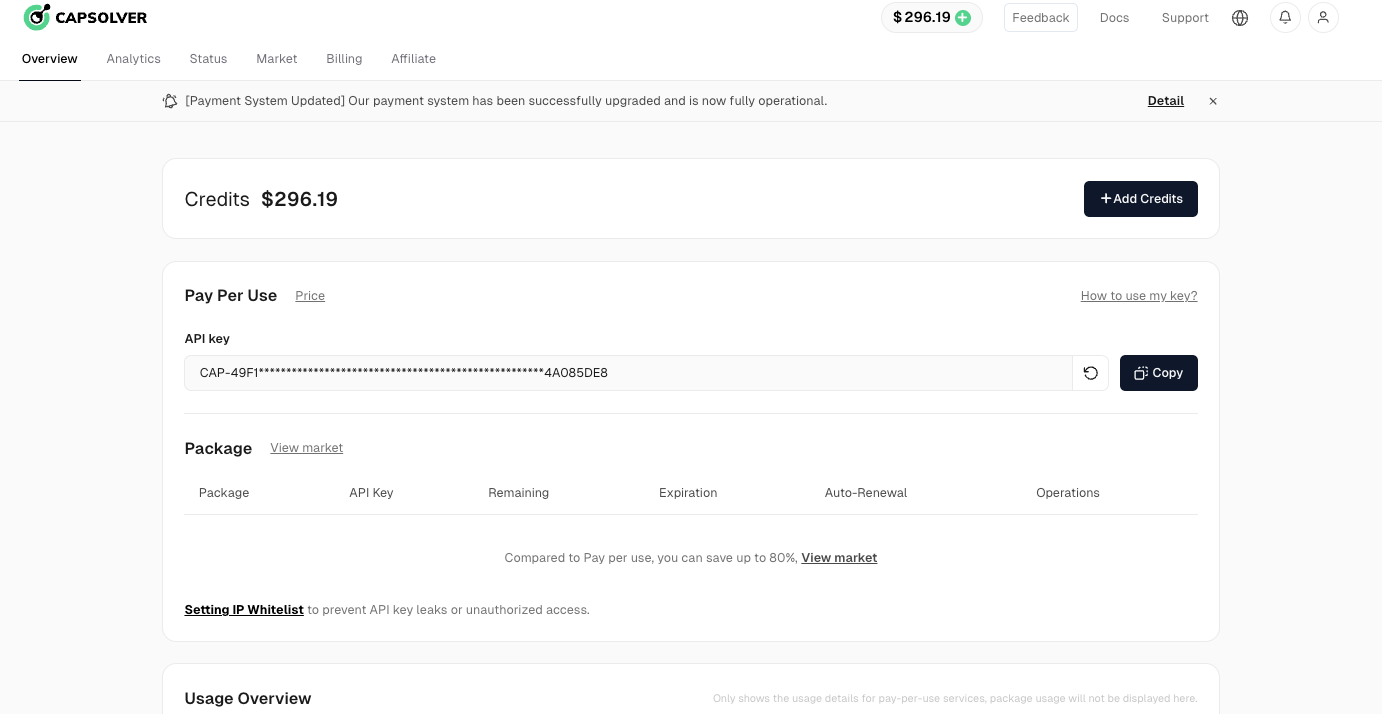

ステップ1: CapSolverに登録する

まず、CapSolverユーザー管理画面にアクセスし、アカウントを登録してください。

ステップ2: APIキーを取得する

登録後、ホームページのパネルからAPIキーを取得してください。

CapSolver統合のサンプルコード

CapSolverをウェブスクラッピングや自動化プロジェクトに統合するのは簡単です。以下は、CapSolverのAPIを使用するPythonの例です:

python

# pip install requests

import requests

import time

# TODO: あなたの設定を記入してください

api_key = "YOUR_API_KEY" # あなたのCapSolver APIキー

site_key = "6Le-wvkSAAAAAPBMRTvw0Q4Muexq9bi0DJwx_mJ-" # ターゲットサイトのreCAPTCHAサイトキー

site_url = "" # あなたのターゲットサイトのURL

def solve_captcha():

payload = {

"clientKey": api_key,

"task": {

"type": 'ReCaptchaV2TaskProxyLess',

"websiteKey": site_key,

"websiteURL": site_url

}

}

res = requests.post("https://api.capsolver.com/createTask", json=payload)

resp = res.json()

task_id = resp.get("taskId")

if not task_id:

print("タスクの作成に失敗しました:", res.text)

return

print(f"taskIdを取得しました: {task_id} / 結果を取得中...")

while True:

time.sleep(3) # 待ち時間

payload = {"clientKey": api_key, "taskId": task_id}

res = requests.post("https://api.capsolver.com/getTaskResult", json=payload)

resp = res.json()

status = resp.get("status")

if status == "ready":

return resp.get("solution", {}).get('gRecaptchaResponse')

if status == "failed" or resp.get("errorId"):

print("解決に失敗しました!応答:", res.text)

return

captcha_token = solve_captcha()

print(captcha_token)このスクリプトは、CapSolverのAPIを使用してreCAPTCHAチャレンジを解決する方法を示しています。このようなソリューションをスクラッピングプロジェクトに統合することで、CAPTCHAの自動解決によりデータ抽出プロセスをスムーズにし、効率を向上させます。

ダイナミックページの処理

JavaScriptでコンテンツが動的に読み込まれるウェブページの場合、ヘッドレスブラウザであるpuppeteerを使用する必要があります。Puppeteerは、実際のユーザーがウェブをブラウズするのをシミュレートし、JavaScriptの実行後に表示されるコンテンツをスクレイピングできます。

Puppeteerの使用例

Cheerioと組み合わせてPuppeteerを使用する方法の簡単な例を以下に示します:

javascript

const puppeteer = require('puppeteer');

const cheerio = require('cheerio');

async function fetchData() {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://example.com');

const content = await page.content();

const $ = cheerio.load(content);

const title = $('title').text();

const headings = [];

$('h1, h2, h3').each((index, element) => {

headings.push($(element).text());

});

console.log('タイトル:', title);

console.log('見出し:', headings);

await browser.close();

}

fetchData();このスクリプトは、ヘッドレスブラウザを起動し、ターゲットURLに移動し、JavaScriptの実行後にHTMLコンテンツを取得します。その後、Cheerioを使用してHTMLを解析し、必要なデータを抽出します。

結論

CheerioとNode.jsを用いたウェブスクラッピングは、ウェブサイトからデータを効率的に抽出するための強力な組み合わせです。CheerioのjQueryに似た構文により、HTMLドキュメントを簡単にナビゲートし、操作できます。一方、Node.jsはHTTPリクエストを処理し、データを処理するための堅牢な環境を提供します。

しかし、開発者はダイナミックコンテンツやスクラッピング防止策(CAPTCHAなど)によって生じる課題に注意する必要があります。CapSolverのようなソリューションを統合することで、これらの障壁を乗り越えることができ、スクリプトの効果と信頼性を保証します。

この記事が2026年のウェブスクラッピングの開始に役立ち、プロジェクトに役立つデータを提供できることを願っています!

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

AI-LLM: リスクコントロールのための画像認識とCAPTCHA解決の未来のソリューション

LLMsがグラフィカルCAPTCHAの解決をどのように変革するかの詳細な探求:ゼロショット推論とCNNの精度を融合した現代のリスク管理へのアプローチ

Sora Fujimoto

05-Dec-2025

ScraplingとCapSolverを用いたウェブスクラッピング時のキャプチャの解き方

Scrapling + CapSolver は、ReCaptcha v2/v3 および Cloudflare Turnstile のバイパスを備えた自動スクリーピングを可能にします。

Sora Fujimoto

05-Dec-2025

ウェブスクリーニングにおけるキャプチャの解決 | セレニウムとパイソンによるウェブスクリーニング

この記事では、SeleniumとPythonを使用してウェブスクレイピングに慣れ親しむことになり、プロセスに関連するCaptchaを解決する方法を学び、効率的なデータ抽出に役立ちます。

Sora Fujimoto

04-Dec-2025

ウェブスクラピングをGolangでCollyを使用して

このブログでは、Collyライブラリを使用したウェブスクリーピングの世界を探求します。ガイドは、Go言語プロジェクトを設定し、Collyパッケージをインストールするのをサポートすることから始まります。その後、ウィキペディアのページからリンクを抽出する基本的なスクリーパーを作成する手順を説明し、Collyの使いやすさと強力な機能を示します。

Lucas Mitchell

04-Dec-2025

ウェブスクラピングとは何か | 一般的な使用ケースと問題点

ウェブスクリーピングを知る:そのメリットを学び、簡単に課題に取り組み、CapSolverでビジネスを成長させましょう。

Sora Fujimoto

03-Dec-2025

パペットイアとは?ウェブスクラビングにおける使い方|完全ガイド 2026

この完全なガイドでは、パペットゥイアとは何か、そしてウェブスクラピングで効果的に使う方法について詳しく解説します。

Anh Tuan

03-Dec-2025