Bahasa Pemrograman Terbaik untuk Web Scraping pada 2026

Emma Foster

Machine Learning Engineer

19-Dec-2025

TL;DR

- Python tetap menjadi bahasa pemrograman yang paling fleksibel dan ramah pemula untuk web scraping karena ekosistem perpustakaannya yang kaya seperti Scrapy dan BeautifulSoup.

- Untuk operasi web scraping volume tinggi dan kritis kinerja, bahasa yang dikompilasi seperti Go dan Rust menawarkan kecepatan dan konkurensi yang lebih baik, menjadikannya pilihan terbaik untuk ekstraksi data skala besar pada 2026.

- JavaScript (Node.js) penting untuk mengambil data dari situs web modern yang dibangun dengan kerangka kerja Aplikasi Halaman Tunggal (SPA), karena menangani rendering sisi klien secara alami.

- Pemilihan bahasa pemrograman lebih sekunder dibandingkan mengatasi ukuran anti-bot; alat seperti CapSolver diperlukan untuk memastikan keandalan proyek web scraping apa pun.

Pendahuluan

Memilih bahasa pemrograman yang tepat adalah keputusan dasar untuk setiap proyek web scraping yang sukses. "Bahasa terbaik" bukanlah sesuatu yang tetap; itu adalah variabel dinamis yang bergantung sepenuhnya pada kebutuhan spesifik proyek, seperti skala, kecepatan, dan kompleksitas situs web yang dituju. Panduan komprehensif ini ditujukan untuk pengembang, ilmuwan data, dan analis bisnis yang merencanakan atau memperluas upaya ekstraksi data mereka pada 2026. Kami akan menganalisis kekuatan dan kelemahan bahasa pemrograman teratas, membantu Anda memilih alat yang optimal untuk tantangan web scraping unik Anda. Dengan memahami lingkungan modern, Anda dapat membangun alur data yang lebih efisien dan andal.

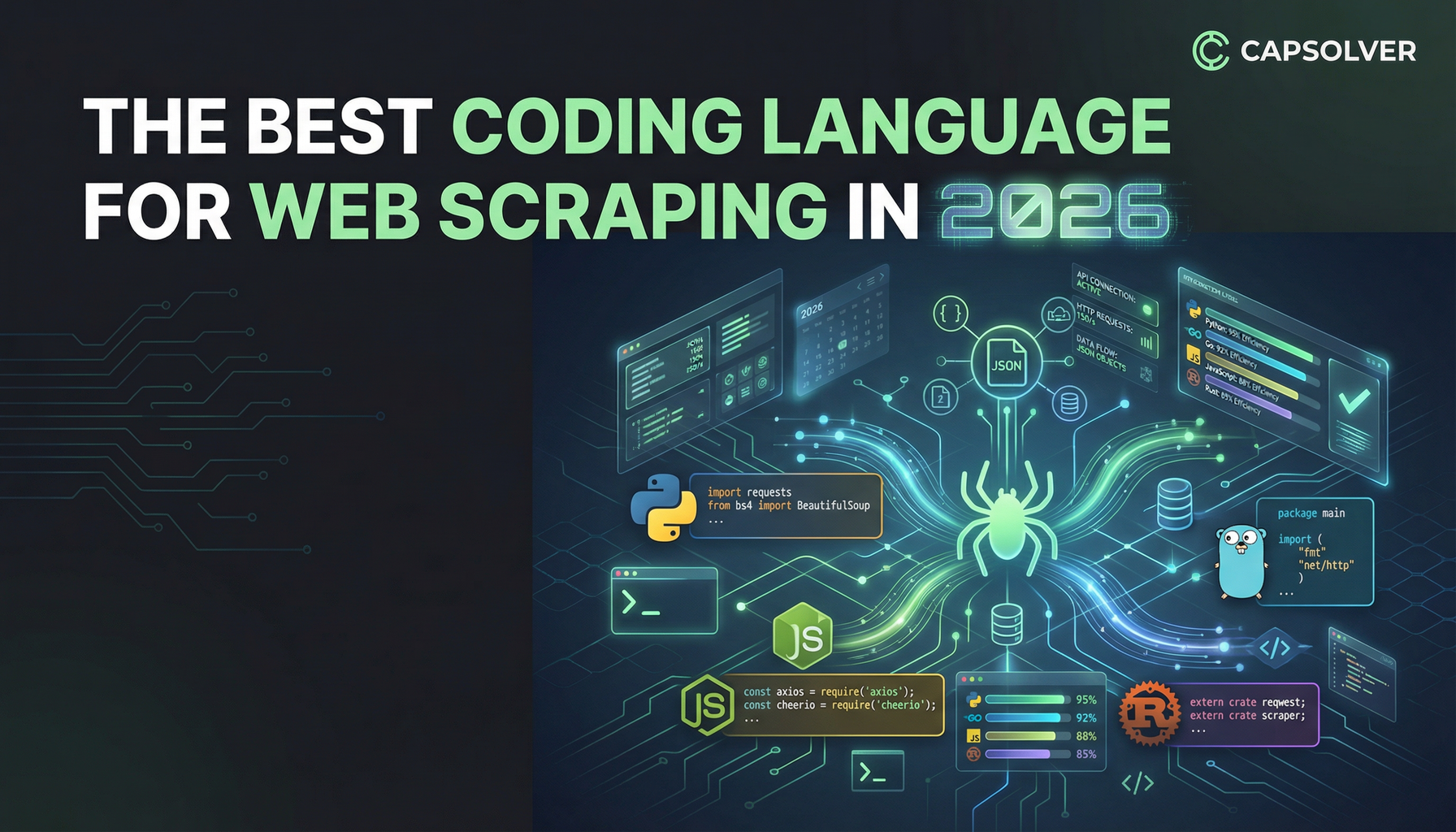

Pesaing Teratas: Penjelasan Mendalam tentang 6+ Bahasa

Perkembangan web, dengan ketergantungannya yang semakin besar pada JavaScript dan pertahanan anti-bot yang canggih, telah mengubah kebutuhan yang ditempatkan pada sebuah bahasa pemrograman yang digunakan untuk web scraping. Meskipun beberapa bahasa unggul dalam pengembangan cepat, yang lain mendominasi dalam kinerja mentah dan konkurensi. Di sini, kami menjelajahi opsi terkemuka untuk ekstraksi data pada 2026.

Python: Raja Ekstraksi Data

Python telah menduduki posisi teratas dalam komunitas web scraping selama lebih dari satu dekade, dan dominasinya terus berlanjut hingga 2026. Sintaksisnya yang jelas dan mudah dibaca mengurangi waktu pengembangan secara signifikan, menjadikannya bahasa pemrograman yang ideal untuk proyek prototipe cepat dan kecil-menengah. Ekosistem perpustakaan yang luas adalah keunggulan terbesar Python, menyediakan alat khusus untuk setiap tahap proses scraping. Perpustakaan seperti Scrapy menawarkan kerangka kerja lengkap untuk proyek skala besar, sementara BeautifulSoup sempurna untuk parsing HTML yang sederhana.

Kelebihan untuk Web Scraping:

- Ekosistem yang Luas: Kumpulan perpustakaan yang luar biasa (Scrapy, BeautifulSoup, Requests, Selenium).

- Kemudahan Penggunaan: Sintaksis sederhana dan kurva pembelajaran yang rendah untuk pengembang pemula.

- Dukungan Komunitas: Komunitas yang besar dan aktif memberikan pembaruan dan solusi yang terus-menerus.

Kekurangan untuk Web Scraping:

- Batasan Kinerja: Global Interpreter Lock (GIL) membatasi eksekusi paralel sejati, yang dapat memperlambat permintaan volume tinggi dan konkuren.

- Penggunaan Memori: Proses Python bisa memakan memori lebih banyak dibandingkan bahasa yang dikompilasi.

Kasus Penggunaan Terbaik: Pengembangan cepat, alur kerja analisis data, dan proyek di mana kecepatan pengembangan lebih diutamakan daripada kecepatan eksekusi mentah.

JavaScript (Node.js): Pilihan Wajib untuk Konten Dinamis

Web modern dibangun berdasarkan JavaScript, menjadikan Node.js semakin penting sebagai bahasa pemrograman untuk web scraping. Node.js memungkinkan pengembang menjalankan JavaScript di sisi server, yang sangat penting untuk berinteraksi dengan situs web yang bergantung berat pada rendering sisi klien (SPAs). Alat seperti Puppeteer dan Playwright menyediakan API tingkat tinggi yang kuat untuk mengontrol browser tanpa kepala, secara efektif meniru interaksi pengguna nyata dengan halaman. Kemampuan ini tidak bisa ditawar lagi ketika menghadapi konten dinamis yang kompleks.

Kelebihan untuk Web Scraping:

- Penanganan Dinamis Alami: Menjalankan JavaScript sisi klien secara langsung, menyelesaikan masalah rendering.

- I/O Asinkron: Node.js secara inheren tidak blok, menjadikannya sangat efisien untuk permintaan jaringan konkuren.

- Stack yang Seragam: Pengembang dapat menggunakan satu bahasa pemrograman untuk tugas frontend dan backend.

Kekurangan untuk Web Scraping:

- Overhead Sumber Daya: Penggunaan browser tanpa kepala memakan CPU dan memori yang jauh lebih besar daripada permintaan HTTP sederhana.

- Kematangan Perpustakaan: Meskipun berkembang, ekosistem perpustakaan khusus untuk scraping kurang matang dibandingkan Python.

Kasus Penggunaan Terbaik: Scraping Aplikasi Halaman Tunggal (SPAs), situs dengan muatan AJAX berat, dan proyek yang memerlukan simulasi interaksi pengguna kompleks.

Go (Golang): Pemenang Kecepatan dan Konkurensi

Go, yang dikembangkan oleh Google, adalah bahasa pemrograman yang disukai untuk infrastruktur kritis kinerja, dan manfaatnya langsung terasa pada scraping web skala besar. Model konkurensi bawaan Go, berbasis goroutines, memungkinkan pengembang mengelola ribuan permintaan simultan dengan overhead minimal. Ini membuatnya jauh lebih cepat dan efisien sumber daya dibandingkan Python untuk tugas volume tinggi. Ketika kecepatan mentah dan penggunaan sumber daya yang efisien adalah prioritas utama, Go adalah pemenang jelas pada 2026.

Kelebihan untuk Web Scraping:

- Konkurensi yang Unggul: Goroutines memungkinkan pemrosesan paralel yang sangat efisien dan ringan.

- Sangat Cepat: Kinerja bahasa yang dikompilasi mengurangi waktu eksekusi secara signifikan.

- Jejak Memori Rendah: Sangat baik untuk menjalankan banyak scraper pada sumber daya server terbatas.

Kekurangan untuk Web Scraping:

- Perpustakaan Tingkat Tinggi yang Lebih Sedikit: Memerlukan lebih banyak coding manual untuk tugas seperti parsing HTML dibandingkan Python.

- Lebih Verbose: Lebih verbose daripada Python, menyebabkan siklus pengembangan yang sedikit lebih panjang.

Kasus Penggunaan Terbaik: Proyek scraping web skala besar, aliran data real-time, dan sistem di mana efisiensi biaya sumber daya awan adalah metrik utama.

Java: Pekerja Enterprise

Java adalah bahasa pemrograman yang kuat dan matang yang unggul dalam membangun aplikasi enterprise besar, stabil, dan berjalan lama. Meskipun mungkin bukan pilihan pertama untuk skrip scraping web yang cepat dan sederhana, stabilitasnya dan alat yang luas membuatnya cocok untuk pipeline data yang kompleks dan kritis. Perpustakaan seperti Jsoup dan Apache HttpClient menyediakan alat yang andal untuk ekstraksi data. Kekuatan tipe data yang kuat dan pengumpulan sampah yang matang berkontribusi pada keandalan sistem skala besar.

Kelebihan untuk Web Scraping:

- Stabilitas dan Skalabilitas: Sangat baik untuk membangun sistem scraping yang sangat stabil dan terdistribusi.

- Ekosistem yang Matang: Alat yang andal dan dukungan tingkat enterprise.

Kekurangan untuk Web Scraping:

- Kecepatan Pengembangan: Lebih verbose dan lebih lambat untuk ditulis dibandingkan Python atau Go.

- Kinerja: Secara umum lebih lambat dari Go, meskipun lebih cepat dari Python standar untuk tugas CPU-bound.

Kasus Penggunaan Terbaik: Agregasi data tingkat enterprise, ekstraksi data keuangan, dan proyek yang memerlukan stabilitas tinggi dan pemeliharaan jangka panjang.

Ruby: Pilihan Ramah Pengembang

Ruby, dengan fokusnya pada kebahagiaan pengembang dan sintaks yang elegan, adalah pilihan yang kuat untuk tugas scraping web yang lebih kecil dan lebih mudah dikelola. Komunitas menyediakan alat yang luar biasa seperti Mechanize untuk navigasi berbasis sesi dan Nokogiri untuk parsing HTML yang efisien. Meskipun kinerjanya sejajar dengan Python, komunitas Ruby yang lebih kecil berarti lebih sedikit perpustakaan khusus untuk scraping dibandingkan ekosistem Python. Ia tetap menjadi bahasa pemrograman yang layak untuk pengembang yang sudah terbiasa dengan lingkungan Ruby.

Kelebihan untuk Web Scraping:

- Sintaks yang Elegan: Sangat mudah dibaca dan menyenangkan untuk ditulis, menghasilkan pengembangan awal yang lebih cepat.

- Mechanize: Perpustakaan yang luar biasa untuk mensimulasikan sesi pengguna dan pengiriman formulir.

Kekurangan untuk Web Scraping:

- Komunitas yang Lebih Kecil: Lebih sedikit perpustakaan khusus dan adopsi yang lebih sedikit untuk scraping skala besar.

- Kinerja: Bukan pilihan tercepat untuk operasi yang sangat konkuren.

Kasus Penggunaan Terbaik: Scraper yang sederhana dan cepat diterapkan, serta proyek dalam infrastruktur berbasis Ruby yang sudah ada.

Rust: Masa Depan Scraping Berkinerja Tinggi

Rust adalah bahasa pemrograman modern yang dengan cepat mendapatkan popularitas karena kinerja yang luar biasa dan keamanan memori. Rust selalu dijajarkan sebagai salah satu bahasa yang paling disukai oleh pengembang yang paling dihormati. Untuk web scraping, Rust menawarkan kecepatan C++ tanpa bug memori yang umum. Kemampuan asinkronnya, yang didukung oleh Tokio, menjadikannya pilihan kuat untuk membangun scraper yang sangat cepat dan konkuren yang dapat menangani volume permintaan yang besar secara efisien.

Kelebihan untuk Web Scraping:

- Kinerja Ekstrem: Kecepatan hampir sejajar C/C++ dengan abstraksi tanpa biaya.

- Keamanan Memori: Menghilangkan kelas bug yang umum di bahasa lain.

- Konkurensi: Kerangka asinkron yang sangat baik untuk scraping web berkecepatan tinggi.

Kekurangan untuk Web Scraping:

- Kurva Pembelajaran yang Curam: Fokus pada pemilikan dan peminjaman bisa menantang bagi pemula.

- Ekosistem yang Terbatas: Ekosistem perpustakaan scraping tingkat tinggi masih dalam tahap awal dibandingkan Python.

Kasus Penggunaan Terbaik: Sistem scraping web berkinerja ekstrem di mana kecepatan, efisiensi sumber daya, dan keandalan adalah prioritas mutlak.

Ringkasan Perbandingan: Pilih Senjata Anda

Keputusan untuk menggunakan bahasa pemrograman tertentu untuk web scraping sering kali mengarah pada pertukaran antara kecepatan pengembangan dan kecepatan eksekusi. Tabel di bawah ini menyimpulkan perbedaan kunci antara pesaing teratas.

| Bahasa | Kemudahan Penggunaan | Kinerja/Kecepatan | Ekosistem Perpustakaan | Konten Dinamis | Model Konkurensi |

|---|---|---|---|---|---|

| Python | ★★★★★ | ★★★☆☆ | ★★★★★ | ★★★☆☆ | Threading/Multiprocessing |

| JavaScript (Node.js) | ★★★★☆ | ★★★★☆ | ★★★☆☆ | ★★★★★ | Event Loop (I/O Asinkron) |

| Go (Golang) | ★★★☆☆ | ★★★★★ | ★★★☆☆ | ★★☆☆☆ | Goroutines (Thread Ringan) |

| Java | ★★★☆☆ | ★★★★☆ | ★★★★☆ | ★★☆☆☆ | Thread Tradisional |

| Ruby | ★★★★☆ | ★★★☆☆ | ★★★☆☆ | ★★☆☆☆ | Thread Tradisional |

| Rust | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | ★★☆☆☆ | Tokio (Runtime Asinkron) |

Catatan: Peringkat bersifat relatif terhadap konteks spesifik web scraping.

Aplikasi Nyata dalam Skenario

Cara terbaik untuk menunjukkan pemilihan bahasa pemrograman adalah melalui contoh praktis. Proyek yang berbeda membutuhkan alat yang berbeda.

Skenario 1: Pemantauan Harga E-commerce (Python)

Sebuah bisnis kecil perlu memantau harga 500 produk di lima situs web kompetitor setiap hari. Volume data rendah, dan tujuan utama adalah mengintegrasikan data yang diambil dengan cepat ke dalam spreadsheet atau basis data yang sudah ada.

- Mengapa Python? Python adalah bahasa pemrograman yang ideal di sini. Kecepatan pengembangan menggunakan perpustakaan seperti Requests dan BeautifulSoup memungkinkan pengembang membuat skrip pemantauan dalam beberapa jam, bukan hari. Kemudahan integrasi Python dengan alat analisis data seperti Pandas membuat pemrosesan setelah scraping sederhana. Ini adalah kasus klasik di mana waktu pengembangan mengatasi kebutuhan untuk optimisasi kecepatan eksekusi.

Skenario 2: Agregasi Berita Skala Besar (Go/Rust)

Sebuah perusahaan media perlu mengambil jutaan artikel berita setiap hari dari ribuan sumber secara global, memerlukan throughput tinggi dan latensi minimal. Sistem harus berjalan 24/7 di klaster server awan.

- Mengapa Go atau Rust? Ini adalah tugas yang kritis dalam kinerja. Go dengan konkurensi yang lebih unggul dan konsumsi sumber daya yang rendah sempurna untuk mengelola jutaan koneksi jaringan simultan secara efisien. Rust adalah pilihan yang lebih kuat jika tim bisa mengatasi kurva pembelajaran awal, menawarkan kecepatan maksimal dan keandalan untuk sistem yang tidak bisa gagal. Efisiensi bahasa yang dikompilasi ini secara langsung berdampak pada biaya komputasi awan yang lebih rendah bagi perusahaan.

Skenario 3: Ekstraksi Data Aplikasi Halaman Tunggal (SPA) (JavaScript/Node.js)

Sebuah perusahaan riset pasar perlu mengambil konten yang dibuat pengguna dari platform media sosial modern yang dibangun sepenuhnya dengan React. Data yang diperlukan hanya muncul setelah JavaScript sisi klien yang kompleks dieksekusi.

- Mengapa JavaScript (Node.js)? Karena situs target adalah SPA dinamis, klien HTTP tradisional hanya akan menerima shell HTML kosong. Node.js, yang dipasangkan dengan browser tanpa kepala seperti Playwright, adalah solusi bahasa pemrograman yang praktis. Ini dapat merender halaman secara penuh, mengeksekusi semua JavaScript yang diperlukan, dan kemudian mengekstrak konten yang dimuat. Kemampuan ini penting untuk scraping web modern terhadap aplikasi web yang kompleks.

Tantangan yang Tidak Dapat Dihindari: Ukuran Anti-Scraping

Tidak peduli bahasa pemrograman yang Anda pilih—baik itu Python, Go, atau JavaScript—operasi web scraping Anda akan secara inevitable menghadapi pertahanan yang canggih. Situs web menggunakan berbagai teknik untuk melindungi data mereka, termasuk pembatasan laju IP, pemindaian sidik jari browser, dan tantangan CAPTCHA yang kompleks. Ukuran-ukuran ini bisa menghentikan bahkan scraper yang ditulis dengan sempurna, menjadikan pemilihan bahasa pemrograman Anda tidak relevan jika permintaan Anda diblokir.

Untuk menjaga alur data yang andal dan konsisten, pengembang harus mengintegrasikan alat khusus yang menangani tantangan ini secara otomatis. Ini adalah saat di mana layanan khusus menjadi tidak tergantikan untuk setiap upaya web scraping serius.

Alat yang Direkomendasikan: CapSolver

Untuk memastikan bahasa pemrograman yang Anda pilih dapat terus-menerus menghasilkan data, kami merekomendasikan integrasi CapSolver ke dalam alur kerja Anda. CapSolver adalah layanan yang kuat yang dirancang untuk menangani sistem anti-bot yang paling menantang, termasuk berbagai bentuk CAPTCHA dan mekanisme deteksi canggih.

Dengan memindahkan kompleksitas penyelesaian tantangan ke CapSolver, tim pengembangan Anda dapat fokus pada logika inti dari proses web scraping. Integrasi ini memastikan scraper Anda, baik itu ditulis dalam Python atau Go, tetap memiliki uptime tinggi dan integritas data yang baik. CapSolver berfungsi sebagai lapisan keandalan yang penting, memungkinkan scraper Anda berjalan seolah-olah tidak ada tantangan yang ada.

Kami mendorong Anda untuk menjelajahi kemampuan CapSolver untuk melihat bagaimana itu dapat meningkatkan stabilitas pipeline ekstraksi data Anda. Anda dapat memulai di Halaman Utama CapSolver dan melihat statistik penggunaan Anda di dashboard CapSolver.

Tukarkan Kode Bonus CapSolver

Tingkatkan anggaran otomatisasi Anda secara instan!

Gunakan kode bonus CAPN saat menambahkan dana ke akun CapSolver Anda untuk mendapatkan bonus tambahan 5% setiap kali isi ulang — tanpa batas.

Tukarkan sekarang di dashboard CapSolver

.

Kesimpulan dan Tindakan Lanjut

Bahasa pemrograman terbaik untuk web scraping pada tahun 2026 adalah yang sesuai dengan tujuan proyek Anda. Python tetap menjadi pilihan terbaik yang mudah diakses dan paling fleksibel untuk sebagian besar proyek. Namun, untuk mereka yang fokus pada skala ekstrem dan kinerja, Go dan Rust adalah masa depan. JavaScript (Node.js) adalah keharusan untuk menjelajahi web dinamis.

Pada akhirnya, keberhasilan proyek web scraping Anda tidak hanya bergantung pada bahasa, tetapi juga pada kemampuan Anda untuk mengatasi hambatan. Solusi web scraping yang kuat memerlukan pendekatan yang multi-fasih, yang mencakup bahasa pemrograman yang tepat dan layanan penyelesaian tantangan yang dapat diandalkan. Jangan biarkan langkah anti-bot mengganggu upaya pengumpulan data Anda.

Ambil langkah berikutnya dalam membangun pipa data yang tangguh. Mulailah proyek web scraping Anda hari ini dan pastikan keberhasilannya dengan mengintegrasikan CapSolver untuk penyelesaian tantangan yang dapat diandalkan.

Pertanyaan yang Sering Diajukan (FAQ)

Q1: Apakah Python masih bahasa terbaik untuk web scraping di tahun 2026?

Ya, Python masih bahasa pemrograman terbaik secara keseluruhan untuk web scraping di tahun 2026. Ekosistem pustaka yang matang (Scrapy, BeautifulSoup) dan kemudahan penggunaannya membuatnya menjadi pilihan default bagi sebagian besar pengembang. Meskipun bahasa yang dikompilasi seperti Go dan Rust lebih cepat, siklus pengembangan yang cepat dan dukungan komunitas Python tetap menjadikannya yang teratas untuk ekstraksi data secara umum.

Q2: Apakah saya sebaiknya menggunakan browser tanpa tampilan atau klien HTTP untuk web scraping?

Pilihan tergantung pada situs web yang dituju. Klien HTTP (seperti Requests Python atau perpustakaan standar Go) lebih cepat dan efisien dalam penggunaan sumber daya, dan sebaiknya digunakan kapan pun mungkin. Namun, jika situs web tersebut adalah Aplikasi Halaman Tunggal (SPA) modern yang memuat konten melalui JavaScript, Anda harus menggunakan browser tanpa tampilan (seperti Puppeteer atau Playwright) untuk merender halaman sebelum mengekstrak data.

Q3: Bagaimana CapSolver membantu dengan web scraping?

CapSolver menyediakan layanan penting dengan menangani berbagai tantangan, seperti CAPTCHA, yang sering menghambat operasi web scraping. Dengan mengintegrasikan CapSolver ke dalam scraper Anda, Anda memastikan bahwa proses ekstraksi data tetap tidak terganggu, terlepas dari bahasa pemrograman yang Anda gunakan. Hal ini secara signifikan meningkatkan keandalan dan ketersediaan pipeline scraping Anda.

Q4: Bahasa apa yang tercepat untuk web scraping?

Go (Golang) dan Rust adalah bahasa tercepat untuk web scraping. Sebagai bahasa yang dikompilasi, mereka menawarkan kecepatan eksekusi yang lebih baik dan model konkurensi yang sangat efisien (goroutines dalam Go, Tokio dalam Rust). Ini membuatnya jauh lebih cepat dibandingkan bahasa yang diinterpretasikan seperti Python atau Ruby untuk permintaan jaringan volume tinggi dan konkuren.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Cara Menyelesaikan Captcha di EasySpider dengan Integrasi CapSolver

EasySpider adalah alat pengambilan data web dan otomatisasi browser visual, tanpa kode, dan ketika dikombinasikan dengan CapSolver, dapat menyelesaikan CAPTCHA seperti reCAPTCHA v2 dan Cloudflare Turnstile secara andal, memungkinkan pengambilan data otomatis yang mulus di berbagai situs web.

Emma Foster

04-Feb-2026

Cara menyelesaikan reCAPTCHA v2 di Relevance AI dengan Integrasi CapSolver

Kembangkan alat Relevance AI untuk menyelesaikan reCAPTCHA v2 menggunakan CapSolver. Otomatisasi pengajuan formulir melalui API tanpa otomatisasi browser.

Ethan Collins

03-Feb-2026

Larangan IP pada 2026: Bagaimana Cara Kerjanya dan Cara Praktis untuk Mengelaknya

Pelajari cara menghindari pembatasan IP pada 2026 dengan panduan lengkap kami. Temukan teknik pemblokiran IP modern dan solusi praktis seperti proxy residensial dan solver CAPTCHA.

Emma Foster

26-Jan-2026

Cara Menyelesaikan Captcha di Maxun dengan Integrasi CapSolver

Panduan praktis untuk mengintegrasikan CapSolver dengan Maxun dalam penggunaan nyata pengambilan data web. Pelajari cara mengelola reCAPTCHA, Cloudflare Turnstile, dan situs yang dilindungi CAPTCHA dengan menggunakan alur kerja pre-auth dan robot.

Adélia Cruz

21-Jan-2026

Cara menyelesaikan Captcha di Browser4 dengan integrasi CapSolver

Otomasi Browser4 dengan throughput tinggi dikombinasikan dengan CapSolver untuk menangani tantangan CAPTCHA dalam ekstraksi data web skala besar.

Anh Tuan

21-Jan-2026

Apa itu Bot Scraping dan Bagaimana Cara Membuatnya

Pelajari apa itu bot scraping dan cara membuatnya untuk ekstraksi data otomatis. Jelajahi alat terbaik, teknik navigasi keamanan, dan praktik scraping yang etis.

Emma Foster

16-Jan-2026