¿Qué es la recopilación de datos: últimas noticias sobre scraping web en 2024?

Adélia Cruz

Neural Network Developer

04-Nov-2025

En la era digital, la información valiosa está dispersa en numerosas fuentes, desde sitios web hasta documentos de diversos formatos. Imagina el poder de recopilar y aprovechar estos datos para tus objetivos específicos. ¡Eso es precisamente lo que implica la recolección de datos!

Este artículo te proporcionará una comprensión integral de la recolección de datos, sus aplicaciones, el proceso involucrado, los desafíos enfrentados y las herramientas para superarlos. ¡Vamos a empezar!

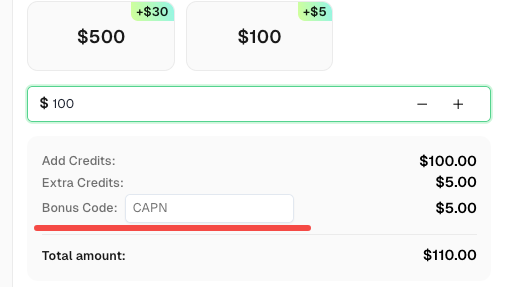

Redimir su código promocional de CapSolver

¡No pierda la oportunidad de optimizar aún más sus operaciones! Utilice el código promocional CAPN al recargar su cuenta de CapSolver y reciba un 5% adicional en cada recarga, sin límites. Visite el Panel de control de CapSolver para redimir su bono ahora!

Comprendiendo la recolección de datos

La recolección de datos es el proceso de recopilar información de una o más fuentes, como páginas web, documentos de texto (por ejemplo, PDF, archivos de Word), archivos tabulares (por ejemplo, hojas de cálculo, archivos CSV) y conjuntos de datos existentes.

En el contexto de la web, la recolección de datos a menudo se denomina "scraping web", que implica extraer datos de sitios web y páginas web. Una vez que se recopila la información deseada, se agrega, limpia y exporta en formatos amigables para el usuario, permitiendo a los miembros de su equipo acceder y analizar fácilmente los datos. Los usuarios empresariales pueden aprovechar estos datos para diversos propósitos, como el perfilado de usuarios, la toma de decisiones y la obtención de insights valiosos.

Hasta 2024, los avances en tecnologías automatizadas e inteligencia artificial (IA) han hecho que la recolección de datos sea más eficiente y accesible, abarcando la recuperación de datos en línea y local, así como la adquisición de datos biométricos.

Aplicaciones y casos de uso de la recolección de datos

La recolección de datos desempeña un papel crucial en tareas relacionadas con diversas industrias y aplicaciones. Usuarios de todos los tipos y niveles de experiencia la utilizan para diferentes objetivos finales. Aquí hay algunos casos de uso comunes:

- Individuos: Seguir precios en línea para obtener mejores ofertas, mejorar la productividad, monitorear ofertas de empleo, mejorar la organización personal y aumentar la eficiencia en tareas diarias.

- Empresas: Analizar el comportamiento de los clientes, perfeccionar las estrategias de marketing, mejorar las ofertas de productos, tomar decisiones informadas, optimizar las operaciones y obtener una ventaja competitiva.

- Gobiernos: Participar en seguridad nacional, formular políticas públicas, asignar recursos de manera eficiente, evaluar la opinión pública y adaptarse a necesidades sociales emergentes.

La recolección de datos también es invaluable en campos como la investigación médica, la atención médica personalizada, el monitoreo de redes sociales y el análisis de campañas para mercadólogos.

El proceso de recolección de datos

Estos son los pasos generales involucrados en el proceso de recolección de datos:

- Identificar fuentes de datos: Localizar fuentes de datos relevantes para su objetivo específico, como sitios web, conjuntos de datos o repositorios que contengan la información deseada.

- Usar una herramienta de extracción de datos: Utilizar una herramienta para simplificar el proceso de extracción de datos de documentos de origen. Dependiendo de sus requisitos, esto podría ser una biblioteca de análisis de datos, una herramienta sin código o una aplicación de escritorio. Las herramientas automatizadas hacen que la recolección de datos sea más rápida y precisa.

- Exportar los datos en un formato conveniente: Después de extraer los datos, transformarlos en un formato adecuado para sus necesidades. Los formatos más comunes para integrarlos en herramientas analíticas son CSV, XML y JSON. También puede que necesite almacenar la información recopilada en una base de datos.

Tomemos un ejemplo concreto para comprender mejor cómo funciona este proceso. Tomemos el ejemplo de la recolección de datos de CAPTCHA:

Para comenzar, asegúrese de tener Python instalado en su sistema. A continuación, instale las siguientes bibliotecas usando pip:

- Requests: Utilizado para enviar solicitudes HTTP al sitio web de CAPTCHA.

- BeautifulSoup: Una biblioteca para analizar HTML y extraer datos.

Haciendo solicitudes a CAPTCHA:

Para extraer datos de CAPTCHA, necesitamos enviar solicitudes HTTP al sitio web y recuperar el contenido HTML de las páginas. Podemos usar la biblioteca Requests para lograr esto. Aquí hay un ejemplo de hacer una solicitud para recuperar el HTML de una página de producto CAPTCHA: revisando los datos.

python

import requests

url = "https://www.captcha.com/product-page-url"

response = requests.get(url)

html_content = response.textAhora tenemos el contenido HTML de la página y podemos proceder con el análisis y la extracción de datos.

Analizando el HTML con BeautifulSoup:

Una vez que hayamos obtenido el contenido HTML de una página, podemos usar BeautifulSoup para analizar el HTML y extraer los datos deseados. Esto podría incluir información del producto, reseñas, precios y más. Aquí hay un ejemplo de usar BeautifulSoup para extraer el título de un producto de una página CAPTCHA:

python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, "html.parser")

title = soup.find("span", id="productTitle").text.strip()Ahora hemos extraído el título del producto y podemos continuar con la extracción de datos adicional. Vea más en el artículo detallado aquí

Elegir la herramienta adecuada para la extracción de datos

Con el aumento de la complejidad de las medidas de CAPTCHA, elegir la herramienta adecuada para la extracción de datos se ha vuelto crítica. Solo las herramientas que le ayuden a evitar ser bloqueado pueden garantizar resultados eficientes y efectivos. Hay dos categorías principales de herramientas de extracción de datos:

Para todos: extensiones de navegador y aplicaciones de escritorio que permiten recuperar datos sin código. Aunque accesibles para usuarios de cualquier nivel de habilidad, estas herramientas suelen tener limitaciones, como ser propensas a errores, detectables fácilmente por los sitios y ofrecer poca o ninguna personalización.

Para desarrolladores: bibliotecas de análisis de datos que pueden extraer datos de diversas fuentes, como HTML, CSV y documentos de texto. Las soluciones avanzadas ofrecen formas de personalizar las solicitudes y evitar la detección de bots.

Aunque las herramientas sin código son adecuadas para la extracción de datos básica, carecen de la flexibilidad necesaria para tareas más complejas. Para una recolección de datos confiable y efectiva, los desarrolladores a menudo necesitan definir lógica de raspado personalizada en scripts automatizados.

Sin embargo, los scripts personalizados en sí mismos no son suficientes para construir un proceso efectivo de recolección de datos. Para resolver realmente el CAPTCHA, necesita una herramienta poderosa como CapSolver. Como servicio líder de resolución de CAPTCHAS, CapSolver proporciona APIs y extensiones para resolver programáticamente o de forma manual diversos tipos de CAPTCHAS cuando los encuentre durante el scraping web, incluidos los utilizados por sistemas avanzados. Al integrar de forma fluida CapSolver en su flujo de trabajo de recolección de datos, puede superar estos desafíos y garantizar una recuperación exitosa de datos.

Conclusión

Este artículo le ha proporcionado una comprensión integral de la recolección de datos, sus aplicaciones, el proceso involucrado, los desafíos enfrentados y las herramientas para superarlos. Al aprovechar el poder de la recolección de datos y herramientas como CapSolver, puede desbloquear información valiosa, obtener una ventaja competitiva y tomar decisiones informadas para su negocio o proyectos personales. Si tiene una alta demanda de soluciones CAPTCHA, puede contactar a CapSolver a través del servicio de atención al cliente o Telegram para obtener una oferta sorpresa.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

¿Qué son los errores 402, 403, 404 y 429 en el web scraping? Una guía completa

Domine el manejo de errores de scraping web comprendiendo qué son los errores 402, 403, 404 y 429. Aprenda a corregir el error 403 Prohibido, implemente soluciones para el error 429 de limitación de tasas y maneje el código de estado 402 Requerido de pago.

Adélia Cruz

12-Dec-2025

Web Scraping Con Python: 2026 Mejores Estrategias

Aprende las tácticas top de scraping web en Python para 2026, incluyendo el manejo de contenido dinámico de JavaScript, la gestión de flujos de autenticación, resolver CAPTCHAs, identificar trampas ocultas, simular comportamiento humano, optimizar patrones de solicitud y reducir el uso de recursos en proyectos de scraping a gran escala.

Adélia Cruz

12-Dec-2025

Cómo resolver captchas al realizar scraping web con Scrapling y CapSolver

Scrapling + CapSolver permite el scraping automatizado con ReCaptcha v2/v3 y bypass de Cloudflare Turnstile.

Ethan Collins

05-Dec-2025

Raspado de web con Selenium y Python | Resolver Captcha al realizar el raspado de web

En este artículo te familiarizarás con el web scraping usando Selenium y Python, y aprenderás a resolver el Captcha involucrado en el proceso para una extracción de datos eficiente.

Rajinder Singh

04-Dec-2025

Raspado de web en Golang con Colly

En este blog, exploramos el mundo del raspado de web usando Golang con la biblioteca Colly. El guía comienza ayudándote a configurar tu proyecto de Golang e instalar el paquete Colly. Luego recorremos la creación de un raspador básico para extraer enlaces de una página de Wikipedia, mostrando la facilidad de uso y las potentes características de Colly.

Emma Foster

04-Dec-2025

¿Qué es el scraping web? | Casos de uso comunes y problemas

Conoce el web scraping: aprende sus beneficios, supera los desafíos con facilidad y potencia tu negocio con CapSolver.

Adélia Cruz

03-Dec-2025