¿Qué es el scraping web? | Casos de uso comunes y problemas

Adélia Cruz

Neural Network Developer

03-Dec-2025

Es posible que haya escuchado una frase sobre que los datos se llaman el nuevo petróleo en la sociedad de la información actual. Debido al gran volumen de información disponible en línea, la capacidad de recopilar y analizar eficazmente datos web se ha convertido en un conjunto de habilidades clave para empresas, investigadores y desarrolladores. Es aquí donde entra en juego el web scraping. El web scraping, también conocido como extracción de datos web, es una tecnología poderosa utilizada para recopilar información de forma automática de sitios web. Imagina poder obtener mucha información clave de un sitio web sin tener que copiar y pegar datos manualmente, pero el web scraping debe usarse con cuidado y cumplimiento. Este blog presentará brevemente el web scraping y abordará algunos de los problemas que podrían surgir. También hablará sobre algunos casos comunes.

Entendiendo el web scraping

El web scraping implica el uso de herramientas de software automatizado, conocidas como scrapers web, para recopilar datos de páginas web. Estas herramientas simulan el comportamiento de navegación humano, permitiéndoles navegar por sitios web, hacer clic en enlaces y extraer información del contenido HTML. Los datos extraídos pueden incluir texto, imágenes, enlaces y otros elementos multimedia. Una vez recopilados, los datos pueden almacenarse en bases de datos o hojas de cálculo para un análisis posterior.

Los scrapers web operan enviando solicitudes HTTP a sitios web y analizando las respuestas HTML. Pueden programarse para seguir enlaces, manejar la paginación y hasta interactuar con aplicaciones web complejas. Los lenguajes de programación populares para el web scraping incluyen Python, con bibliotecas como BeautifulSoup, Scrapy y Selenium, que ofrecen funcionalidades robustas para la extracción de datos y la automatización web.

Canjear su código de bonificación de CapSolver

¡Aumente su presupuesto de automatización instantáneamente!

Utilice el código de bonificación CAPN al recargar su cuenta de CapSolver para obtener un 5% adicional en cada recarga — sin límites.

Canjéalo ahora en tu Panel de CapSolver

.

La legalidad del web scraping

Una de las principales falsas creencias sobre el web scraping es que es ilegal. Esto no es preciso.

El web scraping es perfectamente legal siempre que sigas ciertas directrices: cumplir con las regulaciones CCPA y GDPR, evitar acceder a datos protegidos por credenciales de inicio de sesión y mantenerse alejado de recopilar cualquier información de identificación personal. Sin embargo, esto no da permiso para escrapear cualquier sitio web indiscriminadamente. Las consideraciones éticas son cruciales, lo que significa que siempre debes respetar los términos de servicio del sitio, el archivo robots.txt y las políticas de privacidad.

En esencia, el web scraping en sí no es ilegal, pero es importante seguir ciertas reglas y estándares éticos.

Casos de uso del web scraping

En el mundo basado en datos de hoy, el valor de los datos ha superado al del petróleo, y la Web es una fuente abundante de información valiosa. Numerosas empresas en diversos sectores aprovechan los datos extraídos mediante web scraping para mejorar sus operaciones comerciales.

Aunque hay innumerables aplicaciones del web scraping, aquí hay algunas de las más comunes:

Comparación de precios

Con herramientas de web scraping, empresas y consumidores pueden recopilar precios de productos de diferentes minoristas y plataformas en línea. Este dato puede usarse para comparar precios, encontrar las mejores ofertas y ahorrar tiempo y dinero. Además, permite a las empresas vigilar las estrategias de precios de sus competidores.

Monitoreo del mercado

El web scraping permite a las empresas seguir tendencias del mercado, disponibilidad de productos y cambios de precios en tiempo real. Al mantenerse actualizadas con la información más reciente del mercado, las empresas pueden adaptar rápidamente sus estrategias, aprovechar nuevas oportunidades y responder a las demandas cambiantes de los clientes. Este enfoque proactivo ayuda a mantener una ventaja competitiva.

Análisis de competidores

Al recopilar datos sobre productos, precios, promociones y comentarios de competidores, las empresas pueden obtener información valiosa sobre las fortalezas y debilidades de sus competidores. Las herramientas automatizadas también pueden capturar instantáneas de sitios web y esfuerzos de marketing de competidores, proporcionando una visión integral para desarrollar estrategias para superarlos.

Generación de clientes potenciales

El web scraping ha revolucionado la generación de clientes potenciales, transformando lo que antes era un proceso laborioso en uno automatizado. Al extraer información de contacto pública como direcciones de correo electrónico y números de teléfono, las empresas pueden construir rápidamente una base de datos de clientes potenciales. Este enfoque simplificado acelera el proceso de generación de clientes.

Análisis de sentimiento

El web scraping permite el análisis de sentimiento al extraer comentarios de usuarios de sitios de reseñas y plataformas de redes sociales. Analizar estos datos ayuda a las empresas a comprender la opinión pública sobre sus productos, servicios y marca. Al obtener información sobre los sentimientos de los clientes, las empresas pueden mejorar la satisfacción del cliente y abordar problemas de manera proactiva.

Agregación de contenido

El web scraping puede usarse para agrupar contenido de diversas fuentes en una sola plataforma. Esto es especialmente útil para sitios web de noticias, blogs y portales de investigación que necesitan proporcionar información actualizada de múltiples fuentes. Al automatizar la recopilación de contenido, las empresas ahorran tiempo y garantizan que sus plataformas estén actualizadas.

Listados de bienes raíces

El web scraping también se usa en la industria inmobiliaria para recopilar listados de propiedades de diversos sitios web. Este dato ayuda a agencias inmobiliarias y compradores potenciales a comparar propiedades, analizar tendencias del mercado y tomar decisiones informadas. Automatizar la recopilación de datos inmobiliarios proporciona una visión integral del mercado.

Tipos de scrapers web

Los scrapers web vienen en diversas formas, cada uno adaptado a diferentes propósitos y necesidades de los usuarios. En general, se pueden categorizar en cuatro tipos principales, cada uno con funcionalidades y beneficios únicos:

- Scrapers de escritorio

Los scrapers de escritorio son aplicaciones de software independientes instaladas directamente en la computadora del usuario. Estas herramientas suelen ofrecer una interfaz de usuario amigable sin necesidad de código, permitiendo a los usuarios extraer datos a través de interacciones simples de hacer clic y arrastrar. Los scrapers de escritorio cuentan con funciones como programación de tareas, análisis de datos y opciones de exportación, adaptándose tanto a principiantes como a usuarios avanzados. Son adecuados para tareas de scraping de tamaño medio y ofrecen un buen equilibrio entre funcionalidad y facilidad de uso.

- Scrapers personalizados

Los scrapers personalizados son soluciones altamente flexibles desarrolladas por programadores usando diversas tecnologías. Estos scrapers están diseñados para satisfacer requisitos específicos de extracción de datos, siendo ideales para proyectos complejos y de gran escala. Debido a su naturaleza a medida, los scrapers personalizados pueden manejar estructuras web complejas, navegar contenido dinámico y extraer datos de múltiples fuentes de manera eficiente. Son la elección principal para empresas que requieren soluciones de scraping personalizadas que puedan escalar fácilmente y adaptarse a necesidades en constante evolución.

- Scrapers de extensiones de navegador

Los scrapers de extensiones de navegador son complementos para navegadores web populares como Chrome, Firefox y Safari. Estas extensiones permiten a los usuarios escrapear datos directamente mientras navegan en sitios web. Al usar una interfaz intuitiva de hacer clic y arrastrar, los usuarios pueden seleccionar y extraer elementos de datos de páginas web fácilmente. Aunque los scrapers de extensiones de navegador son efectivos para tareas rápidas y de pequeño tamaño, a menudo tienen limitaciones en cuanto a funcionalidad y escalabilidad en comparación con otros tipos de scrapers.

- Scrapers basados en la nube

Los scrapers basados en la nube operan en la nube, proporcionando soluciones de scraping escalables y distribuidas. Estos scrapers son ideales para manejar tareas de extracción de datos a gran escala y suelen contar con capacidades integradas de procesamiento y almacenamiento de datos. Los usuarios pueden acceder a los scrapers basados en la nube de forma remota, programar tareas de scraping y gestionar la extracción de datos sin necesidad de infraestructura local. Aunque ofrecen capacidades robustas para el scraping a gran volumen, su flexibilidad para manejar contenido web complejo y dinámico puede ser menor que la de los scrapers personalizados.

Al seleccionar un scraper web, es esencial considerar la complejidad de la tarea, el volumen de datos a recopilar y los requisitos de escalabilidad y técnicos del proyecto. Cada tipo de scraper tiene sus propias fortalezas y casos de uso, y la elección dependerá de las necesidades específicas del usuario o organización.

Superando los desafíos del web scraping

El web scraping, aunque poderoso, también presenta grandes obstáculos debido al entorno en constante cambio de internet y a las protecciones empleadas por los sitios web, no es una tarea sencilla, y es muy probable que te encuentres con los siguientes problemas.

La dificultad principal en el web scraping proviene de la dependencia en la estructura HTML de una página web. Cada vez que un sitio web actualiza su interfaz de usuario, los elementos HTML que contienen los datos deseados pueden cambiar, haciendo que tu scraper sea ineficaz. Adaptarse a estos cambios requiere mantenimiento constante y actualización de tu lógica de scraping. Usar selectores de elementos HTML robustos que se adapten a pequeños cambios en la interfaz de usuario puede mitigar este problema, pero no existe una solución única para todos los casos.

Desafortunadamente, más complejidad está por venir, y mucho más compleja que el mantenimiento.

Los sitios web implementan tecnologías sofisticadas para proteger sus datos de los scrapers automatizados. Estos sistemas pueden detectar y bloquear solicitudes automatizadas, representando un obstáculo significativo. Aquí hay algunos desafíos comunes que enfrentan los scrapers:

- Baneos de IP: Los servidores monitorean las solicitudes entrantes en busca de patrones sospechosos. Detectar software automatizado suele llevar al bloqueo de la IP, impidiendo el acceso adicional al sitio.

- Restricciones geográficas: Algunos sitios web restringen el acceso según la ubicación geográfica del usuario. Esto puede bloquear a usuarios extranjeros de acceder a cierto contenido o presentar datos diferentes según la ubicación, complicando el proceso de scraping.

- Límites de velocidad: Hacer demasiadas solicitudes en un corto período de tiempo puede activar medidas de protección contra DDoS o baneos de IP, interrumpiendo la operación de scraping.

- CAPTCHAs: Los sitios web suelen usar CAPTCHAs para distinguir entre humanos y bots, especialmente si se detecta actividad sospechosa. Resolver CAPTCHAs de manera programática es muy complicado, a menudo frustrando a los scrapers automatizados.

Aunque resolver los primeros tres problemas puede hacerse cambiando proxies o usando un navegador de huella digital, el último CAPTCHA requiere soluciones alternativas complejas que normalmente tienen resultados inconsistentes o solo pueden resolverse en un corto período de tiempo. Independientemente de la técnica utilizada, estos obstáculos debilitan la efectividad y estabilidad de cualquier herramienta de web scraping.

Afortunadamente, existe una solución para este problema, y es CapSolver, que ofrece soluciones integrales para estos desafíos. CapSolver se especializa en la resolución de CAPTCHA y ayuda eficazmente al web scraping con tecnología avanzada para garantizar un web scraping estable y efectivo. Al integrar CapSolver en tu flujo de trabajo de scraping, puedes superar estos desafíos, aquí hay algunos pasos básicos.

Integrar solucionadores de CAPTCHA

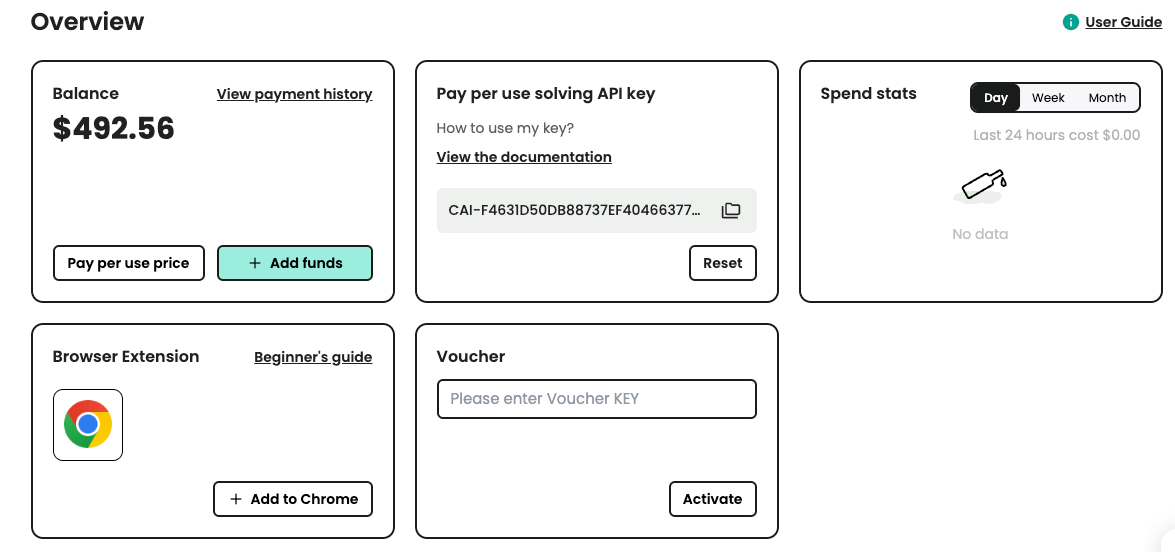

Hay varios servicios de resolución de CAPTCHA disponibles que pueden integrarse en tu script de scraping. Aquí usaremos el servicio CapSolver. Primero, necesitas registrarte en CapSolver y obtener tu clave de API.

Paso 1: Regístrate en CapSolver

Antes de que estés listo para usar los servicios de CapSolver, debes ir al panel de usuario y registrar tu cuenta.

Paso 2: Obtén tu clave de API

Una vez que te hayas registrado, puedes obtener tu clave de API desde el panel de inicio

Código de ejemplo para CapSolver

Usar CapSolver en tu proyecto de scraping web o automatización es sencillo. Aquí tienes un ejemplo rápido en Python para mostrar cómo puedes integrar CapSolver en tu flujo de trabajo:

python

# pip install requests

import requests

import time

# TODO: configure su configuración

api_key = "SU_CLAVE_DE_API" # su clave de API de capsolver

site_key = "6Le-wvkSAAAAAPBMRTvw0Q4Muexq9bi0DJwx_mJ-" # clave del sitio de su sitio objetivo

site_url = "" # URL de la página de su sitio objetivo

def capsolver():

payload = {

"clientKey": api_key,

"task": {

"type": 'ReCaptchaV2TaskProxyLess',

"websiteKey": site_key,

"websiteURL": site_url

}

}

res = requests.post("https://api.capsolver.com/createTask", json=payload)

resp = res.json()

task_id = resp.get("taskId")

if not task_id:

print("No se pudo crear la tarea:", res.text)

return

print(f"Obtuve taskId: {task_id} / Obteniendo resultado...")

while True:

time.sleep(3) # retraso

payload = {"clientKey": api_key, "taskId": task_id}

res = requests.post("https://api.capsolver.com/getTaskResult", json=payload)

resp = res.json()

status = resp.get("status")

if status == "ready":

return resp.get("solution", {}).get('gRecaptchaResponse')

if status == "failed" or resp.get("errorId"):

print("¡Falló la resolución! respuesta:", res.text)

return

token = capsolver()

print(token)En este ejemplo, la función capsolver envía una solicitud a la API de CapSolver con los parámetros necesarios y devuelve la solución del CAPTCHA. Esta integración sencilla puede ahorrarte incontables horas y esfuerzo en resolver manualmente CAPTCHAs durante tareas de scraping web y automatización.

Conclusión

El web scraping ha transformado la forma en que recopilamos y analizamos datos en línea. Desde comparaciones de precios hasta tendencias del mercado y generación de clientes potenciales, sus aplicaciones son diversas y poderosas. A pesar de los desafíos provocados por medidas anti-scraping como los CAPTCHA, soluciones como CapSolver permiten procesos más fluidos de extracción de datos.

Siguiendo guías éticas y aprovechando herramientas avanzadas, empresas y desarrolladores pueden aprovechar al máximo el potencial del web scraping. No se trata solo de recopilar datos; se trata de desbloquear información, impulsar la innovación y mantenerse competitivo en el entorno digital actual.

Preguntas frecuentes

1. ¿Cómo puedo evitar reCAPTCHA o hCaptcha de manera segura durante el web scraping?

La forma más segura y confiable de evitar reCAPTCHA, hCaptcha o Cloudflare Turnstile es utilizar una API dedicada para resolver CAPTCHAs, como CapSolver. Se integra con scripts de raspado, herramientas de automatización de navegadores (Puppeteer, Playwright, Selenium) y maneja automáticamente los tokens de desafío sin intervención manual. Evite usar scripts o bots no confiables para prevenir bloqueos de cuenta o riesgos de seguridad.

2. ¿Por qué mi raspador se bloquea incluso al rotar proxies?

Los sitios web ahora utilizan múltiples capas de detección de bots, incluyendo verificaciones de huellas dactilares del navegador, análisis de comportamiento, fingerprinting TLS y desafíos de CAPTCHA. Incluso con proxies rotantes, el raspado puede fallar si su entorno de navegador parece automatizado. Usar un motor de navegador real con encabezados correctos, tiempos similares a los humanos y un servicio de resolución de CAPTCHA aumenta significativamente las tasas de éxito.

3. ¿Es legal usar servicios de resolución de CAPTCHA para tareas de automatización?

Sí, los servicios de resolución de CAPTCHA son legales cuando se usan para tareas compatibles, como investigación de datos, monitoreo de SEO, seguimiento de precios o automatización que no viole los términos del sitio web o acceda a datos protegidos. Siempre asegúrese de que su caso de uso cumpla con las regulaciones de privacidad locales (GDPR, CCPA) y respete las reglas de la plataforma.

4. ¿Cuál es el mejor método para raspar sitios web renderizados con JavaScript?

Para sitios web con mucho JavaScript, los navegadores headless como Puppeteer, Playwright o Selenium ofrecen la mayor tasa de éxito. Ejecutan completamente los scripts, cargan contenido dinámico y imitan el comportamiento de un usuario real. Para extracción de datos a gran escala, use estas herramientas junto con proxies, limitación de velocidad y integraciones de resolución de CAPTCHA.

5. ¿Cómo mejora CapSolver el éxito de la automatización en sitios web protegidos?

CapSolver resuelve automáticamente reCAPTCHA, Geetest, Turnstile y otros desafíos anti-bot con alta precisión. Funciona de manera fluida con frameworks de raspado y reduce las tasas de falla causadas por paredes de verificación. Esto permite un crawling más suave, menos interrupciones y una mejor eficiencia en la automatización.

6. ¿Cómo puedo reducir la posibilidad de que mi automatización sea detectada como un bot?

Utilice huellas dactilares de navegador realistas, rotar proxies de alta calidad, simular retrasos naturales, cargar activos normalmente y evitar saturar los puntos finales con solicitudes rápidas. Combinar estos pasos con la resolución de CAPTCHA ayuda a que su raspador parezca más una sesión de usuario real.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Cómo resolver Captcha en Nanobot con CapSolver

Automatiza la resolución de CAPTCHA con Nanobot y CapSolver. Utiliza Playwright para resolver reCAPTCHA y Cloudflare autónomamente.

Adélia Cruz

26-Feb-2026

Datos como Servicio (DaaS): ¿Qué es y por qué es importante en 2026

Comprender Datos como Servicio (DaaS) en 2026. Explora sus beneficios, casos de uso y cómo transforma los negocios con insights en tiempo real y escalabilidad.

Sora Fujimoto

12-Feb-2026

Cómo arreglar errores comunes de raspado de web en 2026

Dominar la resolución de diversos errores de scrapers web como 400, 401, 402, 403, 429, 5xx y Cloudflare 1001 en 2026. Aprender estrategias avanzadas para la rotación de IPs, encabezados y limitación de tasa adaptativa con CapSolver.

Emma Foster

05-Feb-2026

Cómo resolver un Captcha en RoxyBrowser con la integración de CapSolver

Integrar CapSolver con RoxyBrowser para automatizar tareas del navegador y evadir reCAPTCHA, Turnstile y otros CAPTCHAs.

Emma Foster

04-Feb-2026

Cómo resolver captcha en EasySpider con la integración de CapSolver

EasySpider es una herramienta visual de scraping web y automatización de navegadores, y cuando se combina con CapSolver, puede resolver de manera confiable los CAPTCHAs como reCAPTCHA v2 y Cloudflare Turnstile, facilitando la extracción de datos automatizada sin interrupciones en todo tipo de sitios web.

Adélia Cruz

04-Feb-2026

Cómo resolver reCAPTCHA v2 en Relevance AI con integración de CapSolver

Construye una herramienta de Relevance AI para resolver reCAPTCHA v2 utilizando CapSolver. Automatiza los envíos de formularios a través de API sin automatización de navegadores.

Aloísio Vítor

03-Feb-2026