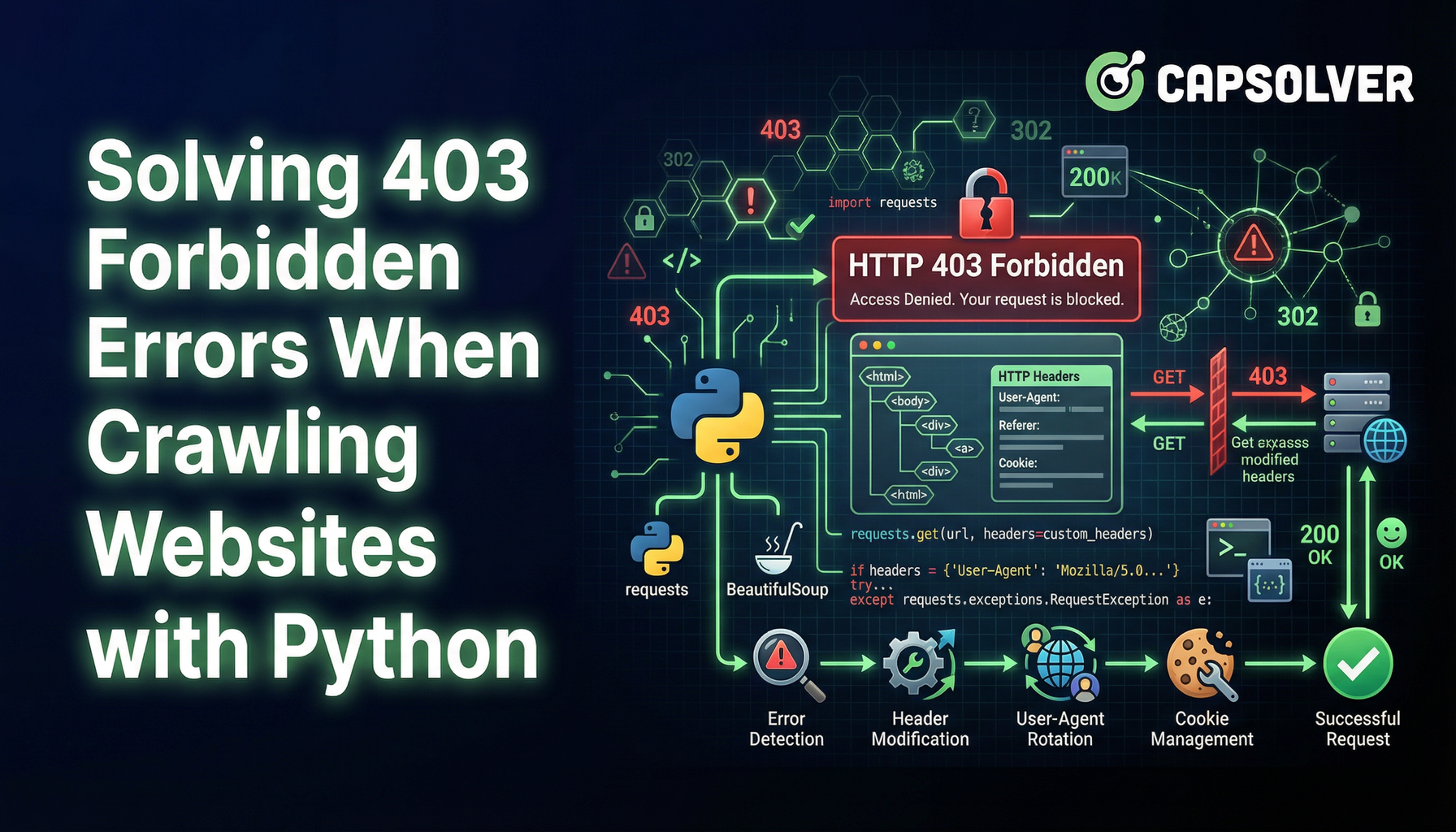

解决使用 Python 爬取网站时的 403 禁止访问错误

Ethan Collins

Pattern Recognition Specialist

13-Jan-2026

网络爬虫是一种从网站中提取数据的宝贵技术。然而,遇到403禁止错误可能会成为主要障碍。此错误表示服务器理解您的请求,但拒绝授权。以下是如何绕过此问题并继续您的网络爬虫之旅。

理解403 禁止错误

当服务器拒绝访问请求的资源时,就会出现403 禁止错误。这可能有多种原因,包括:

面对重复失败的令人恼火的验证码问题?发现无缝的自动验证码解决方法,使用 CapSolver 的人工智能驱动的自动网页解除封锁技术!

领取您的 CapSolver 优惠码

立即提升您的自动化预算!

在充值 CapSolver 账户时使用优惠码 CAPN,每次充值可获得额外 5% 的奖励——无限制。

现在立即在您的 CapSolver 仪表板

。

- IP地址封禁:如果服务器检测到异常或高频率的请求,可能会封禁IP地址。

- 用户代理限制:一些网站根据用户代理字符串限制访问,该字符串标识发出请求的浏览器和设备。

- 需要认证:访问某些页面可能需要登录凭证或API密钥。

绕过403错误的技术

1. 轮换IP地址

服务器通常在达到一定阈值后会封禁同一IP地址的请求。使用代理服务器池轮换IP地址可以帮助您避免这种情况。Nstproxy 或 Bright Data 等服务提供轮换代理解决方案。

python

import requests

proxies = {

"http": "http://your_proxy_here",

"https": "http://your_proxy_here",

}

response = requests.get("http://example.com", proxies=proxies)2. 使用真实的用户代理

网络服务器可以检测并阻止具有可疑用户代理字符串的请求。将用户代理字符串伪装成常规浏览器可以避免被检测到。

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. 实现请求节流

短时间内发送过多请求可能会触发速率限制。在请求之间引入延迟可以帮助您避免被发现。

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # 延迟5秒4. 处理认证

某些资源需要认证。使用Cookie或API密钥进行认证请求可以绕过访问限制。

python

cookies = {

"session": "your_session_cookie_here"

}

response = requests.get("http://example.com", cookies=cookies)5. 利用无头浏览器

无头浏览器如 Puppeteer 或 Selenium 可以模拟真实用户交互,帮助绕过复杂的反爬虫措施。

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. 克服验证码挑战

除了403错误外,网络爬虫经常遇到验证码,这些验证码旨在阻止自动化访问。reCAPTCHA等验证码需要解决视觉或交互式挑战以证明请求是由人类发出的。

要解决这些挑战,您可以使用 CapSolver 等提供自动验证码解决服务的平台。CapSolver 支持多种验证码类型,并提供与网络爬虫工具的便捷集成。

结论

在进行网络爬虫时遇到403禁止错误可能会令人沮丧,但了解其原因并采用正确技术可以帮您克服这一障碍。无论使用轮换IP、真实的用户代理字符串、请求节流、处理认证,还是利用无头浏览器,这些方法都可以帮助您继续从网络中提取有价值的数据。

通过遵循这些策略,您可以有效管理并绕过403错误,确保更顺畅、更成功的网络爬虫工作。

常见问题

1. 在网络爬虫中绕过403禁止错误是否合法?

绕过403错误本身并不违法,但合法性取决于网站的使用条款、robots.txt规则和当地法律。为合法目的爬取公开可访问数据通常是被允许的,而绕过认证、付费墙或明确限制可能违反条款或法规。在爬取前,请务必审查目标网站的政策。

2. 即使使用代理和用户代理,为何仍会收到403错误?

如果网站使用了高级的机器人检测系统,如行为分析、指纹识别或验证码挑战,403错误可能仍然存在。在这种情况下,简单的IP轮换和用户代理伪装可能不够。结合请求节流、会话管理、无头浏览器和验证码解决服务如CapSolver可以显著提高成功率。

3. 在大规模爬虫中,避免403错误的最可靠方法是什么?

对于大规模爬虫,最可靠的方法是采用分层策略:高质量的轮换住宅或移动代理、真实的浏览器指纹、控制请求速率、正确的认证处理以及自动验证码解决。使用无头浏览器和基于AI的网页解除封锁解决方案有助于更贴近真实用户行为,降低重复403封禁的可能性。

合规声明: 本博客提供的信息仅供参考。CapSolver 致力于遵守所有适用的法律和法规。严禁以非法、欺诈或滥用活动使用 CapSolver 网络,任何此类行为将受到调查。我们的验证码解决方案在确保 100% 合规的同时,帮助解决公共数据爬取过程中的验证码难题。我们鼓励负责任地使用我们的服务。如需更多信息,请访问我们的服务条款和隐私政策。

更多

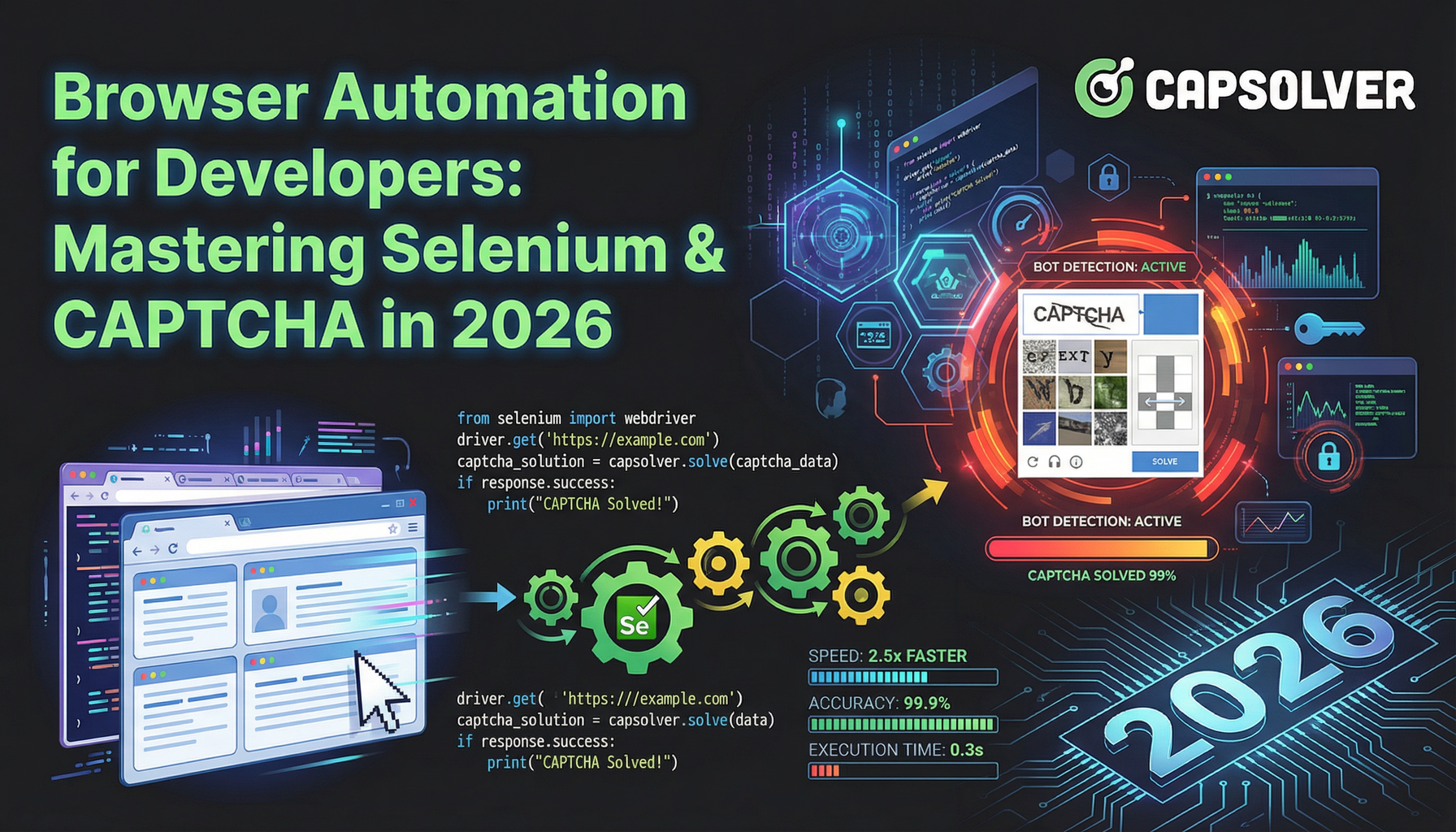

面向开发者的浏览器自动化:2026年掌握Selenium与验证码

通过这份2026年指南,掌握浏览器自动化开发。学习Selenium WebDriver Java、Actions接口以及如何使用CapSolver解决验证码。

Sora Fujimoto

02-Mar-2026

如何在Nanobot中使用CapSolver解决验证码

使用 Nanobot 和 CapSolver 自动化验证码解决。使用 Playwright 自主解决 reCAPTCHA 和 Cloudflare。

Anh Tuan

26-Feb-2026

数据即服务(DaaS):它是什么以及为何在2026年重要

了解2026年的数据即服务(DaaS)。探索其优势、应用场景以及如何通过实时洞察和可扩展性改变企业。

Rajinder Singh

12-Feb-2026

如何在RoxyBrowser中通过CapSolver集成解决验证码

将 CapSolver 与 RoxyBrowser 集成,以自动化浏览器任务并绕过 reCAPTCHA、Turnstile 及其他验证码。

Ethan Collins

04-Feb-2026

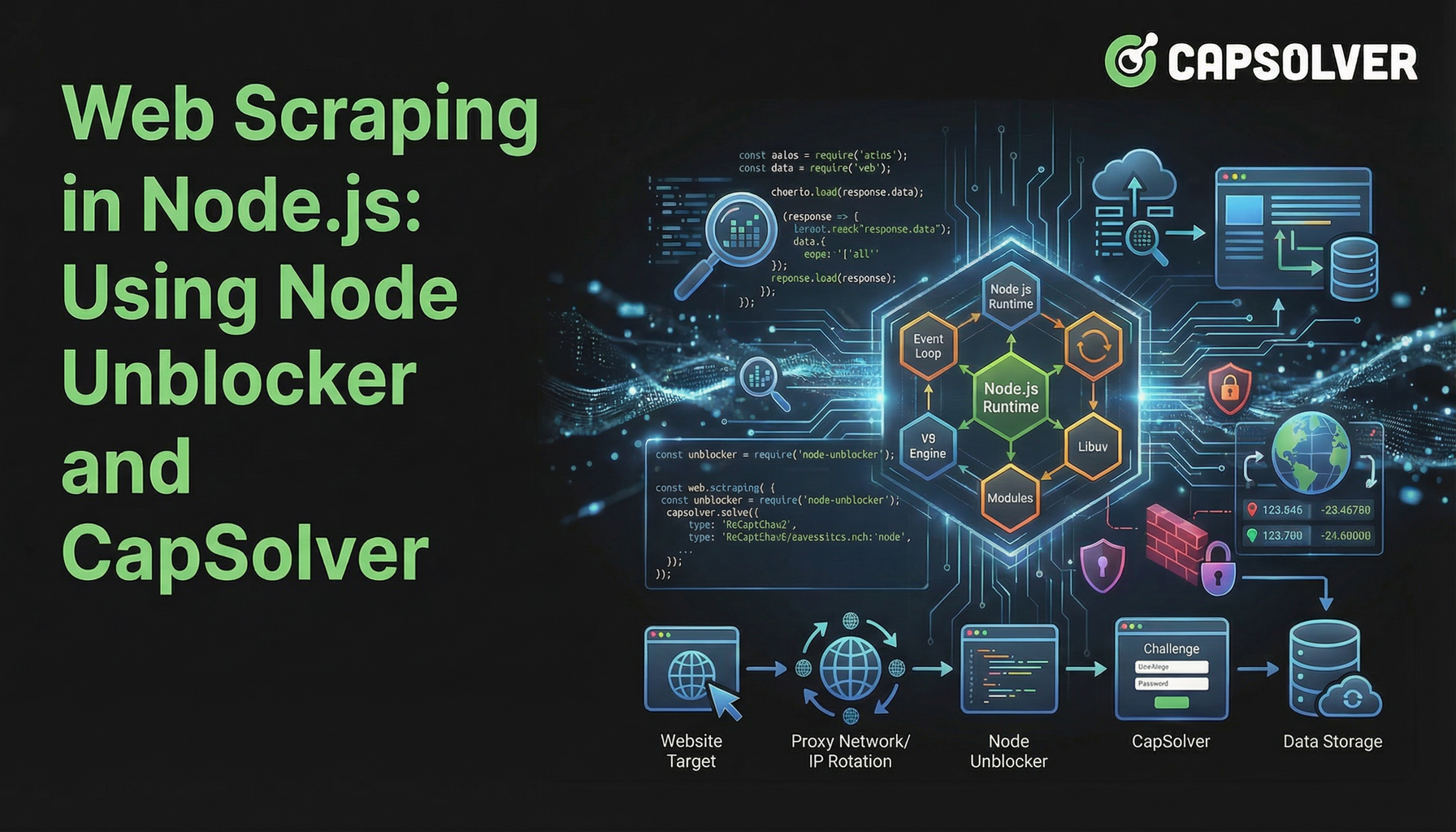

在 Node.js 中进行网页爬虫:使用 Node Unblocker 和 CapSolver

掌握Node.js中的网络爬虫技术,利用Node Unblocker绕过限制,并使用CapSolver解决CAPTCHAs。本指南提供高效且可靠的数据提取进阶策略。

Lucas Mitchell

04-Feb-2026

如何在EasySpider中通过CapSolver集成解决验证码

EasySpider 是一个可视化、无代码的网页抓取和浏览器自动化工具,当与 CapSolver 结合使用时,它可以可靠地解决 reCAPTCHA v2 和 Cloudflare Turnstile 等验证码,从而实现在网站间无缝的自动化数据提取。

Emma Foster

04-Feb-2026