ウェブスクリーピングツール - 解説

Ethan Collins

Pattern Recognition Specialist

23-Dec-2025

TL;DR

- ウェブスクレイピングは、ウェブサイトからデータを自動的に抽出する方法で、インターネットの膨大な非構造化データを構造化され、使用可能な形式に変換します。

- 広く利用されている業界で、価格モニタリング、リード生成、SEOトラッキング、感情分析、データジャーナリズムに使用されています。

- ウェブスクレイピングツールは3つの主要なカテゴリに分類されます:ノーコードのセルフサービスツール、コードベースのプログラマティックツール、完全に管理されたデータ抽出サービス。

- ノーコードと視覚的なツール(例:Import.io、Octoparse、ParseHub、WebHarvy)は、非テクニカルなユーザーが迅速な結果を得るために最適です。

- 開発者向けのツールとライブラリ(例:Scrapy、BeautifulSoup、Selenium、Puppeteer、Cheerio)は、より高い柔軟性とスケーラビリティを提供しますが、プログラミングスキルが必要です。

- ブラウザ自動化ツールであるSeleniumとPuppeteerは、JavaScriptが豊富で、高度にインタラクティブなウェブサイトに不可欠です。

- 適切なツールの選択は、技術的知識、データの複雑さ、スケール、予算に依存し、一見のサイズにあわせたアプローチではありません。

- 責任あるスクレイピングは重要です—常にウェブサイトの利用規約と関連する法的・倫理的ガイドラインに準拠してください。

ウェブスクレイピングツール

ウェブスクレイピング、別名ウェブデータ抽出は、ウェブサイトからデータを取得または「スクレイピング」するプロセスです。手動でデータを抽出する単調で退屈なプロセスとは異なり、ウェブスクレイピングは知的自動化を使用して、インターネットの無限に広がるフロントに数百、数百万、あるいは数十億のデータポイントを取得します。

インターネット上のデータ量は指数関数的に増加しています。現在、17億以上のウェブサイトがオンラインにあり、毎日さらに多くのウェブサイトが作成されています。このようなデータの海の中で、企業、研究者、個人は必要な情報をどうやって見つけるのでしょうか?その答えはウェブスクレイピングにあります。

このガイドは、今日利用可能な最も強力なウェブスクレイピングツールの詳細な概要を提供することを目的としています。これらのツールの一部は技術的知識の一定レベルを必要としますが、他のツールは非プログラマにも適しています。シニアデータサイエンティスト、ソフトウェア開発者、デジタルマーケティング専門家など、誰でもニーズに合ったツールを見つけることができます。

CapSolverのボーナスコードを引き換える

今すぐ自動化予算を増やす!

CapSolverアカウントにチャージする際、ボーナスコード CAPN を使用して、5%のボーナスを毎回獲得—制限なし。

今すぐCapSolverダッシュボードで引き換える

。

1. ウェブスクレイピングの紹介

ウェブスクレイピングは、迅速にウェブサイトから大量のデータを抽出する自動化された方法です。ウェブサイト上のデータは非構造化されています。ウェブスクレイピングは、そのデータを構造化された形式に変換する手段を提供します。

2. ウェブスクレイピングツールを使用する理由

企業、学術界、個人がウェブサイトをスクレイピングしたい理由は数え切れないほどあります。一般的な用途には以下が含まれます。

- データジャーナリズム: ジャーナリストや研究者は、スクレイピングツールを使用して公開記録の変化を追跡したり、調査記事のためにさまざまな情報源から情報を収集したりできます。

- 価格比較: イーコマース企業は、競合の価格戦略をモニタリングするためにウェブスクレイピングツールを使用することがよくあります。製品価格や説明文をスクレイピングすることで、市場の動向を把握できます。

- リード生成: 多くの企業は、ビジネスディレクトリやソーシャルメディアサイトからリードを生成し、連絡先情報を収集するためにウェブスクレイピングを使用します。

- 感情分析: 顧客のレビューとソーシャルメディアの会話をスクレイピングすることで、企業は製品が市場でどのように評価されているかの洞察を得ることができます。これにより、顧客フィードバックに効果的に対応できます。

- SEOモニタリング: SEO会社は、ウェブサイトのパフォーマンスをモニタリングし、SEOランクの変化を追跡し、他の関連データを収集するためにウェブスクレーパーを使用します。

3. ウェブスクレイピングツールの種類

主に3つの種類のウェブスクレイピングツールがあります。

- セルフサービスツール: コードを書くことなくデータをスクレイピングできるポイント&クリックツールです。データフィールドを指定するための視覚的なインターフェースがあり、必要なデータを指定すると自動的に抽出します。

- プログラマティックツール: コードに埋め込むことができるライブラリやフレームワークです。より柔軟性と機能性を提供しますが、プログラミング知識が必要です。

- マネージドサービス: 要件を指定するとデータを提供するエンドツーエンドのプラットフォームです。最も使い勝手が良いですが、柔軟性が最も低く、通常は最も高価です。

4. ウェブスクレイピングツールの詳細レビュー

以下は、人気のあるウェブスクレイピングツールの詳細なレビューです。各ツールのレビューには、特徴、利点、使用例が含まれています。

Import.io

Import.ioは、コードを書かずにウェブサイトからデータを抽出するウェブベースのツールです。スクレイピングしたいデータフィールドを指定するための視覚的なインターフェースを提供します。

特徴:

- ポイント&クリックインターフェース: ユーザーが直感的なポイント&クリックインターフェースを使用して必要なデータを識別できるようにします。

- データレポート: Import.ioは、スクレイピングされたデータをCSVまたはMicrosoft Excelファイルとして提供し、直接データウェアハウスに同期することもできます。

- スケジューラー: データ抽出をスケジュールし、常に最新のデータを提供できます。

使用例:

Import.ioは、プログラミングスキルのない人がページから構造化されたデータを抽出するのに最適です。価格比較、感情分析、ソーシャルメディアスクレイピングなどに使用できます。

Octoparse

Octoparseは、多くの種類のウェブサイトからデータ抽出を自動化する強力なウェブスクレイピングツールです。データ抽出の仕様を管理できる視覚的なワークフローデザイナーを備えています。

特徴:

- クラウド抽出: Octoparseは、データ抽出プロセスがユーザーのローカルデバイスではなく、サーバーで実行されるクラウドベースのデータ抽出機能を提供します。

- エクスポート形式: Excel、HTML、TXT、データベース(MySQL、SQL Server、Oracle)など、さまざまな形式でデータをエクスポートできます。

- APIアクセス: OctoparseはAPIを提供し、ユーザーがデータをリモートで扱えるようにします。

使用例:

Octoparseは、リード生成、価格モニタリング、マーケットリサーチ、学術研究などの幅広いデータ抽出目的に使用できます。

ParseHub

ParseHubは、誰でもウェブからデータを取得できる視覚的なデータ抽出ツールです。ウェブサイトからデータを抽出するための計画を設定し、ParseHubに作業を任せることができます。

特徴:

- JavaScriptとAJAXのサポート: ParseHubはJavaScriptとAJAXを扱うことができ、多くの他のスクレーパーにとって難しいです。

- 高度な技術: マルチレベルのネストされたデータ、ページング、ドロップダウン、検索、フォームを扱うことができます。

- スケジューラー: スクレイピングプロジェクトを10分ごと、あるいは1年1回まで、頻繁に実行できます。

使用例:

ParseHubは、データジャーナリズム、イーコマースの成長、AIトレーニングデータの収集、マーケットトレンド予測などの目的に使用できます。

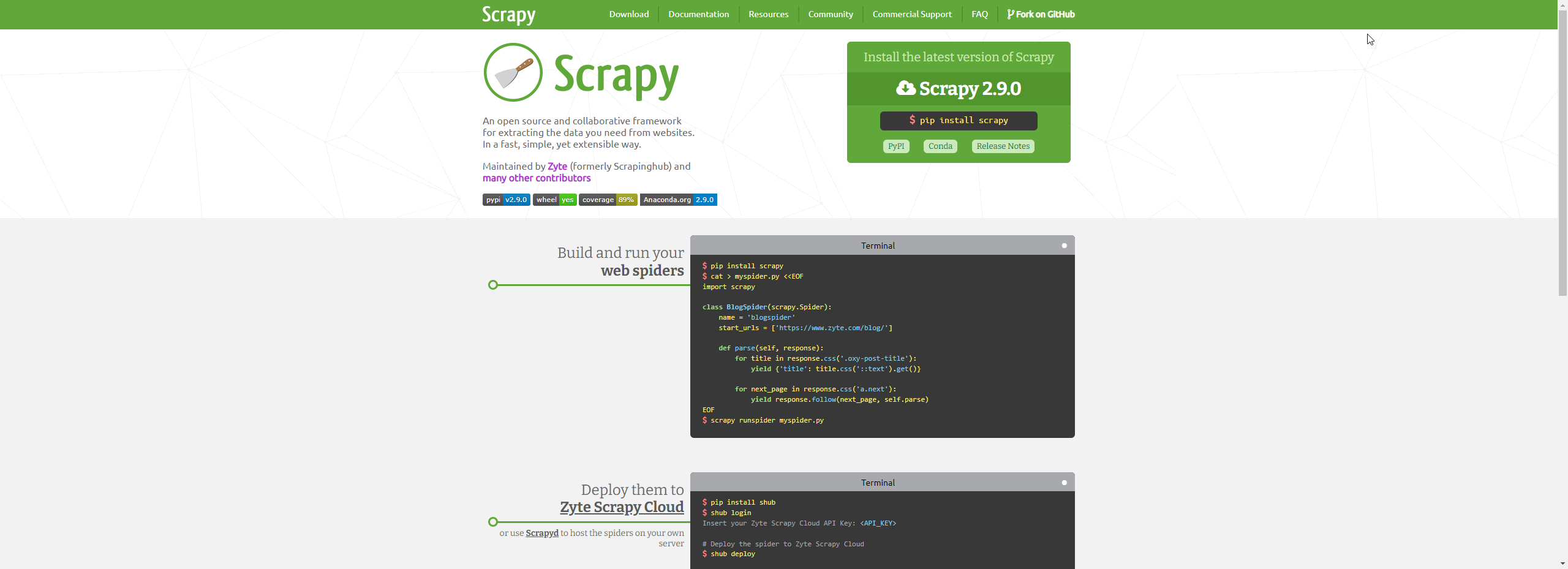

Scrapy

ScrapyはPythonで書かれたオープンソースのウェブクローリングフレームワークです。ウェブサイトからデータを抽出し、処理し、お好みの形式で保存するためのすべてのツールを提供します。

特徴:

- 多機能性: Scrapyは非常に多機能で、データマイニング、データ処理、歴史的アーカイブなど、さまざまなスクレイピングタスクを処理できます。

- 強力でスケーラブル: 大規模なウェブスクレイピングタスクを処理するように構築されています。複数のマシンにわたるスクレイピングタスクを処理することもできます。

- 豊富なライブラリ: Scrapyは、機能を拡張する多数のライブラリを備えた豊かなエコシステムとコミュニティを持っています。

使用例:

Scrapyは、大規模で複雑なスクレイピングタスクに適しています。Pythonプログラミングに慣れているデータサイエンティスト、研究者、開発者に最適です。

BeautifulSoup

BeautifulSoupは、HTMLとXMLファイルからデータを抽出するために設計されたPythonライブラリです。初心者にとって簡単でアクセスしやすいですが、そのシンプルさが機能性を損なうことはありません。

特徴:

- 簡単なパース: BeautifulSoupは複雑なHTMLドキュメントを、タグ、ナビゲート可能な文字列、コメントなどのPythonオブジェクトのツリーに変換します。

- パースツリーの検索: タグ名、属性などに基づいたフィルターを使用して、パースツリーを検索できます。

- Python的なイディオム: BeautifulSoupは、パースツリーの反復、検索、変更にPython的なイディオムを使用します。

使用例:

HTMLとXMLドキュメントのパースが必要なウェブスクレイピングタスクには、BeautifulSoupが適しています。そのシンプルさが初心者にとって良い選択肢です。

Selenium

Seleniumは、プログラムを通じてウェブブラウザを制御する強力なツールです。すべてのブラウザで動作し、すべての主要なOSで動作し、スクリプトはPython、Java、C#などさまざまな言語で書けます。

特徴:

- ブラウザ自動化: ウェブページがインタラクティブで、単純なHTTPリクエストが不十分な場合に、Seleniumはブラウザタスクを自動化できます。

- マルチ言語サポート: Seleniumスクリプトは、Python、Java、C#などの複数のプログラミング言語で書けます。

- さまざまなブラウザのサポート: Chrome、Firefox、Safari、Edgeなどの主要なウェブブラウザをサポートしています。

使用例:

Seleniumは、ウェブページとインタラクションが必要なウェブスクレイピングタスクに最適です。例えば、ボタンをクリックしたり、フォームに入力したりする場合です。また、ウェブアプリケーションのテストにも良い選択肢です。

Puppeteer

Puppeteerは、DevToolsプロトコルを介してChromeまたはChromiumを制御するためのNodeライブラリです。ウェブスクレイピング、自動テスト、事前レンダリングされたコンテンツの生成に使用されます。

特徴:

- ヘッドレスブラウジング: Puppeteerは主にヘッドレスモードで使用され、ウェブコンテンツに高速で自動的にアクセスする方法を提供します。

- インタラクティブ性: Puppeteerはフォームの送信、キーボード入力、ボタンクリックなどのユーザー操作をシミュレートできます。

- スクリーンショットとPDF生成: PuppeteerはページのスクリーンショットとPDFを生成できます。

使用例:

JavaScriptを実行する必要がある場合、Puppeteerは役立ちます。ウェブスクレイピング、自動化されたユニットテスト、サーバーサイドレンダリングに使用できます。

Cheerio

Cheerioは、サーバー専用に設計された高速で柔軟なjQueryのコア実装です。Node.jsライブラリで、開発者がjQueryに似た構文でウェブページを解釈し、分析するのを補助します。

特徴:

- jQuery構文: Cheerioはマークアップをパースし、結果のデータ構造を操作するためのAPIを提供します。

- パフォーマンス: Cheerioは一貫性があり、柔軟なDOM操作APIに焦点を当てており、パースとレンダリングを別々に処理することでパフォーマンスを向上させます。

- 柔軟性: 多くのHTMLとXMLドキュメントで動作し、ウェブスクレイピングタスクに非常に柔軟です。

使用例:

Cheerioは、サーバーサイドでのHTMLデータ操作、HTMLドキュメントからのデータ抽出、特にNode.jsでのウェブスクレイピングに適しています。

OutWit Hub

OutWit Hubは、数十のデータ抽出機能を持つFirefoxアドオンで、ウェブ検索を簡素化します。このツールは、ページを自動的にブラウズし、抽出された情報を任意の形式で保存できます。

特徴:

- データ抽出: OutWit Hubは、必要に応じて小規模または大規模なデータをスクレイピングするための単一のインターフェースを提供します。

- データエクスポート: OutWit Hubで収集されたデータは、Excel、CSV、HTML、またはSQLデータベースとしてエクスポートできます。

- 画像とドキュメント抽出: テキストデータの抽出に加え、OutWit Hubは画像、PDFファイルなども抽出できます。

使用例:

OutWit Hubは、ウェブからデータを抽出し、ローカルに保存する必要があるフリーランスや中小企業に適しています。

WebHarvy

WebHarvyは、任意のウェブサイトからデータを簡単にスクレイピングできるポイント&クリックインターフェースを持つ視覚的なウェブスクレイパーです。一度購入するデスクトップアプリケーションです。

特徴:

- 視覚的なインターフェース: WebHarvyは最小限のプログラミング知識で動作する視覚的なインターフェースを使用します。マウスでデータフィールドを選択します。

- マルチレベルスクレイピング: WebHarvyはリンクをたどって詳細ページからデータをスクレイピングでき、ページングを自動的に処理できます。

- 正規表現サポート: WebHarvyは、データ抽出時にパターンをマッチングするために使用できる正規表現(RegEx)をサポートしています。

使用例:

WebHarvyは、特定のウェブサイトから定期的にデータを抽出する必要があるプログラミングを知らないユーザーに最適です。ExcelやCSVファイルにデータを抽出します。

DataMiner

Data Minerは、ブラウザウィンドウ内のHTMLデータをクリーンで構造化されたデータセットに変換する個人向けブラウザ拡張です。

データマイナーは、特定のウェブサイトから中程度の量のデータを収集し、データ入力や抽出に時間を節約する必要があるプロフェッショナルにとって役立ちます。

Mozenda

Mozendaは、あらゆる種類のデータ抽出ニーズに適した企業向けのウェブスクレイピングソフトウェアです。使いやすいポイント&クリックインターフェースを持ち、さまざまなデータタイプを収集する柔軟性を提供しています。

特徴:

- ポイント&クリックインターフェース: Mozendaは、ユーザーがポイント&クリックツールを使用して必要なデータを選択できるようにします。

- クラウドプラットフォーム: Mozendaはクラウドベースのウェブスクレイパーとして動作し、高速なデータ抽出を提供します。

- APIアクセス: MozendaはAPIを提供し、ユーザーが他のアプリケーションでデータを統合できるようにします。

使用ケース:

Mozendaは、テキスト、画像、ドキュメントなど、さまざまなウェブサイトから幅広いデータタイプを抽出する必要がある企業や研究者にとって理想的です。

5. 結論

ウェブスクレイピングツールは、今日のデータ駆動型世界において必須です。顧客の感情を理解したり、競合企業をモニタリングしたりするなど、ウェブスクレイピングの用途は無限です。しかし、すべてのウェブスクレイピングツールが同じではありません。あなたにとって最適なツールは、あなたの技術的スキル、タスクの複雑さ、そして収集したいデータの種類に依存します。

初心者であるか、コードを書くことを好まない場合は、Import.io、Octoparse、ParseHub、WebHarvy、OutWit Hubなどの視覚的でコード不要のツールがより適しています。一方、コードに慣れている場合は、Scrapy、BeautifulSoup、Selenium、Puppeteer、Cheerioなどのより柔軟で強力なツールを使用できます。

どのツールを選択するかに関わらず、常にウェブサイトの利用規約を尊重し、データを責任を持って使用することを心がけてください。

よくある質問

1. 初心者にとって最適なウェブスクレイピングツールはどれですか?

初心者や非技術者向けには、Import.io、Octoparse、ParseHub、WebHarvy、OutWit Hubなどの視覚的でコード不要のツールが最適です。これらはポイント&クリックインターフェースを提供し、スケジューリング機能やデータエクスポートが簡単で、プログラミング知識が不要です。

2. 通常のスクレイパーではなく、SeleniumやPuppeteerを使用すべきタイミングはいつですか?

SeleniumやPuppeteerは、JavaScriptに強く依存しているウェブサイト、動的コンテンツの読み込み、またはボタンのクリック、フォームの入力、無限スクロールなどのユーザー操作が必要な場合に最適です。通常のHTTPベースのスクレイパーではこれらのシナリオで機能しない可能性があります。

3. ウェブスクレイピングは合法ですか?

ウェブスクレイピング自体は違法ではありませんが、その合法性は使用方法や場所によって異なります。ウェブサイトの利用規約、収集しているデータの種類、および地域のデータ保護規制がすべて重要です。責任を持ってスクレイピングを行い、保護されたまたは個人のデータを避けて、関連する法律やポリシーに準拠することが不可欠です。

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

データ・アズ・ア・サービス(DaaS):それは何か、そしてなぜ2026年において重要なのか

2026年のデータ・アズ・ア・サービス(DaaS)を理解する。その利点、ユースケース、およびリアルタイムの洞察と拡張性を通じて企業を変革する方法について探る。

Adélia Cruz

12-Feb-2026

RoxyBrowserでCAPTCHAを解決する方法(CapSolverの統合)

CapSolverをRoxyBrowserと統合して、ブラウザのタスクを自動化し、reCAPTCHA、Turnstile、その他のCAPTCHAを回避します。

Sora Fujimoto

04-Feb-2026

EasySpiderでCapSolverインテグレーションを使用してCaptchaを解く方法

EasySpiderはビジュアルでノーコードのウェブスクリーピングおよびブラウザ自動化ツールであり、CapSolverと組み合わせることで、reCAPTCHA v2やCloudflare TurnstileなどのCAPTCHAを信頼性高く解決できるため、ウェブサイト間でのシームレスな自動データ抽出を可能にします。

Sora Fujimoto

04-Feb-2026

Relevance AIにおけるreCAPTCHA v2のカプソルバー統合による解決方法

Relevance AIツールを構築し、リカプチャv2を解決するためCapSolverを使用します。APIを介してブラウザの自動化なしでフォームの送信を自動化します。

Sora Fujimoto

03-Feb-2026

即時データスカッパーのツール:コードなしでウェブデータを高速に抽出する方法

2026年用の最高のインスタントデータスラッパーのツールを発見してください。コードなしでウェブデータを迅速に抽出する方法を学びましょう。自動抽出用の最高の拡張機能とAPIを使用して。

Nikolai Smirnov

28-Jan-2026

2026年のIPブロック:仕組みと実用的な回避方法

2026年においてIPブロックを回避する方法を、当社の包括的なガイドを通じて学びましょう。現代のIPブロック技術や住宅プロキシーやCAPTCHAソルバーなどの実用的な解決策を発見してください。

Sora Fujimoto

26-Jan-2026