Pythonでのウェブクローラーと、ウェブクローリング時にブロックされるのを避ける方法

Sora Fujimoto

AI Solutions Architect

19-Nov-2025

インターネットは、ニュースのアップデートから、ウェブサイトの奥深くに埋もれたニッチなデータポイントに至るまで、膨大な情報のデータベースです。これらのデータを手動で抽出するのは現実的ではありません。そこでウェブクローリングが役立ちます。ウェブクローリング(またはウェブスクレイピング)とは、ウェブサイトを自動的にナビゲートし、データを抽出して保存するプロセスであり、データ分析、市場調査、コンテンツ集約などの目的で使用されます。

しかし、ウェブクローリングの環境には課題も伴います。ウェブサイトは、自動化されたクローラーを検出およびブロックするための高度な技術を採用しています。これは、単純なレート制限から、高度なCAPTCHAチャレンジに至るまでさまざまです。ウェブクローラー開発者として、これらの課題を効果的に乗り越えることが、信頼性の高いデータ抽出プロセスを維持する鍵となります。

👌 目次

- ウェブクローラーの理解

- Pythonでのウェブクローラー

- ウェブクローリング時にブロックされるのを避ける方法

- 結論

ウェブクローラーの理解

ウェブクローラーとは何か?

ウェブクローラーは、効率的なデジタル探検家とみなされ、インターネットの広範な領域を tirelessly(執念強く)探索します。その使命は、ウェブサイトを体系的にスキャンし、パス上のすべてをインデックス化することです。もともとは検索エンジンのために設計され、高速な検索結果を作成するために使用されていましたが、現在ではクーポンアプリやSEOの専門家など、さまざまな用途に活用されています。タイトル、画像、キーワード、リンクを収集しながら、インデックス作成だけでなく、コンテンツのスクレイピング、ページの変更の追跡、データのマイニングも行います。ウェブスパイダーとして知られるこの存在は、世界中のウェブを織りなすデジタル情報のネットワークを形成しています。

ウェブクローラーの仕組みは?

ウェブクローラーは、事前に定義されたセットから開始し、ハイパーリンクをたどって新しいページを発見するように体系的にウェブページをナビゲートします。クロールを開始する前に、これらのボットはまずサイトのrobots.txtファイルを参照し、ウェブサイトの所有者が設定した、どのページをクロール可能とし、どのリンクをたどるべきかのガイドラインを確認します。

インターネットの膨大な広がりを考慮すると、ウェブクローラーは確立されたルールに基づいて特定のページを優先順位付けます。これは、外部リンクが多いページ、高いトラフィック量、またはブランドの権威性が高いページを優先するためです。この優先順位戦略は、高いトラフィックやリンクを持つページがユーザーが求める権威性のある価値あるコンテンツを提供している可能性が高いという仮定に根ざしています。アルゴリズムも、各ページのコンテンツの関連性やリンクの質を評価するのを補助します。

探索中に、ウェブクローラーは各サイトのメタタグを正確に記録し、これは基本的なメタデータとキーワード情報を提供します。このデータは、検索エンジンがページを検索結果でどのようにランク付けし、表示するかに重要な役割を果たし、ユーザーが情報を検索しやすくするのに役立ちます。

Pythonでのウェブクローラー

Pythonでのウェブクローラーは、事前に定義されたシードURLから始めて、インターネットを体系的にブラウズする自動スクリプトです。これは、HTTPリクエストをウェブサーバーに送信し、HTMLコンテンツを取得し、BeautifulSoupやlxmlなどのライブラリを使用してこのコンテンツを解析することで動作します。これらのライブラリは、ページタイトル、リンク、画像、テキストなどの関連情報を抽出するのに役立ちます。

PythonのウェブリクエストとHTMLの解析における柔軟性は、ウェブクローラーの開発に特に適しています。クローラーは通常、サイトのrobots.txtファイルに定義されたルールに従います。これは、サイトのどの部分がクロール可能で、どのリンクをたどるべきかを指定しています。この遵守は、倫理的なクローリングの実践とサイト所有者の好みを尊重するのに役立ちます。

検索エンジンのページインデックス作成だけでなく、Pythonウェブクローラーはデータマイニング、コンテンツ集約、ウェブサイト変更のモニタリング、さらには自動テストにも使用されます。ページ内のリンクをたどることで、クローラーはウェブサイトをナビゲートし、ウェブの構造を模倣する相互接続されたページのマップを作成します。このプロセスにより、さまざまなソースからデータを体系的に収集し、競合分析、市場調査、情報取得などのタスクを支援できます。

Pythonウェブクローラーの構築

ウェブクローラーを構築する前に、必要なツールとライブラリで開発環境をセットアップすることが不可欠です。

必要条件

- Python: python.orgからPython 3.xをインストールしてください。

- Requestsライブラリ: HTTPリクエストを送信するため。

- Beautiful Soup: HTMLとXMLドキュメントを解析するため。

- Selenium(オプション): JavaScriptでレンダリングされたコンテンツやCAPTCHAを扱うため。

bash

pip install requests beautifulsoup4 seleniumシンプルなウェブクローラーの構築

Pythonを使用して基本的なウェブクローラーを作成し、ウェブページからリンクやテキストを抽出する方法を示します。

python

import requests

from bs4 import BeautifulSoup

def simple_crawler(url):

# HTTPリクエストを送信

response = requests.get(url)

# リクエストが成功したか確認

if response.status_code == 200:

# BeautifulSoupでコンテンツを解析

soup = BeautifulSoup(response.text, 'html.parser')

# 例: ページからすべてのリンクを抽出

links = soup.find_all('a', href=True)

for link in links:

print(link['href'])

# 例: 特定の要素からのテキストを抽出

headings = soup.find_all(['h1', 'h2', 'h3'])

for heading in headings:

print(heading.text)

else:

print(f"{url}からコンテンツを取得できませんでした")

# 例の使用法

simple_crawler('https://example.com')ウェブクローリング時にブロックされるのを避ける方法

Pythonでウェブクローリングを開始すると、ブロックを回避することが重要な課題になります。多くのウェブサイトは、自動化されたツールを検出および妨害するためのアンチボット対策を強化しており、これによりページへのアクセスがブロックされます。

これらの課題を乗り越えるために、以下の戦略を実装することを検討してください。

1. CAPTCHAの対処

CAPTCHAは、自動化されたクローラーに対する一般的な防御メカニズムです。これは、オブジェクトの識別やテキストの入力などのタスクを完了することで、ユーザーが人間であることを証明するチャレンジです。CAPTCHAを処理する最善の戦略は、CapSolverなどの信頼性の高いCAPTCHA解決サービスをウェブスクレイピングワークフローに統合することです。CapSolverは、さまざまなタイプのCAPTCHAをプログラム的に解決するAPIとツールを提供し、Pythonスクリプトとのシームレスな統合を可能にします。以下に簡単なガイドを示します。

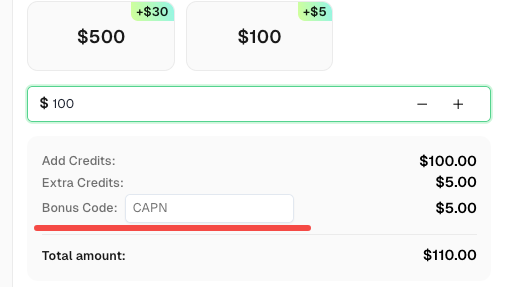

CapSolverのボーナスコードを取得する

さらにオペレーションを最適化する機会を逃さないでください!CapSolverアカウントにチャージする際、ボーナスコードCAPNを使用すると、各チャージで5%のボーナスを獲得できます。CapSolverにアクセスして、今すぐボーナスを取得してください!

Pythonを使用してCapsolverで任意のCAPTCHAを解決する方法:

前提条件

- 作動するプロキシ

- Pythonがインストールされている

- CapSolver APIキー

🤖 ステップ1: 必要なパッケージをインストール

以下のコマンドを実行して必要なパッケージをインストールしてください:

pip install capsolver

以下はreCAPTCHA v2の例です:

👨💻 プロキシを使用してreCAPTCHA v2を解決するPythonコード

このタスクを達成するためのPythonサンプルスクリプトです:

python

import capsolver

# センシティブな情報には環境変数を使用することを検討してください

PROXY = "http://username:password@host:port"

capsolver.api_key = "Your Capsolver API Key"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("reCaptcha v2を解決中")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("解決結果: ", solution)

if __name__ == "__main__":

main()👨💻 プロキシなしでreCAPTCHA v2を解決するPythonコード

このタスクを達成するためのPythonサンプルスクリプトです:

python

import capsolver

# センシティブな情報には環境変数を使用することを検討してください

capsolver.api_key = "Your Capsolver API Key"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("reCaptcha v2を解決中")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("解決結果: ", solution)

if __name__ == "__main__":

main()2. IPブロックとレート制限の回避

ウェブサイトは、過負荷や悪用を防ぐために、一定時間内にクローラーが行うリクエスト数に制限を課すことがよくあります。

検出を回避するための戦略:

- IPアドレスのローテーション: プロキシサーバーまたはVPNを使用してIPアドレスを切り替えて、レート制限をトリガーしないようにします。

- robots.txtの遵守: サイトの

robots.txtファイルに記載されたルールを確認し、遵守することでブロックを避けることができます。 - 親切なポリシーの実装: リクエスト間の遅延(クロール遅延)を実装して、人間のブラウジング行動をシミュレートします。

結論

ウェブクローリングは、ビジネスや研究者が効率的に膨大なデータにアクセスするための力強いツールです。しかし、自動検出とブロックの課題を乗り越えるには、戦略的な計画と倫理的な基準の遵守が必要です。Pythonの強力なライブラリを活用し、ベストプラクティスを実装することで、開発者はウェブサイトが設定した境界を尊重しながら、価値あるインサイトを抽出できる耐性のあるクローラーを構築できます。

要するに、ウェブクローリングをマスターするには、技術的な専門知識だけでなく、ウェブのマナーと法的考慮事項の理解も必要です。これらのツールと戦略を活用することで、プロジェクトでウェブクローリングを責任を持って効果的に活用できます。

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

データ・アズ・ア・サービス(DaaS):それは何か、そしてなぜ2026年において重要なのか

2026年のデータ・アズ・ア・サービス(DaaS)を理解する。その利点、ユースケース、およびリアルタイムの洞察と拡張性を通じて企業を変革する方法について探る。

Adélia Cruz

12-Feb-2026

RoxyBrowserでCAPTCHAを解決する方法(CapSolverの統合)

CapSolverをRoxyBrowserと統合して、ブラウザのタスクを自動化し、reCAPTCHA、Turnstile、その他のCAPTCHAを回避します。

Sora Fujimoto

04-Feb-2026

EasySpiderでCapSolverインテグレーションを使用してCaptchaを解く方法

EasySpiderはビジュアルでノーコードのウェブスクリーピングおよびブラウザ自動化ツールであり、CapSolverと組み合わせることで、reCAPTCHA v2やCloudflare TurnstileなどのCAPTCHAを信頼性高く解決できるため、ウェブサイト間でのシームレスな自動データ抽出を可能にします。

Sora Fujimoto

04-Feb-2026

Relevance AIにおけるreCAPTCHA v2のカプソルバー統合による解決方法

Relevance AIツールを構築し、リカプチャv2を解決するためCapSolverを使用します。APIを介してブラウザの自動化なしでフォームの送信を自動化します。

Sora Fujimoto

03-Feb-2026

即時データスカッパーのツール:コードなしでウェブデータを高速に抽出する方法

2026年用の最高のインスタントデータスラッパーのツールを発見してください。コードなしでウェブデータを迅速に抽出する方法を学びましょう。自動抽出用の最高の拡張機能とAPIを使用して。

Nikolai Smirnov

28-Jan-2026

2026年のIPブロック:仕組みと実用的な回避方法

2026年においてIPブロックを回避する方法を、当社の包括的なガイドを通じて学びましょう。現代のIPブロック技術や住宅プロキシーやCAPTCHAソルバーなどの実用的な解決策を発見してください。

Sora Fujimoto

26-Jan-2026