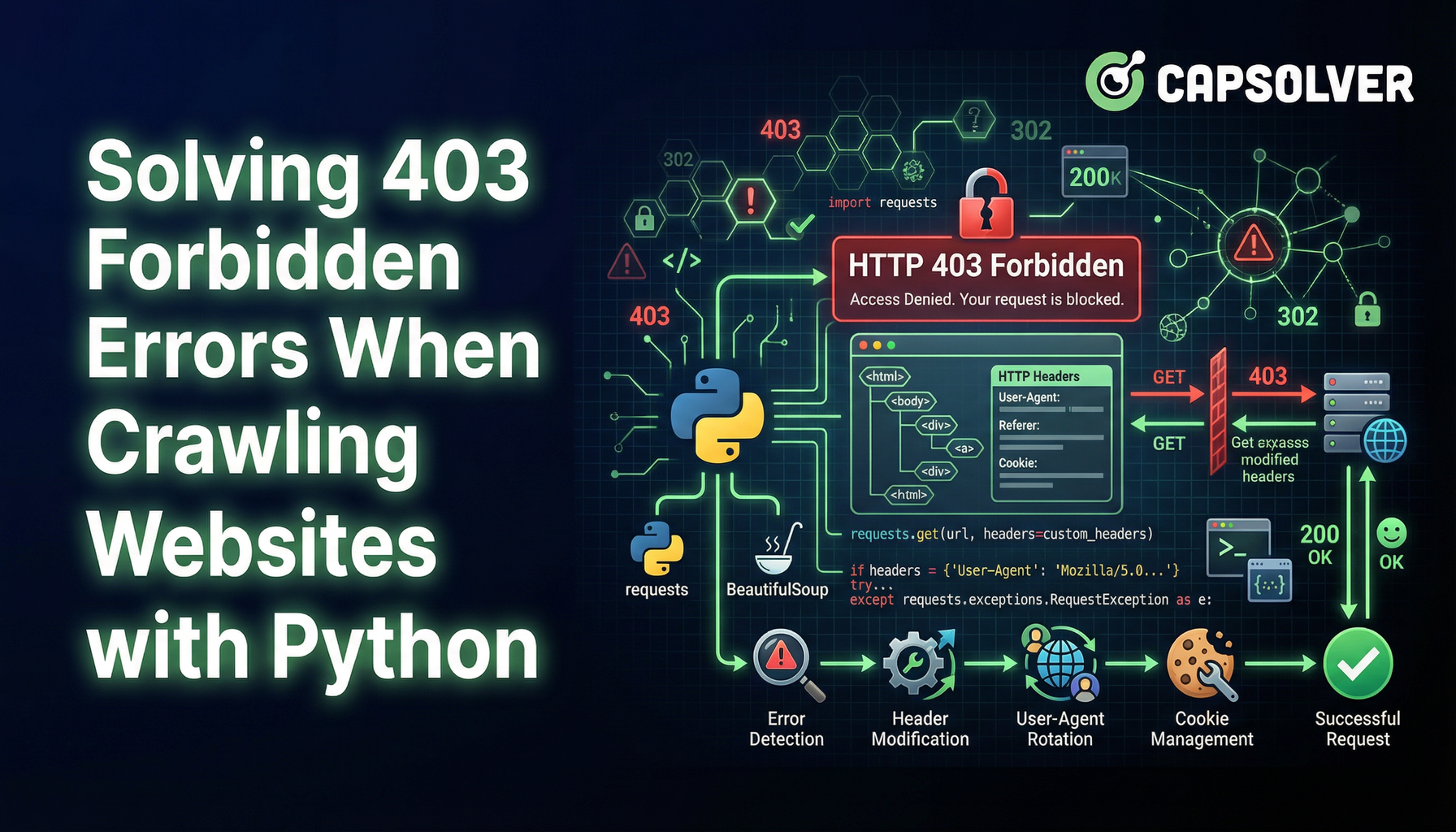

Pythonでウェブサイトをクロールする際の403エラーの解決方法

Sora Fujimoto

AI Solutions Architect

13-Jan-2026

ウェブスクラッピングは、ウェブサイトからデータを抽出するための価値のある技術です。しかし、403 Forbiddenエラーに遭遇することは大きな障害となることがあります。このエラーは、サーバーがリクエストを理解しているものの、認証を拒否していることを示しています。この問題を回避し、ウェブスクラッピングの旅を続ける方法について説明します。

403 Forbiddenエラーの理解

403 Forbiddenエラーは、サーバーが要求されたリソースへのアクセスを拒否したときに発生します。これはいくつかの理由によって起こることがあります:

繰り返されるCAPTCHAの解決に苦労していますか?CapSolverのAIパワードAuto Web Unblock技術で、スムーズな自動CAPTCHA解決を体験してください!

CapSolverのボーナスコードを取得する

自動化予算を即座に増やす!

CapSolverアカウントにチャージする際にボーナスコードCAPNを使用すると、毎回5%のボーナスが追加されます—制限なし。

CapSolverダッシュボードで今すぐ取得してください

。

- IPブロッキング: サーバーは、異常または高頻度のリクエストを検出するとIPアドレスをブロックすることがあります。

- User-Agent制限: 一部のウェブサイトでは、リクエストを行っているブラウザやデバイスを識別するUser-Agent文字列に基づいてアクセスを制限しています。

- 認証が必要: 特定のページにアクセスするにはログイン資格情報やAPIキーが必要な場合があります。

403エラーを回避するテクニック

1. IPアドレスをローテートする

サーバーは一定の閾値を超えると同じIPアドレスからのリクエストをブロックすることがあります。プロキシサーバーのプールを使用してIPアドレスをローテートすることで、これを回避できます。NstproxyやBright Dataなどのサービスがローテートプロキシの解決策を提供しています。

python

import requests

proxies = {

"http": "http://your_proxy_here",

"https": "http://your_proxy_here",

}

response = requests.get("http://example.com", proxies=proxies)2. 現実的なUser-Agentを使用する

ウェブサーバーは疑わしいUser-Agent文字列のリクエストを検出およびブロックすることがあります。通常のブラウザを模倣するUser-Agent文字列をスプーフィングすることで、検出を回避できます。

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. リクエストのスロットリングを実装する

短時間に多くのリクエストを送信すると、レート制限がトリガーされることがあります。リクエストの間に遅延を導入することで、目立たずに済みます。

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # 5秒間の遅延4. 認証を処理する

一部のリソースには認証が必要です。クッキーまたはAPIキーを使用して認証されたリクエストを行うことで、アクセス制限を回避できます。

python

cookies = {

"session": "your_session_cookie_here"

}

response = requests.get("http://example.com", cookies=cookies)5. ヘッドレスブラウザを使用する

PuppeteerやSeleniumなどのヘッドレスブラウザは、リアルなユーザーの操作をシミュレートし、複雑なアンチスクラッピング対策を回避するのに役立ちます。

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. CAPTCHAチャレンジを乗り越える

403エラーに加えて、ウェブスラッパーはしばしばCAPTCHAに遭遇します。reCAPTCHAなどのCAPTCHAは、リクエストが人間によって行われたものであることを証明するために視覚的またはインタラクティブなチャレンジを解決する必要があります。

これらのチャレンジを解決するには、CapSolverなどの自動CAPTCHA解決ソリューションを使用できます。CapSolverはさまざまなCAPTCHAタイプをサポートし、ウェブスクラッピングツールとの簡単な統合を提供しています。

結論

ウェブスクラッピング中に403 Forbiddenエラーに遭遇することは煩わしいかもしれませんが、その理由を理解し、適切なテクニックを採用することでこの障害を乗り越えることができます。IPのローテート、現実的なUser-Agent文字列の使用、リクエストのスロットリング、認証の処理、またはヘッドレスブラウザの活用など、これらの方法は、ウェブから価値あるデータを引き出すことを続けられるようにします。

これらの戦略に従うことで、403エラーを効果的に管理し、よりスムーズで成功しやすいウェブスクラッピングを実現できます。

よくある質問

1. ウェブスクラッピングにおいて403 Forbiddenエラーを回避することは合法ですか?

403エラーを回避することは本質的に違法ではありませんが、ウェブサイトの利用規約、robots.txtのルール、および地域の法律に依存します。公開されているデータを正当な目的でスクラッピングすることは一般的に許可されていますが、認証の回避、有料コンテンツ、または明示的な制限の違反は利用規約や規制に違反する可能性があります。スクラッピングを行う前に、対象サイトのポリシーを確認してください。

2. プロキシとUser-Agentを使用しているにもかかわらず、なぜ403エラーが発生するのでしょうか?

ウェブサイトが高度なボット検出システムを使用している場合、たとえば行動分析、ファイントラッキング、またはCAPTCHAチャレンジを使用している場合、単純なIPのローテートやUser-Agentスプーフィングでは十分でないことがあります。このような場合、リクエストのスロットリング、セッション管理、ヘッドレスブラウザ、およびCapSolverなどのCAPTCHA解決サービスを組み合わせることで、成功確率を大幅に向上させることができます。

3. 大規模なスクラッピングで403エラーを回避する最も信頼性の高い方法はどれですか?

大規模なスクラッピングにおいて最も信頼性の高いアプローチは、階層的な戦略を取ることです。高品質なローテート住宅またはモバイルプロキシ、現実的なブラウザのファイントラッキング、制御されたリクエストレート、適切な認証処理、および自動CAPTCHA解決を組み合わせることです。AIベースのウェブアンブロッキングソリューションを備えたヘッドレスブラウザを使用することで、リアルなユーザーの行動を非常に正確に模倣し、繰り返しの403ブロックの可能性を低減できます。

コンプライアンス免責事項: このブログで提供される情報は、情報提供のみを目的としています。CapSolverは、すべての適用される法律および規制の遵守に努めています。CapSolverネットワークの不法、詐欺、または悪用の目的での使用は厳格に禁止され、調査されます。私たちのキャプチャ解決ソリューションは、公共データのクローリング中にキャプチャの問題を解決する際に100%のコンプライアンスを確保しながら、ユーザーエクスペリエンスを向上させます。私たちは、サービスの責任ある使用を奨励します。詳細については、サービス利用規約およびプライバシーポリシーをご覧ください。

もっと見る

2026年のIPブロック:仕組みと実用的な回避方法

2026年においてIPブロックを回避する方法を、当社の包括的なガイドを通じて学びましょう。現代のIPブロック技術や住宅プロキシーやCAPTCHAソルバーなどの実用的な解決策を発見してください。

Sora Fujimoto

26-Jan-2026

MaxunでCapSolver統合を使用してCaptchaを解決する方法

CapSolverとMaxunを統合して実際のウェブスクレイピングを行うための実用的なガイド。reCAPTCHA、Cloudflare Turnstile、およびCAPTCHAで保護されたサイトを扱う方法を、事前認証とロボットワークフローを使用して学びましょう。

Sora Fujimoto

21-Jan-2026

Captchaをブラウザ4で解く方法とCapSolverの統合

高スループットブラウザ4の自動化と、大規模なウェブデータ抽出におけるCAPTCHAチャレンジを処理するためのCapSolverの組み合わせ。

Sora Fujimoto

21-Jan-2026

スクレイピングボットとは何か、そしてどのように構築するか

スクレイピングボットとは何かを学び、自動データ抽出用にそれを構築する方法を学びましょう。最高のツール、セキュリティナビゲーションのテクニック、および倫理的なスクレイピングの実践を探ってみましょう。

Emma Foster

16-Jan-2026

Scrapy と Selenium: あなたのウェブスクレイピングプロジェクトにどちらが最適か

ScrapyとSeleniumのウェブスクリーピングにおける強みと違いを探る。どのツールがあなたのプロジェクトに最も適しているか、そしてCAPTCHAなどの課題をどう対処するかを学ぶ。

Nikolai Smirnov

14-Jan-2026

Selenium ドライバーレスの使い方: 効率的なウェブスクレイピング

効率的なウェブスクレイピングにSelenium Driverlessを使用する方法を学びましょう。このガイドでは、環境を設定する、最初のSelenium Driverlessスクリプトを書く、動的コンテンツを扱うためのステップバイステップの手順を提供しています。従来のWebDriver管理の複雑さを避けて、ウェブスクレイピングのタスクを簡素化し、データ抽出プロセスをより簡単で、速く、そしてよりポータブルにすることができます。

Nikolai Smirnov

14-Jan-2026