O que é Web Scraping | Casos de uso comuns e problemas

Ethan Collins

Pattern Recognition Specialist

03-Dec-2025

Você pode ter ouvido uma frase sobre dados sendo chamados de novo petróleo na sociedade da informação atual. Devido ao volume enorme de informações disponíveis online, a capacidade de coletar e analisar dados da web de forma eficaz tornou-se um conjunto de habilidades essencial para empresas, pesquisadores e desenvolvedores. É aí que entra o web scraping. Web scraping, também conhecido como extração de dados da web, é uma tecnologia poderosa usada para coletar informações de sites automaticamente. Imagine conseguir obter muitas informações importantes de um site sem ter que copiar e colar dados manualmente, mas o web scraping deve ser usado com cuidado e conformidade. Este blog apresenta brevemente o web scraping e aborda alguns dos problemas que você pode enfrentar. Também falará sobre alguns casos comuns.

Entendendo o Web Scraping

O web scraping envolve o uso de ferramentas de software automatizado, conhecidas como scrapers da web, para coletar dados de páginas da web. Essas ferramentas simulam o comportamento de navegação humana, permitindo que elas naveguem por sites, cliquem em links e extraiam informações do conteúdo HTML. Os dados extraídos podem incluir texto, imagens, links e outros elementos multimídia. Uma vez coletados, os dados podem ser armazenados em bancos de dados ou planilhas para análise posterior.

Scrapers da web funcionam enviando solicitações HTTP para sites e analisando as respostas HTML. Eles podem ser programados para seguir links, lidar com paginação e até interagir com aplicações da web complexas. Linguagens de programação populares para web scraping incluem Python, com bibliotecas como BeautifulSoup, Scrapy e Selenium, que oferecem funcionalidades robustas para extração de dados e automação da web.

Resgate seu código promocional do CapSolver

Aumente seu orçamento de automação instantaneamente!

Use o código promocional CAPN ao recarregar sua conta do CapSolver para obter um bônus extra de 5% em cada recarga — sem limites.

Resgate-o agora em seu Painel do CapSolver

.

A legalidade do Web Scraping

Uma das maiores mitos comuns sobre web scraping é que ele é ilegal. Isso não é preciso!

O web scraping é perfeitamente legal desde que você siga certas diretrizes: obedeça às regulamentações CCPA e GDPR, evite acessar dados protegidos por credenciais de login e fique longe de coletar qualquer informação pessoalmente identificável. No entanto, isso não significa que você possa escavar qualquer site indiscriminadamente. Considerações éticas são cruciais, o que significa que você deve sempre respeitar os termos de serviço do site, o arquivo robots.txt e as políticas de privacidade.

Em essência, o web scraping em si não é ilegal, mas é importante seguir regras específicas e padrões éticos.

Casos de uso do Web Scraping

No mundo atual baseado em dados, o valor dos dados superou o do petróleo, e a Web é uma fonte abundante de informações valiosas. Muitas empresas de diferentes indústrias usam dados extraídos por meio de web scraping para melhorar suas operações comerciais.

Embora haja inúmeras aplicações de web scraping, aqui estão algumas das mais comuns:

Comparação de Preços

Usando ferramentas de web scraping, empresas e consumidores podem coletar preços de produtos de diferentes varejistas e plataformas online. Esses dados podem ser usados para comparar preços, encontrar os melhores negócios e economizar tempo e dinheiro. Além disso, permite que as empresas monitorem as estratégias de preços de seus concorrentes.

Monitoramento de Mercado

O web scraping permite que as empresas acompanhem tendências de mercado, disponibilidade de produtos e mudanças de preços em tempo real. Ao se manter atualizado com as informações mais recentes do mercado, as empresas podem adaptar rapidamente suas estratégias, aproveitar novas oportunidades e responder às demandas dos clientes em constante evolução. Essa abordagem proativa ajuda a manter uma vantagem competitiva.

Análise de Concorrentes

Ao coletar dados sobre os produtos, preços, promoções e feedback dos concorrentes, as empresas podem obter insights valiosos sobre as forças e fraquezas dos concorrentes. Ferramentas automatizadas também podem capturar instantâneos dos sites dos concorrentes e esforços de marketing, fornecendo uma visão abrangente para desenvolver estratégias para superá-los.

Geração de Leads

O web scraping revolucionou a geração de leads, transformando o que antes era um processo intensivo de trabalho em um processo automatizado. Ao extrair informações de contato públicas, como endereços de e-mail e números de telefone, as empresas podem construir rapidamente um banco de dados de leads potenciais. Essa abordagem simplificada acelera o processo de geração de leads.

Análise de Sentimento

O web scraping permite a análise de sentimento ao extrair feedback dos usuários de sites de avaliações e plataformas de redes sociais. Analisar esses dados ajuda as empresas a entenderem a opinião pública sobre seus produtos, serviços e marca. Ao obter insights sobre sentimentos dos clientes, as empresas podem melhorar a satisfação dos clientes e resolver problemas de forma proativa.

Agregação de Conteúdo

O web scraping pode ser usado para aglutinar conteúdo de várias fontes em uma única plataforma. Isso é especialmente útil para sites de notícias, blogs e portais de pesquisa que precisam fornecer informações atualizadas de várias fontes. Ao automatizar a coleta de conteúdo, as empresas economizam tempo e garantem que suas plataformas permaneçam atualizadas.

Listagens de Imóveis

O web scraping também é usado na indústria imobiliária para coletar listagens de imóveis de vários sites. Esses dados ajudam agências imobiliárias e compradores potenciais a comparar imóveis, analisar tendências do mercado e tomar decisões informadas. Automatizar a coleta de dados imobiliários fornece uma visão abrangente do mercado.

Tipos de Scrapers da Web

Scrapers da web vêm em várias formas, cada um adaptado a diferentes propósitos e necessidades dos usuários. Geralmente, podem ser categorizados em quatro tipos principais, cada um oferecendo funcionalidades e benefícios únicos:

- Scrapers de Desktop

Scrapers de desktop são aplicações de software autônomas instaladas diretamente no computador do usuário. Essas ferramentas geralmente oferecem uma interface sem código e amigável ao usuário, permitindo que os usuários extraiam dados por meio de interações simples de clique e arrasto. Scrapers de desktop são equipados com recursos como agendamento de tarefas, análise de dados e opções de exportação, atendendo tanto iniciantes quanto usuários avançados. Eles são adequados para tarefas de raspagem de médio porte e oferecem um bom equilíbrio entre funcionalidade e facilidade de uso.

- Scrapers Personalizados

Scrapers personalizados são soluções altamente flexíveis desenvolvidas por programadores usando várias tecnologias. Esses scrapers são projetados para atender a requisitos específicos de extração de dados, tornando-os ideais para projetos complexos e de grande escala. Devido à sua natureza personalizada, os scrapers personalizados podem lidar com estruturas da web complexas, navegar por conteúdo dinâmico e extrair dados de várias fontes de forma eficiente. Eles são a escolha principal para empresas que exigem soluções de raspagem personalizadas que podem ser facilmente escalonadas e adaptadas às necessidades em constante evolução.

- Scrapers de Extensão de Navegador

Scrapers de extensão de navegador são complementos para navegadores da web populares como Chrome, Firefox e Safari. Essas extensões permitem que os usuários raspem dados diretamente enquanto navegam em sites. Ao usar uma interface intuitiva de clique e arrasto, os usuários podem selecionar e extrair elementos de dados de páginas da web facilmente. Embora os scrapers de extensão de navegador sejam eficazes para tarefas rápidas e de pequena escala, eles geralmente têm limitações em termos de funcionalidade e escalabilidade em comparação com outros tipos de scrapers.

- Scrapers Baseados em Nuvem

Scrapers baseados em nuvem operam na nuvem, fornecendo soluções escalonáveis e distribuídas para raspagem. Esses scrapers são adequados para lidar com tarefas de extração de dados de grande escala e geralmente vêm com capacidades integradas de processamento e armazenamento de dados. Os usuários podem acessar scrapers baseados em nuvem remotamente, agendar tarefas de raspagem e gerenciar a extração de dados sem a necessidade de infraestrutura local. Embora ofereçam capacidades robustas para raspagem de alto volume, sua flexibilidade para lidar com conteúdo da web complexo e dinâmico pode ser menor do que a de scrapers personalizados.

Ao selecionar um scraper da web, é essencial considerar a complexidade da tarefa, o volume de dados a ser coletado e os requisitos de escalabilidade e tecnologia do projeto. Cada tipo de scraper tem suas próprias vantagens e casos de uso, e a escolha dependerá das necessidades específicas do usuário ou organização.

Superando Desafios no Web Scraping

O web scraping, embora poderoso, também apresenta grandes obstáculos devido ao ambiente da internet em constante mudança e às proteções empregadas pelos sites, não é uma tarefa simples, e há alta probabilidade de você enfrentar os seguintes tipos de problemas.

A principal dificuldade no web scraping vem da dependência da estrutura HTML de uma página da web. Sempre que um site atualiza sua interface do usuário, os elementos HTML que contêm os dados desejados podem mudar, tornando seu scraper ineficaz. Adaptar-se a essas mudanças requer manutenção constante e atualização da lógica de raspagem. Usar seletores de elementos HTML robustos que se adaptem a pequenas mudanças na interface pode mitigar esse problema, mas não há uma solução única para todos.

Infelizmente, mais complexidade está por vir, e muito mais complexa do que a manutenção.

Sites implementam tecnologias sofisticadas para proteger seus dados de scrapers automatizados. Esses sistemas podem detectar e sinalizar solicitações automatizadas, representando um obstáculo significativo. Aqui estão alguns dos desafios comuns que os scrapers enfrentam:

- Bans de IP: Servidores monitoram solicitações entrantes por padrões suspeitos. Detectar software automatizado frequentemente leva ao bloqueio de IP, impedindo o acesso adicional ao site.

- Restrições Geográficas: Alguns sites restringem o acesso com base na localização geográfica do usuário. Isso pode bloquear usuários estrangeiros de acessar certos conteúdos ou apresentar dados diferentes com base na localização, complicando o processo de raspagem.

- Limitação de Taxa: Fazer muitas solicitações em um curto período de tempo pode acionar medidas de proteção contra DDoS ou bans de IP, interrompendo a operação de raspagem.

- CAPTCHAs: Sites frequentemente usam CAPTCHAs para distinguir entre humanos e bots, especialmente se atividade suspeita for detectada. Resolver CAPTCHAs de forma programática é altamente desafiador, frequentemente impedindo scrapers automatizados.

Enquanto resolver os três primeiros problemas pode ser feito trocando proxies ou usando um navegador de impressão digital, o último CAPTCHA requer soluções alternativas complexas que normalmente têm resultados inconsistentes ou podem ser resolvidos apenas por um curto período de tempo. Independentemente da técnica usada, esses obstáculos prejudicam a eficácia e a estabilidade de qualquer ferramenta de web scraping.

Felizmente, há uma solução para esse problema, e é o CapSolver, que oferece soluções completas para esses desafios. O CapSolver especializa-se na resolução de CAPTCHAs e ajuda de forma eficaz no web scraping com tecnologia avançada para garantir uma raspagem estável e eficaz. Ao integrar o CapSolver ao seu fluxo de trabalho de raspagem, você pode superar esses desafios, aqui estão alguns passos básicos.

Integração de Solucionadores de CAPTCHA

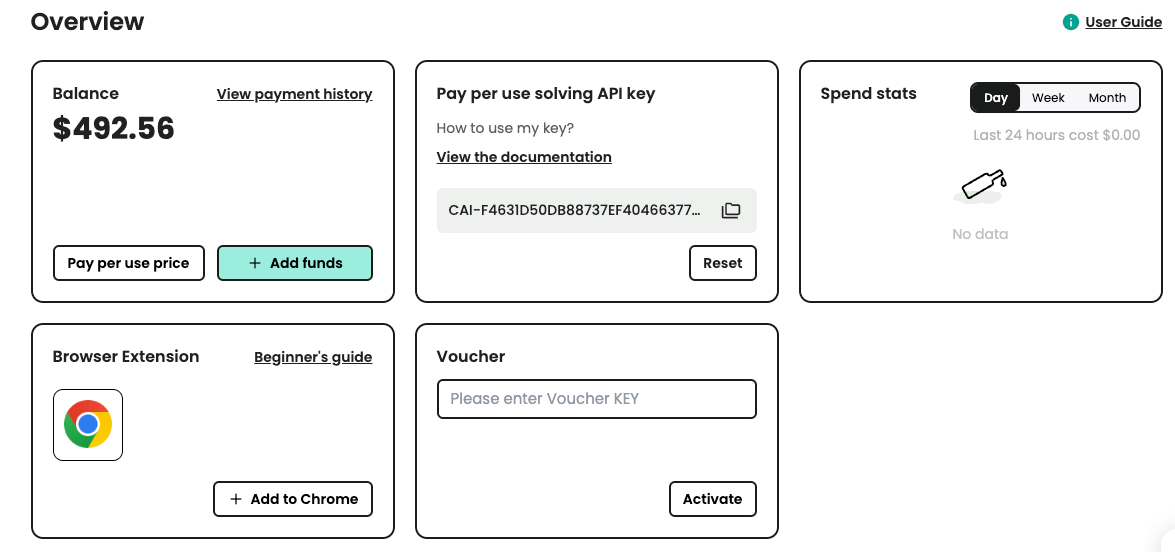

Existem vários serviços de resolução de CAPTCHA disponíveis que podem ser integrados ao seu script de raspagem. Aqui, usaremos o serviço CapSolver. Primeiro, você precisa se cadastrar no CapSolver e obter sua chave de API.

Passo 1: Registre-se no CapSolver

Antes de estar pronto para usar os serviços do CapSolver, você precisa ir ao painel do usuário e registrar sua conta.

Passo 2: Obtenha sua chave de API

Após se registrar, você pode obter sua chave de API no painel da página inicial

Código de Exemplo para o CapSolver

Usar o CapSolver em seu projeto de raspagem da web ou automação é simples. Aqui está um exemplo rápido em Python para demonstrar como você pode integrar o CapSolver ao seu fluxo de trabalho:

python

# pip install requests

import requests

import time

# TODO: defina sua configuração

api_key = "SUA_CHAVE_DE_API" # sua chave de API do capsolver

site_key = "6Le-wvkSAAAAAPBMRTvw0Q4Muexq9bi0DJwx_mJ-" # chave do site do seu site de destino

site_url = "" # URL da página do seu site de destino

def capsolver():

payload = {

"clientKey": api_key,

"task": {

"type": 'ReCaptchaV2TaskProxyLess',

"websiteKey": site_key,

"websiteURL": site_url

}

}

res = requests.post("https://api.capsolver.com/createTask", json=payload)

resp = res.json()

task_id = resp.get("taskId")

if not task_id:

print("Falha ao criar tarefa:", res.text)

return

print(f"Obtido taskId: {task_id} / Obtendo resultado...")

while True:

time.sleep(3) # atraso

payload = {"clientKey": api_key, "taskId": task_id}

res = requests.post("https://api.capsolver.com/getTaskResult", json=payload)

resp = res.json()

status = resp.get("status")

if status == "ready":

return resp.get("solution", {}).get('gRecaptchaResponse')

if status == "failed" or resp.get("errorId"):

print("Falha na resolução! resposta:", res.text)

return

token = capsolver()

print(token)Neste exemplo, a função capsolver envia uma solicitação à API do CapSolver com os parâmetros necessários e retorna a solução do CAPTCHA. Essa integração simples pode poupar-lhe incontáveis horas e esforço na resolução manual de CAPTCHAs durante tarefas de raspagem da web e automação.

Conclusão

O web scraping transformou a forma como coletamos e analisamos dados online. Da comparação de preços às tendências de mercado e geração de leads, suas aplicações são diversas e poderosas. Apesar dos desafios impostos por medidas anti-raspagem, como CAPTCHAs, soluções como o CapSolver permitem processos de extração de dados mais suaves.

Ao seguir diretrizes éticas e aproveitar ferramentas avançadas, empresas e desenvolvedores podem aproveitar ao máximo o potencial do web scraping. Não se trata apenas de coletar dados; é sobre desbloquear insights, impulsionar inovações e permanecer competitivo no cenário digital de hoje.

Perguntas Frequentes

1. Como eu posso contornar o reCAPTCHA ou hCaptcha de forma segura durante a raspagem da web?

O caminho mais seguro e confiável para contornar reCAPTCHA, hCaptcha ou Cloudflare Turnstile é usar uma API dedicada de resolução de CAPTCHA, como o CapSolver. Ele se integra a scripts de raspagem, ferramentas de automação de navegador (Puppeteer, Playwright, Selenium) e gerencia tokens de desafio automaticamente sem intervenção manual. Evite usar scripts ou bots não confiáveis para evitar banimentos de conta ou riscos de segurança.

2. Por que meu scraper é bloqueado mesmo com proxies em rotação?

Os sites agora usam múltiplas camadas de detecção de bots, incluindo verificações de impressão digital do navegador, análise comportamental, fingerprinting TLS e desafios CAPTCHA. Mesmo com proxies em rotação, a raspagem pode falhar se o ambiente do navegador parecer automatizado. Usar um motor de navegador real com cabeçalhos corretos, intervalos semelhantes aos humanos e um serviço de resolução de CAPTCHA aumenta significativamente as taxas de sucesso.

3. É legal usar serviços de resolução de CAPTCHA para tarefas de automação?

Sim — serviços de resolução de CAPTCHA são legais quando usados para tarefas compatíveis, como pesquisa de dados, monitoramento de SEO, rastreamento de preços ou automação que não viole os termos do site ou acesso a dados protegidos. Sempre certifique-se de que seu caso de uso siga as regulamentações de privacidade locais (GDPR, CCPA) e respeite as regras das plataformas.

4. Qual é o melhor método para raspar sites com JavaScript?

Para sites com muita JavaScript, navegadores headless como Puppeteer, Playwright ou Selenium oferecem a maior taxa de sucesso. Eles executam scripts completamente, carregam conteúdo dinâmico e imitam comportamentos de usuários reais. Para extração em larga escala, use essas ferramentas juntamente com proxies, limitação de taxa e integrações de resolução de CAPTCHA.

5. Como o CapSolver melhora o sucesso da automação em sites protegidos?

O CapSolver resolve automaticamente reCAPTCHA, Geetest, Turnstile e outros desafios anti-bot com alta precisão. Ele funciona de forma integrada com frameworks de raspagem e reduz as taxas de falha causadas por paredes de verificação. Isso resulta em raspagem mais suave, menos interrupções e maior eficiência na automação.

6. Como posso reduzir a chance de minha automação ser detectada como um bot?

Use impressões digitais de navegador realistas, rotacione proxies de alta qualidade, simule pausas naturais, carregue ativos normalmente e evite inundar endpoints com solicitações rápidas. Combinar essas etapas com resolução de CAPTCHA ajuda seu scraper a parecer mais como uma sessão real de usuário humano.

Declaração de Conformidade: As informações fornecidas neste blog são apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas soluções de resolução de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos serviços. Para mais informações, visite nossos Termos de Serviço e Política de Privacidade.

Mais

Dados como Serviço (DaaS): O que é e por que importa em 2026

Entenda Dados como Serviço (DaaS) em 2026. Descubra seus benefícios, casos de uso e como transforma os negócios com visões em tempo real e escalabilidade.

Ethan Collins

12-Feb-2026

Como corrigir erros comuns de raspagem da web em 2026

Dominar a correção de diversos erros de raspagem de web, como 400, 401, 402, 403, 429, 5xx e 1001 do Cloudflare em 2026. Aprenda estratégias avançadas para rotação de IPs, cabeçalhos e limitação de taxa adaptativa com o CapSolver.

Rajinder Singh

05-Feb-2026

Como resolver Captcha no RoxyBrowser com integração do CapSolver

Integre o CapSolver com o RoxyBrowser para automatizar tarefas do navegador e contornar o reCAPTCHA, o Turnstile e outros CAPTCHAS.

Adélia Cruz

04-Feb-2026

Como resolver Captcha no EasySpider com integração do CapSolver

EasySpider é uma ferramenta de raspagem de web e automação do navegador visual e sem código, e quando combinado com o CapSolver, pode resolver de forma confiável CAPTCHAs como reCAPTCHA v2 e Cloudflare Turnstile, permitindo a extração de dados automatizada sem interrupções em sites.

Adélia Cruz

04-Feb-2026

Como resolver reCAPTCHA v2 no Relevance AI com integração da CapSolver

Construa uma ferramenta da Relevance AI para resolver reCAPTCHA v2 usando o CapSolver. Automatize os envios de formulários via API sem automação de navegador.

Adélia Cruz

03-Feb-2026

Ferramentas de Raspagem de Dados Instantâneas: Métodos Rápidos para Extrair Dados da Web Sem Código

Descubra as melhores ferramentas de raspagem de dados instantâneas para 2026. Aprenda formas rápidas de extrair dados da web sem código usando as melhores extensões e APIs para extração automatizada.

Emma Foster

28-Jan-2026