Apa Itu Web Scraping | Contoh Penggunaan dan Masalah

Lucas Mitchell

Automation Engineer

03-Dec-2025

Anda mungkin pernah mendengar pernyataan bahwa data disebut sebagai minyak baru di masyarakat informasi saat ini. Karena volume informasi yang sangat besar yang tersedia secara online, kemampuan untuk mengumpulkan dan menganalisis data web secara efektif telah menjadi keterampilan kunci bagi bisnis, peneliti, dan pengembang. Inilah saatnya web scraping masuk. Web scraping, juga dikenal sebagai ekstraksi data web, adalah teknologi yang kuat digunakan untuk mengumpulkan informasi dari situs web secara otomatis. Bayangkan kemampuan untuk mendapatkan banyak informasi penting dari situs web tanpa harus menyalin dan menempelkan data secara manual, tetapi web scraping harus digunakan dengan hati-hati dan kepatuhan. Blog ini akan secara singkat memperkenalkan web scraping dan mengatasi beberapa masalah yang mungkin Anda temui. Ini juga akan membahas beberapa kasus umum.

Memahami Web Scraping

Web scraping melibatkan penggunaan alat perangkat lunak otomatis, yang dikenal sebagai pemindai web, untuk mengumpulkan data dari halaman web. Alat-alat ini mensimulasikan perilaku penjelajahan manusia, memungkinkan mereka untuk menjelajahi situs web, mengklik tautan, dan mengekstrak informasi dari konten HTML. Data yang diekstrak dapat mencakup teks, gambar, tautan, dan elemen multimedia lainnya. Setelah dikumpulkan, data tersebut dapat disimpan dalam basis data atau lembaran kerja untuk analisis lebih lanjut.

Pemindai web beroperasi dengan mengirim permintaan HTTP ke situs web dan memproses respons HTML. Mereka dapat diprogram untuk mengikuti tautan, menangani pagination, dan bahkan berinteraksi dengan aplikasi web yang kompleks. Bahasa pemrograman populer untuk web scraping termasuk Python, dengan perpustakaan seperti BeautifulSoup, Scrapy, dan Selenium, yang menawarkan fungsionalitas yang kuat untuk ekstraksi data dan otomasi web.

Tukarkan Kode Bonus CapSolver Anda

Meningkatkan anggaran otomatisasi Anda secara instan!

Gunakan kode bonus CAPN saat menambahkan dana ke akun CapSolver Anda untuk mendapatkan bonus tambahan 5% pada setiap pengisian ulang — tanpa batas.

Tukarkan sekarang di Dashboard CapSolver

.

Hukum Web Scraping

Salah satu kesalahpahaman umum tentang web scraping adalah bahwa itu ilegal. Ini tidak akurat!

Web scraping adalah legal selama Anda mengikuti panduan tertentu: mematuhi regulasi CCPA dan GDPR, menghindari mengakses data yang dilindungi oleh kredensial login, dan menjauhi pengumpulan informasi yang dapat mengidentifikasi pribadi. Namun, ini tidak memberi kebebasan penuh untuk mengambil data dari situs web mana pun secara sembarangan. Pertimbangan etis sangat penting, artinya Anda harus selalu menghormati ketentuan situs, file robots.txt, dan kebijakan privasi.

Secara esensial, web scraping itu sendiri tidak melanggar hukum, tetapi penting untuk mematuhi aturan dan standar etis tertentu.

Kasus Penggunaan Web Scraping

Di dunia yang didorong oleh data saat ini, nilai data telah melebihi minyak, dan Web adalah sumber informasi yang kaya. Banyak perusahaan di berbagai industri memanfaatkan data yang diekstrak melalui web scraping untuk meningkatkan operasi bisnis mereka.

Meskipun ada banyak aplikasi web scraping, berikut ini beberapa yang paling umum:

Perbandingan Harga

Menggunakan alat web scraping, bisnis dan konsumen dapat mengumpulkan harga produk dari toko ritel dan platform online yang berbeda. Data ini dapat digunakan untuk membandingkan harga, menemukan penawaran terbaik, dan menghemat waktu serta uang. Selain itu, memungkinkan perusahaan untuk memantau strategi harga kompetitor mereka.

Pemantauan Pasar

Web scraping memungkinkan bisnis untuk memantau tren pasar, ketersediaan produk, dan perubahan harga secara real-time. Dengan tetap memperbarui informasi pasar terbaru, perusahaan dapat segera menyesuaikan strategi mereka, memanfaatkan peluang baru, dan merespons permintaan pelanggan yang berubah. Pendekatan proaktif ini membantu mempertahankan keunggulan kompetitif.

Analisis Kompetitor

Dengan mengumpulkan data tentang produk, harga, promosi, dan umpan balik pelanggan kompetitor, bisnis dapat memperoleh wawasan berharga tentang kekuatan dan kelemahan kompetitor mereka. Alat otomatis juga dapat menangkap snapshot dari situs web dan upaya pemasaran kompetitor, memberikan gambaran menyeluruh untuk mengembangkan strategi yang dapat mengungguli mereka.

Pencarian Prospek

Web scraping telah merevolusi pencarian prospek, mengubah apa yang dulu menjadi proses yang melelahkan menjadi otomatis. Dengan mengekstrak informasi kontak yang tersedia secara publik seperti alamat email dan nomor telepon, bisnis dapat segera membangun database prospek potensial. Pendekatan yang dipercepat ini mempercepat proses pencarian prospek.

Analisis Sentimen

Web scraping memungkinkan analisis sentimen dengan mengekstrak umpan balik pengguna dari situs ulasan dan platform media sosial. Menganalisis data ini membantu bisnis memahami opini publik tentang produk, layanan, dan merek mereka. Dengan memperoleh wawasan tentang sentimen pelanggan, perusahaan dapat meningkatkan kepuasan pelanggan dan menangani masalah secara proaktif.

Agregasi Konten

Web scraping dapat digunakan untuk mengumpulkan konten dari berbagai sumber ke dalam satu platform. Ini terutama berguna bagi situs berita, blog, dan portal penelitian yang perlu menyediakan informasi terkini dari sumber yang berbeda. Dengan mengotomasi pengumpulan konten, bisnis dapat menghemat waktu dan memastikan platform mereka tetap up-to-date.

Daftar Properti

Web scraping juga digunakan dalam industri properti untuk mengumpulkan daftar properti dari berbagai situs web. Data ini membantu agen properti dan calon pembeli membandingkan properti, menganalisis tren pasar, dan membuat keputusan yang terinformasi. Mengotomasi pengumpulan data properti memberikan gambaran menyeluruh tentang pasar.

Jenis Pemindai Web

Pemindai web hadir dalam berbagai bentuk, masing-masing disesuaikan untuk tujuan dan kebutuhan pengguna yang berbeda. Secara umum, mereka dapat dikategorikan menjadi empat jenis utama, masing-masing menawarkan fungsionalitas dan manfaat unik:

- Pemindai Desktop

Pemindai desktop adalah aplikasi perangkat lunak mandiri yang diinstal langsung ke komputer pengguna. Alat ini sering menyediakan antarmuka tanpa kode, yang ramah pengguna, memungkinkan pengguna untuk mengekstrak data melalui interaksi titik-klik sederhana. Pemindai desktop dilengkapi fitur seperti penjadwalan tugas, parsing data, dan opsi ekspor, yang menyesuaikan baik pemula maupun pengguna lanjutan. Mereka cocok untuk tugas pemindaian skala menengah dan menawarkan keseimbangan yang baik antara fungsionalitas dan kemudahan penggunaan.

- Pemindai Kustom

Pemindai kustom adalah solusi yang sangat fleksibel yang dikembangkan oleh programmer menggunakan berbagai teknologi. Pemindai ini dirancang untuk memenuhi kebutuhan ekstraksi data spesifik, menjadikannya ideal untuk proyek yang kompleks dan skala besar. Karena sifatnya yang khusus, pemindai kustom dapat menangani struktur web yang rumit, menjelajahi konten dinamis, dan mengekstrak data dari berbagai sumber secara efisien. Mereka adalah pilihan utama bagi bisnis yang membutuhkan solusi pemindaian yang disesuaikan yang dapat dengan mudah diskala dan disesuaikan dengan kebutuhan yang berkembang.

- Pemindai Ekstensi Peramban

Pemindai ekstensi peramban adalah tambahan untuk peramban web populer seperti Chrome, Firefox, dan Safari. Ekstensi ini memungkinkan pengguna untuk memindai data secara langsung saat menjelajahi situs web. Dengan antarmuka titik-klik yang intuitif, pengguna dapat dengan mudah memilih dan mengekstrak elemen data dari halaman web. Meskipun pemindai ekstensi peramban efektif untuk tugas kecil dan cepat, mereka seringkali memiliki keterbatasan dalam hal fungsionalitas dan skalabilitas dibandingkan jenis pemindai lainnya.

- Pemindai Berbasis Cloud

Pemindai berbasis cloud beroperasi di awan, menawarkan solusi pemindaian yang skalabel dan terdistribusi. Pemindai ini cocok untuk menangani tugas ekstraksi data skala besar dan seringkali dilengkapi dengan kemampuan pemrosesan dan penyimpanan data yang terintegrasi. Pengguna dapat mengakses pemindai berbasis cloud secara remote, menjadwalkan tugas pemindaian, dan mengelola ekstraksi data tanpa perlu infrastruktur lokal. Meskipun mereka menawarkan kemampuan yang kuat untuk pemindaian volume tinggi, fleksibilitasnya dalam menangani konten web yang kompleks dan dinamis mungkin kurang dibandingkan pemindai kustom.

Ketika memilih pemindai web, penting untuk mempertimbangkan kompleksitas tugas, volume data yang akan dikumpulkan, dan kebutuhan proyek untuk skalabilitas dan teknis. Setiap jenis pemindai memiliki kekuatannya masing-masing dan kasus penggunaan, dan pilihan akan bergantung pada kebutuhan spesifik pengguna atau organisasi.

Mengatasi Tantangan dalam Web Scraping

Web scraping, meskipun kuat, juga menawarkan rintangan besar karena lingkungan internet yang berubah cepat dan perlindungan yang digunakan situs web, bukanlah tugas yang sederhana, dan ada probabilitas tinggi bahwa Anda akan menghadapi jenis masalah berikut ini

Kesulitan utama dalam web scraping berasal dari ketergantungan pada struktur HTML halaman web. Setiap kali situs web memperbarui antarmuka pengguna, elemen HTML yang mengandung data yang diinginkan mungkin berubah, membuat pemindai Anda tidak efektif. Menyesuaikan perubahan ini memerlukan pemeliharaan dan pembaruan logika pemindaian Anda secara terus-menerus. Menggunakan pemilih elemen HTML yang kuat yang dapat menyesuaikan perubahan UI kecil dapat mengurangi masalah ini, tetapi tidak ada solusi yang cocok untuk semua.

Sayangnya, kompleksitas yang lebih besar masih menanti, dan jauh lebih kompleks daripada pemeliharaan.

Situs web menerapkan teknologi canggih untuk melindungi data mereka dari pemindai otomatis. Sistem ini dapat mendeteksi dan menghentikan permintaan otomatis, menjadi penghalang signifikan. Berikut ini tantangan umum yang dihadapi pemindai:

- Blokir IP: Server memantau permintaan masuk untuk pola yang mencurigakan. Mendeteksi perangkat lunak otomatis sering kali menyebabkan blokir IP, mencegah akses lebih lanjut ke situs.

- Pembatasan Geografis: Beberapa situs web membatasi akses berdasarkan lokasi geografis pengguna. Ini dapat memblokir pengguna asing dari mengakses konten tertentu atau menampilkan data yang berbeda berdasarkan lokasi, memperumit proses pemindaian.

- Pembatasan Kecepatan: Membuat terlalu banyak permintaan dalam waktu singkat dapat memicu langkah perlindungan DDoS atau blokir IP, mengganggu operasi pemindaian.

- CAPTCHA: Situs web sering menggunakan CAPTCHA untuk membedakan antara manusia dan bot, terutama jika aktivitas mencurigakan terdeteksi. Menyelesaikan CAPTCHA secara programatis sangat sulit, sering menghambat pemindai otomatis.

Meskipun masalah pertama dan ketiga dapat diatasi dengan mengganti proxy atau menggunakan browser fingerprinting, CAPTCHA yang terakhir memerlukan solusi kompleks yang biasanya memiliki hasil yang tidak konsisten atau hanya dapat diselesaikan dalam waktu singkat. Terlepas dari teknik yang digunakan, rintangan ini mengurangi efektivitas dan stabilitas setiap alat pemindaian web.

Sayangnya, ada solusi untuk masalah ini, dan itu adalah CapSolver, yang menawarkan solusi komprehensif untuk tantangan ini. CapSolver spesialis dalam penyelesaian CAPTCHA dan secara efektif membantu pemindaian web dengan teknologi canggih untuk memastikan pemindaian web yang stabil dan efektif. Dengan mengintegrasikan CapSolver ke dalam alur kerja pemindaian Anda, Anda dapat mengatasi tantangan ini, berikut adalah beberapa langkah dasar.

Mengintegrasikan Penyelesaian CAPTCHA

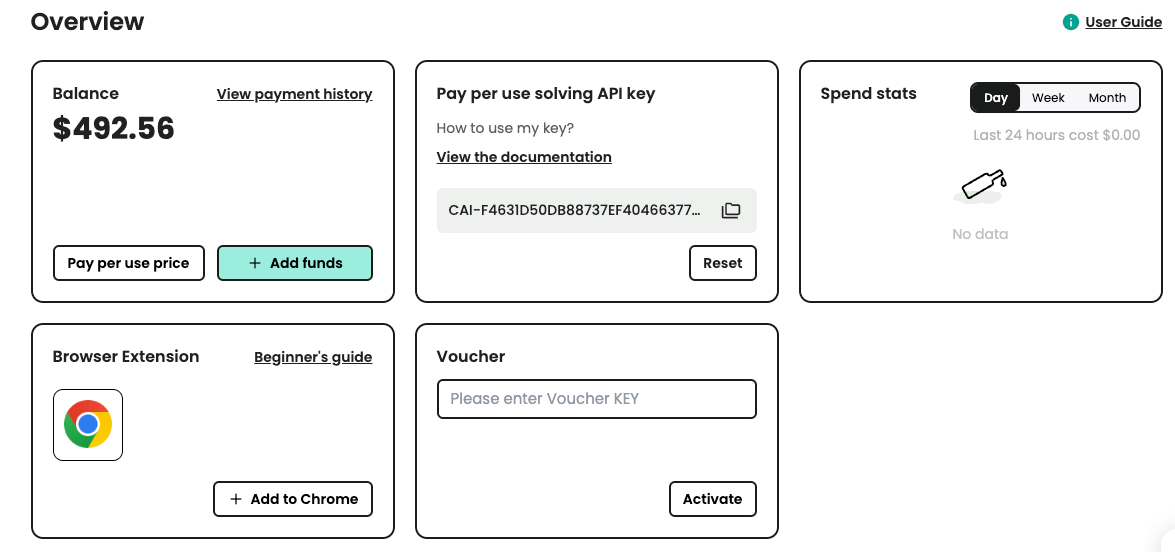

Ada beberapa layanan penyelesaian CAPTCHA yang tersedia yang dapat diintegrasikan ke dalam skrip pemindaian Anda. Di sini, kita akan menggunakan layanan CapSolver. Pertama, Anda perlu mendaftar ke CapSolver dan mendapatkan kunci API Anda.

Langkah. 1: Daftar ke CapSolver

Sebelum Anda siap menggunakan layanan CapSolver, Anda perlu pergi ke panel pengguna dan daftar akun Anda.

Langkah. 2: Dapatkan Kunci API Anda

Setelah Anda mendaftar, Anda dapat mendapatkan kunci API dari panel halaman utama

Contoh Kode untuk CapSolver

Menggunakan CapSolver dalam proyek pemindaian web atau otomasi Anda adalah sederhana. Berikut ini contoh cepat dalam Python untuk menunjukkan bagaimana Anda dapat mengintegrasikan CapSolver ke dalam alur kerja Anda:

python

# pip install requests

import requests

import time

# TODO: atur konfigurasi Anda

api_key = "KUNCI_API_ANDA" # kunci API Anda dari capsolver

site_key = "6Le-wvkSAAAAAPBMRTvw0Q4Muexq9bi0DJwx_mJ-" # kunci situs dari situs target Anda

site_url = "" # URL halaman dari situs target Anda

def capsolver():

payload = {

"clientKey": api_key,

"task": {

"type": 'ReCaptchaV2TaskProxyLess',

"websiteKey": site_key,

"websiteURL": site_url

}

}

res = requests.post("https://api.capsolver.com/createTask", json=payload)

resp = res.json()

task_id = resp.get("taskId")

if not task_id:

print("Gagal membuat tugas:", res.text)

return

print(f"Dapatkan taskId: {task_id} / Mendapatkan hasil...")

while True:

time.sleep(3) # jeda

payload = {"clientKey": api_key, "taskId": task_id}

res = requests.post("https://api.capsolver.com/getTaskResult", json=payload)

resp = res.json()

status = resp.get("status")

if status == "ready":

return resp.get("solution", {}).get('gRecaptchaResponse')

if status == "failed" or resp.get("errorId"):

print("Penyelesaian gagal! respons:", res.text)

return

token = capsolver()

print(token)Dalam contoh ini, fungsi capsolver() mengirim permintaan ke API CapSolver dengan parameter yang diperlukan dan mengembalikan solusi CAPTCHA. Integrasi sederhana ini dapat menghemat banyak jam dan usaha dalam menyelesaikan CAPTCHA secara manual selama pemindaian web dan tugas otomasi.

Kesimpulan

Web scraping telah mengubah cara kita mengumpulkan dan menganalisis data secara online. Dari perbandingan harga hingga tren pasar dan pencarian prospek, aplikasinya beragam dan kuat. Meskipun tantangan yang ditimbulkan oleh langkah-langkah anti-pemindaian seperti CAPTCHA, solusi seperti CapSolver memungkinkan proses ekstraksi data yang lebih mulus.

Dengan mematuhi pedoman etis dan memanfaatkan alat canggih, bisnis dan pengembang dapat memanfaatkan potensi penuh web scraping. Ini bukan hanya tentang mengumpulkan data; ini tentang mengungkap wawasan, mendorong inovasi, dan tetap kompetitif dalam lingkungan digital saat ini.

FAQ

1. Bagaimana cara melewati reCAPTCHA atau hCaptcha secara aman selama web scraping?

Cara yang paling aman dan terpercaya untuk melewati reCAPTCHA, hCaptcha, atau Cloudflare Turnstile adalah dengan menggunakan API penyelesaian CAPTCHA khusus seperti CapSolver. API ini terintegrasi dengan skrip pengambilan data, alat otomatisasi browser (Puppeteer, Playwright, Selenium), dan menangani token tantangan secara otomatis tanpa intervensi manual. Hindari menggunakan skrip atau bot yang tidak tepercaya untuk mencegah pemblokiran akun atau risiko keamanan.

2. Mengapa scraper saya diblokir meskipun menggunakan proksi yang diubah-ubah?

Situs web sekarang menggunakan beberapa lapisan deteksi bot, termasuk pemeriksaan sidik jari browser, analisis perilaku, pemeriksaan sidik jari TLS, dan tantangan CAPTCHA. Bahkan dengan proksi yang diubah-ubah, pengambilan data bisa gagal jika lingkungan browser Anda terlihat otomatis. Menggunakan mesin browser nyata dengan header yang benar, waktu yang mirip manusia, dan layanan penyelesaian CAPTCHA secara signifikan meningkatkan tingkat keberhasilan.

3. Apakah legal menggunakan layanan penyelesaian CAPTCHA untuk tugas otomasi?

Ya—layanan penyelesaian CAPTCHA legal ketika digunakan untuk tugas yang sesuai, seperti penelitian data, pemantauan SEO, pelacakan harga, atau otomasi yang tidak melanggar ketentuan situs atau mengakses data yang dilindungi. Selalu pastikan penggunaan kasus Anda sesuai dengan regulasi privasi setempat (GDPR, CCPA) dan menghormati aturan platform.

4. Apa metode terbaik untuk mengambil data situs web yang berbasis JavaScript?

Untuk situs web yang berbasis JavaScript berat, browser tanpa tampilan seperti Puppeteer, Playwright, atau Selenium memberikan tingkat keberhasilan tertinggi. Mereka mengeksekusi skrip secara penuh, memuat konten dinamis, dan meniru perilaku pengguna nyata. Untuk ekstraksi data skala besar, gunakan alat ini bersamaan dengan proksi, pembatasan kecepatan, dan integrasi layanan penyelesaian CAPTCHA.

5. Bagaimana CapSolver meningkatkan keberhasilan otomasi di situs web yang dilindungi?

CapSolver secara otomatis menyelesaikan reCAPTCHA, Geetest, Turnstile, dan tantangan anti-bot lainnya dengan akurasi tinggi. API ini berjalan mulus dengan kerangka kerja pengambilan data dan mengurangi tingkat kegagalan yang disebabkan oleh dinding verifikasi. Hal ini menghasilkan penggalian data yang lebih lancar, lebih sedikit gangguan, dan efisiensi otomasi yang lebih baik.

6. Bagaimana cara mengurangi kemungkinan otomasi saya terdeteksi sebagai bot?

Gunakan sidik jari browser yang realistis, ubah proksi berkualitas tinggi, simulasi jeda alami, muat aset secara normal, dan hindari membanjiri endpoint dengan permintaan cepat. Menggabungkan langkah-langkah ini dengan penyelesaian CAPTCHA membantu scraper Anda terlihat lebih seperti sesi pengguna manusia.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Cara menyelesaikan Captcha di Nanobot dengan CapSolver

Mengotomasi penyelesaian CAPTCHA dengan Nanobot dan CapSolver. Gunakan Playwright untuk menyelesaikan reCAPTCHA dan Cloudflare secara otomatis.

Anh Tuan

26-Feb-2026

Data sebagai Layanan (DaaS): Apa Itu dan Mengapa Penting pada 2026

Pahami Data sebagai Layanan (DaaS) pada 2026. Eksplor manfaatnya, kasus penggunaan, dan bagaimana DaaS mengubah bisnis dengan wawasan real-time dan skalabilitas.

Anh Tuan

12-Feb-2026

Cara Menyelesaikan Captcha di RoxyBrowser dengan Integrasi CapSolver

Mengintegrasikan CapSolver dengan RoxyBrowser untuk mengotomatisasi tugas browser dan menghindari reCAPTCHA, Turnstile, dan CAPTCHA lainnya.

Ethan Collins

04-Feb-2026

Cara Menyelesaikan Captcha di EasySpider dengan Integrasi CapSolver

EasySpider adalah alat pengambilan data web dan otomatisasi browser visual, tanpa kode, dan ketika dikombinasikan dengan CapSolver, dapat menyelesaikan CAPTCHA seperti reCAPTCHA v2 dan Cloudflare Turnstile secara andal, memungkinkan pengambilan data otomatis yang mulus di berbagai situs web.

Emma Foster

04-Feb-2026

Cara menyelesaikan reCAPTCHA v2 di Relevance AI dengan Integrasi CapSolver

Kembangkan alat Relevance AI untuk menyelesaikan reCAPTCHA v2 menggunakan CapSolver. Otomatisasi pengajuan formulir melalui API tanpa otomatisasi browser.

Ethan Collins

03-Feb-2026

Larangan IP pada 2026: Bagaimana Cara Kerjanya dan Cara Praktis untuk Mengelaknya

Pelajari cara menghindari pembatasan IP pada 2026 dengan panduan lengkap kami. Temukan teknik pemblokiran IP modern dan solusi praktis seperti proxy residensial dan solver CAPTCHA.

Emma Foster

26-Jan-2026