Cara Mengatasi Perlindungan Cloudflare Saat Web Scraping

Rajinder Singh

Deep Learning Researcher

05-Feb-2026

TL;Dr

- Cloudflare menggunakan tumpukan keamanan yang canggih, termasuk analisis perilaku dan tantangan otomatis, untuk memverifikasi lalu lintas web yang sah.

- Alat pengumpulan data standar sering mengalami gangguan karena tidak memberikan sinyal yang diperlukan oleh filter keamanan modern.

- Pendekatan profesional melibatkan penggunaan proksi perumahan berkualitas tinggi, manajemen header yang tepat, dan alat otomatis khusus.

- CapSolver menawarkan solusi berbasis API yang disederhanakan untuk menangani Cloudflare Turnstile dan halaman tantangan secara efisien dalam alur kerja yang sesuai aturan.

Pendahuluan

Pengumpulan data web modern telah menjadi semakin kompleks seiring dengan penerapan langkah keamanan canggih oleh situs web untuk melindungi aset digital mereka. Di antaranya, Cloudflare adalah yang paling umum digunakan, memberikan perlindungan yang kuat bagi jutaan domain melalui sistem manajemen bot cerdasnya. Bagi pengembang dan profesional data, pertanyaan tentang cara mengatasi Cloudflare adalah hambatan teknis umum saat membangun pipeline data yang andal dan sesuai aturan. Artikel ini memberikan panduan komprehensif tentang cara mengatasi perlindungan Cloudflare saat scraping web dengan pendekatan profesional dan etis. Kami akan mengeksplorasi mekanisme teknis di balik lapisan keamanan ini dan menawarkan strategi praktis untuk memastikan pengumpulan data Anda tetap tidak terganggu dan efisien. Dengan mengikuti panduan ini, Anda akan belajar bagaimana membangun sistem yang tangguh yang dapat menavigasi keamanan web modern dengan mudah.

Memahami Kerangka Keamanan Cloudflare

Cloudflare menggunakan pendekatan berlapis untuk mengevaluasi dan memverifikasi lalu lintas web yang masuk. Memahami komponen-komponen ini penting bagi siapa pun yang ingin mengatasi perlindungan Cloudflare secara efektif dalam lingkungan profesional.

1. Verifikasi Permintaan

Cloudflare menganalisis karakteristik teknis setiap koneksi untuk memastikan berasal dari lingkungan browser yang standar. Ini termasuk memeriksa konsistensi header HTTP dan protokol koneksi di bawahnya untuk memverifikasi bahwa klien dikonfigurasi dengan benar untuk situs target.

2. Analisis Perilaku

Lapisan ini memantau pola interaksi untuk membedakan antara aktivitas pengguna biasa dan proses otomatis. Faktor seperti kecepatan navigasi, frekuensi permintaan, dan konsistensi interaksi dianalisis untuk memastikan lalu lintas sesuai dengan perilaku manusia yang diharapkan di platform.

3. Tantangan Verifikasi Otomatis

Ketika permintaan memerlukan verifikasi tambahan, Cloudflare mengeluarkan tantangan otomatis, seperti Turnstile. Tantangan ini dirancang agar tidak mengganggu pengguna sah, namun memastikan hanya klien yang diverifikasi yang dapat mengakses konten yang dilindungi. Menangani tantangan ini secara efisien adalah kunci untuk mempertahankan tingkat keberhasilan yang tinggi dalam proyek pengumpulan data.

Ringkasan Perbandingan: Metode Pengumpulan Data

Tabel berikut membandingkan berbagai metode untuk menangani perlindungan Cloudflare selama ekstraksi data web profesional.

| Metode | Kompleksitas | Tingkat Keberhasilan | Biaya | Skalabilitas |

|---|---|---|---|---|

| Klien HTTP Dasar | Rendah | Sangat Rendah | Gratis | Tinggi |

| Otomatisasi Standar | Sedang | Sedang | Sedang | Rendah |

| Kerangka Lanjutan | Sedang | Tinggi | Sedang | Sedang |

| CapSolver API | Rendah | Sangat Baik | Bayar per penggunaan | Sangat Tinggi |

Strategi Profesional untuk Mengatasi Tantangan Cloudflare

Untuk memastikan ekstraksi data yang sukses dalam skenario yang sesuai aturan, diperlukan pengadopsian teknik standar industri yang menekankan keandalan dan akurasi.

Mengoptimalkan Header dan Profil Pengguna

Langkah penting dalam pengumpulan data profesional adalah pengelolaan header HTTP yang tepat. Penting untuk menggunakan User-Agent terbaik yang secara akurat mencerminkan profil browser modern. Anda juga dapat mengganti User-Agent untuk mengatasi verifikasi Cloudflare dengan memastikan profil klien Anda konsisten dengan pola lalu lintas yang diharapkan. Untuk standar teknis yang lebih rinci, merujuk pada Spesifikasi Header HTTP W3C dan MDN Web Docs: User-Agent.

Menggunakan Proksi Perumahan Berkualitas Tinggi

Cloudflare mengevaluasi reputasi alamat IP yang mengakses jaringannya. Menggunakan kumpulan proksi perumahan berkualitas tinggi adalah praktik standar untuk pengumpulan data skala besar yang sesuai aturan. Alamat IP perumahan terkait dengan penyedia layanan nyata, yang membantu menjaga skor kepercayaan yang tinggi dan memastikan permintaan Anda dianggap sebagai lalu lintas sah.

Memastikan Konsistensi Lingkungan

Memelihara lingkungan browser yang konsisten sangat penting untuk melewati pemeriksaan otomatis. Ini melibatkan memastikan alat otomatisasi Anda secara benar mendukung API Canvas dan standar web modern lainnya. Dengan menggunakan kerangka otomatisasi kelas profesional, Anda dapat memastikan lingkungan klien Anda memberikan sinyal yang diperlukan untuk diverifikasi sebagai pengunjung sah.

Verifikasi Efisien dengan CapSolver

Dalam skenario di mana otomatisasi standar menghadapi tantangan, solusi khusus seperti CapSolver menawarkan cara yang andal dan efisien untuk menangani verifikasi. CapSolver dirancang khusus untuk mengelola Cloudflare Turnstile dan halaman tantangan 5 detik dalam alur kerja bisnis yang sah.

Gunakan kode

CAP26saat mendaftar di CapSolver untuk mendapatkan kredit tambahan!

Keunggulan CapSolver

CapSolver menyediakan platform berbasis AI yang mengotomatisasi proses verifikasi secara real-time. Ini sangat bermanfaat ketika Anda perlu menyelesaikan Cloudflare Turnstile dan tantangan 5 detik tanpa mengganggu jadwal pengumpulan data Anda. Dengan mengintegrasikan CapSolver, Anda dapat memastikan proyek Anda tetap stabil dan efisien, bahkan seiring berkembangnya protokol keamanan web.

Integrasi yang Mudah untuk Pengembang

CapSolver menawarkan API yang mudah digunakan untuk berbagai bahasa pemrograman, termasuk Python, PHP, dan Node.js. Misalnya, jika Anda menyelesaikan Cloudflare dengan Selenium, CapSolver dapat memberikan token verifikasi yang diperlukan untuk menyelesaikan proses secara mulus. Secara serupa, bagi tim yang mengambil data dari situs yang dilindungi Cloudflare menggunakan PHP, proses integrasi dirancang agar sederhana dan sangat andal.

Skalabilitas dan Praktik Terbaik dalam Pengumpulan Data

Mengembangkan proyek pengumpulan data memerlukan fokus pada stabilitas dan penghormatan terhadap infrastruktur situs target.

- Pembatasan Tingkat yang Bertanggung Jawab: Terapkan jeda yang sesuai antara permintaan untuk memastikan aktivitas Anda tetap dalam batas wajar dan meniru perilaku penjelajahan alami.

- Manajemen Kesalahan Proaktif: Kembangkan logika penanganan kesalahan yang kuat untuk mencatat dan menganalisis setiap hambatan verifikasi, memungkinkan Anda menyempurnakan strategi Anda seiring waktu.

- Pengelolaan Sesi yang Efisien: Gunakan kembali token sesi dan cookie di mana sesuai. Memelihara sesi yang valid dapat secara signifikan mengurangi frekuensi tantangan verifikasi.

- Pemantauan Kinerja: Gunakan alat pemantauan komprehensif untuk melacak tingkat keberhasilan dan memastikan node pengumpulan data Anda berjalan optimal.

Untuk pemahaman yang lebih dalam tentang cara sistem keamanan ini beroperasi, Anda dapat menjelajahi dokumentasi resmi di Manajemen Bot Cloudflare.

Evolusi Verifikasi Web di Tahun 2026

Seiring perkembangan tahun 2026, lingkungan keamanan web terus beralih ke metode verifikasi yang lebih cerdas dan kurang mengganggu. Tujuan penyedia keamanan modern adalah memastikan pengalaman yang mulus bagi pengguna nyata sambil mempertahankan standar tinggi untuk perlindungan data. Bagi profesional di bidang ekstraksi data, ini berarti strategi yang digunakan tahun-tahun sebelumnya harus disempurnakan. Fokus telah bergeser dari teknik "melewati" sederhana menuju strategi "verifikasi" yang lebih canggih. Dengan menyelaraskan alat pengumpulan data Anda dengan standar teknis yang diharapkan oleh browser web modern, Anda dapat mencapai aliran data yang lebih stabil dan andal.

Mengapa Verifikasi adalah Standar Baru

Dulu, banyak alat fokus pada menyembunyikan sifat otomatisnya. Kini, pendekatan yang paling sukses adalah menjadi klien yang dapat diverifikasi. Ini melibatkan tidak hanya memiliki header yang benar, tetapi juga memastikan koneksi Anda mengikuti pola negosiasi yang sama seperti browser standar. Ketika Anda menyelesaikan perlindungan Cloudflare menggunakan metode profesional, Anda pada dasarnya memberikan server tujuan semua bukti yang diperlukan bahwa permintaan Anda sah dan aman untuk dipenuhi. Perubahan perspektif ini sangat penting untuk membangun operasi penggalian data jangka panjang yang berkelanjutan yang dapat bertahan terhadap pembaruan frekuensi protokol keamanan web.

Integrasi Strategis CapSolver dalam Alur Kerja Perusahaan

Untuk pengumpulan data tingkat perusahaan, keandalan dan kecepatan adalah hal yang sangat penting. Mengintegrasikan solusi profesional seperti CapSolver ke dalam pipeline CI/CD Anda memastikan pengumpulan data tetap tidak terganggu. Ini terutama penting bagi bisnis yang bergantung pada data real-time untuk analisis pasar, pemantauan harga, atau penelitian akademik. Dengan mengotomatisasi proses verifikasi, Anda menghilangkan titik kegagalan signifikan dalam pipeline data Anda.

Mencapai Efisiensi Biaya pada Skala Besar

Meskipun ada biaya terkait penggunaan solver profesional, return on investment jelas terlihat ketika mempertimbangkan waktu dan sumber daya yang disimpan. Mengelola dan memperbarui skrip verifikasi kustom secara manual adalah proses yang melelahkan yang sering menghasilkan hasil yang tidak konsisten. Dengan memanfaatkan API CapSolver, tim pengembangan Anda dapat fokus pada nilai inti proyek Anda—menganalisis data—daripada menghabiskan jam-jam berjam-jam untuk pemeliharaan teknis. Ini menghasilkan jadwal proyek yang lebih prediktif dan kualitas data yang lebih tinggi secara keseluruhan.

Pertimbangan Etis dan Kepatuhan dalam Penggalian Data

Penggalian data profesional dibangun di atas fondasi etika dan kepatuhan. Sangat penting untuk memahami bahwa langkah keamanan seperti Cloudflare bertujuan untuk melindungi integritas web. Ketika Anda menyelesaikan perlindungan Cloudflare, Anda harus selalu melakukannya dalam batas kasus penggunaan yang sah. Ini termasuk menghormati batas tingkat situs target, menghindari pengumpulan informasi pribadi sensitif tanpa izin, dan memastikan aktivitas Anda tidak merugikan kinerja situs bagi pengguna lain.

Membangun Kepercayaan dengan Platform Tujuan

Dengan mengadopsi pendekatan profesional dan transparan dalam pengumpulan data, Anda dapat membangun hubungan yang lebih baik dengan platform yang Anda interaksi. Ini termasuk menggunakan User-Agent yang dapat diidentifikasi di mana sesuai dan mengikuti panduan yang ditetapkan dalam file robots.txt situs tersebut. Ketika aktivitas pengumpulan data Anda dianggap sah dan hormat, kemungkinannya lebih kecil untuk dianggap sebagai ancaman keamanan, menghasilkan lingkungan yang lebih stabil untuk penelitian dan operasi bisnis Anda.

Keunggulan Teknis dalam Manajemen Header

Manajemen header yang tepat lebih dari sekadar menyetel string User-Agent. Ini melibatkan memahami hubungan kompleks antara berbagai header HTTP dan bagaimana mereka diinterpretasikan oleh filter keamanan. Misalnya, header Accept-Language, Accept-Encoding, dan Sec-Fetch-* harus konsisten dengan User-Agent yang Anda tampilkan. Setiap ketidaksesuaian dapat menjadi sinyal bahwa permintaan tidak berasal dari browser standar.

Pentingnya Konsistensi

Konsistensi adalah inti dari verifikasi web yang sukses. Jika User-Agent Anda mengklaim Anda menggunakan versi terbaru Chrome di Windows, tetapi protokol koneksi Anda menunjukkan versi lama Linux, permintaan ini kemungkinan besar akan ditandai untuk verifikasi tambahan. Alat dan layanan profesional membantu memastikan setiap lapisan permintaan Anda—dari koneksi TCP hingga lapisan aplikasi—sepenuhnya sinkron. Tingkat keunggulan teknis ini adalah yang membedakan pengumpulan data profesional dari skrip otomatis dasar.

Mempersiapkan Masa Depan Pipeline Data Anda

Satu-satunya hal yang tetap dalam keamanan web adalah perubahan. Seiring AI dan pembelajaran mesin semakin terintegrasi ke dalam kerangka keamanan, tantangan untuk pengumpulan data akan terus berkembang. Untuk mempersiapkan masa depan pipeline data Anda, Anda harus memilih alat dan mitra yang berkomitmen pada inovasi berkelanjutan. Dedikasi CapSolver untuk tetap di depan tren keamanan terbaru membuatnya menjadi mitra yang ideal bagi bisnis yang membutuhkan akses data yang andal sekarang dan di masa depan. Dengan tetap memperbarui diri tentang perkembangan terbaru dalam verifikasi web dan mengadopsi strategi yang fleksibel dan profesional, Anda dapat memastikan proyek pengumpulan data Anda tetap sukses selama bertahun-tahun.

Kesimpulan

Mengatasi perlindungan Cloudflare pada tahun 2026 adalah tentang menggunakan alat yang tepat dan mempertahankan pendekatan profesional serta sesuai aturan. Dengan menggabungkan manajemen header yang tepat, proksi perumahan berkualitas tinggi, dan kemampuan verifikasi lanjutan dari CapSolver, Anda dapat membangun sistem pengumpulan data yang sangat efektif. Kunci keberhasilan jangka panjang adalah memastikan aktivitas Anda diverifikasi sebagai sah dan menghormati ekosistem web. Fokuslah pada membangun pipeline data yang berkelanjutan yang memanfaatkan solusi profesional untuk mempertahankan efisiensi dan keandalan dalam semua proyek scraping web Anda.

FAQ

1. Mengapa scraper saya menghadapi tantangan meskipun User-Agent sudah benar?

Sistem verifikasi melihat berbagai sinyal di luar User-Agent, termasuk protokol koneksi dan pola perilaku. Jika sinyal-sinyal ini tidak sejalan dengan lingkungan browser standar, permintaan mungkin akan ditantang.

2. Apakah mungkin menangani Cloudflare Turnstile secara otomatis?

Ya, layanan profesional seperti CapSolver menyediakan solusi otomatis untuk Turnstile, memungkinkan Anda menangani verifikasi ini secara efisien dalam skrip pengumpulan data Anda.

3. Bagaimana cara memastikan web scraping saya sesuai?

Selalu tinjau ketentuan layanan dan file robots.txt dari situs web yang dituju. Pastikan Anda mengumpulkan data untuk tujuan yang sah dan mematuhi semua regulasi privasi data yang berlaku seperti GDPR.

4. Apa keuntungan menggunakan proxy rumah dibandingkan datacenter?

Proxy rumah memiliki tingkat kepercayaan yang lebih tinggi karena terkait dengan pengguna internet rumah tangga nyata, sehingga lebih sedikit kemungkinannya terdeteksi oleh filter keamanan dibandingkan IP datacenter.

5. Apakah CapSolver mendukung tantangan 5 detik terbaru?

Ya, CapSolver terus diperbarui untuk mendukung versi terbaru dari tantangan verifikasi Cloudflare, memastikan kinerja yang konsisten untuk proyek otomasi Anda.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Berita AI Agens: Mengapa Otomatisasi Web Terus Gagal pada CAPTCHA

Temukan mengapa agen AI mengalami kesulitan dengan otomatisasi web dan CAPTCHA. Pelajari cara menjembatani kesenjangan antara penalaran AI dan eksekusi dengan solusi CapSolver.

Lucas Mitchell

05-Feb-2026

Cara Mengatasi Perlindungan Cloudflare Saat Web Scraping

Pelajari cara mengatasi perlindungan Cloudflare saat web scraping. Temukan metode yang terbukti seperti rotasi IP, TLS fingerprinting, dan CapSolver untuk mengatasi tantangan.

Rajinder Singh

05-Feb-2026

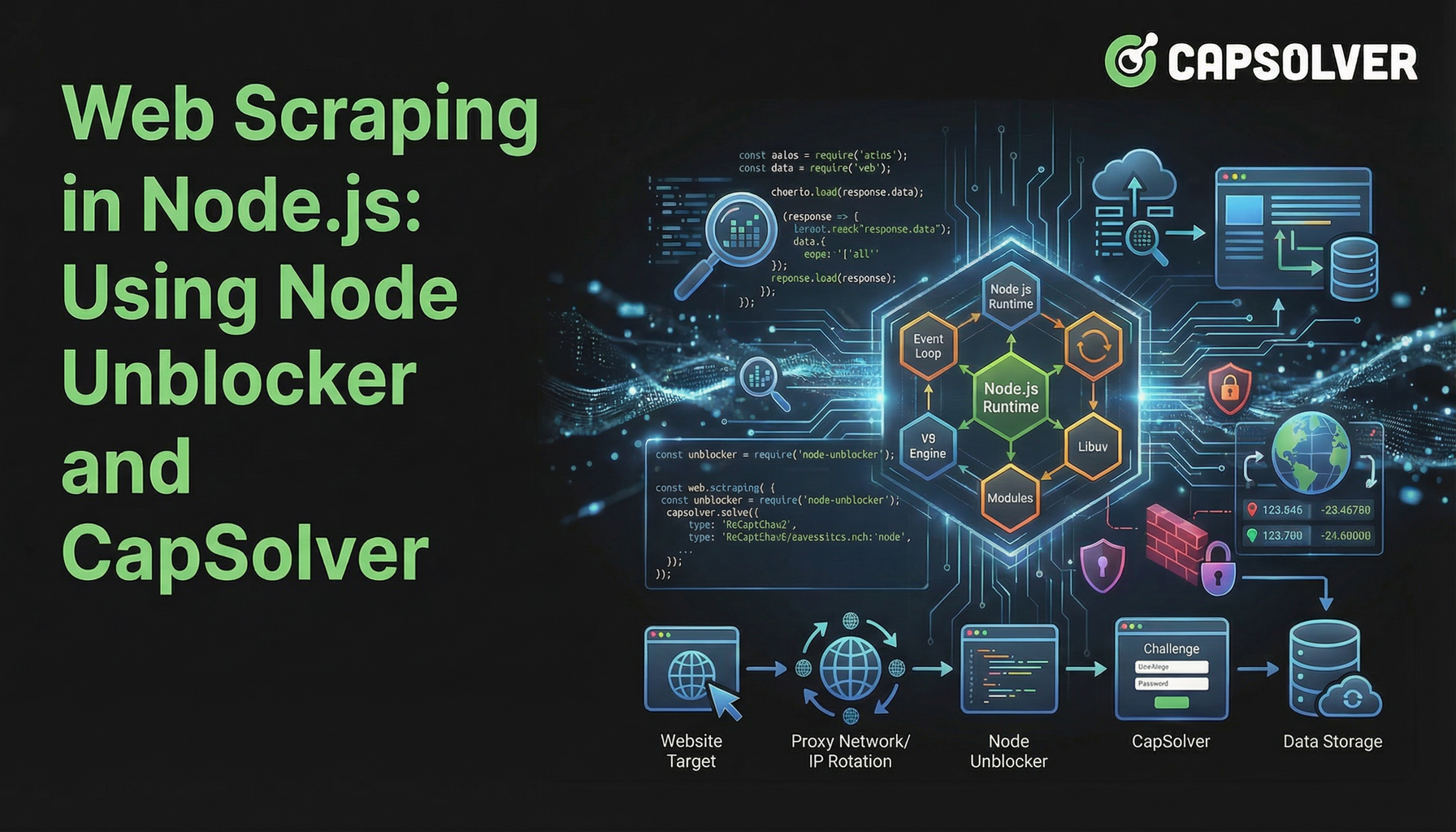

Penyedotan Web di Node.js: Menggunakan Node Unblocker dan CapSolver

Menguasai pengambilan data web di Node.js menggunakan Node Unblocker untuk menghindari pembatasan dan CapSolver untuk menyelesaikan CAPTCHAs. Panduan ini menyediakan strategi lanjutan untuk ekstraksi data yang efisien dan andal.

Rajinder Singh

04-Feb-2026

Crawl4AI vs Firecrawl: Perbandingan Komprehensif & Ulasan 2026

Bandingkan Crawl4AI vs Firecrawl pada 2026. Temukan fitur, harga, dan kinerja alat pengambilan data web AI ini untuk ekstraksi markdown yang siap untuk LLM.

Sora Fujimoto

04-Feb-2026

Penggunaan Browser vs Browserbase: Manakah Alat Otomatisasi Browser yang Lebih Baik untuk Agen AI?

Bandingkan Penggunaan Browser dengan Browserbase untuk otomatisasi agen AI. Jelajahi fitur, harga, dan cara menyelesaikan CAPTCHA dengan CapSolver untuk alur kerja yang mulus.

Anh Tuan

26-Jan-2026

Top 9 Kerangka Agen Kecerdasan Buatan pada 2026

Jelajahi 9 kerangka kerja agen AI teratas untuk 2026, termasuk CrewAI, AutoGen, dan LangGraph. Pelajari cara memilih kerangka kerja terbaik untuk pengaturan agen multi dan pengembangan agen otonom, serta temukan alat penting untuk interaksi web dunia nyata.

Emma Foster

26-Jan-2026