वेब क्रॉलिंग विरुद्ध वेब स्क्रैपिंग: महत्वपूर्ण अंतर

Rajinder Singh

Deep Learning Researcher

09-Dec-2025

TL;DR: वेब क्रॉलिंग लिंक का अनुसरण करके वेब पृष्ठों की खोज और इंडेक्सिंग करने की प्रक्रिया है, जो मुख्य रूप से खोज इंजन और साइट ऑडिट के लिए उपयोग की जाती है। वेब स्क्रैपिंग वेब पृष्ठों से विशिष्ट डेटा के लक्षित निष्कर्षण की प्रक्रिया है, जो बाजार अनुसंधान और डेटा विश्लेषण के लिए महत्वपूर्ण है। दोनों प्रक्रियाएं, विशेष रूप से वेब स्क्रैपिंग, आवेदक नियंत्रणों जैसे AWS WAF द्वारा अक्सर बाधित की जाती हैं। इन चुनौतियों को विशेषज्ञ समाधान के साथ अच्छी तरह से सुलझाया जा सकता है जैसे कि CapSolver।

परिचय

डिजिटल दुनिया डेटा पर बनी हुई है, और वेब क्रॉलिंग और वेब स्क्रैपिंग इस विशाल जानकारी के एकत्रीकरण के लिए मूल तकनीक हैं। जबकि इन्हें अक्सर एक दूसरे के साथ बराबर उपयोग किया जाता है, ये डेटा अधिग्रहण पाइपलाइन में दो अलग-अलग, लेकिन पूरक चरण हैं। डेटा-आधारित एप्लिकेशन बनाने वाले, बाजार अनुसंधान करने वाले या खोज इंजन के लिए अनुकूलित करने वाले के लिए वेब क्रॉलिंग और वेब स्क्रैपिंग के बीच अंतर की समझ आवश्यक है।

इस विस्तृत गाइड का उद्देश्य डेटा विशेषज्ञ, SEO विशेषज्ञ और विकासकर्ता के लिए है। हम दोनों प्रक्रियाओं की स्पष्ट परिभाषा करेंगे, उनके मुख्य अंतरों को उजागर करेंगे, 10 विस्तृत समाधानों का अध्ययन करेंगे जहां इनका उपयोग किया जाता है, और दिखाएंगे कि CapSolver जैसे उपकरण दक्षता में सुधार और सामान्य एक्सेस चुनौतियों के समाधान में कैसे मदद कर सकते हैं। अंत तक, आपके पास दक्ष और सुसंगत वेब डेटा रणनीति के लागू करने के लिए एक मजबूत ढांचा होगा।

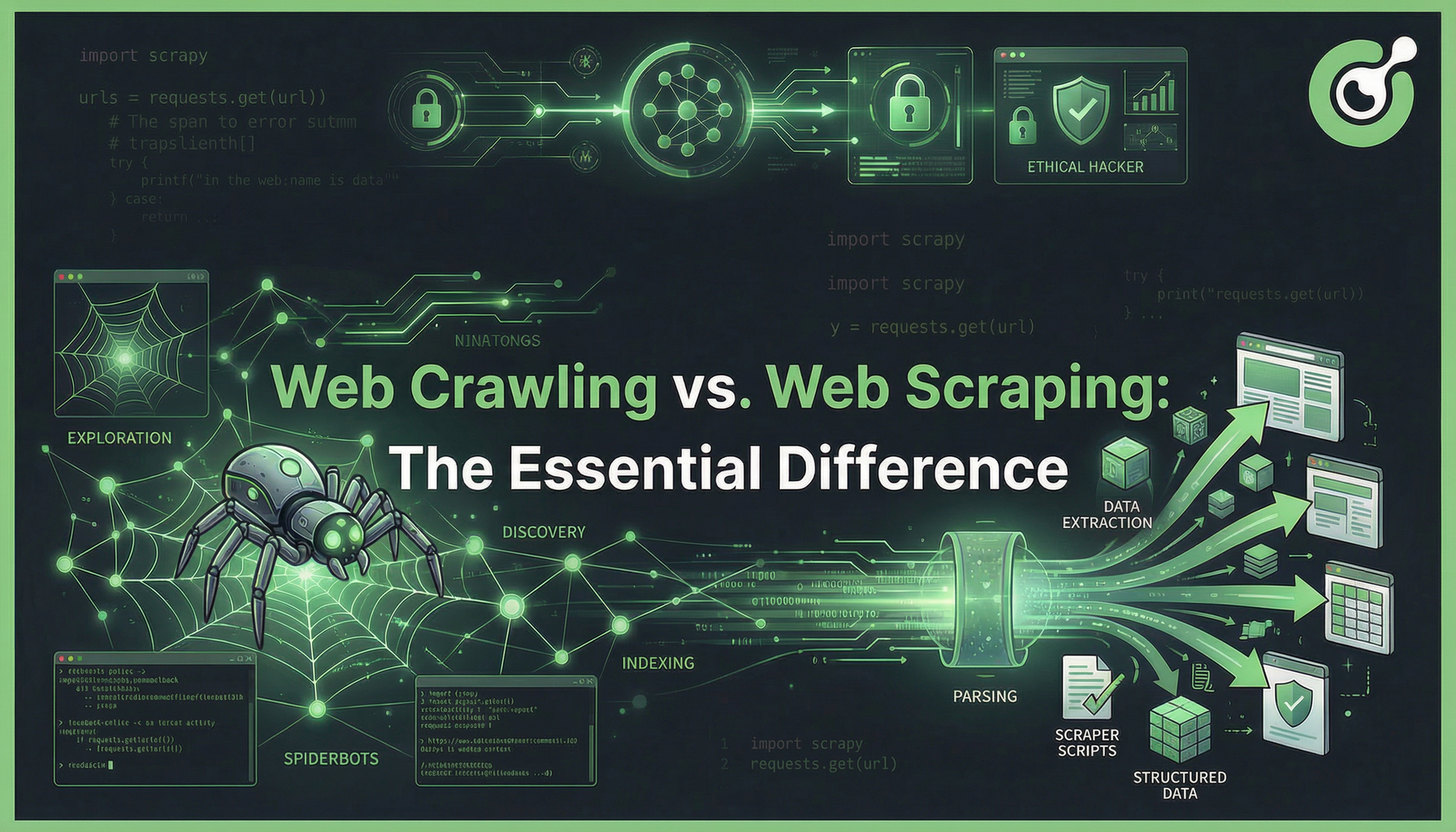

वेब क्रॉलिंग और वेब स्क्रैपिंग: मूल अंतर

वेब क्रॉलिंग और वेब स्क्रैपिंग के बीच अंतर उनके मुख्य उद्देश्य में है। वेब क्रॉलिंग खोज और मानचित्रण के बारे में है, जबकि वेब स्क्रैपिंग निष्कर्षण और संरचना के बारे में है।

एक वेब क्रॉलर, जैसे कि Googlebot, वर्ल्ड वाइड वेब के सिस्टमेटिक रूप से ब्राउज़ करता है, एक पृष्ठ से दूसरे पृष्ठ तक हाइपरलिंक का अनुसरण करता है। इसका उद्देश्य इंटरनेट के एक व्यापक सूची के निर्माण करना है। एक वेब स्क्रैपर, दूसरी ओर, ज्ञात यूआरएल के सेट से विशिष्ट डेटा बिंदुओं का लक्ष्य बनाता है—जैसे कि उत्पाद की कीमत, संपर्क जानकारी, या लेख की लेखन जानकारी—जो असंरचित HTML को साफ उपयोग करने योग्य डेटा फॉर्मैट जैसे कि CSV या JSON में बदल देता है।

तुलना सारांश: क्रॉलिंग और स्क्रैपिंग

| विशेषता | वेब क्रॉलिंग | वेब स्क्रैपिंग |

|---|---|---|

| मुख्य लक्ष्य | खोज, इंडेक्सिंग, साइट संरचना मानचित्रण | डेटा निष्कर्षण, संरचना, विश्लेषण |

| आउटपुट | यूआरएल की सूची, साइट मैप, या पृष्ठों का सूचीकरण | संरचित डेटा (JSON, CSV, डेटाबेस रिकॉर्ड) |

| सीमा | साइट-स्तर या वेब-स्तर (सभी लिंक का अनुसरण करते हुए) | पृष्ठ-स्तर (विशिष्ट तत्वों का लक्ष्य) |

| अनुमान | एक लाइब्रेरियन जो लाइब्रेरी में सभी किताबों को वर्गीकृत करता है | एक अनुसंधानकर्ता जो किसी किताब से एक विशिष्ट उद्धरण निकालता है |

| मुख्य उपकरण | Scrapy, Apache Nutch, Googlebot | BeautifulSoup, Puppeteer, Selenium, कस्टम स्क्रिप्ट |

| सामान्य उपयोग केस | खोज इंजन अनुकूलन (SEO), साइट ऑडिट | मूल्य निगरानी, बीमा जनरेशन, बाजार अनुसंधान |

वेब क्रॉलिंग: खोज की इंजन

वेब क्रॉलिंग वर्ल्ड वाइड वेब के सिस्टमेटिक रूप से ब्राउज़ करने की स्वचालित प्रक्रिया है। यह खोज इंजन के लिए नए और अपडेट किए गए सामग्री की खोज करने के लिए आधारभूत चरण है।

उद्देश्य और यांत्रिकी

वेब क्रॉलिंग का मुख्य उद्देश्य इंटरनेट या विशिष्ट वेबसाइट के मानचित्रण करना है। एक क्रॉलर बीज सूची के यूआरएल से शुरू होता है, उन पृष्ठों की सामग्री को लोड करता है, और फिर एचटीएमएल को पार्स करता है ताकि नए हाइपरलिंक ढूंढे जा सकें। यह प्रक्रिया बार-बार दोहराई जाती है, जिससे इसकी पहुंच बढ़ जाती है। इस प्रक्रिया को robots.txt फ़ाइल में परिभाषित नियमों द्वारा नियंत्रित किया जाता है, जो निर्धारित करता है कि वेबसाइट के कौन से हिस्से क्रॉलर द्वारा एक्सेस किए जा सकते हैं।

SEO विशेषज्ञों के लिए क्रॉलिंग आवश्यक है। एक सफल क्रॉल का मतलब है कि एक पृष्ठ इंडेक्स किया जा सकता है और रैंक किया जा सकता है। एक SEO महत्व के अध्ययन के अनुसार, सफल क्रॉलिंग कार्बोनिक दृश्यता के लिए आवश्यक पहला कदम है। ClickGuard नोट करता है कि यदि एक पृष्ठ क्रॉल नहीं किया जाता है, तो इसे रैंक नहीं किया जा सकता है।

वेब क्रॉलिंग के लिए मुख्य उपकरण

- Scrapy: पायथन में एक तेज़, उच्च स्तर की वेब क्रॉलिंग और वेब स्क्रैपिंग फ्रेमवर्क। यह बड़े पैमाने पर, जटिल क्रॉलिंग परियोजनाओं के लिए उपयुक्त है।

- Apache Nutch: एक ओपन-सोर्स वेब क्रॉलर जो बड़े पैमाने पर खोज इंजन बनाने के लिए उपयोग किया जा सकता है।

- कस्टम क्रॉलर: पायथन में

requestsऔरBeautifulSoupजैसी पुस्तकालयों के साथ बनाए गए, आमतौर पर छोटे, अत्यधिक अनुकूलित कार्यों के लिए।

वेब स्क्रैपिंग: डेटा निष्कर्षण की कला

वेब स्क्रैपिंग वेबसाइटों से विशिष्ट डेटा निकालने की तकनीक है। यह एक अधिक लक्षित प्रक्रिया है जो एक पृष्ठ के क्रॉलर द्वारा खोजे जाने के बाद या जब यूआरएल पहले से ज्ञात होता है, तब होती है।

उद्देश्य और यांत्रिकी

वेब स्क्रैपिंग का उद्देश्य वेब पृष्ठ पर मानव-पठनीय, असंरचित डेटा को मशीन-पठनीय, संरचित रूप में बदलना है। इसमें विशिष्ट डेटा तत्वों की पहचान करने के लिए सेलेक्टर (जैसे कि CSS सेलेक्टर या XPath) का उपयोग किया जाता है—जैसे कि एक उत्पाद का नाम, एक मूल्य, या एक समीक्षा अंक—और फिर उस डेटा को निकालने और साफ करने की आवश्यकता होती है।

वेब स्क्रैपिंग के बाजार में महत्वपूर्ण वृद्धि हो रही है। वैश्विक वेब स्क्रैपिंग बाजार 2030 तक 2 बिलियन अमेरिकी डॉलर तक पहुंच जाएगा, वित्त, ई-कॉमर्स और बाजार बुद्धिमानी में विकल्प डेटा स्रोतों की बढ़ती मांग के कारण। Mordor Intelligence इस तेज विस्तार को चिह्नित करता है।

वेब स्क्रैपिंग के लिए मुख्य उपकरण

- BeautifulSoup: पायथन में HTML और XML दस्तावेज़ों के विश्लेषण के लिए एक पुस्तकालय, आमतौर पर

requestsपुस्तकालय के साथ उपयोग किया जाता है। - Selenium/Puppeteer: डायनामिक सामग्री (जावास्क्रिप्ट-रेंडर किए गए पृष्ठ) के लिए ब्राउज़र स्वचालन उपकरण, जो वास्तविक उपयोगकर्ता के अंतरक्रिया के समान बनाते हैं।

- विशेषज्ञ स्क्रैपिंग एपीएस: उपयोगकर्ता के लिए बुनियादी ढांचा, प्रॉक्सी घूमना और एंटी-बॉट बचाव का निपटारा करते हैं।

10 विस्तृत समाधान और उपयोग के मामले क्रॉलिंग और स्क्रैपिंग के लिए

वेब क्रॉलिंग और वेब स्क्रैपिंग के साथ निपटान करना शक्तिशाली, डेटा-आधारित समाधान बनाने के लिए आवश्यक है। यहां 10 विस्तृत अनुप्रयोग हैं, जो खोज और निष्कर्षण के बीच संगति को दर्शाते हैं।

1. व्यापक SEO साइट ऑडिट (क्रॉलिंग)

लक्ष्य: खोज इंजन इंडेक्सिंग के लिए अड़चन बनाने वाले टूटे लिंक, रीडायरेक्ट श्रृंखला और साइट संरचना समस्याओं की पहचान करें।

प्रक्रिया: एक क्रॉलर लॉगिन पृष्ठ से शुरू होता है और सभी आंतरिक लिंक का अनुसरण करता है। यह प्रत्येक यूआरएल के लिए स्थिति कोड (200, 404, 301), पृष्ठ शीर्षक और गहराई को रिकॉर्ड करता है।

मूल्य: खोज इंजन क्रॉलर द्वारा सभी महत्वपूर्ण पृष्ठों की खोज करने सुनिश्चित करता है, जो अच्छे SEO के लिए आवश्यक है।

2. वास्तविक समय ई-कॉमर्स मूल्य निगरानी (स्क्रैपिंग)

लक्ष्य: हजारों उत्पादों के प्रतिस्पर्धी मूल्यों की निगरानी करना ताकि डायनामिक मूल्य नीति को समायोजित किया जा सके।

प्रक्रिया: एक स्क्रैपर को ज्ञात उत्पाद यूआरएल की सूची दी जाती है। यह विशिष्ट HTML तत्व का लक्ष्य बनाता है जो मूल्य को रखता है और उस संख्यात्मक मान को निकालता है।

मूल्य: बाजार परिवर्तनों पर तत्काल प्रतिक्रिया की अनुमति देकर प्रतिस्पर्धी फायदा प्रदान करता है।

3. बीमा जनरेशन और संपर्क डेटा अधिग्रहण (स्क्रैपिंग)

लक्ष्य: व्यावसायिक निर्देशिकाओं या पेशेवर नेटवर्किंग साइटों से संपर्क विवरण (ईमेल, फोन नंबर) निकालें।

प्रक्रिया: एक क्रॉलर पहले संबंधित कंपनी प्रोफ़ाइल पृष्ठों की खोज करता है। फिर स्क्रैपर उन पृष्ठों से ईमेल पते और फोन नंबर के संबंधित टेक्स्ट पैटर्न निकालता है।

मूल्य: बिक्री और बाजार के पाइपलाइन में ताजा, लक्षित संपर्क जानकारी के साथ ईंधन प्रदान करता है।

4. खोज इंजन इंडेक्सिंग और रैंकिंग (क्रॉलिंग)

लक्ष्य: गूगल और बिंग जैसे प्रमुख खोज इंजन के मूल कार्य है।

प्रक्रिया: बड़े, वितरित क्रॉलर नए सामग्री की लगातार खोज करते हैं। खोजे गए पृष्ठों को एक इंडेक्सर के पास भेजा जाता है, जो टेक्स्ट को प्रसंस्करण करता है और तेजी से पुनर्प्राप्ति के लिए एक बड़े डेटाबेस में संग्रहीत करता है।

मूल्य: बिलियन उपयोगकर्ताओं के लिए इंटरनेट के विशालता को खोजनीय बनाता है।

5. सामग्री संग्रह और समाचार फीड (क्रॉलिंग और स्क्रैपिंग)

लक्ष्य: विभिन्न समाचार स्रोतों से लेखों को ले जाने वाला केंद्रीकृत प्लेटफॉर्म बनाएं।

प्रक्रिया: एक क्रॉलर लक्षित समाचार साइटों के साइटमैप और श्रेणी पृष्ठों की निगरानी करता है। जब एक नया लेख यूआरएल पाया जाता है, तो एक स्क्रैपर लेख के शीर्षक, शरीर के टेक्स्ट, लेखक और प्रकाशन तिथि को निकालता है।

मूल्य: व्यक्तिगत समाचार पाठक और सामग्री विश्लेषण प्लेटफॉर्म को चालू करता है।

6. बाजार अनुसंधान और भावना विश्लेषण (स्क्रैपिंग)

लक्ष्य: फोरम, सोशल मीडिया और ई-कॉमर्स साइटों से ग्राहक समीक्षाओं और टिप्पणियों के एकत्रीकरण के माध्यम से किसी उत्पाद पर सार्वजनिक राय का आकलन करें।

प्रक्रिया: स्क्रैपर उत्पाद पृष्ठों के समीक्षा अनुभाग का लक्ष्य बनाते हैं, टेक्स्ट और सितारा रेटिंग निकालते हैं। इस डेटा को एनएलपी मॉडल में भेजा जाता है ताकि भावना स्कोरिंग किया जा सके।

मूल्य: उपभोक्ता ध्वनि से उत्पाद के बल्कि और कमजोरियों के बारे में क्रियात्मक अंतर्दृष्टि प्रदान करता है।

7. वेबसाइट बदलाव निर्देशन (क्रॉलिंग और स्क्रैपिंग)

लक्ष्य: अनुमति बिना बदलाव, नियमावली अपडेट या स्टॉक उपलब्धता के लिए विशिष्ट पृष्ठों की निगरानी करें।

प्रक्रिया: एक क्रॉलर लक्षित यूआरएल के लिए एक योजना के अनुसार भ्रमण करता है। एक स्क्रैपर पृष्ठ के मुख्य सामग्री के हैश निकालता है। यदि हैश बदल जाता है, तो एक चेतावनी चालू हो जाती है।

मूल्य: पालन-प्राप्ति, प्रतिस्पर्धी जानकारी और स्टॉक ट्रैकिंग के लिए आवश्यक है।

8. विश्वविद्यालय अनुसंधान और उद्धरण मैपिंग (क्रॉलिंग)

लक्ष्य: एक अध्ययन क्षेत्र में उद्धरण नेटवर्क का मैप बनाएं।

प्रक्रिया: एक क्रॉलर एक महत्वपूर्ण पेपर से शुरू होता है और सभी संदर्भ और सभी पेपर जो इसके उल्लेख करते हैं निकालता है। इन लिंक का अनुसरण करके एक अकादमिक प्रभाव के ग्राफ का निर्माण करता है।

मूल्य: अपने क्षेत्र में महत्वपूर्ण लेखकों और उभरते प्रवृत्ति की पहचान में मदद करता है।

9. डेटा स्थानांतरण और आर्किविंग (स्क्रैपिंग)

लक्ष्य: एक पुराने वेबसाइट से सभी सामग्री के निकालने के लिए, या ऐतिहासिक उद्देश्य के लिए वेबसाइट के आर्किविंग।

प्रक्रिया: क्रॉलर पुराने वेबसाइट पर सभी यूआरएल की पहचान करता है। स्क्रैपर एक-एक करके प्रत्येक पृष्ठ की पूर्ण एचटीएमएल सामग्री निकालता है और इसे स्थानीय रूप से संग्रहीत करता है।

मूल्य: प्लेटफॉर्म संक्रमण के दौरान मूल्यवान डेटा और सामग्री को संरक्षित करता है।

10. मशीनी लर्निंग मॉडल के शिक्षण (स्क्रैपिंग)

लक्ष्य: चित्र पहचान या भाषा मॉडल जैसे AI मॉडल के शिक्षण के लिए बड़े विविध डेटा सेट के एकत्रीकरण।

प्रक्रिया: स्क्रैपर लाखों छवियों के साथ उनके कैप्शन के एकत्रीकरण के लिए डेप्लॉय किए जाते हैं, या विभिन्न स्रोतों से विशाल मात्रा में टेक्स्ट डेटा के एकत्रीकरण के लिए।

मूल्य: बेहतरीन AI प्रौद्योगिकी के विकास और अनुन्नति के लिए आवश्यक ईंधन प्रदान करता है।

चुनौती: आधुनिक एक्सेस नियंत्रण और AWS WAF

वेब डेटा के मूल्य बढ़ते रहने के साथ, वेबसाइट ने बढ़ते हुए सुरक्षा और ट्रैफिक फ़िल्टरिंग तकनीकों को अपनाया है। इनमें दर्जे सीमा, IP प्रतिष्ठा जांच और CAPTCHA सत्यापन शामिल हैं, जो आमतौर पर वेब एप्लिकेशन फ़ायरवॉल (WAF) जैसे AWS WAF के माध्यम से लागू किए जाते हैं। इन नियंत्रणों के तहत, बड़े पैमाने पर क्रॉलिंग और चयनात्मक डेटा निष्कर्षण असामान्य व्यवहार के रूप में चिह्नित किया जा सकता है, जिसके परिणामस्वरूप अनुरोध ब्लॉक किए जा सकते हैं या डेटा पाइपलाइन बाधित हो सकती है।

जब ट्रैफिक के ऑटोमेटिक होने की संभावना होती है, तो AWS WAF CAPTCHA चुनौती जारी कर सकता है, जो कार्य प्रक्रिया को बाधित करता है जब तक कि यह हल नहीं कर लिया जाता है। इस परिस्थिति में, विशेषज्ञ समाधान लगातारता और डेटा विश्वसनीयता बनाए रखने के लिए आवश्यक होते हैं।

CapSolver: अव्यवहित डेटा अधिग्रहण के लिए आवश्यक उपकरण

CapSolver एक AI-शक्ति CAPTCHA और एंटी-बॉट बचाव सेवा है जो आपके वेब क्रॉलिंग और वेब स्क्रैपिंग ऑपरेशन को अव्यवहित रूप से और कुशल रूप से बनाए रखता है, भले ही आपको AWS WAF जैसे कठिन रक्षा के सामना करना पड़े। यह एक आवश्यक परत के रूप में काम करता है, जो वास्तविक समय में चुनौतियों को हल करता है ताकि आपके क्रॉलर और स्क्रैपर बाधित बिना आगे बढ़ सकें।

CapSolver AWS WAF के लिए टोकन-आधारित और पहचान-आधारित समाधान प्रदान करता है, जो विकासकर्ता के अपने वर्तमान पायथन या नोड.जे.एस स्क्रैपिंग फ्रेमवर्क में इसे सीधे एम्बेड करने की अनुमति देता है।

CapSolver बोनस कोड का उपयोग करें

तुरंत अपने स्वचालन बजट को बढ़ाएं!

CapSolver खाता भरते समय CAPN बोनस कोड का उपयोग करें ताकि प्रत्येक भरती पर 5% बोनस मिले — कोई सीमा नहीं।

अब अपने CapSolver डैशबोर्ड में इसे बदलें

.

AWS WAF बचाव के लिए CapSolver के एम्बेडिंग

CapSolver के शक्ति को दर्शाने के लिए, यहां आपके पास AWS WAF चुनौती के लिए अंतर्निहित और टोकन मोड के साथ समाधान के लिए कैसे एम्बेड करें।

समाधान 1: AWS WAF पहचान मोड (चित्र-आधारित CAPTCHA)

इस मोड का उपयोग तब किया जाता है जब WAF एक दृश्य चुनौती प्रस्तुत करता है (जैसे कि "कार वाले सभी चित्र चुनें")।

कोड ऑपरेशन चरण (पायथन उदाहरण):

- ग्रहण करें: आपके स्क्रैपर AWS WAF चित्र चुनौती की पहचान करता है और चित्र को ग्रहण करता है।

- जमा करें:

AwsWafClassificationटास्क प्रकार के साथ CapSolver API में चित्र भेजें। - प्राप्त करें: CapSolver के AI चुनौती के सही वस्तु के निर्देशांक या लेबल वापस भेजता है।

- हल करें: आपके स्क्रैपर चुनौती पृष्ठ पर सही क्लिक के लिए निर्देशांक का उपयोग करता है।

CapSolver टास्क (पहचान मोड) संदर्भ:

विस्तृत API पैरामीटर और अनुप्रयोग के लिए, आधिकारिक डॉक्यूमेंटेशन के लिए जाएं: CapSolver AWS WAF Classification

समाधान 2: AWS WAF टोकन मोड (अदृश्य/चुनौती पृष्ठ)

इस मोड का उपयोग तब किया जाता है जब WAF एक वैध टोकन की आवश्यकता होती है, आमतौर पर एक छोटे लोडिंग स्क्रीन या अदृश्य जांच के बाद।

कोड ऑपरेशन चरण (पायथन उदाहरण):

- पहचानें: आपके स्क्रैपर चुनौती पृष्ठ से आवश्यक पैरामीटर निर्धारित करता है (जैसे कि

host,iv,key,context)। - जमा करें:

AwsWafटास्क प्रकार के साथ CapSolver API में इन पैरामीटर भेजें। - प्राप्त करें: CapSolver चुनौती को हल करता है और एक वैध

tokenवापस भेजता है। - बचाव करें: आपके स्क्रैपर प्राप्त टोकन को अगले अनुरोध हेडर या फॉर्म डेटा में डालता है ताकि WAF के माध्यम से बचा जा सके।

CapSolver टास्क (टोकन मोड) संदर्भ:

विस्तृत API पैरामीटर और अनुप्रयोग के लिए, आधिकारिक डॉक्यूमेंटेशन के लिए जाएं: CapSolver AWS WAF Token

निष्कर्ष और कार्यवाही के लिए आह्वान

वेब क्रॉलिंग और वेब स्क्रैपिंग के बीच अंतर स्पष्ट है: क्रॉलिंग एक मानचित्र है, और स्क्रैपिंग एक धन खोज है। दोनों आधुनिक डेटा रणनीतियों के लिए अनिवार्य हैं, चाहे आप SEO विशेषज्ञ हो जो खोज इंजन के लिए खोजने योग्य सुनिश्चित करते हैं या डेटा विशेषज्ञ जो बाजार बुद्धिमानी प्लेटफॉर्म बनाते हैं।

हालांकि, जटिल एंटी-बॉट प्रणालियों जैसे कि AWS WAF के बढ़ते उपयोग के कारण, यहां तक कि सबसे अच्छी तरह से डिज़ाइन किए गए क्रॉलिंग और स्क्रैपिंग पाइपलाइन असफल हो सकते हैं। उच्च अव्यवहितता और डेटा सटीकता बनाए रखने के लिए, आपको एक विश्वसनीय समाधान की आवश्यकता होती है।

CapSolver इन चुनौतियों के खिलाफ आवश्यक रक्षा की परत प्रदान करता है, जो आपके डेटा प्रवाह को अव्यवहित रखता है। हाथ में CAPTCHA हल करने में समय बर्बाद न करें या IP बैन के साथ निपटें।

क्या आप एक बल्कि अव्यवहित डेटा पाइपलाइन बनाने के लिए तैयार हैं?

- अपनी यात्रा शुरू करें: CapSolver की वेबसाइट पर जाएं ताकि वे सभी एंटी-बॉट समाधानों की जांच कर सकें।

- तुरंत शुरू करें: CapSolver डैशबोर्ड पर अपना मुफ्त परीक्षण साइन अप करें।

CapSolver आधिकारिक वेबसाइट

CapSolver डैशबोर्ड

अक्सर पूछे जाने वाले प्रश्न (FAQ)

Q1: वेब क्रॉलिंग या वेब स्क्रैपिंग अवैध है?

न तो वेब क्रॉलिंग न ही वेब स्क्रैपिंग आत्मविश्वासपूर्वक अवैध है। कानूनीता क्या आप डेटा निकालते हैं और कैसे आप इसे करते हैं पर निर्भर करती है। आपको robots.txt फ़ाइल का सम्मान करना चाहिए, निजी या कॉपीराइट डेटा को निकालने से बचना चाहिए, और सेवा की शर्तों का पालन करना चाहिए। एक वेबसाइट के प्रदर्शन को नुकसान पहुंचाने वाले अत्यधिक, आक्रामक क्रॉलिंग को अवैध या अनैतिक माना जा सकता है।

Q2: क्या मैं वेब क्रॉलिंग के बिना वेब स्क्रैपिंग कर सकता हूं?

हां, आप कर सकते हैं। अगर आपके पास विशिष्ट यूआरएल की सूची है (जैसे कि एक डेटाबेस से उत्पाद पृष्ठों की सूची), तो आप उन पृष्ठों पर सीधे वेब स्क्रैपिंग कर सकते हैं बिना वेबसाइट के पूरे को खोजने के लिए वेब क्रॉलिंग करने के बिना। क्रॉलिंग केवल खोज के लिए आवश्यक है।

Q3: CapSolver वेब क्रॉलिंग और वेब स्क्रैपिंग दोनों में कैसे मदद करता है?

CapSolver दोनों कार्य प्रवाहों के बीच बाधाओं के समाधान में मुख्य भूमिका निभाता है। बड़े पैमाने पर क्रॉलिंग में, भारी मात्रा में मांग के कारण कैपचा सत्यापन द्वारा रोक दिया जा सकता है। लक्षित स्क्रैपिंग में, एक एक्स्ट्रैक्शन प्रयास एक एमजे़डी वीएएफ चुनौती को सक्रिय कर सकता है। CapSolver वास्तविक समय में इन सत्यापनों को संसाधित करता है, जिससे खोज चरण (क्रॉलिंग) और निकालने चरण (स्क्रैपिंग) में बाधा के बिना चलाना संभव हो जाता है।

Q4: एक सरल स्क्रैपर और Scrapy जैसे एक पूर्ण-कार्यकारी क्रॉलर फ्रेमवर्क के बीच मुख्य अंतर क्या है?

एक सरल स्क्रैपर (जैसे कि requests और BeautifulSoup का उपयोग करके) आमतौर पर एक एकल स्क्रिप्ट होती है जो एक एकल पृष्ठ या छोटी, ज्ञात यूआरएल सूची से डेटा निकालने के लिए डिज़ाइन की जाती है। एक पूर्ण-कार्यकारी क्रॉलर फ्रेमवर्क जैसे कि Scrapy बड़े पैमाने पर, वितरित वेब क्रॉलिंग के लिए डिज़ाइन किया गया है। यह लिंक खोज, मांग योजना, पुन: प्रयास, प्रॉक्सी घूर्णन और पाइपलाइन प्रबंधन का ध्यान रखता है, जो पूरे वेबसाइट के नक्शा बनाने के लिए उपयुक्त होता है।

Q5: क्या वेब क्रॉलिंग केवल खोज इंजन के लिए ही है?

नहीं। खोज इंजन वेब क्रॉलिंग के सबसे प्रसिद्ध उपयोगकर्ता हैं, लेकिन इसका उपयोग एसईओ टूल्स द्वारा साइट ऑडिट के लिए, अकादमिक अनुसंधानकर्ता द्वारा संदर्भ नेटवर्क मैप करने के लिए और सामग्री संग्रहकर्ता द्वारा नए लेख खोजने के लिए भी किया जाता है। किसी भी कार्य जिसमें लिंक और पृष्ठों के नियमित खोज की आवश्यकता होती है, वेब क्रॉलिंग से लाभ प्राप्त करता है।

अनुपालन अस्वीकरण: इस ब्लॉग पर प्रदान की गई जानकारी केवल सूचनात्मक उद्देश्यों के लिए है। CapSolver सभी लागू कानूनों और विनियमों का पालन करने के लिए प्रतिबद्ध है। CapSolver नेटवर्क का उपयोग अवैध, धोखाधड़ी या दुरुपयोग करने वाली गतिविधियों के लिए करना सख्त वर्जित है और इसकी जांच की जाएगी। हमारे कैप्चा समाधान उपयोगकर्ता अनुभव को बेहतर बनाने के साथ-साथ सार्वजनिक डेटा क्रॉलिंग के दौरान कैप्चा कठिनाइयों को हल करने में 100% अनुपालन सुनिश्चित करते हैं। हम अपनी सेवाओं के जिम्मेदार उपयोग की प्रोत्साहना करते हैं। अधिक जानकारी के लिए, कृपया हमारी सेवा की शर्तें और गोपनीयता नीति पर जाएं।

अधिक

2026 में IP बैन: उनके काम करने का तरीका और उन्हें पार करने के व्यावहारिक तरीके

2026 में आईपी बैन बायपास करने के तरीके सीखें हमारे विस्तृत गाइड के साथ। आधुनिक आईपी ब्लॉकिंग तकनीकों और रिजिडेंशियल प्रॉक्सी और कैप्चा सॉल्वर्स जैसे व्यावहारिक समाधानों की खोज करें।

Nikolai Smirnov

26-Jan-2026

कैप्चा कैसे हल करें ब्राउज़र4 में कैपसॉल्वर इंटीग्रेशन के साथ

उच्च बहुतायत ब्राउज़र4 स्वचालन के साथ संयोजित करें, जो बड़े पैमाने पर वेब डेटा निकास में CAPTCHA चुनौतियों का निपटारा करने के लिए CapSolver का उपयोग करता है।

Rajinder Singh

21-Jan-2026

स्क्रैपी और सीलीनियम: आपके वेब स्क्रैपिंग परियोजना के लिए कौन सा सबसे अच्छा है

स्क्रैपी और सीलेनियम के बीच ताकतों और अंतरों की खोज करें। अपने प्रोजेक्ट के लिए सबसे अच्छा टूल कौन है, इसे सीखें और कैप्चा के जैसी चुनौतियों के साथ कैसे निपटें।

Nikolai Smirnov

14-Jan-2026

सेलेनियम ड्राइवर रहित का उपयोग कैसे करें कुशल वेब स्क्रैपिंग के लिए

जानें कैसे सेलेनियम ड्राइवरलेस का उपयोग करके कुशल वेब स्क्रैपिंग करें। यह गाइड अपने वातावरण की स्थापना, अपना पहला सेलेनियम ड्राइवरलेस स्क्रिप्ट लिखना और डायनामिक सामग्री का प्रबंधन करने के चरण-दर-चरण निर्देश प्रदान करता है। पारंपरिक ड्राइवर प्रबंधन की जटिलताओं से बचकर अपने वेब स्क्रैपिंग कार्यों को सुव्यवस्थित करें, जिससे आपकी डेटा निकास प्रक्रिया सरल, तेज और अधिक पोर्टेबल बन जाती है।

Rajinder Singh

14-Jan-2026

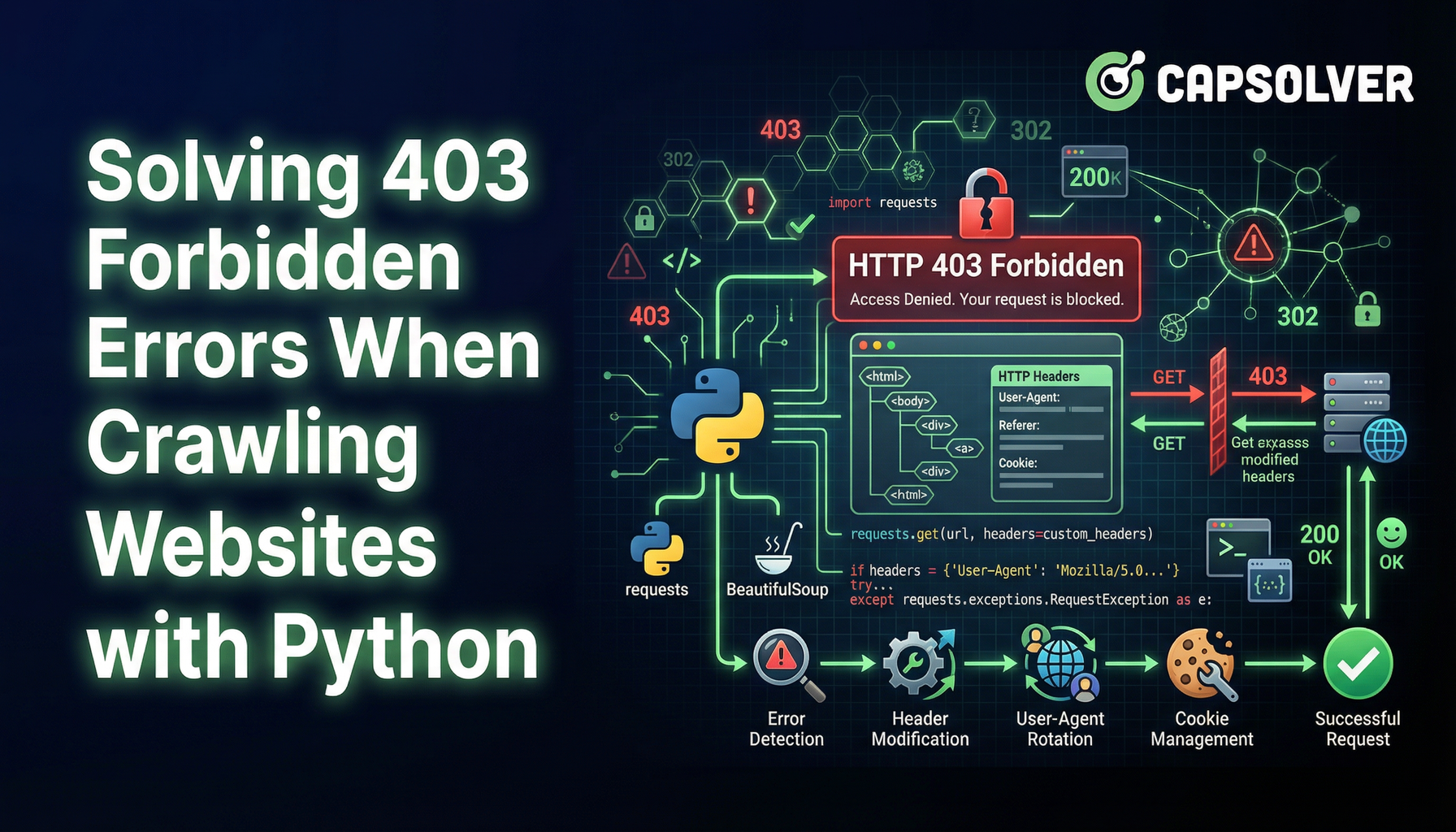

403 अस्वीकृत त्रुटि के समाधान जब पायथन के साथ वेबसाइट्स क्रॉल करते हैं

पायथन के साथ वेबसाइटों को क्रॉल करते समय 403 अस्वीकृत त्रुटि से बचना सीखें। यह गाइड IP रोटेशन, यूजर-एजेंट स्पूफिंग, अनुरोध धीमा करना, प्रमाणीकरण का निपटारा और हेडलेस ब्राउजर का उपयोग करके पहुंच प्रतिबंध बचाना और सफल रूप से वेब स्क्रैपिंग जारी रखना शामिल करता है।

Aloísio Vítor

13-Jan-2026

एग्नो में कैप्चा हल करें कैपसॉल्वर एंटीग्रेशन के साथ

जानें कैसे कैपसॉल्वर को एग्नो के साथ एम्बेड करें ताकि आप अपने स्वायत्त एआई एजेंट्स में reCAPTCHA v2/v3, Cloudflare Turnstile, और WAF चुनौतियां हल कर सकें। वेब स्क्रैपिंग और स्वचालन के लिए वास्तविक पायथन उदाहरण शामिल हैं।

Adélia Cruz

13-Jan-2026