403 अस्वीकृत त्रुटि के समाधान जब पायथन के साथ वेबसाइट्स क्रॉल करते हैं

Aloísio Vítor

Image Processing Expert

13-Jan-2026

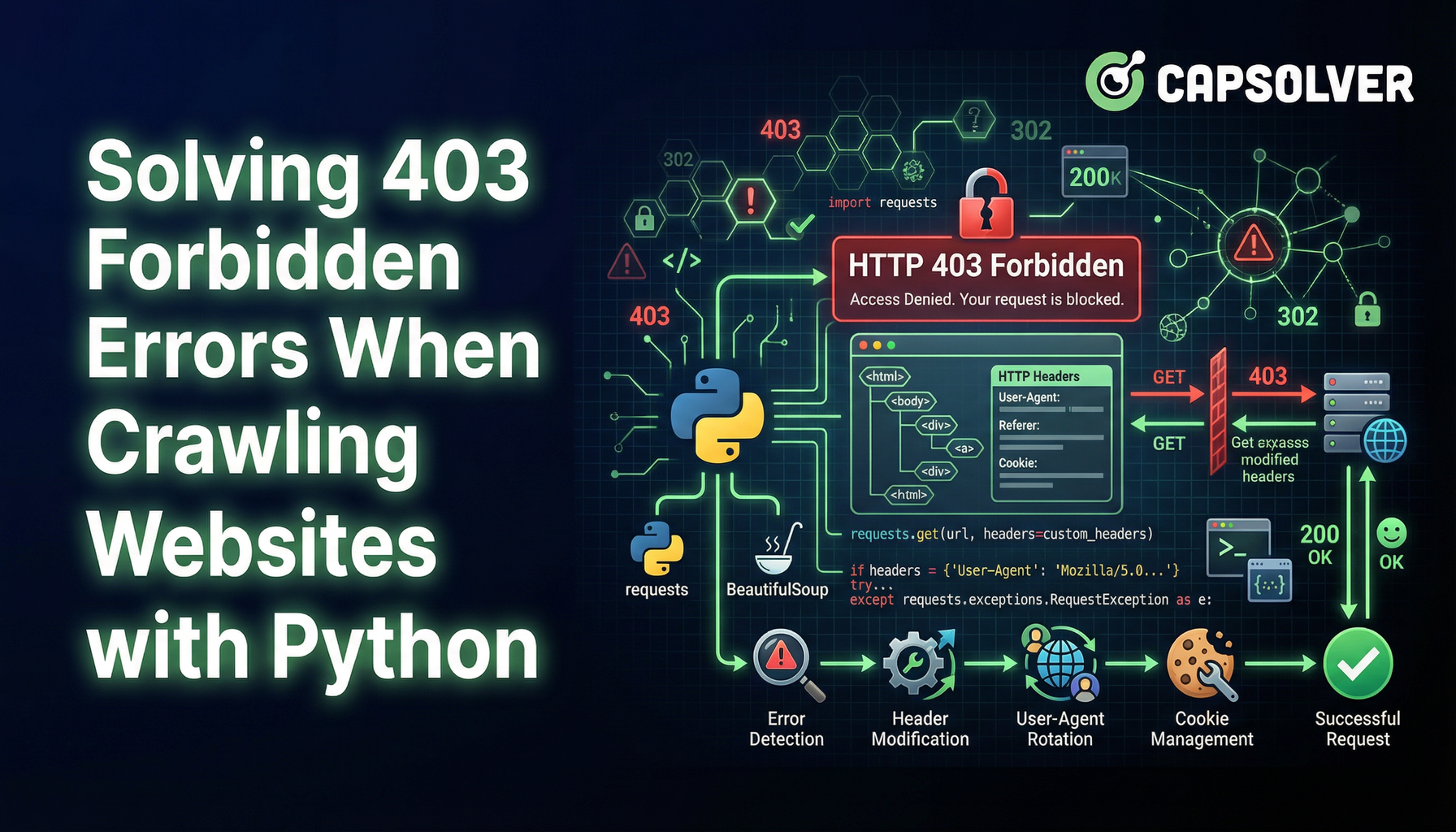

वेब स्क्रैपिंग वेबसाइटों से डेटा निकालने के लिए एक अमूल्य तकनीक है। हालांकि, 403 अस्वीकृत त्रुटि का सामना करना एक मुख्य बाधा हो सकती है। यह त्रुटि संकेत देती है कि सर्वर आपके अनुरोध को समझता है, लेकिन इसे अनुमति देने से इनकार कर देता है। इस समस्या के आसपास घूमने और अपने वेब स्क्रैपिंग यात्रा को जारी रखने के लिए यहां एक तरीका है।

403 अस्वीकृत त्रुटि को समझें

403 अस्वीकृत त्रुटि तब होती है जब सर्वर अनुरोधित संसाधन तक पहुंच को अस्वीकृत कर देता है। इसके कई कारण हो सकते हैं, जैसे:

बार-बार असफल होने वाले अप्रत्याशित कैपचा को पूरी तरह से हल करने में लगे हुए हैं? CapSolver एआई-आधारित ऑटो वेब अनब्लॉक तकनीक के साथ बिना किसी बाधा के कैपचा हल करें!

CapSolver बोनस कोड के साथ बोनस प्राप्त करें

अपने स्वचालन बजट को तुरंत बढ़ाएं!

CapSolver खाता भरते समय CAPN बोनस कोड का उपयोग करके हर भरोसे पर 5% बोनस प्राप्त करें — कोई सीमा नहीं।

अब अपने CapSolver डैशबोर्ड में इसे रीडीम करें

।

- आईपी ब्लॉकिंग: यदि सर्वर असामान्य या उच्च आवृत्ति अनुरोधों का पता लगाता है, तो आईपी पते को ब्लॉक कर सकता है।

- उपयोगकर्ता-एजेंट प्रतिबंध: कुछ वेबसाइटें अनुरोध करने वाले ब्राउजर और उपकरण के उपयोगकर्ता-एजेंट स्ट्रिंग पर आधारित प्रतिबंध लगा सकती हैं।

- प्रमाणीकरण आवश्यक: कुछ पृष्ठों तक पहुंच के लिए लॉगिन आवेदन या एपीआई कुंजी आवश्यक हो सकती है।

403 त्रुटि से बचने के तकनीक

1. आईपी पते के घूर्णन का उपयोग करें

एक निश्चित सीमा के बाद सर्वर एक ही आईपी पते से अनुरोधों को ब्लॉक कर सकता है। आईपी पते के घूर्णन के लिए प्रॉक्सी सर्वर के सूची का उपयोग करके आप इससे बच सकते हैं। Nstproxy या Bright Data जैसी सेवाएं घूर्णन प्रॉक्सी समाधान प्रदान करती हैं।

python

import requests

proxies = {

"http": "http://your_proxy_here",

"https": "http://your_proxy_here",

}

response = requests.get("http://example.com", proxies=proxies)2. वास्तविक उपयोगकर्ता-एजेंट का उपयोग करें

वेब सर्वर अक्सर शंकस्पद उपयोगकर्ता-एजेंट स्ट्रिंग के साथ अनुरोधों की पहचान कर सकते हैं और उन्हें अस्वीकृत कर सकते हैं। एक वास्तविक ब्राउजर के समान उपयोगकर्ता-एजेंट स्ट्रिंग को धोखा देने से आप निरीक्षण से बच सकते हैं।

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. अनुरोध धीमा करें

एक छोटी अवधि में बहुत सारे अनुरोध भेजने से दर-सीमा सीमा ट्रिगर हो सकती है। अनुरोधों के बीच देरी डालकर आप अपने आप को ध्यान में रख सकते हैं।

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # 5 सेकंड के लिए देरी4. प्रमाणीकरण का प्रबंधन करें

कुछ संसाधनों के लिए प्रमाणीकरण आवश्यक हो सकता है। प्रमाणीकृत अनुरोधों के लिए कुकीज या एपीआई कुंजी का उपयोग करके आप पहुंच प्रतिबंध को बर्बाद कर सकते हैं।

python

cookies = {

"session": "your_session_cookie_here"

}

response = requests.get("http://example.com", cookies=cookies)5. हेडलेस ब्राउजर का उपयोग करें

हेडलेस ब्राउजर, जैसे पुप्पेटीयर या सीलेनियम, वास्तविक उपयोगकर्ता अंतक्रिया के साथ एक ब्राउजर के समान व्यवहार करते हैं और जटिल वेब-स्क्रैपिंग रोकने वाले उपायों को बर्बाद करने में मदद कर सकते हैं।

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. कैपचा चुनौतियों को पार करें

403 त्रुटि के अलावा, वेब स्क्रैपर्स को कैपचा चुनौतियों का सामना भी करना पड़ सकता है, जो ऑटोमेटेड एक्सेस को रोकने के लिए डिज़ाइन किए गए हैं। कैपचा जैसे reCAPTCHA के लिए विज़ुअल या इंटरैक्टिव चुनौतियों को हल करना आवश्यक होता है ताकि अनुरोध एक मानव द्वारा किया गया हो यह साबित कर सके।

इन चुनौतियों को हल करने के लिए, आप CapSolver जैसी सेवाओं का उपयोग कर सकते हैं जो स्वचालित कैपचा हल करने के समाधान प्रदान करती हैं। CapSolver विभिन्न प्रकार के कैपचा प्रकारों का समर्थन करता है और वेब स्क्रैपिंग टूल्स के साथ आसान एम्बेडिंग प्रदान करता है।

निष्कर्ष

वेब स्क्रैपिंग के दौरान 403 अस्वीकृत त्रुटि का सामना करना चिंता का विषय हो सकता है, लेकिन इसके पीछे के कारणों को समझने और सही तकनीकों के उपयोग से आप इस बाधा को पार कर सकते हैं। आईपी घूर्णन, वास्तविक उपयोगकर्ता-एजेंट स्ट्रिंग के उपयोग, अनुरोध धीमा करना, प्रमाणीकरण का प्रबंधन करना, या हेडलेस ब्राउजर का उपयोग करना, इन विधियां आपको वेब से मूल्यवान डेटा निकालने के लिए जारी रखने में मदद कर सकती हैं।

इन रणनीतियों का अनुसरण करके, आप 403 त्रुटि के प्रबंधन और बर्बाद करने में प्रभावी ढंग से अपने वेब स्क्रैपिंग प्रयासों को बेहतर बना सकते हैं।

अक्सर पूछे जाने वाले प्रश्न (FAQs)

1. वेब स्क्रैपिंग में 403 अस्वीकृत त्रुटि को बीच करना कानूनी है?

403 त्रुटि को बीच करना अपने आप में अवैध नहीं है, लेकिन कानूनीता वेबसाइट की शर्तों के अनुसार, robots.txt नियमों और स्थानीय कानूनों पर निर्भर करती है। सार्वजनिक रूप से उपलब्ध डेटा के लिए वैध उद्देश्यों के लिए स्क्रैपिंग अक्सर अनुमति दी जाती है, जबकि प्रमाणीकरण, भुगतान के पाठ्यक्रम, या स्पष्ट प्रतिबंधों के बीच करना शर्तों या नियमों के उल्लंघन के रूप में विचार किया जा सकता है। स्क्रैपिंग करने से पहले लक्ष्य साइट की नीतियों की समीक्षा करें।

2. जब प्रॉक्सी और उपयोगकर्ता-एजेंट का उपयोग करने के बाद भी मैं 403 त्रुटि प्राप्त करता हूं, तो क्यों?

403 त्रुटि तब भी बनी रह सकती है यदि वेबसाइट उन्नत बॉट-पहचान प्रणाली जैसे व्यवहार विश्लेषण, फिंगरप्रिंटिंग या कैपचा चुनौतियों का उपयोग करती है। ऐसे मामलों में सरल आईपी घूर्णन और उपयोगकर्ता-एजेंट धोखा देना पर्याप्त नहीं हो सकता है। अनुरोध धीमा करना, सेशन प्रबंधन, हेडलेस ब्राउजर और कैपचा हल करने वाली सेवाओं जैसे CapSolver के साथ अपने आप को बेहतर बनाने में मदद मिल सकती है।

3. बड़े पैमाने पर स्क्रैपिंग के लिए 403 त्रुटि से बचने का सबसे विश्वसनीय तरीका क्या है?

बड़े पैमाने पर स्क्रैपिंग के लिए, सबसे विश्वसनीय दृष्टिकोण एक परतदार रणनीति है: उच्च गुणवत्ता वाले घूर्णन निवासी या मोबाइल प्रॉक्सी, वास्तविक ब्राउजर फिंगरप्रिंट, नियंत्रित अनुरोध दर, सही प्रमाणीकरण प्रबंधन, और स्वचालित कैपचा हल करने वाली सेवाओं का उपयोग करें। हेडलेस ब्राउजर के साथ एआई-आधारित वेब अनब्लॉक समाधान का उपयोग करके वास्तविक उपयोगकर्ता व्यवहार के बराबर बनाए रखने में मदद मिलती है और 403 ब्लॉक के दोहराने की संभावना कम हो जाती है।

अनुपालन अस्वीकरण: इस ब्लॉग पर प्रदान की गई जानकारी केवल सूचनात्मक उद्देश्यों के लिए है। CapSolver सभी लागू कानूनों और विनियमों का पालन करने के लिए प्रतिबद्ध है। CapSolver नेटवर्क का उपयोग अवैध, धोखाधड़ी या दुरुपयोग करने वाली गतिविधियों के लिए करना सख्त वर्जित है और इसकी जांच की जाएगी। हमारे कैप्चा समाधान उपयोगकर्ता अनुभव को बेहतर बनाने के साथ-साथ सार्वजनिक डेटा क्रॉलिंग के दौरान कैप्चा कठिनाइयों को हल करने में 100% अनुपालन सुनिश्चित करते हैं। हम अपनी सेवाओं के जिम्मेदार उपयोग की प्रोत्साहना करते हैं। अधिक जानकारी के लिए, कृपया हमारी सेवा की शर्तें और गोपनीयता नीति पर जाएं।

अधिक

रॉक्सीब्राउज़र में कैप्चा हल करना कैपसॉल्वर एकीकरण के साथ

CapSolver के साथ RoxyBrowser के एकीकरण करें ताकि ब्राउज़र के कार्यों को स्वचालित किया जा सके और reCAPTCHA, Turnstile और अन्य CAPTCHAs को बायपास किया जा सके।

Rajinder Singh

04-Feb-2026

ईजीस्पाइडर में कैप्चा हल करें कैपसॉल्वर एकीकरण के साथ

ईज़ीस्पाइडर एक दृश्य, नो-कोड वेब स्क्रैपिंग और ब्राउज़र ऑटोमेशन टूल है, जबकि कैपसॉल्वर के साथ जुड़ा हुआ है, तो यह reCAPTCHA v2 और Cloudflare Turnstile जैसे CAPTCHA को विश्वसनीय रूप से हल कर सकता है, जो वेबसाइटों पर सुचारू रूप से स्वचालित डेटा निकालने की अनुमति देता है।

Rajinder Singh

04-Feb-2026

रीकैपचा वी२ कैसे हल करें रीलेवेंस एआई में कैपसॉल्वर एकीकरण के साथ

रिलेवेंस एआई उपकरण बनाएं जो reCAPTCHA v2 को CapSolver के उपयोग से हल करे। ब्राउजर ऑटोमेशन के बिना एपीआई के माध्यम से फॉर्म जमाकर स्वचालित करें।

Rajinder Singh

03-Feb-2026

2026 में IP बैन: उनके काम करने का तरीका और उन्हें पार करने के व्यावहारिक तरीके

2026 में आईपी बैन बायपास करने के तरीके सीखें हमारे विस्तृत गाइड के साथ। आधुनिक आईपी ब्लॉकिंग तकनीकों और रिजिडेंशियल प्रॉक्सी और कैप्चा सॉल्वर्स जैसे व्यावहारिक समाधानों की खोज करें।

Nikolai Smirnov

26-Jan-2026

कैप्चा कैसे हल करें ब्राउज़र4 में कैपसॉल्वर इंटीग्रेशन के साथ

उच्च बहुतायत ब्राउज़र4 स्वचालन के साथ संयोजित करें, जो बड़े पैमाने पर वेब डेटा निकास में CAPTCHA चुनौतियों का निपटारा करने के लिए CapSolver का उपयोग करता है।

Rajinder Singh

21-Jan-2026

स्क्रैपी और सीलीनियम: आपके वेब स्क्रैपिंग परियोजना के लिए कौन सा सबसे अच्छा है

स्क्रैपी और सीलेनियम के बीच ताकतों और अंतरों की खोज करें। अपने प्रोजेक्ट के लिए सबसे अच्छा टूल कौन है, इसे सीखें और कैप्चा के जैसी चुनौतियों के साथ कैसे निपटें।

Nikolai Smirnov

14-Jan-2026