पायथन में वेब क्रालर और वेब क्रॉलिंग के दौरान ब्लॉक होने से कैसे बचें

Rajinder Singh

Deep Learning Researcher

19-Nov-2025

इंटरनेट जानकारी का एक विशाल भंडार है, जो समाचार अपडेट से लेकर वेबसाइटों के गहरे छोर पर छिपे निश्चित डेटा बिंदुओं तक फैला हुआ है। इस डेटा को हाथ से निकालना अव्यावहारिक है, जहां वेब क्रॉलिंग चमकता है। वेब क्रॉलिंग, जिसे वेब स्क्रैपिंग भी कहा जाता है, वेबसाइटों के माध्यम से नेविगेट करने, डेटा निकालने और विभिन्न उद्देश्यों के लिए भंडारण करने की स्वचालित प्रक्रिया है, जैसे कि डेटा विश्लेषण, बाजार अनुसंधान और सामग्री एग्रीगेशन।

हालांकि, वेब क्रॉलिंग के दृष्टिकोण चुनौतियों से बचे नहीं है। वेबसाइटें स्वचालित क्रॉलर के पता लगाने और ब्लॉक करने के लिए जटिल तकनीकों का उपयोग करती हैं, जो आसान दर सीमा से लेकर उन्नत कैपचा चुनौतियों तक फैली हुई है। वेब क्रॉलर विकासकर्ता के रूप में, इन चुनौतियों के साथ प्रभावी ढंग से निपटना विश्वसनीय डेटा निकासी प्रक्रियाओं को बनाए रखने के लिए महत्वपूर्ण है।

👌 सारांश

- वेब क्रॉलर की समझ

- पायथन में एक वेब क्रॉलर

- वेब क्रॉलिंग के दौरान ब्लॉक होने से बचने के तरीके

- निष्कर्ष

वेब क्रॉलर की समझ

वेब क्रॉलर क्या है?

एक वेब क्रॉलर, एक लगन से काम करने वाले डिजिटल खोजकर्ता के समान होता है, जो इंटरनेट के विस्तृत क्षेत्रों के माध्यम से बिना रुके घूमता रहता है। इसका लक्ष्य क्या है? वेबसाइटों को व्यवस्थित रूप से खोजना, अपने रास्ते में सभी चीजों को इंडेक्स करना। मूल रूप से खोज इंजनों के लिए डिज़ाइन किया गया, जो तेजी से खोज परिणाम बनाता है, इन बॉट विकसित हो गए हैं। अब, वे कूपन एप्स से लेकर एसईओ विशेषज्ञों तक चलाते हैं, जो शीर्षक, छवियां, कीवर्ड और लिंक एकत्र करते हैं। इंडेक्सिंग के बाद, वे सामग्री निकाल सकते हैं, वेबपेज के परिवर्तनों का अनुसरण कर सकते हैं, और यहां तक कि डेटा खनन भी कर सकते हैं। वेब स्पाइडर के साथ परिचित हो जाओ: वर्ल्ड वाइड वेब के माध्यम से घूमते हुए, जानकारी के डिजिटल जाल बुनते हुए।

वेब क्रॉलर कैसे काम करता है?

वेब क्रॉलर वेब पृष्ठों के माध्यम से व्यवस्थित रूप से नेविगेट करता है, पूर्व निर्धारित सेट से शुरू होता है और नए पृष्ठों की खोज करने के लिए हाइपरलिंक का अनुसरण करता है। क्रॉल शुरू करने से पहले, ये बॉट पहले एक साइट के रोबोट्स.txt फ़ाइल की जांच करते हैं, जो वेबसाइट मालिकों द्वारा निर्धारित नियमों के बारे में बताती है कि कौन से पृष्ठ क्रॉल करे जा सकते हैं और कौन से लिंक अनुसरण करे जा सकते हैं।

इंटरनेट के विशाल विस्तार के लिए, वेब क्रॉलर निर्धारित नियमों के आधार पर कुछ पृष्ठों की प्राथमिकता देते हैं। वे बाहरी लिंकों के साथ अधिक पृष्ठों, अधिक ट्रैफिक के पृष्ठों या अधिक ब्रांड प्रभाव के पृष्ठों की प्राथमिकता दे सकते हैं। इस प्राथमिकता रणनीति के मूल में यह धारणा है कि जिन पृष्ठों पर अधिक ट्रैफिक और लिंक होते हैं, वे उपयोगकर्ताओं द्वारा खोजे गए विश्वसनीय और मूल्यवान सामग्री के अधिक संभावना होती है। एल्गोरिदम भी क्रॉलर को प्रत्येक पृष्ठ पर पाए गए सामग्री के संबंधितता और लिंक की गुणवत्ता का आकलन करने में मदद करते हैं।

उनकी खोज के दौरान, वेब क्रॉलर प्रत्येक साइट से मेटा टैग को ध्यान से रिकॉर्ड करते हैं, जो आवश्यक मेटाडेटा और कीवर्ड जानकारी प्रदान करते हैं। यह डेटा खोज इंजनों द्वारा पृष्ठों के रैंकिंग और प्रदर्शन में महत्वपूर्ण भूमिका निभाता है, जो उपयोगकर्ताओं के लिए जानकारी के अनुरोध के लिए मार्गदर्शन में मदद करता है।

पायथन में एक वेब क्रॉलर

पायथन में एक वेब क्रॉलर एक स्वचालित स्क्रिप्ट होती है जो पूर्व निर्धारित सीड यूआरएल से शुरू होकर इंटरनेट का ध्यान से ब्राउज करती है। यह वेब सर्वरों पर HTTP मांगें करके काम करता है, HTML सामग्री प्राप्त करता है, और फिर BeautifulSoup या lxml जैसे लाइब्रेरी का उपयोग करके इस सामग्री को पार्स करता है। इन लाइब्रेरी के माध्यम से क्रॉलर को पृष्ठ शीर्षक, लिंक, छवि और पाठ जैसी संबंधित जानकारी निकालने में मदद मिलती है।

पायथन के विविधता वेब मांगों के साथ निपटने में विशेष रूप से उपयुक्त होती है और HTML के पार्सिंग के लिए। क्रॉलर आमतौर पर एक साइट के robots.txt फ़ाइल में निर्धारित नियमों के अनुसार रहते हैं, जो बताता है कि कौन से हिस्से क्रॉल करे जा सकते हैं और कौन से बाहर रखे जाने चाहिए। इस अनुपालन नैतिक क्रॉलिंग अभ्यास को बनाए रखने और साइट मालिक के पसंद के सम्मान करने में मदद करता है।

खोज इंजन के लिए पृष्ठों के इंडेक्सिंग के अलावा, पायथन वेब क्रॉलर डेटा खनन, सामग्री एग्रीगेशन, वेबसाइट के परिवर्तनों की निगरानी और यहां तक कि स्वचालित परीक्षण के लिए भी उपयोग किए जाते हैं। जब वे पृष्ठों में लिंक का अनुसरण करते हैं, तो क्रॉलर वेबसाइटों के माध्यम से घूमते हैं, जो वेब के संरचना के समान एक जाल बनाते हैं। इस प्रक्रिया के माध्यम से वे विस्तृत स्रोतों से डेटा का ध्यान से एकत्र करते हैं, जो प्रतिस्पर्धी विश्लेषण, बाजार अनुसंधान और जानकारी प्राप्ति में मदद करते हैं।

पायथन वेब क्रॉलर बनाना

वेब क्रॉलर बनाने में डूबने से पहले, आवश्यक उपकरणों और लाइब्रेरी के साथ अपने विकास पर्यावरण को सेट करना महत्वपूर्ण है।

आवश्यकताएं

- पायथन: python.org से पायथन 3.x स्थापित करें।

- रिक्वेस्ट्स लाइब्रेरी: HTTP मांगें बनाने के लिए।

- ब्यूटीफुल सॉउप: HTML और XML दस्तावेज़ों के पार्सिंग के लिए।

- सीलेनियम (वैकल्पिक): जावास्क्रिप्ट-रेंडर की गई सामग्री और कैपचा के साथ निपटने के लिए।

bash

pip install requests beautifulsoup4 seleniumएक सरल वेब क्रॉलर बनाना

चलिए पायथन के साथ एक बुनियादी वेब क्रॉलर बनाते हैं और एक वेबपेज से लिंक और पाठ निकालने के तरीके को दर्शाते हैं।

python

import requests

from bs4 import BeautifulSoup

def simple_crawler(url):

# HTTP मांग भेजें

response = requests.get(url)

# जांचें कि मांग सफल रही है या नहीं

if response.status_code == 200:

# BeautifulSoup के साथ सामग्री को पार्स करें

soup = BeautifulSoup(response.text, 'html.parser')

# उदाहरण: पृष्ठ से सभी लिंक निकालें

links = soup.find_all('a', href=True)

for link in links:

print(link['href'])

# उदाहरण: विशिष्ट तत्वों से पाठ निकालें

headings = soup.find_all(['h1', 'h2', 'h3'])

for heading in headings:

print(heading.text)

else:

print(f"{url} से सामग्री प्राप्त करने में विफल रहे")

# उदाहरण उपयोग

simple_crawler('https://example.com')वेब क्रॉलिंग के दौरान ब्लॉक होने से बचने के तरीके

जब आप पायथन में वेब क्रॉलिंग शुरू करते हैं, तो ब्लॉक के बारे में निपटना एक महत्वपूर्ण चुनौती बन जाता है। बहुत सारे वेबसाइट अपनी रक्षा के लिए एंटी-बॉट उपायों के साथ बंद कर दिए गए हैं, जो स्वचालित उपकरणों के पता लगाने और रोकने के लिए डिज़ाइन किए गए हैं, इसलिए उनके पृष्ठों तक पहुंच ब्लॉक कर दी जाती है।

इन बाधाओं को दूर करने के लिए, निम्नलिखित रणनीतियों के अनुसरण करने का विचार करें:

1. कैपचा के साथ निपटना

कैपचा स्वचालित क्रॉलर के खिलाफ एक सामान्य रक्षा तकनीक है। वे उपयोगकर्ताओं को विश्वास दिलाने के लिए चुनौतियां देते हैं कि वे मानव हैं, जैसे कि वस्तुओं की पहचान करना या टेक्स्ट दर्ज करना। सबसे अच्छी रणनीति कैपचा हल करने वाली विश्वसनीय सेवा के साथ जुड़ना है, जैसे कि CapSolver अपने वेब स्क्रैपिंग प्रक्रिया में इस प्रक्रिया को सुव्यवस्थित कर सकता है। CapSolver विभिन्न प्रकार के कैपचा को कार्यात्मक रूप से हल करने के लिए एपीआई और उपकरण प्रदान करता है, जो अपने पायथन स्क्रिप्ट के साथ बिना किसी बाधा के एम्बेड कर सकता है। नीचे एक त्वरित शॉर्ट गाइड दिखाई गई है:

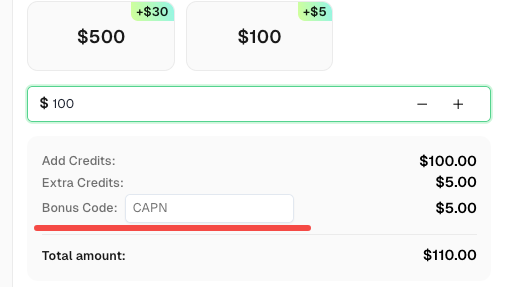

अपने CapSolver बोनस कोड के साथ अपने कार्य को आगे बढ़ाएं

अपने ऑपरेशन को आगे बढ़ाने के अवसर को न छोड़ें! अपने CapSolver खाते में जमा करते समय बोनस कोड CAPN का उपयोग करें और प्रत्येक रीचार्ज पर 5% बोनस प्राप्त करें, कोई सीमा नहीं है। CapSolver पर जाएं और अब अपना बोनस बदलें!

कैपसॉल्वर के साथ पायथन के साथ किसी भी कैपचा को हल करना:

आवश्यकताएं

- कार्यरत प्रॉक्सी

- पायथन स्थापित

- CapSolver API की

🤖 चरण 1: आवश्यक पैकेज स्थापित करें

आवश्यक पैकेज स्थापित करने के लिए निम्नलिखित आदेश चलाएं:

pip install capsolver

यहां reCAPTCHA v2 का एक उदाहरण है:

👨💻 reCAPTCHA v2 के साथ अपने प्रॉक्सी के साथ हल करने के लिए पायथन कोड

यहां एक पायथन उदाहरण स्क्रिप्ट है जो कार्य करती है:

python

import capsolver

# संवेदनशील जानकारी के लिए पर्यावरण चर का उपयोग करें

PROXY = "http://username:password@host:port"

capsolver.api_key = "अपना कैपसॉल्वर API की"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("reCaptcha v2 हल कर रहा है")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("समाधान: ", solution)

if __name__ == "__main__":

main()👨💻 reCAPTCHA v2 के बिना प्रॉक्सी के साथ हल करने के लिए पायथन कोड

यहां एक पायथन उदाहरण स्क्रिप्ट है जो कार्य करती है:

python

import capsolver

# संवेदनशील जानकारी के लिए पर्यावरण चर का उपयोग करें

capsolver.api_key = "अपना कैपसॉल्वर API की"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("reCaptcha v2 हल कर रहा है")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("समाधान: ", solution)

if __name__ == "__main__":

main()2. आईपी बैन और दर सीमाओं से बचें

वेबसाइटें आमतौर पर अतिभार और दुरुपयोग को रोकने के लिए एक निश्चित समय फ्रेम में क्रॉलर द्वारा की गई मांगों की संख्या पर सीमा लगाती हैं।

पहचान के बचने के लिए रणनीतियां:

- आईपी पता बदलें: आईपी पतों को बदलने के लिए प्रॉक्सी सर्वर या वीपीएन का उपयोग करें और दर सीमाओं को ट्रिगर न करें।

- रोबोट्स.txt का सम्मान करें: एक साइट के

robots.txtफ़ाइल में निर्देशों की जांच करें और उनका पालन करें ताकि ब्लॉक न हो। - मेहरबान नीति: मांगों के बीच देरी शामिल करें (क्रॉल देरी) ताकि मानव ब्राउजिंग व्यवहार को सिमुलेट करें।

निष्कर्ष

वेब क्रॉलिंग व्यापार और अनुसंधानकर्ताओं को विशाल मात्रा में डेटा के अधिक प्रभावी तरीके से उपलब्ध कराता है। हालांकि, स्वचालित पहचान और ब्लॉकिंग के चुनौतियों के निपटारे के लिए रणनीतिक योजना और नैतिक मानकों के पालन की आवश्यकता होती है। पायथन की मजबूत लाइब्रेरी के उपयोग और अच्छे अभ्यास के अनुसरण करके, विकासकर्ता टिकाऊ क्रॉलर बना सकते हैं जो वेबसाइटों द्वारा निर्धारित सीमाओं के सम्मान के साथ मूल्यवान अंतर्दृष्टि निकालने में सक्षम हो सकते हैं।

सारांश में, वेब क्रॉलिंग का नियंत्रण करना केवल तकनीकी विशेषज्ञता के साथ-साथ वेब व्यवहार के अच्छे ज्ञान और कानूनी विचारों के समझ के साथ आवश्यक है। इन उपकरणों और रणनीतियों के साथ आप अपने परियोजनाओं में वेब क्रॉलिंग के शक्ति का जिम्मेदार और प्रभावी ढंग से उपयोग कर सकते हैं।

अनुपालन अस्वीकरण: इस ब्लॉग पर प्रदान की गई जानकारी केवल सूचनात्मक उद्देश्यों के लिए है। CapSolver सभी लागू कानूनों और विनियमों का पालन करने के लिए प्रतिबद्ध है। CapSolver नेटवर्क का उपयोग अवैध, धोखाधड़ी या दुरुपयोग करने वाली गतिविधियों के लिए करना सख्त वर्जित है और इसकी जांच की जाएगी। हमारे कैप्चा समाधान उपयोगकर्ता अनुभव को बेहतर बनाने के साथ-साथ सार्वजनिक डेटा क्रॉलिंग के दौरान कैप्चा कठिनाइयों को हल करने में 100% अनुपालन सुनिश्चित करते हैं। हम अपनी सेवाओं के जिम्मेदार उपयोग की प्रोत्साहना करते हैं। अधिक जानकारी के लिए, कृपया हमारी सेवा की शर्तें और गोपनीयता नीति पर जाएं।

अधिक

2026 में IP बैन: उनके काम करने का तरीका और उन्हें पार करने के व्यावहारिक तरीके

2026 में आईपी बैन बायपास करने के तरीके सीखें हमारे विस्तृत गाइड के साथ। आधुनिक आईपी ब्लॉकिंग तकनीकों और रिजिडेंशियल प्रॉक्सी और कैप्चा सॉल्वर्स जैसे व्यावहारिक समाधानों की खोज करें।

Nikolai Smirnov

26-Jan-2026

कैप्चा कैसे हल करें ब्राउज़र4 में कैपसॉल्वर इंटीग्रेशन के साथ

उच्च बहुतायत ब्राउज़र4 स्वचालन के साथ संयोजित करें, जो बड़े पैमाने पर वेब डेटा निकास में CAPTCHA चुनौतियों का निपटारा करने के लिए CapSolver का उपयोग करता है।

Rajinder Singh

21-Jan-2026

स्क्रैपी और सीलीनियम: आपके वेब स्क्रैपिंग परियोजना के लिए कौन सा सबसे अच्छा है

स्क्रैपी और सीलेनियम के बीच ताकतों और अंतरों की खोज करें। अपने प्रोजेक्ट के लिए सबसे अच्छा टूल कौन है, इसे सीखें और कैप्चा के जैसी चुनौतियों के साथ कैसे निपटें।

Nikolai Smirnov

14-Jan-2026

सेलेनियम ड्राइवर रहित का उपयोग कैसे करें कुशल वेब स्क्रैपिंग के लिए

जानें कैसे सेलेनियम ड्राइवरलेस का उपयोग करके कुशल वेब स्क्रैपिंग करें। यह गाइड अपने वातावरण की स्थापना, अपना पहला सेलेनियम ड्राइवरलेस स्क्रिप्ट लिखना और डायनामिक सामग्री का प्रबंधन करने के चरण-दर-चरण निर्देश प्रदान करता है। पारंपरिक ड्राइवर प्रबंधन की जटिलताओं से बचकर अपने वेब स्क्रैपिंग कार्यों को सुव्यवस्थित करें, जिससे आपकी डेटा निकास प्रक्रिया सरल, तेज और अधिक पोर्टेबल बन जाती है।

Rajinder Singh

14-Jan-2026

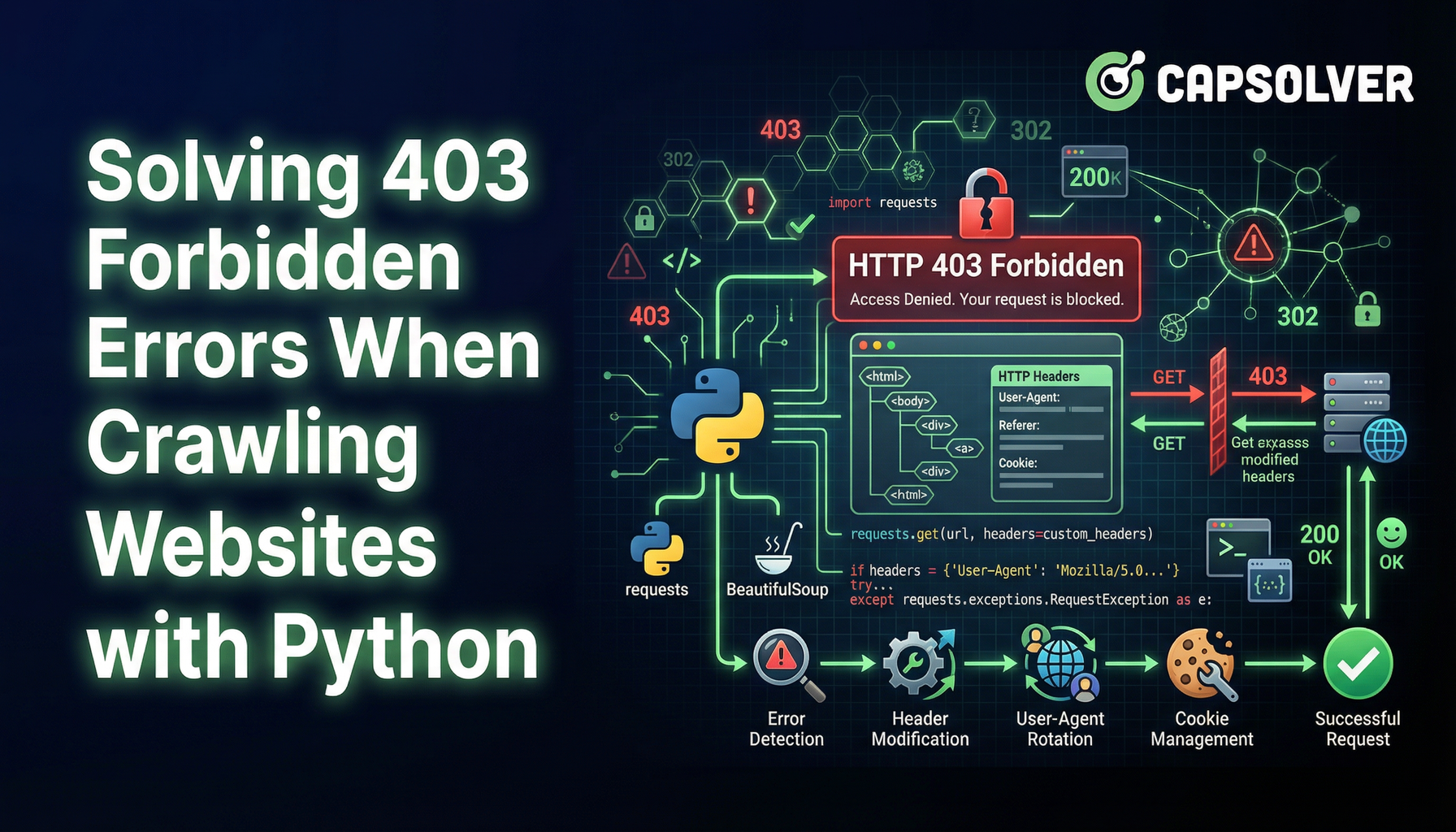

403 अस्वीकृत त्रुटि के समाधान जब पायथन के साथ वेबसाइट्स क्रॉल करते हैं

पायथन के साथ वेबसाइटों को क्रॉल करते समय 403 अस्वीकृत त्रुटि से बचना सीखें। यह गाइड IP रोटेशन, यूजर-एजेंट स्पूफिंग, अनुरोध धीमा करना, प्रमाणीकरण का निपटारा और हेडलेस ब्राउजर का उपयोग करके पहुंच प्रतिबंध बचाना और सफल रूप से वेब स्क्रैपिंग जारी रखना शामिल करता है।

Aloísio Vítor

13-Jan-2026

एग्नो में कैप्चा हल करें कैपसॉल्वर एंटीग्रेशन के साथ

जानें कैसे कैपसॉल्वर को एग्नो के साथ एम्बेड करें ताकि आप अपने स्वायत्त एआई एजेंट्स में reCAPTCHA v2/v3, Cloudflare Turnstile, और WAF चुनौतियां हल कर सकें। वेब स्क्रैपिंग और स्वचालन के लिए वास्तविक पायथन उदाहरण शामिल हैं।

Adélia Cruz

13-Jan-2026