Crawleo de web vs. Scraping de web: La diferencia esencial

Adélia Cruz

Neural Network Developer

26-Nov-2025

TL;DR: El rastreo web es el proceso de descubrir y indexar páginas web siguiendo enlaces, principalmente utilizado por motores de búsqueda y para auditorías de sitios. El scraping web es la extracción dirigida de datos específicos de esas páginas descubiertas, esencial para la investigación de mercado y el análisis de datos. Ambos procesos, especialmente el scraping web, suelen interrumpirse con frecuencia por controles de acceso avanzados como AWS WAF. Estos desafíos pueden abordarse eficazmente utilizando una solución especializada como CapSolver.

Introducción

El mundo digital se basa en datos, y los procesos de rastreo web y scraping web son los mecanismos fundamentales para recopilar esta vasta información. Aunque a menudo se usan indistintamente, representan dos etapas distintas, pero complementarias, en la cadena de adquisición de datos. Comprender la diferencia entre el rastreo web y el scraping web es crucial para cualquiera que esté construyendo aplicaciones basadas en datos, realizando investigación de mercado o optimizando para motores de búsqueda.

Esta guía completa está diseñada para científicos de datos, especialistas en SEO y desarrolladores. Definiremos claramente cada proceso, destacaremos sus diferencias principales, exploraremos 10 soluciones detalladas donde se aplican y demostraremos cómo herramientas como CapSolver pueden mejorar la eficiencia y resolver desafíos comunes de acceso. Al final, tendrás un marco sólido para implementar estrategias de datos web eficientes y compatibles.

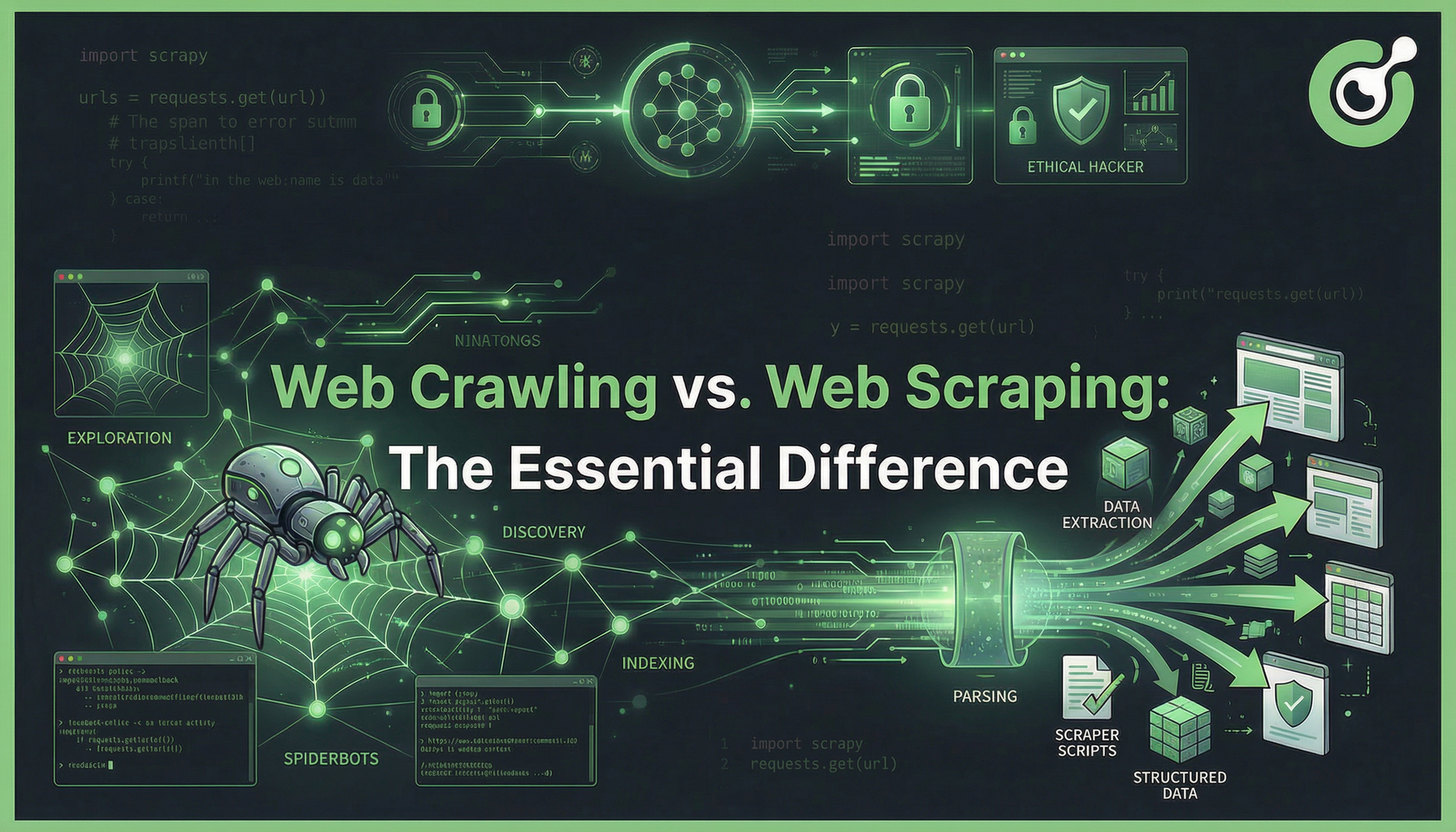

Rastreo web vs. Scraping web: La distinción fundamental

En esencia, la diferencia entre el rastreo web y el scraping web radica en su objetivo principal. El rastreo web se trata de descubrimiento y mapeo, mientras que el scraping web se enfoca en la extracción y estructuración.

Un rastreador web, como Googlebot, navega sistemáticamente por la World Wide Web, siguiendo hipervínculos de una página a otra. Su objetivo es crear un índice completo de internet. Un scraper web, por otro lado, se enfoca en puntos de datos específicos, como precios de productos, información de contacto o texto de artículos, de un conjunto conocido de URLs, transformando HTML no estructurado en formatos de datos limpios y utilizables como CSV o JSON.

Resumen de comparación: Rastreo vs. Scraping

| Característica | Rastreo web | Scraping web |

|---|---|---|

| Objetivo principal | Descubrimiento, Indexación, Mapeo de la estructura del sitio | Extracción de datos, Estructuración, Análisis |

| Salida | Una lista de URLs, mapa del sitio o índice de páginas | Datos estructurados (JSON, CSV, registros de base de datos) |

| Alcance | Nivel de sitio o web completa (siguiendo todos los enlaces) | Nivel de página (objetivo elementos específicos) |

| Analogía | Un bibliotecario catalogando todos los libros de una biblioteca | Un investigador extrayendo una cita específica de un libro |

| Herramientas clave | Scrapy, Apache Nutch, Googlebot | BeautifulSoup, Puppeteer, Selenium, Scripts personalizados |

| Caso de uso típico | Optimización para motores de búsqueda (SEO), Auditorías de sitio | Monitoreo de precios, generación de leads, investigación de mercado |

Rastreo web: El motor del descubrimiento

El rastreo web es el proceso automatizado de navegar sistemáticamente por la World Wide Web. Es el primer paso fundamental para que los motores de búsqueda descubran contenido nuevo y actualizado.

Propósito y mecanismo

El propósito principal del rastreo web es crear un mapa de internet o de un sitio web específico. Un rastreador comienza con una lista de semillas de URLs, obtiene el contenido de esas páginas y luego analiza el HTML para encontrar nuevos hipervínculos. Repite este proceso recursivamente, expandiendo su alcance. Este proceso está gobernado por reglas definidas en el archivo robots.txt, que indica qué partes de un sitio el rastreador puede acceder.

Para los profesionales de SEO, el rastreo es esencial. Un rastreo exitoso significa que una página puede ser indexada y clasificada. Según un estudio sobre la importancia del SEO, un rastreo exitoso es el paso fundamental primero para lograr visibilidad orgánica. ClickGuard señala que si una página no es rastreada, no puede ser clasificada.

Herramientas clave para el rastreo web

- Scrapy: Un marco de rastreo web de alto nivel y rápido para Python. Es ideal para proyectos de rastreo a gran escala y complejos.

- Apache Nutch: Un rastreador web de código abierto que se puede usar para construir motores de búsqueda a gran escala.

- Rastreadores personalizados: Construidos usando bibliotecas como

requestsyBeautifulSoupen Python, a menudo para tareas más pequeñas y altamente personalizadas.

Scraping web: El arte de la extracción de datos

El scraping web es la técnica de extraer datos específicos de sitios web. Es un proceso más enfocado que ocurre después de que una página haya sido descubierta por un rastreador o cuando la URL ya se conoce.

Propósito y mecanismo

El objetivo del scraping web es convertir los datos no estructurados, legibles por humanos en una forma estructurada y legible por máquinas. Esto implica usar selectores (como selectores CSS o XPath) para identificar los elementos de datos exactos, como el nombre de un producto, un precio o una calificación de revisión, y luego extraer y limpiar ese texto.

El mercado del scraping web está experimentando un crecimiento significativo. El mercado global de scraping web se proyecta alcanzar 2.000 millones de dólares para 2030, impulsado por la creciente demanda de fuentes de datos alternativas en finanzas, comercio electrónico y inteligencia de mercado. Mordor Intelligence destaca esta rápida expansión.

Herramientas clave para el scraping web

- BeautifulSoup: Una biblioteca de Python para analizar documentos HTML y XML, a menudo usada junto con la biblioteca

requests. - Selenium/Puppeteer: Herramientas de automatización de navegadores usadas para extraer contenido dinámico (páginas renderizadas con JavaScript) simulando la interacción de un usuario real.

- APIs de scraping dedicadas: Servicios que manejan la infraestructura, rotación de proxies y el bypass de robots para el usuario.

10 Soluciones y Casos de Uso Detallados para Rastreo y Scraping

Dominar tanto el rastreo web como el scraping web permite crear soluciones poderosas y basadas en datos. Aquí hay 10 aplicaciones detalladas, demostrando la sinergia entre el descubrimiento y la extracción.

1. Auditorías completas de SEO (Rastreo)

Objetivo: Identificar enlaces rotos, cadenas de redirección y problemas de estructura de sitio que obstaculizan el indexado de motores de búsqueda.

Proceso: Un rastreador comienza en la página principal y sigue cada enlace interno. Registra el código de estado (200, 404, 301), título de la página y profundidad para cada URL.

Valor: Asegura que todas las páginas importantes sean descubiertas por los rastreadores de motores de búsqueda, lo cual es fundamental para un buen SEO.

2. Monitoreo en tiempo real de precios en comercio electrónico (Scraping)

Objetivo: Seguir los precios de competidores para miles de productos para ajustar estrategias de precios dinámicos.

Proceso: Un scraper recibe una lista de URLs de productos conocidos. Se enfoca en el elemento HTML específico que contiene el precio y extrae el valor numérico.

Valor: Proporciona una ventaja competitiva al permitir reaccionar instantáneamente a los cambios del mercado.

3. Generación de leads y adquisición de datos de contacto (Scraping)

Objetivo: Extraer detalles de contacto (correo electrónico, número de teléfono) de directorios empresariales o sitios de redes profesionales.

Proceso: Un rastreador descubre primero las páginas de perfiles de empresas relevantes. El scraper luego extrae los patrones de texto específicos correspondientes a direcciones de correo electrónico y números de teléfono de esas páginas.

Valor: Impulsa las cadenas de ventas y marketing con información de contacto fresca y enfocada.

4. Indexación y clasificación de motores de búsqueda (Rastreo)

Objetivo: La función principal de motores de búsqueda principales como Google y Bing.

Proceso: Rastreadores distribuidos de gran tamaño descubren continuamente nuevo contenido. Las páginas descubiertas se pasan a un indexador, que procesa el texto y las almacena en una base de datos masiva para recuperación rápida.

Valor: Hace que la vastedad de internet sea buscable para miles de millones de usuarios.

5. Agregación de contenido y canales de noticias (Rastreo y Scraping)

Objetivo: Crear una plataforma centralizada que extraiga artículos de múltiples fuentes de noticias.

Proceso: Un rastreador monitorea los sitemaps y páginas de categorías de sitios de noticias objetivo. Cuando se encuentra una nueva URL de artículo, un scraper extrae el título del artículo, el texto principal, el autor y la fecha de publicación.

Valor: Impulsa lectores de noticias personalizados y plataformas de análisis de contenido.

6. Investigación de mercado y análisis de sentimiento (Scraping)

Objetivo: Recopilar reseñas y comentarios de usuarios de foros, redes sociales y sitios de comercio electrónico para evaluar la opinión pública sobre un producto.

Proceso: Los scrapers se enfocan en las secciones de reseñas de las páginas de productos, extrayendo el texto y las calificaciones con estrellas. Estos datos se alimentan a modelos de procesamiento de lenguaje natural (NLP) para puntuación de sentimiento.

Valor: Proporciona insights accionables sobre fortalezas y debilidades de un producto directamente desde la voz del consumidor.

7. Detección de cambios en sitios web (Rastreo y Scraping)

Objetivo: Monitorear un conjunto específico de páginas para cambios no autorizados, actualizaciones regulatorias o disponibilidad de stock.

Proceso: Un rastreador visita la URL objetivo en un horario programado. Un scraper extrae un hash del contenido principal de la página. Si el hash cambia, se activa una alerta.

Valor: Esencial para cumplimiento, inteligencia competitiva y seguimiento de inventario.

8. Investigación académica y mapeo de citas (Rastreo)

Objetivo: Mapear la red de citas dentro de un campo de estudio.

Proceso: Un rastreador comienza con un artículo clave y extrae todas las referencias y todos los artículos que lo citan. Sigue estos enlaces para construir un gráfico de influencia académica.

Valor: Ayuda a los investigadores a identificar autores clave y tendencias emergentes en su dominio.

9. Migración de datos y archivado (Scraping)

Objetivo: Extraer todo el contenido de un sitio web antiguo antes de descontinuarlo, o archivar un sitio con fines históricos.

Proceso: Un rastreador identifica todas las URLs en el sitio antiguo. Un scraper extrae sistemáticamente el contenido HTML completo de cada página y lo guarda localmente.

Valor: Preserva datos y contenido valiosos durante la transición de plataformas.

10. Entrenamiento de modelos de aprendizaje automático (Scraping)

Objetivo: Adquirir conjuntos de datos grandes y diversos para entrenar modelos de IA, como reconocimiento de imágenes o modelos de lenguaje.

Proceso: Se despliegan scrapers para recopilar millones de imágenes con sus descripciones, o grandes cantidades de datos de texto de diversas fuentes.

Valor: Proporciona el combustible necesario para desarrollar y perfeccionar tecnologías de IA de vanguardia.

El desafío: Controles de acceso modernos y AWS WAF

A medida que el valor de los datos web continúa aumentando, los sitios web han adoptado mecanismos de seguridad y filtrado de tráfico cada vez más avanzados. Estos incluyen limitación de tasas, verificaciones de reputación de IP y verificación de CAPTCHA, a menudo impuestas a través de Firewalls de Aplicaciones Web (WAF) como AWS WAF. Bajo estos controles, tanto el rastreo a gran escala como la extracción selectiva de datos pueden ser marcados como comportamiento anormal, resultando en solicitudes bloqueadas o interrupciones en las cadenas de datos.

Cuando el tráfico se sospecha que es automatizado, AWS WAF puede emitir un desafío de CAPTCHA, deteniendo el flujo de trabajo hasta que se resuelva. En tales escenarios, las soluciones dedicadas se vuelven esenciales para mantener la continuidad y la confiabilidad de los datos.

CapSolver: La herramienta esencial para la adquisición de datos sin interrupciones

CapSolver es un servicio de resolución de CAPTCHA y anti-robot impulsado por inteligencia artificial que garantiza que sus operaciones de rastreo web y scraping web permanezcan fluidas y eficientes, incluso contra defensas muy fuertes como AWS WAF. Actúa como una capa crítica, resolviendo desafíos en tiempo real para que sus rastreadores y scrapers puedan continuar sin interrupción.

CapSolver ofrece soluciones basadas en tokens y en reconocimiento para AWS WAF, permitiendo a los desarrolladores integrarlas directamente en sus marcos de scraping existentes de Python o Node.js.

Redime tu código de bonificación de CapSolver

¡Aumenta tu presupuesto de automatización instantáneamente!

Usa el código de bonificación CAPN al recargar tu cuenta de CapSolver para obtener un 5% adicional de bonificación en cada recarga — sin límites.

Redímelo ahora en tu Panel de CapSolver

.

Integración de CapSolver para el bypass de AWS WAF

Para demostrar el poder de CapSolver, aquí está cómo integrarlo para resolver un desafío de AWS WAF usando tanto los modos de reconocimiento como de token.

Solución 1: Modo de reconocimiento de AWS WAF (CAPTCHA basado en imagen)

Este modo se usa cuando el WAF presenta un desafío visual (por ejemplo, "Selecciona todas las imágenes con un automóvil").

Pasos de operación del código (Ejemplo en Python):

- Capturar: Tu scraper detecta el desafío de imagen de AWS WAF y captura la imagen.

- Enviar: Envía la imagen a la API de CapSolver usando el tipo de tarea

AwsWafClassification. - Recibir: La IA de CapSolver devuelve las coordenadas o etiquetas de los objetos correctos.

- Resolver: Tu scraper utiliza las coordenadas para simular los clics correctos en la página de desafío.

Tarea de CapSolver (Modo de reconocimiento):

Para parámetros y implementación detallados de la API, consulta la documentación oficial: CapSolver AWS WAF Classification

Solución 2: Modo de token de AWS WAF (Invisible/ página de desafío)

Este modo se usa cuando el WAF requiere un token válido para continuar, a menudo después de una pantalla de carga breve o una verificación invisible.

Pasos de operación del código (Ejemplo en Python):

- Identificar: Tu scraper identifica los parámetros necesarios de la página de desafío (por ejemplo,

host,iv,key,context). - Enviar: Envía estos parámetros a la API de CapSolver usando el tipo de tarea

AwsWaf. - Recibir: CapSolver resuelve el desafío y devuelve un token válido.

- Bypass: Tu scraper inyecta el token recibido en los encabezados o datos del formulario de la solicitud siguiente para evitar el WAF.

Tarea de CapSolver (Modo de token):

Para parámetros y implementación detallados de la API, consulta la documentación oficial: CapSolver AWS WAF Token

Conclusión y llamado a la acción

La distinción entre el rastreo web y el scraping web es clara: el rastreo es el mapa, y el scraping es el tesoro. Ambos son indispensables para las estrategias de datos modernas, ya sea que seas un profesional de SEO asegurando la descubrimiento o un científico de datos construyendo una plataforma de inteligencia de mercado.

Sin embargo, el uso creciente de sistemas anti-robot avanzados como AWS WAF significa que incluso los flujos de trabajo de rastreo y scraping más bien diseñados pueden fallar. Para mantener un alto tiempo de actividad y precisión de datos, necesitas una solución confiable.

CapSolver proporciona la capa esencial de defensa contra estos desafíos, asegurando que tu flujo de datos permanezca ininterrumpido. Deja de perder tiempo resolviendo manualmente CAPTCHA o lidiando con prohibiciones de IP.

¿Listo para construir una cadena de datos robusta e ininterrumpida?

- Empieza tu viaje: Visita el sitio web de CapSolver para explorar todas sus soluciones anti-bot.

- Empieza de inmediato: Regístrate para tu prueba gratuita en el Dashboard de CapSolver.

Sitio web oficial de CapSolver

Dashboard de CapSolver

Preguntas frecuentes (FAQ)

P1: ¿Es ilegal el rastreo de web o el scraping de web?

Ni el rastreo de web ni el scraping de web son inherentemente ilegales. La legalidad depende de qué escaneas y cómo lo haces. Debes respetar el archivo robots.txt, evitar escanear datos privados o protegidos por derechos de autor y cumplir con los términos de servicio. Un rastreo excesivo o agresivo que afecte el rendimiento de un sitio web puede considerarse ilegal o poco ético.

P2: ¿Puedo hacer scraping de web sin rastreo de web?

Sí, puedes. Si ya tienes una lista de URLs específicas (por ejemplo, una lista de páginas de productos de una base de datos), puedes realizar el scraping directamente en esas páginas sin necesidad de rastrear primero todo el sitio para descubrirlas. El rastreo solo es necesario para el descubrimiento.

P3: ¿Cómo ayuda CapSolver con el rastreo de web y el scraping de web?

CapSolver desempeña un papel clave en la resolución de desafíos de acceso que interrumpen ambos flujos de trabajo. En rastreos a gran escala, el alto volumen de solicitudes puede activar la verificación de CAPTCHA debido al límite de velocidad. En el scraping dirigido, un intento de extracción puede activar un desafío de AWS WAF. CapSolver procesa estas verificaciones en tiempo real, permitiendo que ambos, la fase de descubrimiento (rastreo) y la fase de extracción (scraping), continúen sin interrupciones.

P4: ¿Cuál es la principal diferencia entre un raspador simple y un marco de rastreador completo como Scrapy?

Un raspador simple (por ejemplo, usando requests y BeautifulSoup) es típicamente un solo script diseñado para extraer datos de una sola página o de una pequeña lista conocida de URLs. Un marco de rastreador completo como Scrapy está diseñado para rastrear web a gran escala y distribuido. Se encarga del descubrimiento de enlaces, programación de solicitudes, reintentos, rotación de proxies y gestión de tuberías, lo que lo hace adecuado para mapear todo un sitio web.

P5: ¿Es el rastreo de web solo para motores de búsqueda?

No. Aunque los motores de búsqueda son los usuarios más famosos del rastreo de web, también es utilizado por herramientas de SEO para auditorías de sitios, por investigadores académicos para mapear redes de citas y por agregadores de contenido para descubrir nuevos artículos. Cualquier tarea que requiera el descubrimiento sistemático de enlaces y páginas se beneficia del rastreo de web.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Top 10 Scrapers sin código para usar en 2026

Una lista curada de las mejores herramientas de scraping web sin código para usar en 2026. Comparar scrapers con inteligencia artificial, plataformas visuales de punto y clic, precios, ventajas y desventajas, y casos de uso del mundo real.

Adélia Cruz

27-Jan-2026

Bloqueos de IP en 2026: Cómo funcionan y Formas prácticas de evadirlos

Aprende cómo evitar el bloqueo de IP en 2026 con nuestro guía completa. Descubre técnicas modernas de bloqueo de IP y soluciones prácticas como proxies residenciales y resolutores de CAPTCHA.

Rajinder Singh

26-Jan-2026

Cómo resolver Captcha en Maxun con integración de CapSolver

Una guía práctica para integrar CapSolver con Maxun para el scraping de web en el mundo real. Aprende cómo manejar reCAPTCHA, Cloudflare Turnstile y sitios protegidos por CAPTCHA utilizando flujos de trabajo de pre-autenticación y robot.

Adélia Cruz

21-Jan-2026

Cómo resolver Captcha en Browser4 con integración de CapSolver

Automatización de Browser4 con alta capacidad de procesamiento combinada con CapSolver para el manejo de desafíos CAPTCHA en la extracción de datos web a gran escala.

Aloísio Vítor

21-Jan-2026

¿Qué es un bot de scraping y cómo construir uno

Aprende qué es un bot de raspado y cómo construir uno para la extracción automatizada de datos. Descubre las mejores herramientas, técnicas de navegación segura y prácticas éticas de raspado.

Emma Foster

15-Jan-2026

Scrapy vs. Selenium: ¿Cuál es el mejor para tu proyecto de raspado web?

Descubre las fortalezas y diferencias entre Scrapy y Selenium para el web scraping. Aprende qué herramienta se adapta mejor a tu proyecto y cómo manejar desafíos como los CAPTCHAs.

Ethan Collins

14-Jan-2026