Resolver errores 403 Prohibido al rastrear sitios web con Python

Lucas Mitchell

Automation Engineer

13-Jan-2026

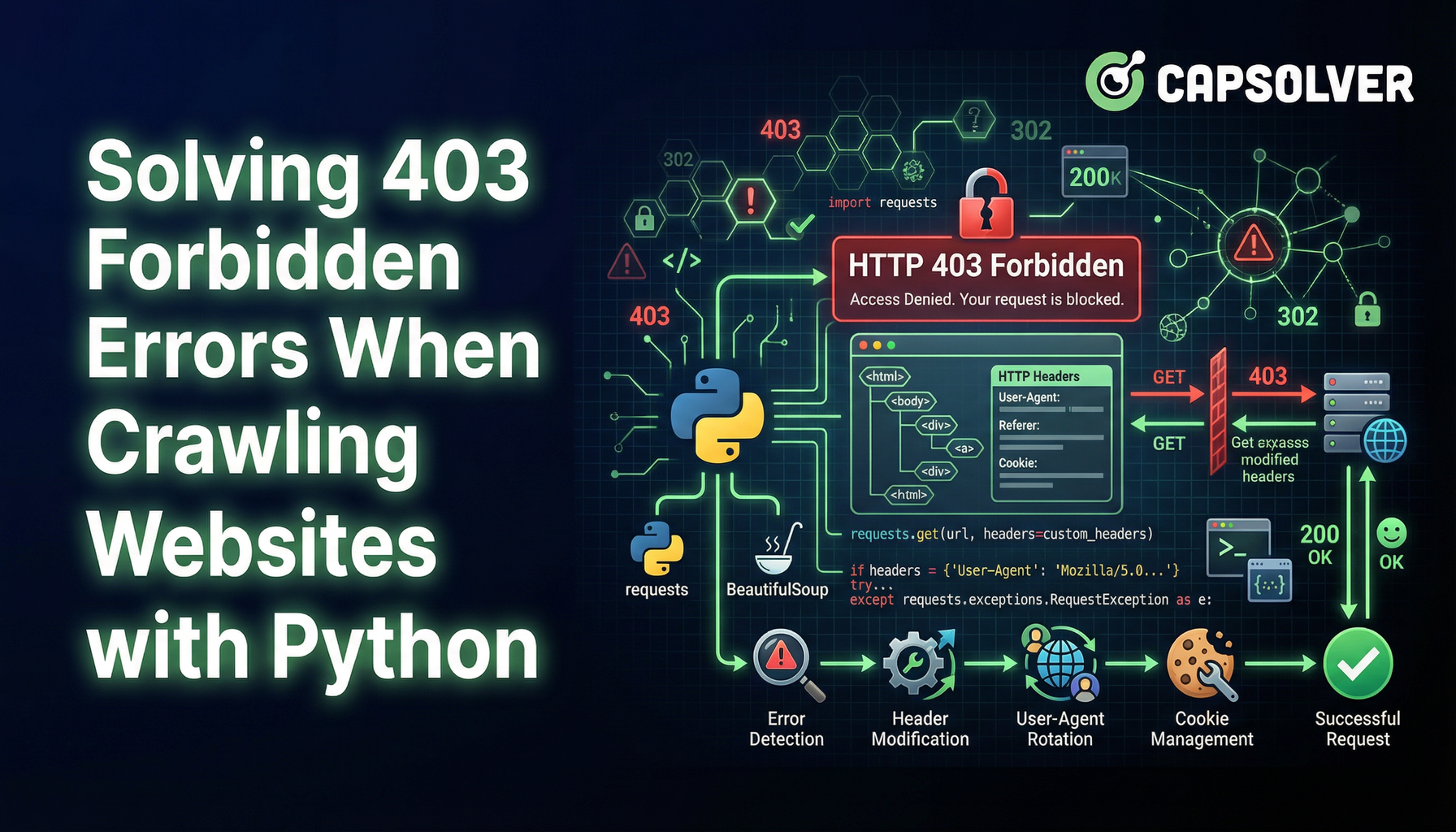

El scraping web es una técnica invaluable para extraer datos de sitios web. Sin embargo, encontrar un error 403 Prohibido puede ser un gran obstáculo. Este error indica que el servidor entiende su solicitud, pero se niega a autorizarla. A continuación, le mostramos cómo navegar alrededor de este problema y continuar con su tarea de scraping web.

Entendiendo el error 403 Prohibido

Un error 403 Prohibido ocurre cuando un servidor niega el acceso al recurso solicitado. Esto puede suceder por varias razones, incluyiendo:

¿Luchando con el fracaso repetido para resolver completamente el irritante captcha? Descubra la resolución automática de captcha con la tecnología de desbloqueo web impulsada por inteligencia artificial de CapSolver!

Redimir tu código de bonificación de CapSolver

Aumente su presupuesto de automatización instantáneamente!

Use el código de bonificación CAPN al recargar su cuenta de CapSolver para obtener un 5% adicional en cada recarga — sin límites.

Redímalo ahora en su Panel de CapSolver

.

- Bloqueo de IP: Los servidores pueden bloquear direcciones IP si detectan solicitudes inusuales o de alto volumen.

- Restricciones de User-Agent: Algunos sitios web restringen el acceso según la cadena User-Agent, que identifica el navegador y el dispositivo que realiza la solicitud.

- Autenticación requerida: Acceder a ciertas páginas puede requerir credenciales de inicio de sesión o una clave de API.

Técnicas para eludir errores 403

1. Rotar direcciones IP

Los servidores suelen bloquear solicitudes desde la misma dirección IP después de un cierto límite. Usar un conjunto de servidores proxy para rotar direcciones IP puede ayudar a evitar esto. Servicios como Nstproxy o Bright Data ofrecen soluciones de proxy rotatorio.

python

import requests

proxies = {

"http": "http://your_proxy_here",

"https": "http://your_proxy_here",

}

response = requests.get("http://example.com", proxies=proxies)2. Usar un User-Agent realista

Los servidores web pueden detectar y bloquear solicitudes con cadenas de User-Agent sospechosas. Falsificar una cadena de User-Agent para imitar un navegador regular puede ayudar a evitar la detección.

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. Implementar limitación de solicitudes

Enviar demasiadas solicitudes en un corto período puede activar límites de velocidad. Introducir demoras entre solicitudes puede ayudar a permanecer en el radar.

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # Demora de 5 segundos4. Manejar la autenticación

Algunos recursos requieren autenticación. Usar cookies o claves de API para solicitudes autenticadas puede eludir las restricciones de acceso.

python

cookies = {

"session": "your_session_cookie_here"

}

response = requests.get("http://example.com", cookies=cookies)5. Utilizar navegadores sin cabeza

Navegadores sin cabeza como Puppeteer o Selenium simulan interacciones reales de usuarios y pueden ayudar a eludir medidas anti-scraping sofisticadas.

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. Superar los desafíos de CAPTCHA

Además de errores 403, los raspadores web suelen encontrar CAPTCHAs, diseñados para bloquear el acceso automatizado. CAPTCHAs como reCAPTCHA requieren resolver desafíos visuales o interactivos para demostrar que la solicitud es realizada por un humano.

Para resolver estos desafíos, puede usar servicios como CapSolver que ofrecen soluciones para resolver CAPTCHAs automáticamente. CapSolver admite diversos tipos de CAPTCHA y ofrece integración sencilla con herramientas de scraping web.

Conclusión

Encontrar un error 403 Prohibido durante el scraping web puede ser frustrante, pero entender las razones detrás de él y emplear las técnicas adecuadas puede ayudarle a superar este obstáculo. Ya sea rotar IPs, usar cadenas de User-Agent realistas, limitar solicitudes, manejar la autenticación o utilizar navegadores sin cabeza, estos métodos pueden ayudarle a continuar extrayendo datos valiosos de la web.

Siguiendo estas estrategias, puede gestionar y eludir eficazmente errores 403, asegurando un scraping web más fluido y exitoso.

Preguntas frecuentes

1. ¿Es legal eludir un error 403 Prohibido en el scraping web?

Eludir un error 403 no es inherentemente ilegal, pero la legalidad depende de los términos de servicio del sitio web, las reglas de robots.txt y las leyes locales. Raspar datos accesibles públicamente para fines legítimos suele estar permitido, mientras que eludir autenticación, barreras de pago o restricciones explícitas puede violar términos o regulaciones. Siempre revise las políticas del sitio objetivo antes de raspar.

2. ¿Por qué aún obtengo un error 403 incluso al usar proxies y un User-Agent?

Un error 403 puede persistir si el sitio web utiliza sistemas avanzados de detección de bots como análisis de comportamiento, fingerprinting o desafíos de CAPTCHA. En estos casos, la rotación simple de IPs y la falsificación de User-Agent pueden no ser suficientes. Combinar limitación de solicitudes, gestión de sesiones, navegadores sin cabeza y servicios de resolución de CAPTCHA como CapSolver puede mejorar significativamente las tasas de éxito.

3. ¿Cuál es el método más confiable para evitar errores 403 en scraping a gran escala?

Para scraping a gran escala, el enfoque más confiable es una estrategia de capas: proxies de alta calidad con direcciones residenciales o móviles rotatorios, huellas digitales de navegador realistas, tasas de solicitud controladas, manejo adecuado de la autenticación y resolución automática de CAPTCHA. Usar navegadores sin cabeza con soluciones de desbloqueo web basadas en inteligencia artificial ayuda a imitar cercanamente el comportamiento de un usuario real y reduce la probabilidad de bloqueos repetidos de 403.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Cómo resolver Captcha en Nanobot con CapSolver

Automatiza la resolución de CAPTCHA con Nanobot y CapSolver. Utiliza Playwright para resolver reCAPTCHA y Cloudflare autónomamente.

Adélia Cruz

26-Feb-2026

Datos como Servicio (DaaS): ¿Qué es y por qué es importante en 2026

Comprender Datos como Servicio (DaaS) en 2026. Explora sus beneficios, casos de uso y cómo transforma los negocios con insights en tiempo real y escalabilidad.

Sora Fujimoto

12-Feb-2026

Cómo arreglar errores comunes de raspado de web en 2026

Dominar la resolución de diversos errores de scrapers web como 400, 401, 402, 403, 429, 5xx y Cloudflare 1001 en 2026. Aprender estrategias avanzadas para la rotación de IPs, encabezados y limitación de tasa adaptativa con CapSolver.

Emma Foster

05-Feb-2026

Cómo resolver un Captcha en RoxyBrowser con la integración de CapSolver

Integrar CapSolver con RoxyBrowser para automatizar tareas del navegador y evadir reCAPTCHA, Turnstile y otros CAPTCHAs.

Emma Foster

04-Feb-2026

Cómo resolver captcha en EasySpider con la integración de CapSolver

EasySpider es una herramienta visual de scraping web y automatización de navegadores, y cuando se combina con CapSolver, puede resolver de manera confiable los CAPTCHAs como reCAPTCHA v2 y Cloudflare Turnstile, facilitando la extracción de datos automatizada sin interrupciones en todo tipo de sitios web.

Adélia Cruz

04-Feb-2026

Cómo resolver reCAPTCHA v2 en Relevance AI con integración de CapSolver

Construye una herramienta de Relevance AI para resolver reCAPTCHA v2 utilizando CapSolver. Automatiza los envíos de formularios a través de API sin automatización de navegadores.

Aloísio Vítor

03-Feb-2026