Crawler de Web en Python y Cómo evitar ser bloqueado al hacer crawling web

Adélia Cruz

Neural Network Developer

19-Nov-2025

Internet es un vasto repositorio de información, que va desde actualizaciones de noticias hasta puntos de datos especializados ocultos en profundidad dentro de los sitios web. Extraer estos datos manualmente es poco práctico, lo que hace que el crawling web brille. El crawling web, también conocido como scraping web, es el proceso automatizado de navegar por sitios web, extraer datos y almacenarlos para diversos propósitos como análisis de datos, investigación de mercado y agregación de contenido.

Sin embargo, el paisaje del crawling web no está exento de desafíos. Los sitios web implementan técnicas sofisticadas para detectar y bloquear crawlers automatizados, desde limitaciones de velocidad simples hasta desafíos avanzados de CAPTCHA. Como desarrollador de crawlers web, navegar eficazmente estos desafíos es clave para mantener procesos de extracción de datos confiables.

👌 Índice

- Entendiendo los Crawl de Web

- Un Crawler Web en Python

- Cómo Evitar Ser Bloqueado al Hacer Web Crawling

- Conclusión

Entendiendo el Crawler Web

¿Qué es un Crawler Web?

Un crawler web, a menudo comparado con un explorador digital diligente, recorre incansablemente las vastas extensiones de Internet. Su misión: explorar sistemáticamente los sitios web, indexando todo lo que encuentra. Originalmente diseñados para motores de búsqueda para crear resultados de búsqueda rápidos, estos bots han evolucionado. Ahora, impulsan todo, desde aplicaciones de cupones hasta herramientas de SEO, recopilando títulos, imágenes, palabras clave y enlaces mientras avanzan. Más allá del indexado, pueden extraer contenido, rastrear cambios en páginas web y hasta minar datos. Conoce a la araña web: recorriendo la World Wide Web, tejiendo una red digital de información.

¿Cómo funciona un Crawler Web?

Los crawlers web operan navegando sistemáticamente por páginas web, comenzando desde un conjunto predefinido y siguiendo enlaces hipertextuales para descubrir nuevas páginas. Antes de iniciar un crawling, estos bots primero consultan el archivo robots.txt del sitio, que establece directrices definidas por los propietarios del sitio sobre qué páginas pueden ser rastreadas y qué enlaces pueden seguirse.

Dada la vastedad de Internet, los crawlers priorizan ciertas páginas según reglas establecidas. Pueden favorecer páginas con numerosos enlaces externos apuntando a ellas, mayores volúmenes de tráfico o mayor autoridad de marca. Esta estrategia de priorización se basa en la suposición de que las páginas con tráfico y enlaces significativos son más propensas a ofrecer contenido autoritario y valioso buscado por los usuarios. Los algoritmos también ayudan a los crawlers a evaluar la relevancia del contenido y la calidad de los enlaces encontrados en cada página.

Durante su exploración, los crawlers registran cuidadosamente las etiquetas meta de cada sitio, que proporcionan metadatos esenciales y información de palabras clave. Este dato desempeña un papel crucial en cómo los motores de búsqueda clasifican y muestran páginas en resultados de búsqueda, ayudando a la navegación y recuperación de información de los usuarios.

Un Crawler Web en Python

Un crawler web en Python es un script automatizado diseñado para navegar por Internet de manera metódica, comenzando desde URLs predefinidas. Opera realizando solicitudes HTTP a servidores web, recuperando contenido HTML y luego analizando este contenido utilizando bibliotecas como BeautifulSoup o lxml. Estas bibliotecas permiten al crawler extraer información relevante como títulos de página, enlaces, imágenes y texto.

La versatilidad de Python para manejar solicitudes web y analizar HTML lo hace particularmente adecuado para desarrollar crawlers web. Los crawlers suelen seguir un conjunto de reglas definidas en el archivo robots.txt de un sitio, que especifica qué partes del sitio están abiertas para el rastreo y cuáles deben excluirse. Esta adherencia ayuda a mantener prácticas éticas de rastreo y respetar las preferencias de los propietarios del sitio.

Además de indexar páginas para motores de búsqueda, los crawlers web en Python se utilizan para diversos propósitos, incluida la minería de datos, la agregación de contenido, el monitoreo de cambios en sitios web y hasta pruebas automatizadas. Al seguir enlaces dentro de las páginas, los crawlers navegan a través de sitios web, construyendo un mapa de páginas interconectadas que imitan la estructura de la web. Este proceso les permite recopilar datos de una amplia gama de fuentes de manera sistemática, ayudando en tareas como análisis de competencia, investigación de mercado y recuperación de información.

Creando un Crawler Web en Python

Antes de sumergirse en la creación de un crawler web, es crucial configurar su entorno de desarrollo con las herramientas y bibliotecas necesarias.

Requisitos previos

- Python: Instale Python 3.x desde python.org.

- Biblioteca Requests: Para realizar solicitudes HTTP.

- Beautiful Soup: Para analizar documentos HTML y XML.

- Selenium (opcional): Para manejar contenido renderizado por JavaScript y CAPTCHAS.

bash

pip install requests beautifulsoup4 seleniumCreando un Crawler Web Simple

Creemos un crawler web básico usando Python y demostremos cómo extraer enlaces y texto de una página web.

python

import requests

from bs4 import BeautifulSoup

def simple_crawler(url):

# Enviar solicitud HTTP

response = requests.get(url)

# Verificar si la solicitud fue exitosa

if response.status_code == 200:

# Analizar el contenido con BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

# Ejemplo: Extraer todos los enlaces de la página

links = soup.find_all('a', href=True)

for link in links:

print(link['href'])

# Ejemplo: Extraer texto de elementos específicos

headings = soup.find_all(['h1', 'h2', 'h3'])

for heading in headings:

print(heading.text)

else:

print(f"Fallo al recuperar contenido de {url}")

# Ejemplo de uso

simple_crawler('https://example.com')Cómo Evitar Ser Bloqueado al Hacer Web Crawling

Al iniciar el crawling web en Python, navegar alrededor de los bloqueos se convierte en un desafío crítico. Numerosos sitios web fortalecen sus defensas con medidas anti-bot, diseñadas para detectar y frustrar herramientas automatizadas, bloqueando así el acceso a sus páginas.

Para superar estos obstáculos, considere implementar las siguientes estrategias:

1. Manejo de CAPTCHAS

Las CAPTCHAS son un mecanismo de defensa común contra los crawlers automatizados. Desafían a los usuarios para probar que son humanos completando tareas como identificar objetos o ingresar texto. La mejor estrategia para manejar CAPTCHAS es incorporar un servicio confiable de resolución de CAPTCHA como CapSolver en su flujo de trabajo de scraping. CapSolver proporciona APIs y herramientas para resolver programáticamente diversos tipos de CAPTCHAS, permitiendo una integración fluida con sus scripts de Python. Un breve guía rápida a continuación muestra:

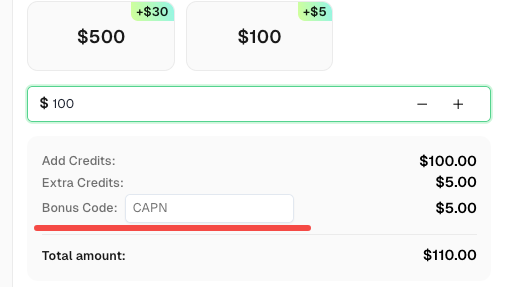

Redimir tu Código de Bonificación de CapSolver

No pierdas la oportunidad de optimizar aún más tus operaciones. Usa el código de bonificación CAPN al recargar tu cuenta de CapSolver y recibe un 5% adicional en cada recarga, sin límites. Visita CapSolver para redimir tu bonificación ahora!

Cómo Resolver Cualquier CAPTCHA con Capsolver usando Python:

Requisitos previos

- Un proxy funcional

- Python instalado

- Clave de API de CapSolver

🤖 Paso 1: Instalar Paquetes Necesarios

Ejecuta los siguientes comandos para instalar los paquetes requeridos:

pip install capsolver

Aquí hay un ejemplo de reCAPTCHA v2:

👨💻 Código Python para resolver reCAPTCHA v2 con tu proxy

Aquí hay un script de Python para lograr la tarea:

python

import capsolver

# Considera usar variables de entorno para información sensible

PROXY = "http://username:password@host:port"

capsolver.api_key = "Tu Clave de API de Capsolver"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("Resolviendo reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solución: ", solution)

if __name__ == "__main__":

main()👨💻 Código Python para resolver reCAPTCHA v2 sin proxy

Aquí hay un script de Python para lograr la tarea:

python

import capsolver

# Considera usar variables de entorno para información sensible

capsolver.api_key = "Tu Clave de API de Capsolver"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("Resolviendo reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solución: ", solution)

if __name__ == "__main__":

main()2. Evitando Bloqueos de IP y Límites de Velocidad

Los sitios web suelen imponer restricciones sobre el número de solicitudes que un crawler puede realizar dentro de un período determinado para prevenir sobrecarga y abuso.

Estrategias para Evitar la Detección:

- Rotar Direcciones IP: Usar servidores proxy o VPN para cambiar direcciones IP y evitar activar límites de velocidad.

- Respetar Robots.txt: Verificar y cumplir con las reglas especificadas en el archivo robots.txt de un sitio para evitar ser bloqueado.

- Políticas de Cortesía: Implementar retrasos entre solicitudes (retraso de crawling) para simular el comportamiento de navegación humana.

Conclusión

El crawling web empodera a empresas y investigadores para acceder a grandes cantidades de datos de manera eficiente. Sin embargo, navegar los desafíos de detección automatizada y bloqueo requiere planificación estratégica y cumplimiento de estándares éticos. Al aprovechar las bibliotecas robustas de Python e implementar mejores prácticas, los desarrolladores pueden construir crawlers resistentes capaces de extraer insights valiosos mientras respetan los límites establecidos por los sitios web.

En esencia, dominar el crawling web implica no solo habilidades técnicas, sino también un conocimiento profundo de la etiqueta web y consideraciones legales. Con estas herramientas y estrategias a tu disposición, puedes aprovechar el poder del crawling web de manera responsable y efectiva en tus proyectos.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

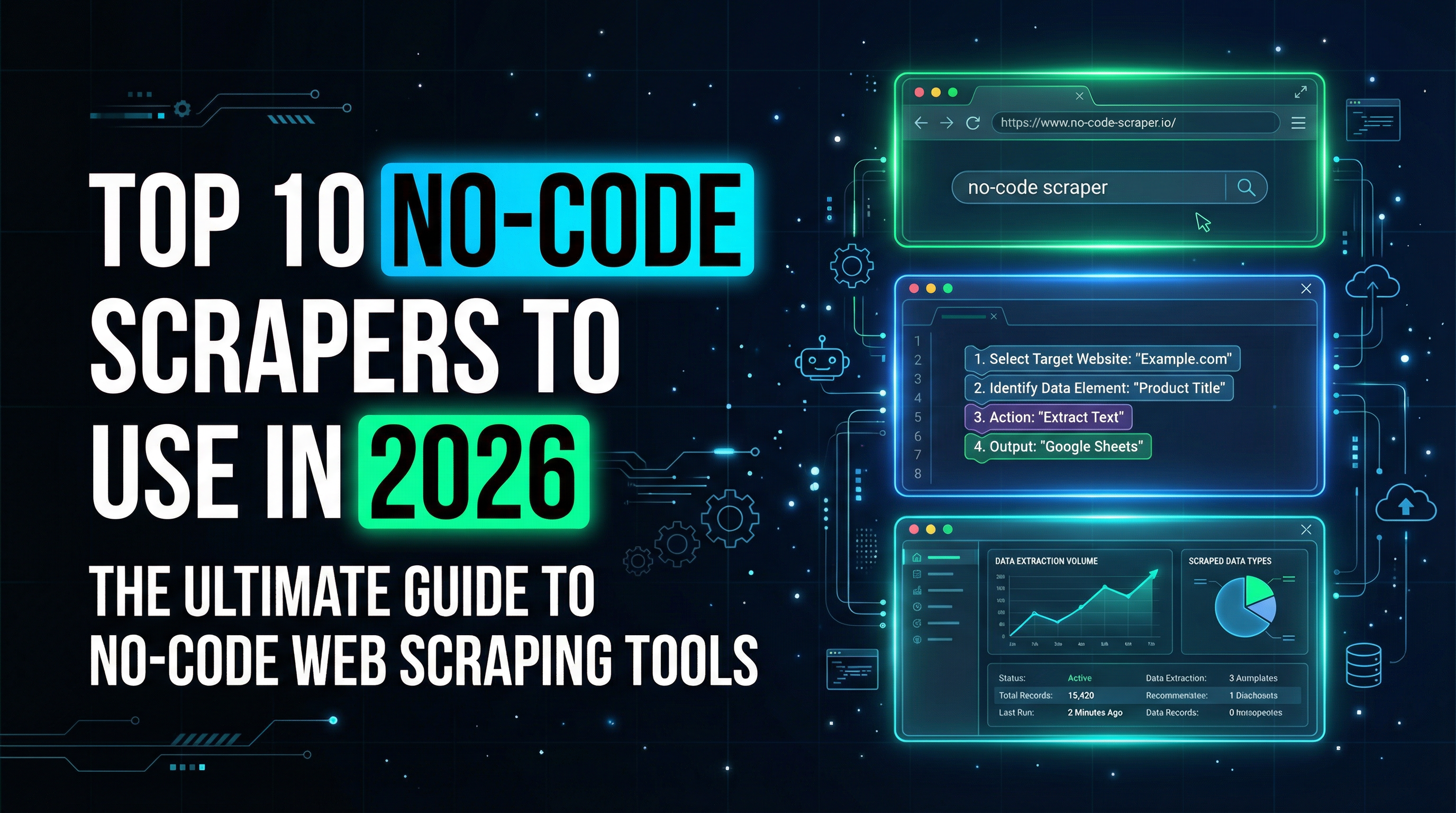

Top 10 Scrapers sin código para usar en 2026

Una lista curada de las mejores herramientas de scraping web sin código para usar en 2026. Comparar scrapers con inteligencia artificial, plataformas visuales de punto y clic, precios, ventajas y desventajas, y casos de uso del mundo real.

Adélia Cruz

27-Jan-2026

Bloqueos de IP en 2026: Cómo funcionan y Formas prácticas de evadirlos

Aprende cómo evitar el bloqueo de IP en 2026 con nuestro guía completa. Descubre técnicas modernas de bloqueo de IP y soluciones prácticas como proxies residenciales y resolutores de CAPTCHA.

Rajinder Singh

26-Jan-2026

Cómo resolver Captcha en Maxun con integración de CapSolver

Una guía práctica para integrar CapSolver con Maxun para el scraping de web en el mundo real. Aprende cómo manejar reCAPTCHA, Cloudflare Turnstile y sitios protegidos por CAPTCHA utilizando flujos de trabajo de pre-autenticación y robot.

Adélia Cruz

21-Jan-2026

Cómo resolver Captcha en Browser4 con integración de CapSolver

Automatización de Browser4 con alta capacidad de procesamiento combinada con CapSolver para el manejo de desafíos CAPTCHA en la extracción de datos web a gran escala.

Aloísio Vítor

21-Jan-2026

¿Qué es un bot de scraping y cómo construir uno

Aprende qué es un bot de raspado y cómo construir uno para la extracción automatizada de datos. Descubre las mejores herramientas, técnicas de navegación segura y prácticas éticas de raspado.

Emma Foster

15-Jan-2026

Scrapy vs. Selenium: ¿Cuál es el mejor para tu proyecto de raspado web?

Descubre las fortalezas y diferencias entre Scrapy y Selenium para el web scraping. Aprende qué herramienta se adapta mejor a tu proyecto y cómo manejar desafíos como los CAPTCHAs.

Ethan Collins

14-Jan-2026