Crawler da Web em Python e Como Evitar Ser Bloqueado Durante o Crawl da Web

Adélia Cruz

Neural Network Developer

19-Nov-2025

A internet é um vasto repositório de informações, que vai desde atualizações de notícias até pontos de dados especializados escondidos profundamente em sites. Extrair esses dados manualmente é inviável, o que é onde o web crawling brilha. Web crawling, também conhecido como web scraping, é o processo automatizado de navegação por sites, extração de dados e armazenamento para diversos fins, como análise de dados, pesquisa de mercado e agregação de conteúdo.

No entanto, o cenário do web crawling não está isento de desafios. Os sites utilizam técnicas sofisticadas para detectar e bloquear crawlers automatizados, desde limitação de taxa simples até desafios avançados de CAPTCHA. Como desenvolvedor de web crawlers, navegar efetivamente por esses desafios é fundamental para manter processos confiáveis de extração de dados.

👌 Índice

- Entendendo os Web Crawlers

- Um Web Crawler em Python

- Como Evitar Ser Bloqueado ao Fazer Web Crawling

- Conclusão

Entendendo o Web Crawler

O que é um Web Crawler?

Um web crawler, frequentemente comparado a um explorador digital dedicado, percorre diligentemente os vastos territórios da internet. Seu objetivo? Explorar sites de forma sistemática, indexando tudo no seu caminho. Originalmente criado para motores de busca para criar resultados de pesquisa rápidos, esses bots evoluíram. Hoje, eles alimentam desde aplicativos de cupons até ferramentas de SEO, coletando títulos, imagens, palavras-chave e links enquanto avançam. Além do indexamento, eles podem extrair conteúdo, rastrear mudanças em páginas da web e até minerar dados. Conheça o web spider: percorrendo a World Wide Web, tecendo uma rede digital de informações.

Como o Web Crawler funciona?

Web crawlers operam navegando sistematicamente por páginas da web, começando com um conjunto pré-definido e seguindo hiperlinks para descobrir novas páginas. Antes de iniciar uma varredura, esses bots primeiro consultam o arquivo robots.txt de um site, que estabelece diretrizes definidas pelos proprietários do site sobre quais páginas podem ser rastreadas e quais links podem ser seguidos.

Dado o vasto alcance da internet, os web crawlers priorizam certas páginas com base em regras estabelecidas. Eles podem favorecer páginas com muitos links externos apontando para elas, maiores volumes de tráfego ou maior autoridade da marca. Essa estratégia de priorização está enraizada na suposição de que páginas com tráfego e links significativos são mais propensas a oferecer conteúdo autoritativo e valioso procurado pelos usuários. Algoritmos também ajudam os crawlers a avaliar a relevância do conteúdo e a qualidade dos links encontrados em cada página.

Durante sua exploração, os web crawlers registram cuidadosamente as tags meta de cada site, que fornecem metadados essenciais e informações sobre palavras-chave. Esses dados desempenham um papel crucial em como os motores de busca classificam e exibem páginas nos resultados de busca, ajudando na navegação dos usuários e recuperação de informações.

Um Web Crawler em Python

Um web crawler em Python é um script automatizado projetado para navegar pela internet de forma sistemática, começando com URLs pré-definidas. Ele opera fazendo solicitações HTTP aos servidores da web, recuperando conteúdo HTML e, em seguida, analisando esse conteúdo usando bibliotecas como BeautifulSoup ou lxml. Essas bibliotecas permitem que o crawler extraia informações relevantes, como títulos de páginas, links, imagens e texto.

A versatilidade do Python no tratamento de solicitações da web e na análise de HTML o torna particularmente adequado para o desenvolvimento de web crawlers. Os crawlers geralmente seguem um conjunto de regras definidas no arquivo robots.txt de um site, que especifica quais partes do site estão abertas para rastreamento e quais devem ser excluídas. Essa aderência ajuda a manter práticas éticas de rastreamento e respeitar as preferências dos proprietários do site.

Além de indexar páginas para motores de busca, os web crawlers em Python são usados para diversos fins, incluindo mineração de dados, agregação de conteúdo, monitoramento de mudanças em sites e até testes automatizados. Ao seguir links dentro das páginas, os crawlers navegam por sites, construindo um mapa de páginas interligadas que imitam a estrutura da web. Esse processo permite que eles coletem dados de forma sistemática de uma ampla gama de fontes, auxiliando em tarefas como análise de concorrência, pesquisa de mercado e recuperação de informações.

Construindo um Web Crawler em Python

Antes de mergulhar na construção de um web crawler, é essencial configurar seu ambiente de desenvolvimento com as ferramentas e bibliotecas necessárias.

Requisitos

- Python: Instale o Python 3.x em python.org.

- Biblioteca Requests: Para fazer solicitações HTTP.

- Beautiful Soup: Para analisar documentos HTML e XML.

- Selenium (opcional): Para lidar com conteúdo renderizado por JavaScript e CAPTCHAs.

bash

pip install requests beautifulsoup4 seleniumConstruindo um Web Crawler Simples

Vamos criar um crawler básico usando Python e demonstrar como extrair links e texto de uma página da web.

python

import requests

from bs4 import BeautifulSoup

def simple_crawler(url):

# Enviar solicitação HTTP

response = requests.get(url)

# Verificar se a solicitação foi bem-sucedida

if response.status_code == 200:

# Analisar o conteúdo com o BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

# Exemplo: extrair todos os links da página

links = soup.find_all('a', href=True)

for link in links:

print(link['href'])

# Exemplo: extrair texto de elementos específicos

títulos = soup.find_all(['h1', 'h2', 'h3'])

for título in títulos:

print(título.text)

else:

print(f"Falha ao recuperar conteúdo de {url}")

# Exemplo de uso

simple_crawler('https://example.com')Como Evitar Ser Bloqueado ao Fazer Web Crawling

Ao iniciar o web crawling em Python, navegar ao redor de bloqueios torna-se um desafio crítico. Muitos sites reforçam suas defesas com medidas anti-bot, projetadas para detectar e impedir ferramentas automatizadas, bloqueando assim o acesso às suas páginas.

Para superar esses obstáculos, considere implementar as seguintes estratégias:

1. Lidando com CAPTCHAs

CAPTCHAs são um mecanismo de defesa comum contra crawlers automatizados. Eles desafiam os usuários a provar que são humanos completando tarefas como identificar objetos ou digitar texto. A melhor estratégia para lidar com CAPTCHAs é incorporar um serviço confiável de resolução de CAPTCHA, como o CapSolver, ao seu fluxo de trabalho de scraping da web, o que pode agilizar o processo de resolução desses desafios. O CapSolver fornece APIs e ferramentas para resolver programaticamente diversos tipos de CAPTCHAs, permitindo integração sem problemas com seus scripts em Python. Um guia rápido abaixo para mostrar:

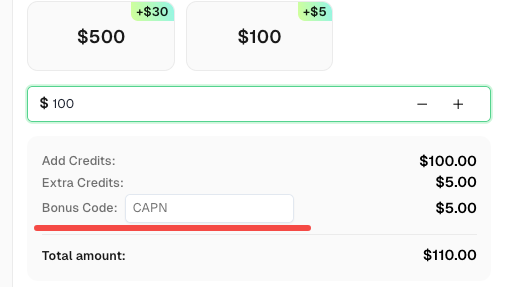

Resgate seu código promocional do CapSolver

Não perca a oportunidade de otimizar ainda mais suas operações! Use o código promocional CAPN ao recarregar sua conta do CapSolver e receba um bônus adicional de 5% em cada recarga, sem limites. Acesse o CapSolver para resgatar seu bônus agora!

Como resolver qualquer CAPTCHA com o Capsolver usando Python:

Requisitos prévios

- Um proxy funcional

- Python instalado

- Chave de API do CapSolver

🤖 Passo 1: Instalar os Pacotes Necessários

Execute os seguintes comandos para instalar os pacotes necessários:

pip install capsolver

Aqui está um exemplo de reCAPTCHA v2:

👨💻 Código Python para resolver reCAPTCHA v2 com seu proxy

Aqui está um script de exemplo em Python para realizar a tarefa:

python

import capsolver

# Considere usar variáveis de ambiente para informações sensíveis

PROXY = "http://username:password@host:port"

capsolver.api_key = "Sua chave de API do Capsolver"

PAGE_URL = "URL_DA_PÁGINA"

PAGE_KEY = "CHAVE_DO_SITE"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("Resolvendo reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solução: ", solution)

if __name__ == "__main__":

main()👨💻 Código Python para resolver reCAPTCHA v2 sem proxy

Aqui está um script de exemplo em Python para realizar a tarefa:

python

import capsolver

# Considere usar variáveis de ambiente para informações sensíveis

capsolver.api_key = "Sua chave de API do Capsolver"

PAGE_URL = "URL_DA_PÁGINA"

PAGE_KEY = "CHAVE_DO_SITE"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("Resolvendo reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solução: ", solution)

if __name__ == "__main__":

main()2. Evitando Banimentos de IP e Limites de Taxa

Os sites frequentemente impõem restrições ao número de solicitações que um crawler pode fazer em um determinado período para evitar sobrecarga e abuso.

Estratégias para Evitar Detecção:

- Rotacionar Endereços IP: Use servidores proxy ou VPNs para mudar endereços IP e evitar disparar limites de taxa.

- Respeitar o robots.txt: Verifique e siga as regras especificadas no arquivo

robots.txtde um site para evitar ser bloqueado. - Políticas de Cortesia: Implemente pausas entre solicitações (tempo de varredura) para simular o comportamento de navegação humana.

Conclusão

O web crawling permite que empresas e pesquisadores acessem grandes volumes de dados de forma eficiente. No entanto, navegar pelos desafios da detecção automatizada e bloqueio requer planejamento estratégico e aderência aos padrões éticos. Ao utilizar as robustas bibliotecas do Python e implementar melhores práticas, os desenvolvedores podem construir crawlers resistentes capazes de extrair insights valiosos, respeitando os limites estabelecidos pelos sites.

Essencialmente, dominar o web crawling envolve não apenas expertise técnica, mas também um entendimento aguçado sobre etiqueta da web e considerações legais. Com essas ferramentas e estratégias à disposição, você pode aproveitar o poder do web crawling de forma responsável e eficaz em seus projetos.

Declaração de Conformidade: As informações fornecidas neste blog são apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas soluções de resolução de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos serviços. Para mais informações, visite nossos Termos de Serviço e Política de Privacidade.

Mais

Dados como Serviço (DaaS): O que é e por que importa em 2026

Entenda Dados como Serviço (DaaS) em 2026. Descubra seus benefícios, casos de uso e como transforma os negócios com visões em tempo real e escalabilidade.

Ethan Collins

12-Feb-2026

Como corrigir erros comuns de raspagem da web em 2026

Dominar a correção de diversos erros de raspagem de web, como 400, 401, 402, 403, 429, 5xx e 1001 do Cloudflare em 2026. Aprenda estratégias avançadas para rotação de IPs, cabeçalhos e limitação de taxa adaptativa com o CapSolver.

Rajinder Singh

05-Feb-2026

Como resolver Captcha no RoxyBrowser com integração do CapSolver

Integre o CapSolver com o RoxyBrowser para automatizar tarefas do navegador e contornar o reCAPTCHA, o Turnstile e outros CAPTCHAS.

Adélia Cruz

04-Feb-2026

Como resolver Captcha no EasySpider com integração do CapSolver

EasySpider é uma ferramenta de raspagem de web e automação do navegador visual e sem código, e quando combinado com o CapSolver, pode resolver de forma confiável CAPTCHAs como reCAPTCHA v2 e Cloudflare Turnstile, permitindo a extração de dados automatizada sem interrupções em sites.

Adélia Cruz

04-Feb-2026

Como resolver reCAPTCHA v2 no Relevance AI com integração da CapSolver

Construa uma ferramenta da Relevance AI para resolver reCAPTCHA v2 usando o CapSolver. Automatize os envios de formulários via API sem automação de navegador.

Adélia Cruz

03-Feb-2026

Ferramentas de Raspagem de Dados Instantâneas: Métodos Rápidos para Extrair Dados da Web Sem Código

Descubra as melhores ferramentas de raspagem de dados instantâneas para 2026. Aprenda formas rápidas de extrair dados da web sem código usando as melhores extensões e APIs para extração automatizada.

Emma Foster

28-Jan-2026