Resolvendo Erros 403 Proibidos ao Raspar Sites com Python

Emma Foster

Machine Learning Engineer

13-Jan-2026

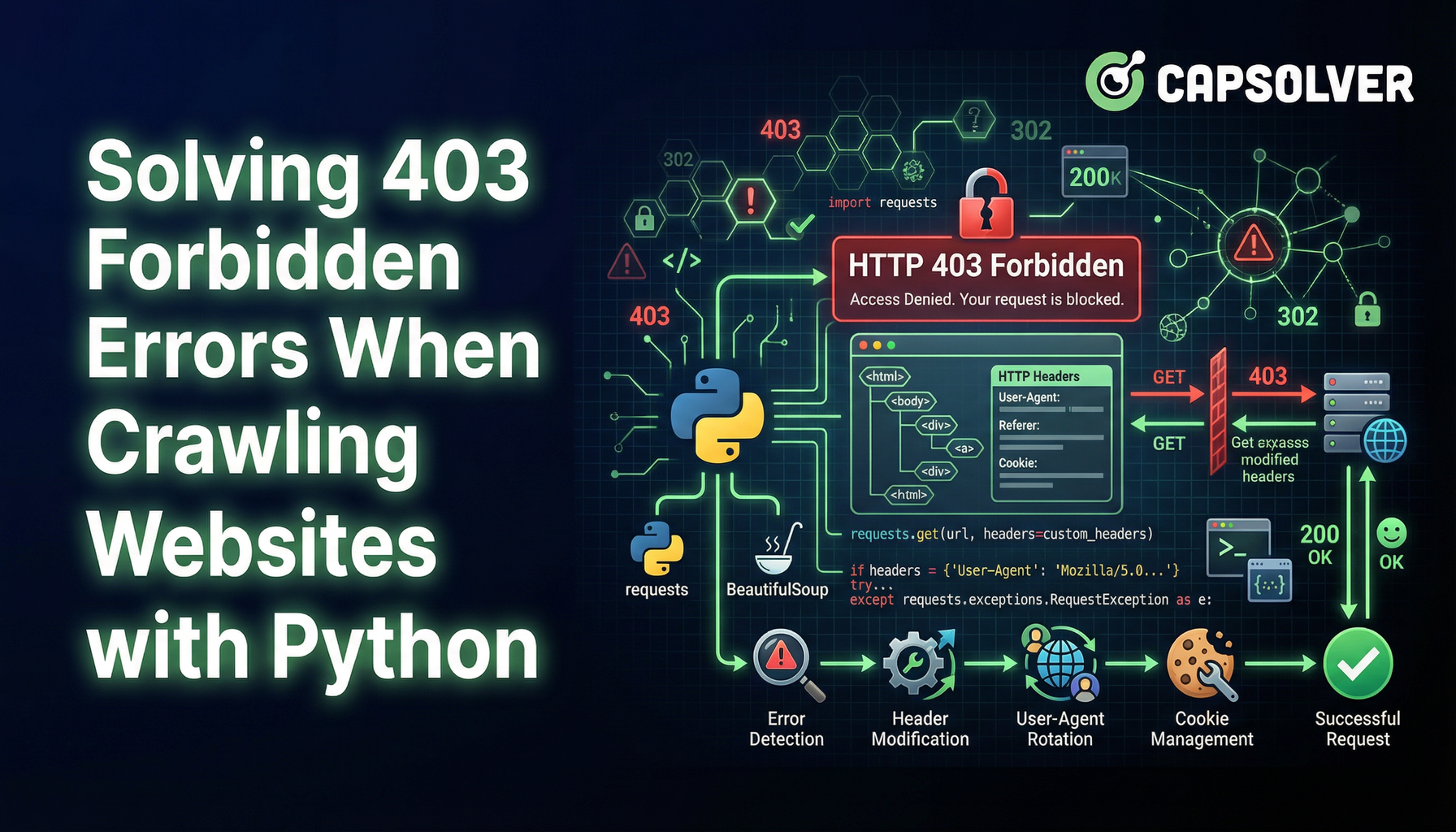

A raspagem de web é uma técnica valiosa para extrair dados de sites. No entanto, encontrar um erro 403 Proibido pode ser um grande obstáculo. Esse erro indica que o servidor entende sua solicitação, mas se recusa a autorizá-la. Aqui está como contornar esse problema e continuar sua jornada de raspagem de web.

Entendendo o Erro 403 Proibido

Um erro 403 Proibido ocorre quando o servidor nega o acesso ao recurso solicitado. Isso pode acontecer por vários motivos, incluindo:

Tendo dificuldades com a falha repetida em resolver o irritante CAPTCHA? Descubra a resolução automática de CAPTCHA com a tecnologia de desbloqueio da web com inteligência artificial do CapSolver!

Resgatar seu código de bônus do CapSolver

Aumente seu orçamento de automação instantaneamente!

Use o código de bônus CAPN ao recarregar sua conta do CapSolver para obter um bônus extra de 5% em cada recarga — sem limites.

Resgate-o agora no seu Painel CapSolver

.

- Bloqueio de IP: Servidores podem bloquear endereços IP se detectarem solicitações incomuns ou de alto volume.

- Restrições de User-Agent: Alguns sites restringem o acesso com base na string do User-Agent, que identifica o navegador e o dispositivo que faz a solicitação.

- Autenticação necessária: Acessar certas páginas pode exigir credenciais de login ou uma chave de API.

Técnicas para Contornar Erros 403

1. Rotacionar Endereços IP

Servidores frequentemente bloqueiam solicitações do mesmo endereço IP após um certo limite. Usar um conjunto de servidores proxy para rotacionar endereços IP pode ajudar a evitar isso. Serviços como Nstproxy ou Bright Data oferecem soluções de proxy rotativo.

python

import requests

proxies = {

"http": "http://seu_proxy_aqui",

"https": "http://seu_proxy_aqui",

}

response = requests.get("http://example.com", proxies=proxies)2. Usar um User-Agent Realista

Servidores web podem detectar e bloquear solicitações com strings de User-Agent suspeitas. Falsificar a string do User-Agent para imitar um navegador regular pode ajudar a evitar a detecção.

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. Implementar Limitação de Solicitações

Enviar muitas solicitações em um curto período pode acionar limites de taxa. Introduzir atrasos entre as solicitações pode ajudar a permanecer invisível.

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # Atraso de 5 segundos4. Gerenciar Autenticação

Alguns recursos exigem autenticação. Usar cookies ou chaves de API para solicitações autenticadas pode contornar restrições de acesso.

python

cookies = {

"session": "seu_cookie_de_sessão_aqui"

}

response = requests.get("http://example.com", cookies=cookies)5. Usar Navegadores Headless

Navegadores headless como Puppeteer ou Selenium simulam interações reais de usuários e podem ajudar a contornar medidas avançadas de anti-raspagem.

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. Superar Desafios de CAPTCHA

Além de erros 403, raspadores frequentemente encontram CAPTCHAs, que são projetados para bloquear o acesso automatizado. CAPTCHAs como reCAPTCHA exigem resolver desafios visuais ou interativos para provar que a solicitação foi feita por um humano.

Para resolver esses desafios, você pode usar serviços como CapSolver que oferecem soluções de resolução automática de CAPTCHA. CapSolver suporta diversos tipos de CAPTCHA e oferece integração fácil com ferramentas de raspagem de web.

Conclusão

Encontrar um erro 403 Proibido durante a raspagem de web pode ser frustrante, mas compreender as razões por trás dele e empregar as técnicas certas pode ajudar a superar esse obstáculo. Seja usando rotação de IPs, strings de User-Agent realistas, limitação de solicitações, gerenciamento de autenticação ou navegadores headless, esses métodos podem ajudar você a continuar extraíndo dados valiosos da web.

Ao seguir essas estratégias, você pode gerenciar e contornar efetivamente erros 403, garantindo raspagens de web mais suaves e bem-sucedidas.

Perguntas Frequentes

1. É legal contornar um erro 403 Proibido na raspagem de web?

Contornar um erro 403 Proibido não é intrinsecamente ilegal, mas a legalidade depende dos termos de serviço do site, regras do robots.txt e leis locais. Raspagem de dados publicamente acessíveis para fins legítimos é frequentemente permitida, enquanto contornar autenticação, muros de pagamento ou restrições explícitas pode violar termos ou regulamentações. Sempre revise as políticas do site alvo antes de raspagem.

2. Por que ainda recebo um erro 403 mesmo usando proxies e um User-Agent?

Um erro 403 pode persistir se o site usar sistemas avançados de detecção de bots, como análise de comportamento, fingerprinting ou desafios de CAPTCHA. Nesses casos, rotação simples de IPs e falsificação de User-Agent podem não ser suficientes. Combinar limitação de solicitações, gerenciamento de sessão, navegadores headless e serviços de resolução de CAPTCHA como o CapSolver pode melhorar significativamente as taxas de sucesso.

3. Qual é o método mais confiável para evitar erros 403 para raspagem em larga escala?

Para raspagem em larga escala, a abordagem mais confiável é uma estratégia em camadas: proxies rotativos de alta qualidade, como residenciais ou móveis, impressões digitais de navegador realistas, taxas controladas de solicitações, tratamento adequado de autenticação e resolução automática de CAPTCHA. O uso de navegadores headless com soluções de desbloqueio de web baseadas em IA ajuda a imitar com precisão o comportamento de usuários reais e reduz a probabilidade de bloqueios 403 repetidos.

Declaração de Conformidade: As informações fornecidas neste blog são apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas soluções de resolução de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos serviços. Para mais informações, visite nossos Termos de Serviço e Política de Privacidade.

Mais

Dados como Serviço (DaaS): O que é e por que importa em 2026

Entenda Dados como Serviço (DaaS) em 2026. Descubra seus benefícios, casos de uso e como transforma os negócios com visões em tempo real e escalabilidade.

Ethan Collins

12-Feb-2026

Como corrigir erros comuns de raspagem da web em 2026

Dominar a correção de diversos erros de raspagem de web, como 400, 401, 402, 403, 429, 5xx e 1001 do Cloudflare em 2026. Aprenda estratégias avançadas para rotação de IPs, cabeçalhos e limitação de taxa adaptativa com o CapSolver.

Rajinder Singh

05-Feb-2026

Como resolver Captcha no RoxyBrowser com integração do CapSolver

Integre o CapSolver com o RoxyBrowser para automatizar tarefas do navegador e contornar o reCAPTCHA, o Turnstile e outros CAPTCHAS.

Adélia Cruz

04-Feb-2026

Como resolver Captcha no EasySpider com integração do CapSolver

EasySpider é uma ferramenta de raspagem de web e automação do navegador visual e sem código, e quando combinado com o CapSolver, pode resolver de forma confiável CAPTCHAs como reCAPTCHA v2 e Cloudflare Turnstile, permitindo a extração de dados automatizada sem interrupções em sites.

Adélia Cruz

04-Feb-2026

Como resolver reCAPTCHA v2 no Relevance AI com integração da CapSolver

Construa uma ferramenta da Relevance AI para resolver reCAPTCHA v2 usando o CapSolver. Automatize os envios de formulários via API sem automação de navegador.

Adélia Cruz

03-Feb-2026

Ferramentas de Raspagem de Dados Instantâneas: Métodos Rápidos para Extrair Dados da Web Sem Código

Descubra as melhores ferramentas de raspagem de dados instantâneas para 2026. Aprenda formas rápidas de extrair dados da web sem código usando as melhores extensões e APIs para extração automatizada.

Emma Foster

28-Jan-2026