Alat Pengambilan Data Web - Dijelaskan

Sora Fujimoto

AI Solutions Architect

23-Dec-2025

TL;DR

- Pengambilan data web mengotomatisasi ekstraksi data dari situs web, mengubah volume besar data online yang tidak terstruktur menjadi format yang terstruktur dan dapat digunakan.

- Ini digunakan secara luas di berbagai industri untuk pemantauan harga, generasi lead, pemantauan SEO, analisis sentimen, dan jurnalisme data.

- Alat pengambilan data web terbagi menjadi tiga kategori utama: alat self-service tanpa kode, alat berbasis kode, dan layanan ekstraksi data yang sepenuhnya dikelola.

- Alat tanpa kode dan visual (misalnya, Import.io, Octoparse, ParseHub, WebHarvy) ideal untuk pengguna non-teknis yang membutuhkan hasil cepat.

- Alat dan perpustakaan yang fokus pada pengembang (misalnya, Scrapy, BeautifulSoup, Selenium, Puppeteer, Cheerio) menawarkan fleksibilitas dan skalabilitas yang lebih besar tetapi memerlukan keterampilan pemrograman.

- Alat otomatisasi browser seperti Selenium dan Puppeteer penting untuk situs web yang berbasis JavaScript dan sangat interaktif.

- Memilih alat yang tepat bergantung pada keahlian teknis, kompleksitas data, skala, dan anggaran, bukan pada pendekatan satu ukuran cocok untuk semua.

- Pengambilan data yang bertanggung jawab sangat penting—selalu patuhi syarat layanan situs web dan pedoman hukum serta etika yang berlaku.

Alat Pengambilan Data Web

Pengambilan data web, juga dikenal sebagai ekstraksi data web, adalah proses mengambil atau "mengambil" data dari sebuah situs web. Berbeda dengan proses yang membosankan dan melelahkan dari mengambil data secara manual, pengambilan data web menggunakan otomatisasi cerdas untuk mengambil ratusan, jutaan, atau bahkan miliaran titik data dari perbatasan internet yang tak terbatas.

Jumlah data di internet meningkat secara eksponensial. Ada lebih dari 1,7 miliar situs web online, dan lebih banyak lagi dibuat setiap hari. Dalam lautan data ini, bagaimana bisnis, peneliti, dan individu bisa menemukan informasi yang mereka butuhkan? Jawabannya terletak pada pengambilan data web.

Panduan ini bertujuan untuk memberikan gambaran mendalam tentang beberapa alat pengambilan data web yang paling kuat saat ini. Meskipun beberapa alat ini memerlukan tingkat pengetahuan teknis, yang lain cocok untuk non-pemrogram. Baik Anda seorang ilmuwan data berpengalaman, pengembang perangkat lunak, atau spesialis pemasaran digital, Anda akan menemukan alat yang sesuai dengan kebutuhan Anda.

Tukarkan Kode Bonus CapSolver Anda

Meningkatkan anggaran otomatisasi Anda secara instan!

Gunakan kode bonus CAPN saat menambahkan dana ke akun CapSolver Anda untuk mendapatkan bonus tambahan 5% pada setiap penambahan dana — tanpa batas.

Tukarkan sekarang di Dasbor CapSolver

.

1. Pengantar Pengambilan Data Web

Pengambilan data web adalah metode otomatis yang digunakan untuk mengekstrak data dalam jumlah besar dari situs web dengan cepat. Data di situs web tidak terstruktur. Pengambilan data web memungkinkan kita untuk mengubah data tersebut menjadi bentuk yang terstruktur.

2. Mengapa Menggunakan Alat Pengambilan Data Web?

Ada banyak alasan mengapa bisnis, akademisi, dan individu mungkin ingin mengambil data dari sebuah situs web. Penggunaan umum termasuk:

- Jurnalisme Data: Jurnalis dan peneliti dapat menggunakan alat pengambilan data untuk melacak perubahan pada catatan publik atau mengumpulkan informasi dari berbagai sumber untuk sebuah laporan investigatif.

- Perbandingan Harga: Perusahaan e-commerce sering menggunakan alat pengambilan data untuk memantau strategi harga kompetitor mereka. Dengan mengambil harga produk dan deskripsi, mereka dapat memantau pasar mereka.

- Generasi Lead: Banyak bisnis menggunakan pengambilan data untuk menghasilkan lead dan mengumpulkan informasi kontak dari direktori bisnis atau situs media sosial.

- Analisis Sentimen: Dengan mengambil ulasan pelanggan dan percakapan media sosial, bisnis dapat memperoleh wawasan tentang bagaimana produk mereka dipersepsikan di pasar, memungkinkan mereka merespons umpan balik pelanggan secara lebih efektif.

- Pemantauan SEO: Perusahaan SEO menggunakan pengambil data untuk memantau kinerja situs web, melacak perubahan peringkat SEO, dan mengumpulkan data lain yang relevan.

3. Jenis Alat Pengambilan Data Web

Ada tiga jenis alat pengambilan data web secara utama:

- Alat Self-Service: Alat ini adalah alat klik dan pilih yang memungkinkan pengguna mengambil data tanpa menulis kode. Mereka sering hadir dengan antarmuka visual, di mana Anda dapat menandai bidang data yang Anda butuhkan, dan mereka secara otomatis mengekstraknya untuk Anda.

- Alat Programatik: Alat ini adalah perpustakaan atau kerangka kerja yang dapat Anda sematkan dalam kode Anda. Mereka menawarkan fleksibilitas dan kemampuan yang lebih besar tetapi memerlukan pengetahuan pemrograman.

- Layanan yang Dikelola: Alat ini adalah platform end-to-end di mana Anda menentukan kebutuhan Anda, dan mereka menyampaikan data. Mereka paling nyaman tetapi paling tidak fleksibel dan sering paling mahal.

4. Ulasan Mendetail Alat Pengambilan Data Web

Berikut adalah ulasan mendetail tentang beberapa alat pengambilan data web yang populer. Setiap ulasan alat mencakup deskripsi fitur, manfaat, dan kasus penggunaannya.

Import.io

Import.io adalah alat berbasis web yang mengekstrak data dari situs web tanpa menulis kode apa pun. Ini menyediakan antarmuka visual untuk menunjuk ke bidang data yang ingin Anda ambil, dan kemudian melakukan sisanya.

Fitur:

- Antarmuka Klik dan Pilih: Alat ini memungkinkan pengguna mengidentifikasi data yang mereka butuhkan menggunakan antarmuka klik dan pilih yang intuitif.

- Laporan Data: Import.io menyampaikan data yang diambil sebagai file CSV atau Microsoft Excel atau dapat mensinkronkannya langsung ke gudang data Anda.

- Scheduler: Alat ini dapat mengatur ekstraksi data dan selalu menyampaikan data yang terkini.

Kasus Penggunaan:

Import.io cocok untuk orang-orang yang tidak memiliki keterampilan pemrograman tetapi perlu mengekstrak data terstruktur dari halaman web. Ini dapat digunakan untuk perbandingan harga, analisis sentimen, pengambilan data media sosial, dll.

Octoparse

Octoparse adalah alat pengambilan data web yang kuat yang mengotomatisasi ekstraksi data dari berbagai jenis situs web. Ini memiliki desainer alur kerja visual yang memungkinkan pengguna mengelola spesifikasi ekstraksi data mereka.

Fitur:

- Ekstraksi Cloud: Octoparse menawarkan fitur ekstraksi data berbasis cloud yang memberikan ekstraksi data dengan kecepatan tinggi, karena proses ekstraksi data dilakukan di server mereka alih-alih perangkat lokal pengguna.

- Format Ekspor: Alat ini memungkinkan pengguna mengekspor data dalam berbagai format, termasuk Excel, HTML, TXT, dan basis data (MySQL, SQL Server, dan Oracle).

- Akses API: Octoparse menyediakan API, memungkinkan pengguna mengelola data mereka secara remote.

Kasus Penggunaan:

Octoparse dapat digunakan untuk berbagai tujuan ekstraksi data, seperti generasi lead, pemantauan harga, riset pasar, dan riset akademik.

ParseHub

ParseHub adalah alat ekstraksi data visual yang dapat digunakan siapa saja untuk mendapatkan data dari web. Anda dapat membuat rencana untuk mengekstrak data dari situs web dan biarkan ParseHub melakukan pekerjaannya.

Fitur:

- Dukungan JavaScript dan AJAX: ParseHub dapat menangani situs web dengan JavaScript dan AJAX, yang sulit untuk banyak alat pengambil data lainnya.

- Teknik Lanjutan: Alat ini dapat menangani data bersarang multi-level, paginasi, dropdown, pencarian, dan formulir.

- Scheduler: Alat ini dapat menjalankan proyek pengambilan data sebanyak setiap 10 menit atau sekali setahun.

Kasus Penggunaan:

ParseHub dapat digunakan untuk berbagai tujuan, seperti jurnalisme data, pertumbuhan e-commerce, pengumpulan data pelatihan AI, dan prediksi tren pasar.

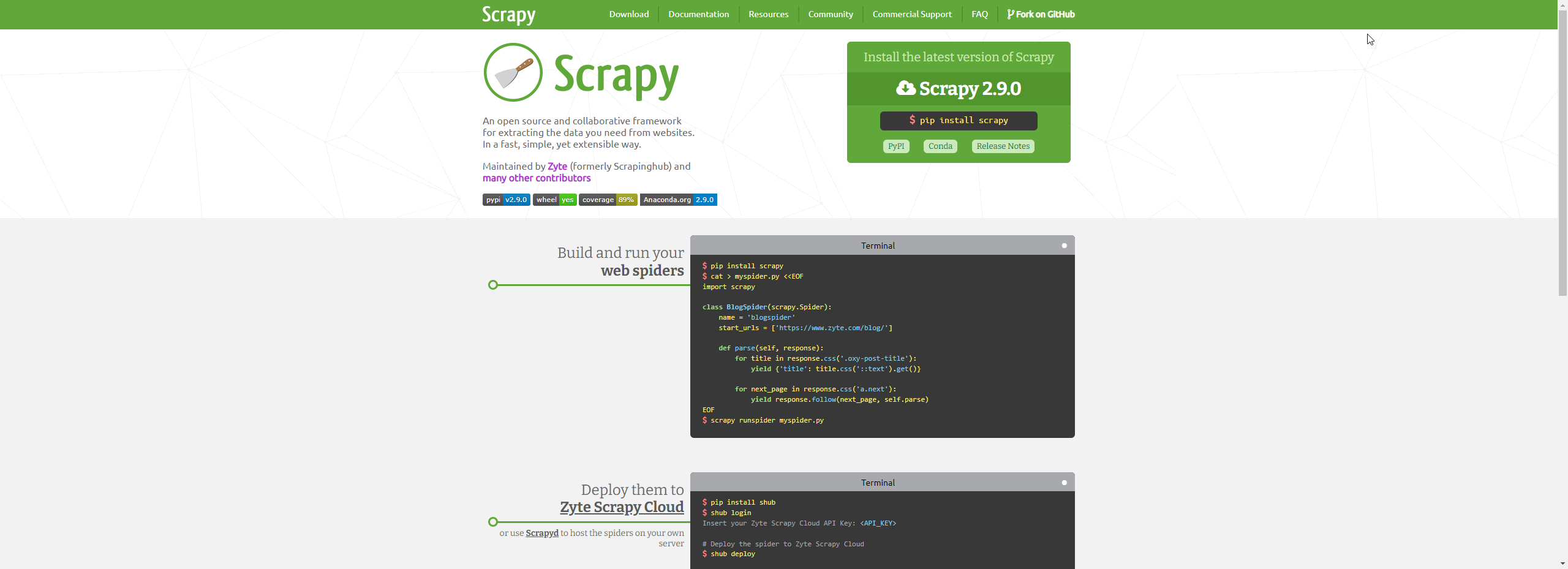

Scrapy

Scrapy adalah kerangka kerja pengambilan data web open-source yang ditulis dalam Python. Alat ini menyediakan semua alat yang dibutuhkan untuk mengekstrak data dari situs web, memprosesnya, dan menyimpannya dalam format yang Anda sukai.

Fitur:

- Bervariasi: Scrapy sangat bervariasi dan dapat menangani berbagai tugas pengambilan data, termasuk data mining, data processing, dan arsip sejarah.

- Kuat dan Skalabel: Alat ini dirancang untuk menangani tugas pengambilan data web skala besar. Alat ini bahkan dapat menangani tugas pengambilan data yang didistribusikan ke beberapa mesin.

- Perpustakaan Luas: Scrapy memiliki ekosistem dan komunitas yang kaya, dengan banyak perpustakaan yang memperluas fungsionalitasnya.

Kasus Penggunaan:

Scrapy cocok untuk tugas pengambilan data skala besar dan kompleks. Alat ini ideal untuk ilmuwan data, peneliti, dan pengembang yang nyaman dengan pemrograman Python.

BeautifulSoup

BeautifulSoup adalah perpustakaan Python yang dirancang untuk tujuan pengambilan data untuk menarik data dari file HTML dan XML. Ini sederhana dan mudah diakses bagi pemula, tetapi kesederhanaannya tidak mengorbankan fungsionalitasnya.

Fitur:

- Parsing yang Mudah: BeautifulSoup mengubah dokumen HTML yang kompleks menjadi pohon objek Python, seperti tag, string yang dapat dijelajahi, atau komentar.

- Pencarian Pohon Parsing: Anda dapat mencari pohon parsing menggunakan filter berdasarkan nama tag, atribut, dan lainnya.

- Idiom Python: BeautifulSoup menggunakan idiom Python untuk iterasi, pencarian, dan modifikasi pohon parsing.

Kasus Penggunaan:

BeautifulSoup adalah pilihan yang baik untuk tugas pengambilan data yang memerlukan parsing dokumen HTML dan XML. Kesederhanaannya membuatnya menjadi pilihan yang baik untuk pemula.

Selenium

Selenium adalah alat yang kuat untuk mengontrol browser web melalui program. Alat ini fungsional untuk semua browser, berjalan di semua sistem operasi utama dan skripnya ditulis dalam berbagai bahasa, yaitu Python, Java, C#, dll.

Fitur:

- Otomatisasi Browser: Selenium dapat mengotomatisasi tugas browser, yang berguna ketika halaman web interaktif dan permintaan HTTP sederhana tidak cukup.

- Dukungan Multi Bahasa: Skrip Selenium dapat ditulis dalam beberapa bahasa pemrograman, termasuk Python, Java, dan C#.

- Dukungan Berbagai Browser: Alat ini mendukung semua browser web utama, termasuk Chrome, Firefox, Safari, dan Edge.

Kasus Penggunaan:

Selenium ideal untuk tugas pengambilan data yang memerlukan interaksi dengan halaman web, seperti mengklik tombol atau mengisi formulir. Ini juga merupakan pilihan yang baik untuk pengujian aplikasi web.

Puppeteer

Puppeteer adalah perpustakaan Node yang menyediakan API tingkat tinggi untuk mengontrol Chrome atau Chromium melalui Protokol DevTools. Alat ini sering digunakan untuk pengambilan data web, pengujian otomatis, dan menghasilkan konten yang dirender sebelumnya.

Fitur:

- Navigasi Tanpa Antarmuka: Puppeteer umumnya digunakan dalam mode headless, menawarkan cara cepat dan otomatis untuk mengakses konten web.

- Interaktivitas: Puppeteer dapat mensimulasikan interaksi pengguna seperti pengiriman formulir, input keyboard, dan klik tombol.

- Pembuatan Screenshot dan PDF: Puppeteer dapat menghasilkan screenshot dan PDF dari halaman.

Kasus Penggunaan:

Puppeteer berguna ketika Anda perlu mengeksekusi JavaScript di halaman Anda. Alat ini dapat digunakan untuk pengambilan data web, pengujian unit otomatis, dan rendering sisi server.

Cheerio

Cheerio adalah implementasi yang cepat, fleksibel, dan ringan dari inti jQuery yang dirancang khusus untuk server. Ini adalah perpustakaan Node.js yang membantu pengembang memahami dan menganalisis halaman web menggunakan sintaks mirip jQuery.

Fitur:

- Sintaks jQuery: Cheerio memproses markup dan menyediakan API untuk menjelajahi/mengubah struktur data yang dihasilkan.

- Kinerja: Cheerio fokus pada API traversal DOM yang konsisten dan fleksibel serta memisahkan parsing dan rendering, yang dapat meningkatkan kinerja.

- Fleksibilitas: Alat ini bekerja dengan berbagai dokumen HTML dan XML, membuatnya sangat fleksibel untuk tugas pengambilan data web.

Kasus Penggunaan:

Cheerio adalah alat yang hebat untuk manipulasi data HTML di sisi server, ekstraksi data dari dokumen HTML, dan khususnya pengambilan data web dengan Node.js.

OutWit Hub

OutWit Hub adalah ekstensi Firefox dengan fitur ekstraksi data yang banyak untuk menyederhanakan pencarian web Anda. Alat ini dapat secara otomatis menjelajahi halaman dan menyimpan informasi yang diambil dalam format pilihan Anda.

Fitur:

- Ekstraksi Data: OutWit Hub menawarkan antarmuka tunggal untuk mengambil data kecil atau besar sesuai kebutuhan.

- Ekspor Data: Data yang dikumpulkan dengan OutWit Hub dapat diekspor sebagai Excel, CSV, HTML, atau basis data SQL.

- Ekstraksi Gambar dan Dokumen: Selain mengekstrak data teks, OutWit Hub juga dapat mengekstrak gambar, file PDF, dan lainnya.

Kasus Penggunaan:

OutWit Hub cocok untuk freelancer, dan bisnis kecil hingga menengah yang perlu mengambil data dari web dan menyimpannya secara lokal.

WebHarvy

WebHarvy adalah alat pengambil data web visual dengan antarmuka klik dan pilih untuk mengekstrak data dari situs web apa pun dengan mudah. Ini adalah aplikasi desktop dengan pembelian sekali.

Fitur:

- Antarmuka Visual: WebHarvy beroperasi dengan antarmuka visual yang memerlukan pengetahuan coding minimal. Anda memilih bidang data yang ingin diambil menggunakan mouse.

- Ekstraksi Multi-level: Alat ini dapat mengikuti tautan untuk mengekstrak data dari halaman detail, dan juga dapat menangani paginasi secara otomatis.

- Dukungan Ekspresi Reguler: WebHarvy mendukung Ekspresi Reguler (RegEx) yang dapat digunakan untuk mencocokkan pola saat mengekstrak data.

Kasus Penggunaan:

WebHarvy ideal untuk non-pemrogram yang perlu mengekstrak data secara berkala dari situs web tertentu ke file Excel atau CSV.

DataMiner

Data Miner adalah ekstensi browser pribadi yang membantu Anda mengubah data HTML di jendela browser Anda menjadi dataset yang bersih dan terstruktur.

Data Miner berguna bagi profesional yang perlu mengumpulkan jumlah data yang moderat dari situs web tertentu dan menghemat waktu dalam entri atau ekstraksi data.

Mozenda

Mozenda adalah perangkat lunak pengambilan data web untuk perusahaan yang dirancang untuk berbagai kebutuhan ekstraksi data. Memiliki antarmuka yang ramah pengguna dan mudah digunakan dengan klik dan pilih, serta memberikan fleksibilitas untuk mengumpulkan berbagai jenis data.

Fitur:

- Antarmuka Klik dan Pilih: Mozenda memungkinkan pengguna untuk dengan mudah memilih data yang mereka butuhkan menggunakan alat klik dan pilih.

- Platform Cloud: Mozenda beroperasi sebagai alat pengambil data berbasis cloud, menawarkan ekstraksi data dengan kecepatan tinggi.

- Akses API: Mozenda menyediakan API, memungkinkan pengguna untuk mengintegrasikan data mereka ke dalam aplikasi lain.

Kasus Penggunaan:

Mozenda ideal untuk bisnis dan peneliti yang perlu mengambil berbagai jenis data, termasuk teks, gambar, dokumen, dan lainnya dari berbagai situs web.

5. Kesimpulan

Alat pengambilan data web adalah kebutuhan di dunia yang didorong oleh data saat ini. Dari memahami sentimen pelanggan hingga memantau kompetitor bisnis, penggunaan pengambilan data web tidak terbatas. Namun, tidak semua alat pengambilan data web dibuat sama. Alat yang tepat untuk Anda tergantung pada keahlian teknis Anda, kompleksitas tugas, dan jenis data yang perlu Anda ambil.

Jika Anda pemula atau seseorang yang tidak suka menulis kode, alat seperti Import.io, Octoparse, ParseHub, WebHarvy, dan OutWit Hub akan lebih sesuai. Di sisi lain, jika Anda nyaman dengan coding, Anda bisa menggunakan alat yang lebih fleksibel dan kuat seperti Scrapy, BeautifulSoup, Selenium, Puppeteer, dan Cheerio.

Bahkan jika Anda memilih alat apa pun, ingatlah selalu untuk menghormati syarat layanan situs web dan menggunakan data secara bertanggung jawab.

FAQ

1. Alat pengambilan data web mana yang terbaik untuk pemula?

Untuk pemula atau pengguna non-teknis, alat visual dan tanpa kode seperti Import.io, Octoparse, ParseHub, WebHarvy, dan OutWit Hub adalah pilihan terbaik. Mereka menyediakan antarmuka klik dan pilih, jadwal bawaan, dan ekspor data yang mudah tanpa memerlukan pengetahuan pemrograman.

2. Kapan saya harus menggunakan Selenium atau Puppeteer alih-alih pengambil data tradisional?

Selenium dan Puppeteer lebih cocok digunakan untuk situs web yang bergantung pada JavaScript, konten dinamis, atau interaksi pengguna seperti mengklik tombol, mengisi formulir, atau menggulir tak terbatas. Pengambil data berbasis HTTP tradisional mungkin gagal dalam skenario ini.

3. Apakah pengambilan data web legal?

Pengambilan data web tidak ilegal secara alami, tetapi kelegalannya tergantung pada cara dan tempat penggunaannya. Faktor-faktor seperti syarat layanan situs web, jenis data yang dikumpulkan, dan regulasi perlindungan data setempat semuanya penting. Penting untuk mengambil data secara bertanggung jawab, menghindari data yang dilindungi atau pribadi, dan memastikan kepatuhan terhadap hukum dan kebijakan yang relevan.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Cara menyelesaikan Captcha di Nanobot dengan CapSolver

Mengotomasi penyelesaian CAPTCHA dengan Nanobot dan CapSolver. Gunakan Playwright untuk menyelesaikan reCAPTCHA dan Cloudflare secara otomatis.

Anh Tuan

26-Feb-2026

Data sebagai Layanan (DaaS): Apa Itu dan Mengapa Penting pada 2026

Pahami Data sebagai Layanan (DaaS) pada 2026. Eksplor manfaatnya, kasus penggunaan, dan bagaimana DaaS mengubah bisnis dengan wawasan real-time dan skalabilitas.

Anh Tuan

12-Feb-2026

Cara Menyelesaikan Captcha di RoxyBrowser dengan Integrasi CapSolver

Mengintegrasikan CapSolver dengan RoxyBrowser untuk mengotomatisasi tugas browser dan menghindari reCAPTCHA, Turnstile, dan CAPTCHA lainnya.

Ethan Collins

04-Feb-2026

Cara Menyelesaikan Captcha di EasySpider dengan Integrasi CapSolver

EasySpider adalah alat pengambilan data web dan otomatisasi browser visual, tanpa kode, dan ketika dikombinasikan dengan CapSolver, dapat menyelesaikan CAPTCHA seperti reCAPTCHA v2 dan Cloudflare Turnstile secara andal, memungkinkan pengambilan data otomatis yang mulus di berbagai situs web.

Emma Foster

04-Feb-2026

Cara menyelesaikan reCAPTCHA v2 di Relevance AI dengan Integrasi CapSolver

Kembangkan alat Relevance AI untuk menyelesaikan reCAPTCHA v2 menggunakan CapSolver. Otomatisasi pengajuan formulir melalui API tanpa otomatisasi browser.

Ethan Collins

03-Feb-2026

Larangan IP pada 2026: Bagaimana Cara Kerjanya dan Cara Praktis untuk Mengelaknya

Pelajari cara menghindari pembatasan IP pada 2026 dengan panduan lengkap kami. Temukan teknik pemblokiran IP modern dan solusi praktis seperti proxy residensial dan solver CAPTCHA.

Emma Foster

26-Jan-2026