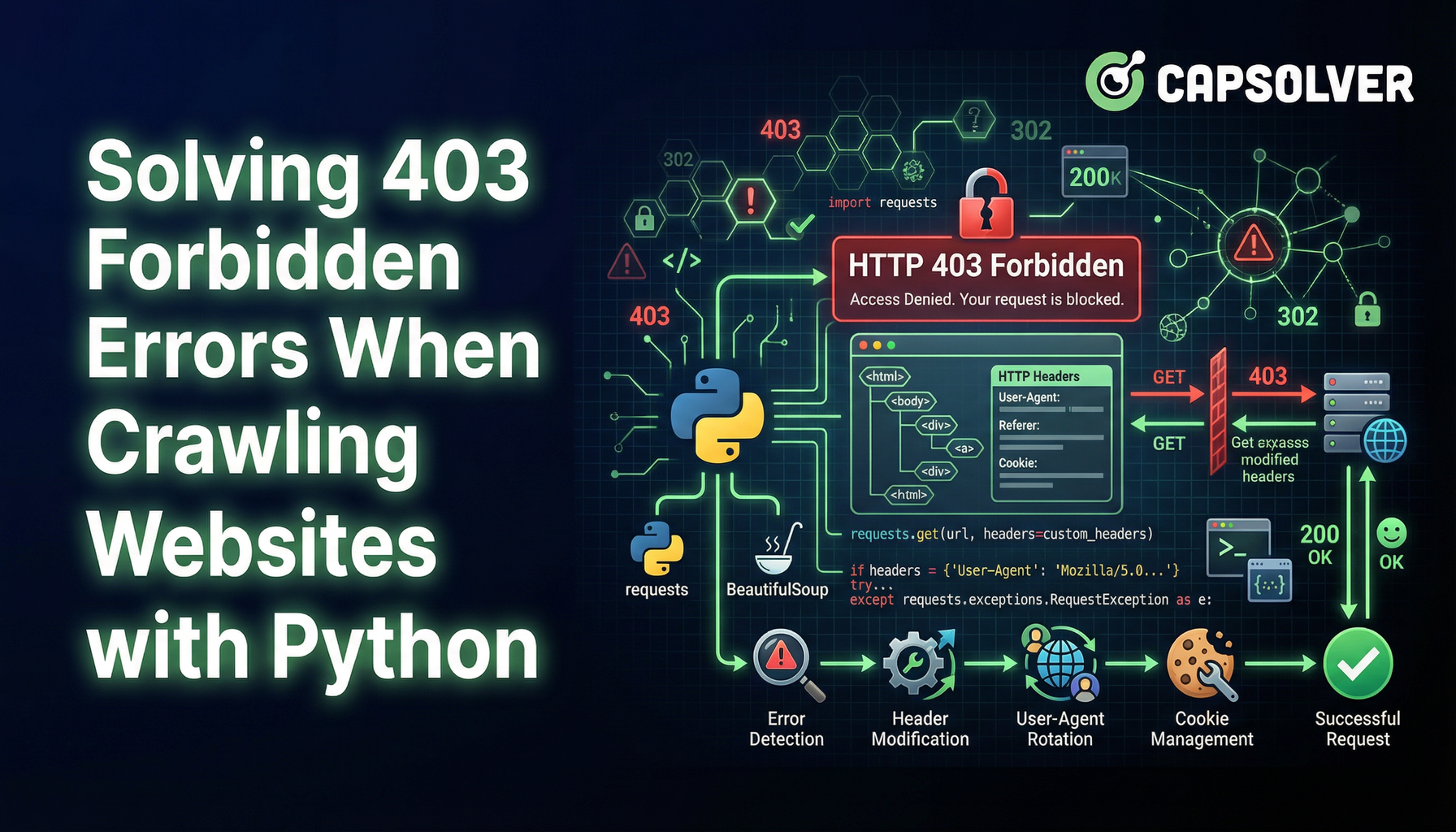

Mengatasi Kesalahan 403 Forbidden Saat Mengakses Situs Web Dengan Python

Nikolai Smirnov

Software Development Lead

13-Jan-2026

Web scraping adalah teknik yang sangat berharga untuk mengekstrak data dari situs web. Namun, menghadapi error 403 Forbidden bisa menjadi penghalang besar. Error ini menunjukkan bahwa server memahami permintaan Anda, tetapi menolak untuk mengizinkannya. Berikut ini cara mengatasi masalah ini dan melanjutkan perjalanan web scraping Anda.

Memahami Error 403 Forbidden

Error 403 Forbidden terjadi ketika server menolak akses ke sumber daya yang diminta. Hal ini bisa terjadi karena beberapa alasan, termasuk:

Kesulitan dalam mengatasi kegagalan berulang dalam menyelesaikan captcha yang mengganggu? Temukan penyelesaian captcha otomatis dengan teknologi Auto Web Unblock berbasis AI dari CapSolver!

Klaim Kode Bonus CapSolver

Meningkatkan anggaran otomasi Anda secara instan!

Gunakan kode bonus CAPN saat menambahkan dana ke akun CapSolver Anda untuk mendapatkan bonus tambahan 5% pada setiap pengisian ulang — tanpa batas.

Klaim sekarang di Dashboard CapSolver Anda

.

- Pemblokiran IP: Server mungkin memblokir alamat IP jika mendeteksi permintaan yang tidak biasa atau volume tinggi.

- Pembatasan User-Agent: Beberapa situs web membatasi akses berdasarkan string User-Agent, yang mengidentifikasi browser dan perangkat yang membuat permintaan.

- Autentikasi Diperlukan: Mengakses halaman tertentu mungkin memerlukan kredensial login atau kunci API.

Teknik untuk Menghindari Error 403

1. Ganti Alamat IP

Server sering memblokir permintaan dari alamat IP yang sama setelah ambang batas tertentu. Menggunakan kumpulan server proxy untuk mengganti alamat IP dapat membantu Anda menghindari ini. Layanan seperti Nstproxy atau Bright Data menawarkan solusi proxy yang berputar.

python

import requests

proxies = {

"http": "http://your_proxy_here",

"https": "http://your_proxy_here",

}

response = requests.get("http://example.com", proxies=proxies)2. Gunakan User-Agent yang Realistis

Server web dapat mendeteksi dan memblokir permintaan dengan string User-Agent yang mencurigakan. Mengubah string User-Agent untuk meniru browser biasa dapat membantu menghindari deteksi.

python

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"

}

response = requests.get("http://example.com", headers=headers)3. Terapkan Pengendalian Permintaan

Mengirim terlalu banyak permintaan dalam waktu singkat dapat memicu pembatasan kecepatan. Menambahkan jeda antara permintaan dapat membantu Anda tetap tidak terdeteksi.

python

import time

for url in url_list:

response = requests.get(url)

time.sleep(5) # Jeda selama 5 detik4. Kelola Autentikasi

Beberapa sumber daya memerlukan autentikasi. Menggunakan cookie atau kunci API untuk permintaan yang terautentikasi dapat mengatasi pembatasan akses.

python

cookies = {

"session": "your_session_cookie_here"

}

response = requests.get("http://example.com", cookies=cookies)5. Manfaatkan Browser Tanpa Antarmuka

Browser tanpa antarmuka seperti Puppeteer atau Selenium mensimulasikan interaksi pengguna nyata dan dapat membantu mengatasi penghalang anti-scraping yang canggih.

python

from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

html = driver.page_source6. Atasi Tantangan CAPTCHA

Selain error 403, para penjelajah web sering menghadapi CAPTCHA, yang dirancang untuk menghalangi akses otomatis. CAPTCHA seperti reCAPTCHA memerlukan penyelesaian tantangan visual atau interaktif untuk membuktikan bahwa permintaan dibuat oleh manusia.

Untuk menyelesaikan tantangan ini, Anda dapat menggunakan layanan seperti CapSolver yang menyediakan solusi penyelesaian CAPTCHA otomatis. CapSolver mendukung berbagai jenis CAPTCHA dan menawarkan integrasi yang mudah dengan alat penjelajahan web.

Kesimpulan

Menghadapi error 403 Forbidden saat melakukan web scraping bisa sangat mengganggu, tetapi memahami alasan di baliknya dan menerapkan teknik yang tepat dapat membantu Anda mengatasi hambatan ini. Baik itu mengganti IP, menggunakan string User-Agent yang realistis, mengendalikan permintaan, mengelola autentikasi, atau memanfaatkan browser tanpa antarmuka, metode ini dapat membantu Anda terus mengekstrak data berharga dari web.

Dengan mengikuti strategi ini, Anda dapat secara efektif mengelola dan menghindari error 403, memastikan proses penjelajahan web yang lebih lancar dan sukses.

Pertanyaan Umum

1. Apakah mem bypass error 403 Forbidden legal dalam web scraping?

Mem bypass error 403 Forbidden tidak secara inherent ilegal, tetapi kelegalannya tergantung pada kebijakan situs web, aturan robots.txt, dan hukum setempat. Menjelajah data yang tersedia secara publik untuk tujuan yang sah sering kali diizinkan, sementara mem bypass autentikasi, pembatasan berbayar, atau pembatasan yang jelas mungkin melanggar kebijakan atau regulasi. Selalu tinjau kebijakan situs target sebelum menjelajah.

2. Mengapa saya masih mendapatkan error 403 meskipun menggunakan proxy dan User-Agent?

Error 403 bisa terus muncul jika situs web menggunakan sistem deteksi bot yang canggih seperti analisis perilaku, fingerprinting, atau tantangan CAPTCHA. Dalam kasus ini, penggantian IP sederhana dan spoofing User-Agent mungkin tidak cukup. Menggabungkan pengendalian permintaan, manajemen sesi, browser tanpa antarmuka, dan layanan penyelesaian CAPTCHA seperti CapSolver dapat meningkatkan tingkat keberhasilan secara signifikan.

3. Apa metode paling andal untuk menghindari error 403 dalam scraping skala besar?

Untuk scraping skala besar, pendekatan paling andal adalah strategi berlapis: proxy berputar berkualitas tinggi, fingerprint browser yang realistis, kecepatan permintaan yang terkendali, penanganan autentikasi yang tepat, dan penyelesaian CAPTCHA otomatis. Menggunakan browser tanpa antarmuka dengan solusi unblock web berbasis AI membantu meniru perilaku pengguna nyata dan mengurangi kemungkinan blokir 403 berulang.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

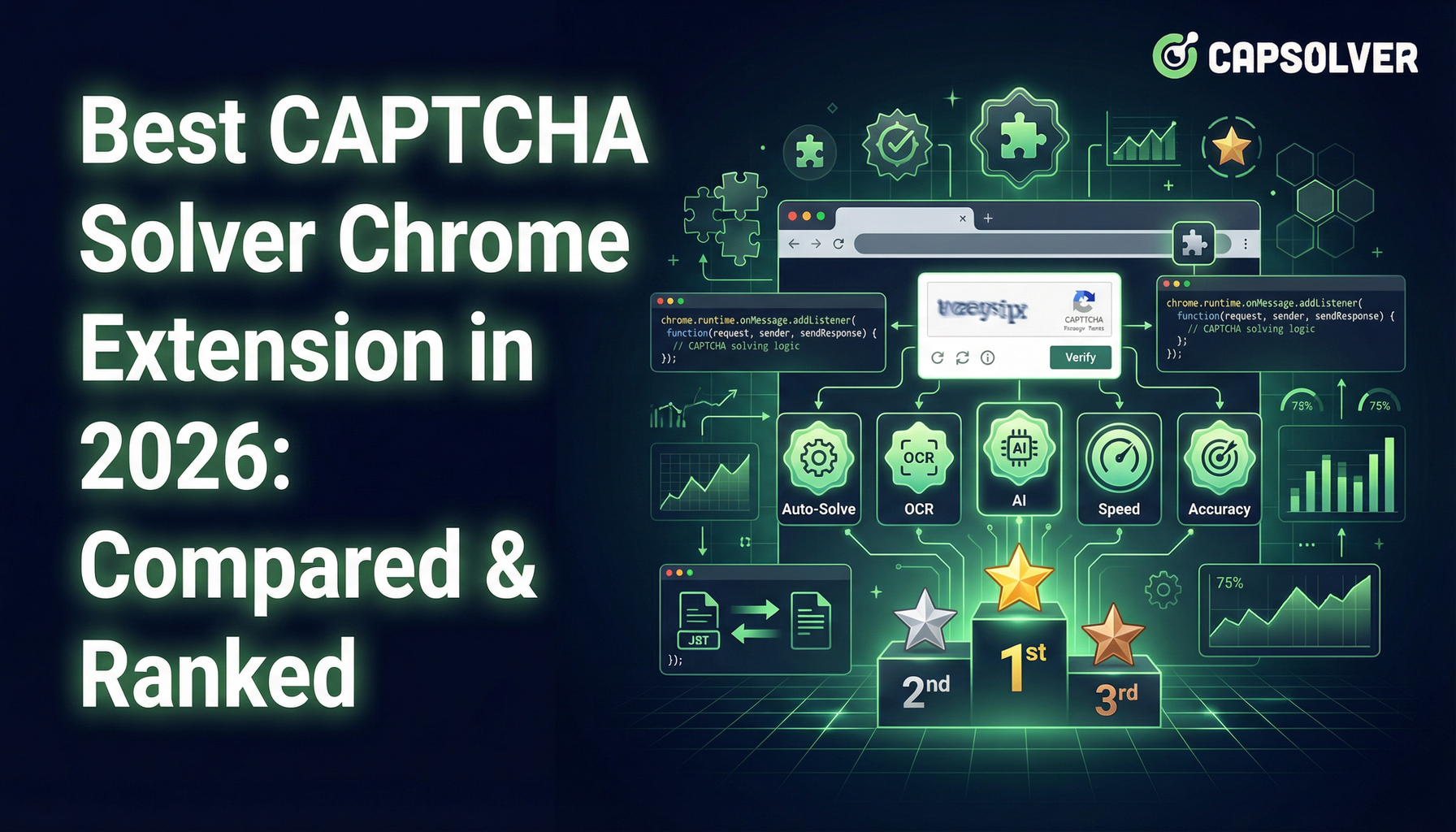

Terbaik Pemecah CAPTCHA Ekstensi Chrome Pada 2026: Dibandingkan & Diperingkat

Temukan ekstensi Chrome solver CAPTCHA terbaik pada tahun 2026. Bandingkan alat terbaik seperti CapSolver dan AZcaptcha untuk kecepatan, akurasi, dan bypass berbasis AI dari reCAPTCHA dan Cloudflare.

Anh Tuan

13-Jan-2026

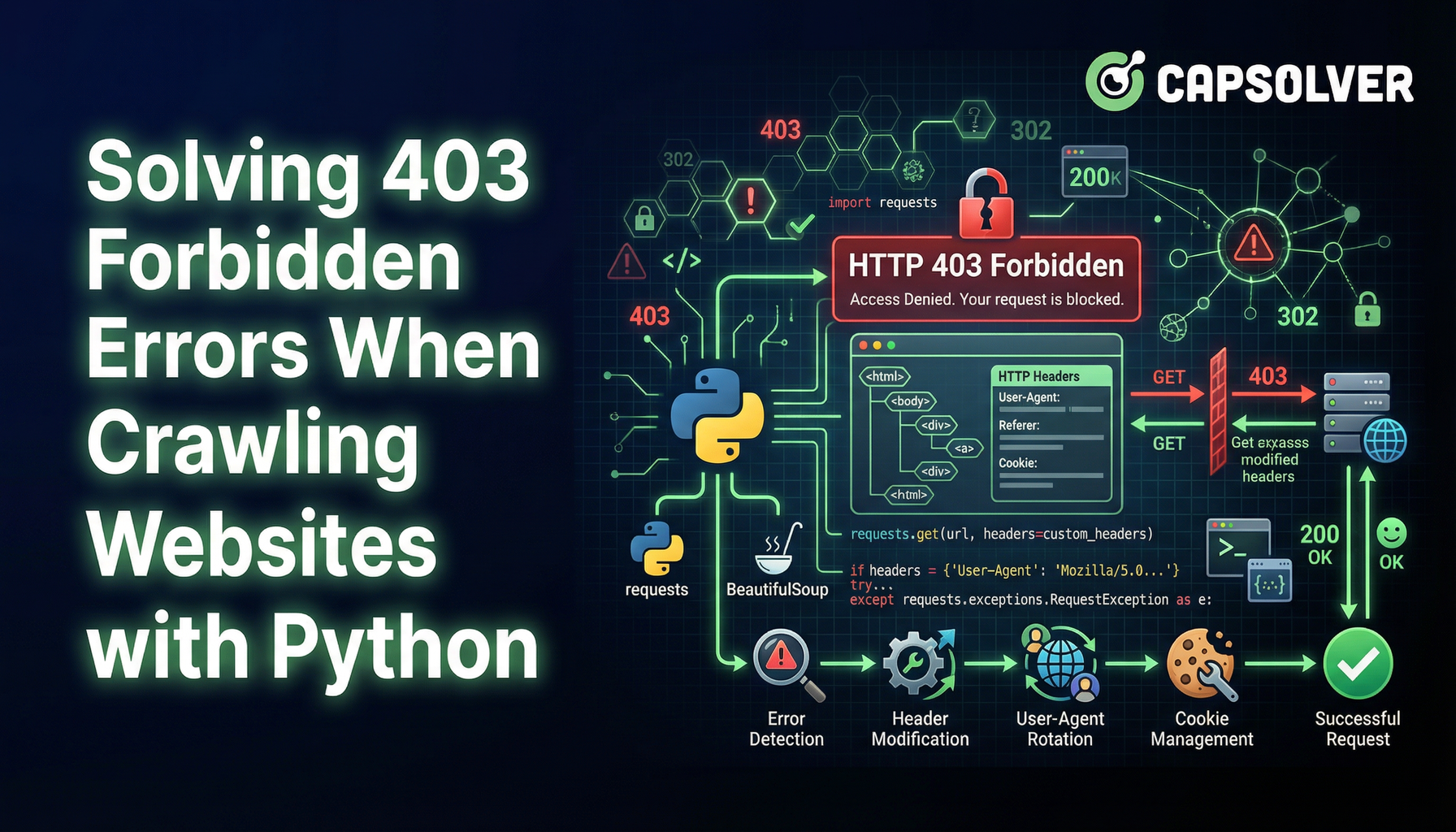

Mengatasi Kesalahan 403 Forbidden Saat Mengakses Situs Web Dengan Python

Pelajari cara mengatasi kesalahan 403 Dilarang saat meng-crawl situs web dengan Python. Panduan ini mencakup rotasi IP, pemalsuan user-agent, pengendalian permintaan, penanganan autentikasi, dan penggunaan browser tanpa antarmuka untuk menghindari pembatasan akses dan teruskan web scraping dengan sukses.

Nikolai Smirnov

13-Jan-2026

Sample Post

Menyelesaikan CAPTCHA Turnstile Cloudflare di halaman web apa pun dengan mudah menggunakan Ekstensi Penyelesaian CAPTCHA CapSolver

Lucas Mitchell

22-Dec-2025

Ekstensi Pemecah Captcha Terbaik untuk Chrome dan Mozilla

preview

Adélia Cruz

15-Dec-2025

Apa yang terbaik ekstensi untuk menyelesaikan CAPTCHA 2026?

Dalam dunia keamanan online yang terus berkembang, tantangan CAPTCHA telah menjadi hambatan umum bagi pengguna internet...

Emma Foster

12-Dec-2025

Ekstensi CapSolver: Selesaikan dengan Mudah Tantangan Captcha Gambar dan ImageToText di Browser Anda

Gunakan Ekstensi Chrome CapSolver untuk penyelesaian satu klik tantangan Captcha gambar dan ImageToText yang ditenagai AI langsung di browser Anda.

Emma Foster

11-Dec-2025