Pengumpul Web dengan Python dan Cara Menghindari Terblokir Saat Menjelajah Web

Adélia Cruz

Neural Network Developer

19-Nov-2025

Internet adalah gudang informasi yang luas, mencakup pembaruan berita hingga titik data khusus yang tersembunyi dalam situs web. Mengambil data ini secara manual tidak praktis, itulah sebabnya web crawling menjadi solusi yang efektif. Web crawling, juga dikenal sebagai web scraping, adalah proses otomatis yang mengunjungi situs web, mengambil data, dan menyimpannya untuk berbagai tujuan seperti analisis data, penelitian pasar, dan pengumpulan konten.

Namun, dunia web crawling tidak lepas dari tantangannya. Situs web menggunakan teknik canggih untuk mendeteksi dan memblokir crawler otomatis, mulai dari pembatasan kecepatan sederhana hingga tantangan CAPTCHA yang canggih. Sebagai pengembang crawler web, mengatasi tantangan ini secara efektif adalah kunci untuk menjaga proses pengambilan data yang andal.

👌 Daftar Isi

- Memahami Web Crawler

- Web Crawler dalam Python

- Cara Menghindari Diblokir Saat Web Crawling

- Kesimpulan

Memahami Web Crawler

Apa Itu Web Crawler?

Web crawler, sering diibaratkan sebagai penjelajah digital yang tekun, secara terus-menerus menjelajahi luasnya internet. Misi utamanya? Menjelajahi situs web secara sistematis, mengindeks segala sesuatu yang dilewati. Awalnya dirancang untuk mesin pencari agar menciptakan hasil pencarian yang cepat, bot ini telah berkembang. Kini, mereka memangku peran dalam berbagai hal mulai dari aplikasi kupon hingga alat SEO, mengumpulkan judul, gambar, kata kunci, dan tautan saat menjelajah. Selain mengindeks, mereka juga bisa mengambil konten, melacak perubahan halaman web, bahkan menambang data. Bertemu dengan web spider: menjelajahi World Wide Web, menyusun jaringan informasi digital.

Cara Kerja Web Crawler?

Web crawler beroperasi dengan menjelajahi halaman web secara sistematis, mulai dari set awal yang ditentukan dan mengikuti tautan hipertext untuk menemukan halaman baru. Sebelum memulai pencarian, bot ini terlebih dahulu memeriksa file robots.txt dari situs, yang menentukan panduan yang ditetapkan oleh pemilik situs mengenai halaman mana yang bisa dicari dan tautan mana yang bisa diikuti.

Dengan luasnya internet, web crawler memprioritaskan halaman tertentu berdasarkan aturan yang telah ditetapkan. Mereka mungkin lebih memilih halaman dengan banyak tautan eksternal yang mengarah ke mereka, volume lalu lintas yang lebih tinggi, atau otoritas merek yang lebih besar. Strategi prioritas ini berakar pada asumsi bahwa halaman dengan lalu lintas dan tautan yang signifikan lebih mungkin menawarkan konten otoritatif dan bernilai yang dicari pengguna. Algoritma juga membantu crawler mengevaluasi relevansi konten dan kualitas tautan yang ditemukan di setiap halaman.

Saat menjelajah, web crawler mencatat secara cermat meta tag dari setiap situs, yang memberikan metadata penting dan informasi kata kunci. Data ini memainkan peran penting dalam cara mesin pencari mengurutkan dan menampilkan halaman dalam hasil pencarian, membantu pengguna dalam navigasi dan pengambilan informasi.

Web Crawler dalam Python

Web crawler dalam Python adalah skrip otomatis yang dirancang untuk menjelajahi internet secara terstruktur, dimulai dari URL awal yang ditentukan. Bot ini beroperasi dengan mengirim permintaan HTTP ke server web, mengambil konten HTML, dan kemudian menganalisis konten ini menggunakan perpustakaan seperti BeautifulSoup atau lxml. Perpustakaan-perpustakaan ini memungkinkan crawler untuk mengekstrak informasi yang relevan seperti judul halaman, tautan, gambar, dan teks.

Kemampuan Python dalam menangani permintaan web dan parsing HTML membuatnya sangat cocok untuk pengembangan web crawler. Crawler biasanya mematuhi aturan yang ditetapkan dalam file robots.txt dari situs, yang menentukan bagian mana dari situs yang bisa dikunjungi dan mana yang harus dihindari. Kepatuhan ini membantu menjaga praktik crawling yang etis dan menghormati preferensi pemilik situs.

Selain mengindeks halaman untuk mesin pencari, web crawler Python digunakan untuk berbagai tujuan seperti penambangan data, pengumpulan konten, pemantauan perubahan situs web, bahkan pengujian otomatis. Dengan mengikuti tautan dalam halaman, crawler menjelajahi situs web, membangun peta halaman yang saling terhubung yang meniru struktur web. Proses ini memungkinkan mereka mengumpulkan data secara sistematis dari berbagai sumber, membantu tugas seperti analisis kompetitif, penelitian pasar, dan pengambilan informasi.

Membangun Web Crawler Python

Sebelum memulai membangun web crawler, penting untuk menyiapkan lingkungan pengembangan Anda dengan alat dan perpustakaan yang diperlukan.

Prasyarat

- Python: Instal Python 3.x dari python.org.

- Perpustakaan Requests: Untuk mengirim permintaan HTTP.

- Beautiful Soup: Untuk memproses dokumen HTML dan XML.

- Selenium (opsional): Untuk menangani konten yang dirender JavaScript dan CAPTCHA.

bash

pip install requests beautifulsoup4 seleniumMembangun Web Crawler Sederhana

Mari kita membuat crawler web dasar menggunakan Python dan tunjukkan cara mengekstrak tautan dan teks dari halaman web.

python

import requests

from bs4 import BeautifulSoup

def simple_crawler(url):

# Kirim permintaan HTTP

response = requests.get(url)

# Periksa apakah permintaan berhasil

if response.status_code == 200:

# Parsing konten dengan BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

# Contoh: Ekstrak semua tautan dari halaman

links = soup.find_all('a', href=True)

for link in links:

print(link['href'])

# Contoh: Ekstrak teks dari elemen tertentu

headings = soup.find_all(['h1', 'h2', 'h3'])

for heading in headings:

print(heading.text)

else:

print(f"Gagal mengambil konten dari {url}")

# Contoh penggunaan

simple_crawler('https://example.com')Cara Menghindari Diblokir Saat Web Crawling

Saat Anda memulai web crawling dalam Python, menghindari pemblokiran menjadi tantangan kritis. Banyak situs web memperkuat pertahanan mereka dengan langkah-langkah anti-bot, dirancang untuk mendeteksi dan menghentikan alat otomatis, sehingga memblokir akses ke halaman mereka.

Untuk mengatasi hambatan ini, pertimbangkan untuk menerapkan strategi berikut:

1. Mengatasi CAPTCHA

CAPTCHA adalah mekanisme pertahanan umum terhadap crawler otomatis. Mereka menantang pengguna untuk membuktikan bahwa mereka manusia dengan menyelesaikan tugas seperti mengidentifikasi objek atau memasukkan teks. Strategi terbaik untuk menangani CAPTCHA adalah dengan mengintegrasikan layanan penyelesaian CAPTCHA yang andal seperti CapSolver ke dalam alur kerja pengambilan data Anda, yang akan mempercepat proses penyelesaian tantangan ini. CapSolver menyediakan API dan alat untuk menyelesaikan berbagai jenis CAPTCHA secara programatik, memungkinkan integrasi yang mulus dengan skrip Python Anda. Panduan singkat cepat di bawah ini:

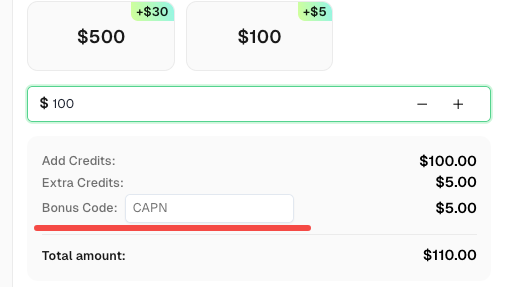

Klaim Kode Bonus CapSolver Anda

Jangan lewatkan kesempatan untuk mengoptimalkan operasi Anda lebih lanjut! Gunakan kode bonus CAPN saat mengisi ulang akun CapSolver Anda dan dapatkan bonus tambahan 5% untuk setiap pengisian ulang, tanpa batas. Kunjungi CapSolver untuk klaim bonus Anda sekarang!

Cara Menyelesaikan CAPTCHA Apa Pun dengan Capsolver Menggunakan Python:

Prasyarat

- Proxy yang berfungsi

- Python terinstal

- Kunci API CapSolver

🤖 Langkah 1: Instal Paket yang Diperlukan

Jalankan perintah berikut untuk menginstal paket yang diperlukan:

pip install capsolver

Berikut adalah contoh reCAPTCHA v2:

👨💻 Kode Python untuk menyelesaikan reCAPTCHA v2 dengan proxy Anda

Berikut adalah skrip contoh Python untuk menyelesaikan tugas tersebut:

python

import capsolver

# Pertimbangkan menggunakan variabel lingkungan untuk informasi sensitif

PROXY = "http://username:password@host:port"

capsolver.api_key = "Kunci API CapSolver Anda"

PAGE_URL = "URL_HALAMAN"

PAGE_KEY = "KUNCI_SITUS"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("Menyelesaikan reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solusi: ", solution)

if __name__ == "__main__":

main()👨💻 Kode Python untuk menyelesaikan reCAPTCHA v2 tanpa proxy

Berikut adalah skrip contoh Python untuk menyelesaikan tugas tersebut:

python

import capsolver

# Pertimbangkan menggunakan variabel lingkungan untuk informasi sensitif

capsolver.api_key = "Kunci API CapSolver Anda"

PAGE_URL = "URL_HALAMAN"

PAGE_KEY = "KUNCI_SITUS"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("Menyelesaikan reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solusi: ", solution)

if __name__ == "__main__":

main()2. Menghindari Larangan IP dan Batas Permintaan

Situs web sering menerapkan pembatasan jumlah permintaan yang dapat dilakukan crawler dalam waktu tertentu untuk mencegah beban berlebihan dan penyalahgunaan.

Strategi untuk Menghindari Deteksi:

- Putar Alamat IP: Gunakan server proxy atau VPN untuk mengganti alamat IP dan menghindari trigger batas permintaan.

- Patuhi robots.txt: Periksa dan patuhi aturan yang ditentukan dalam file robots.txt dari situs untuk menghindari pemblokiran.

- Kebijakan Kesopanan: Terapkan jeda antara permintaan (waktu jeda pencarian) untuk meniru perilaku penjelajahan manusia.

Kesimpulan

Web crawling memberdayakan bisnis dan peneliti untuk mengakses sejumlah besar data secara efisien. Namun, menghadapi tantangan deteksi otomatis dan pemblokiran memerlukan perencanaan strategis dan kepatuhan terhadap standar etis. Dengan memanfaatkan perpustakaan Python yang kuat dan menerapkan praktik terbaik, pengembang dapat membangun crawler yang tangguh yang mampu mengekstrak wawasan bernilai sambil menghormati batasan yang ditetapkan oleh situs web.

Pada intinya, menguasai web crawling melibatkan tidak hanya keahlian teknis tetapi juga pemahaman yang tajam tentang etika web dan pertimbangan hukum. Dengan alat dan strategi ini, Anda dapat memanfaatkan kekuatan web crawling secara bertanggung jawab dan efektif dalam proyek Anda.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Larangan IP pada 2026: Bagaimana Cara Kerjanya dan Cara Praktis untuk Mengelaknya

Pelajari cara menghindari pembatasan IP pada 2026 dengan panduan lengkap kami. Temukan teknik pemblokiran IP modern dan solusi praktis seperti proxy residensial dan solver CAPTCHA.

Emma Foster

26-Jan-2026

Cara Menyelesaikan Captcha di Maxun dengan Integrasi CapSolver

Panduan praktis untuk mengintegrasikan CapSolver dengan Maxun dalam penggunaan nyata pengambilan data web. Pelajari cara mengelola reCAPTCHA, Cloudflare Turnstile, dan situs yang dilindungi CAPTCHA dengan menggunakan alur kerja pre-auth dan robot.

Adélia Cruz

21-Jan-2026

Cara menyelesaikan Captcha di Browser4 dengan integrasi CapSolver

Otomasi Browser4 dengan throughput tinggi dikombinasikan dengan CapSolver untuk menangani tantangan CAPTCHA dalam ekstraksi data web skala besar.

Anh Tuan

21-Jan-2026

Apa itu Bot Scraping dan Bagaimana Cara Membuatnya

Pelajari apa itu bot scraping dan cara membuatnya untuk ekstraksi data otomatis. Jelajahi alat terbaik, teknik navigasi keamanan, dan praktik scraping yang etis.

Emma Foster

16-Jan-2026

Scrapy vs. Selenium: Mana yang Terbaik untuk Proyek Scraping Web Anda?

Temukan kekuatan dan perbedaan antara Scrapy dan Selenium untuk pengambilan data web. Pelajari alat mana yang paling sesuai dengan proyek Anda dan cara mengatasi tantangan seperti CAPTCHA.

Emma Foster

14-Jan-2026

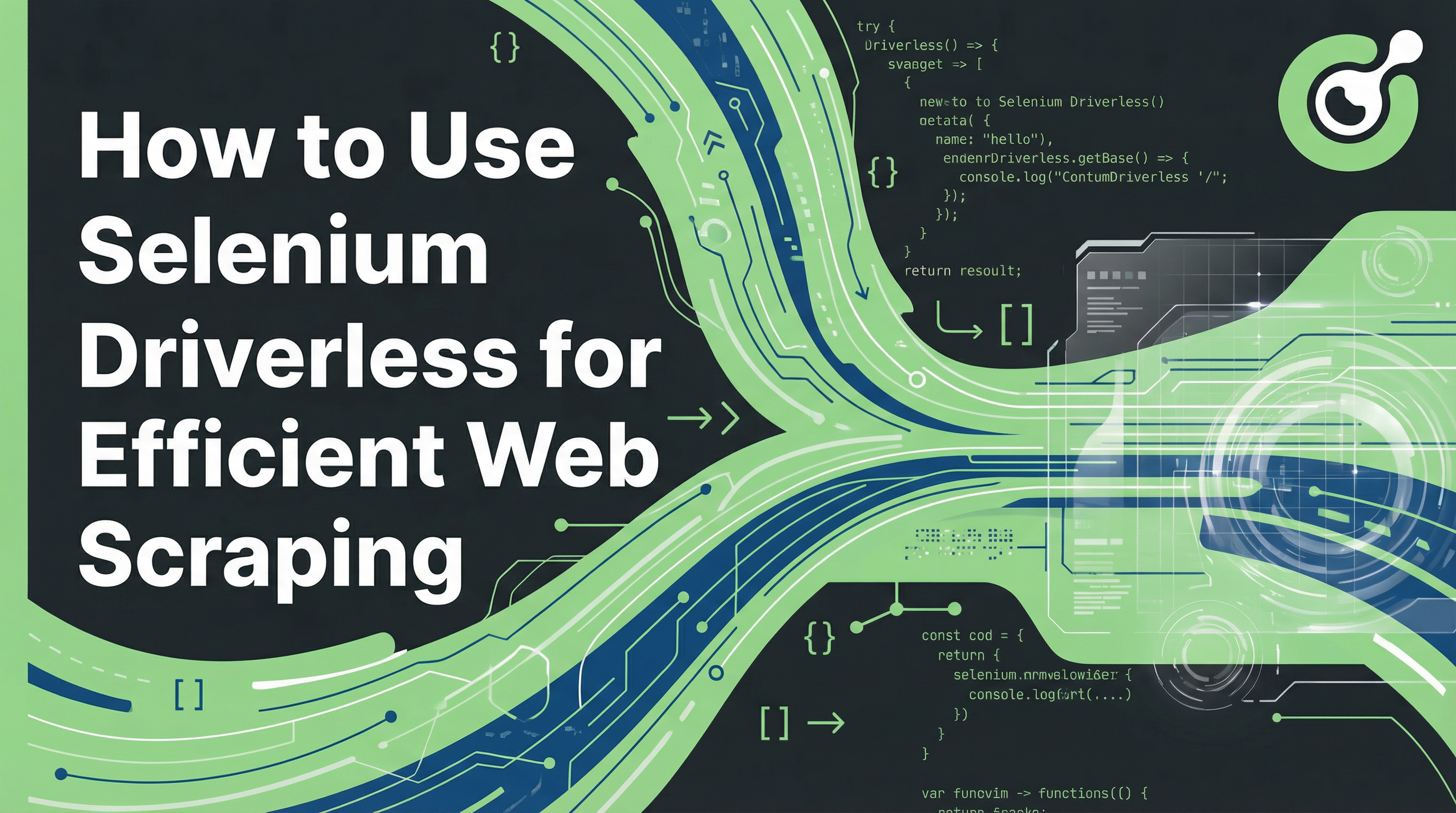

Cara Menggunakan Selenium Driverless untuk Pengambilan Data Web yang Efisien

Pelajari cara menggunakan Selenium Driverless untuk pengambilan data web yang efisien. Panduan ini memberikan instruksi langkah demi langkah tentang menyiapkan lingkungan Anda, menulis skrip Selenium Driverless pertama Anda, dan menangani konten dinamis. Mempermudah tugas pengambilan data web Anda dengan menghindari kompleksitas manajemen WebDriver tradisional, sehingga membuat proses ekstraksi data Anda lebih sederhana, lebih cepat, dan lebih portabel.

Aloísio Vítor

14-Jan-2026