Agen Pengguna Terbaik untuk Web Scraping & Cara Menggunakannya

Ethan Collins

Pattern Recognition Specialist

07-Mar-2025

Saat melakukan web scraping, menggunakan user agent yang salah dapat menyebabkan pemblokiran instan. Situs web sering bergantung pada user agent untuk membedakan antara pengguna nyata dan bot. Untuk menghindari deteksi, sangat penting untuk menggunakan user agent yang terformat dengan baik dan sering diperbarui dalam proyek web scraping Anda.

Dalam panduan ini, Anda akan menemukan:

- Apa itu user agent dan mengapa itu penting untuk web scraping

- Sebuah daftar user agent terbaik untuk scraping

- Cara mengatur dan memutar user agent di Python

- Praktik terbaik tambahan untuk mencegah pemblokiran

Mari selami! 🚀

Apa Itu User Agent?

User Agent (UA) adalah string yang dikirim dalam header permintaan HTTP yang mengidentifikasi browser, sistem operasi, dan detail lainnya. Server web menggunakan informasi ini untuk merender konten yang sesuai untuk perangkat pengguna.

Contoh String User Agent:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36Uraian:

Mozilla/5.0– Keluarga browser(Windows NT 10.0; Win64; x64)– Detail sistem operasiAppleWebKit/537.36 (KHTML, like Gecko)– Mesin renderingChrome/123.0.0.0– Versi browserSafari/537.36– Kerangka kerja kompatibilitas

Dengan memodifikasi user agent, Anda dapat membuat web scraper Anda tampak seperti browser nyata, mengurangi risiko deteksi.

Mengapa User Agent Penting untuk Web Scraping

Sebagian besar situs web ** menganalisis user agent** untuk menyaring lalu lintas bot. Jika scraper Anda mengirimkan user agent yang tidak valid atau usang, ia mungkin akan diblokir secara instan.

Dengan menggunakan user agent yang sesuai, Anda dapat:

- Meniru browser nyata dan menyatu dengan lalu lintas normal.

- Melewati perlindungan anti-bot yang memeriksa library scraping default.

- Meningkatkan tingkat keberhasilan permintaan dan menghindari CAPTCHA atau larangan IP.

Namun, menggunakan hanya satu user agent berulang kali masih dapat memicu sistem anti-bot. Inilah sebabnya mengapa memutar user agent sangat penting.

User Agent Terbaik untuk Web Scraping (Daftar Terbaru)

Berikut adalah daftar yang telah dikurasi dari user agent yang efektif untuk web scraping:

User Agent Google Chrome:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36User Agent Mozilla Firefox:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (Macintosh; Intel Mac OS X 14.4; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (X11; Linux i686; rv:124.0) Gecko/20100101 Firefox/124.0Browser Lain:

plaintext

Mozilla/5.0 (Macintosh; Intel Mac OS X 14_4_1) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/17.4.1 Safari/605.1.15

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36 Edg/123.0.2420.81💡 Tip: Anda dapat memeriksa user agent Anda sendiri dengan mengunjungi WhatIsMyUserAgent.

Cara Mengatur User Agent Kustom di Python

Banyak situs web menerapkan mekanisme deteksi bot yang memblokir permintaan dengan header user-agent yang hilang atau salah. Di bagian ini, mari kita gunakan berbagai cara untuk mengatur dan memutar user agent secara efisien.

1. Menggunakan Library requests

Cara paling sederhana untuk menentukan user agent adalah dengan memodifikasi header permintaan menggunakan library requests yang populer.

Contoh: Mengatur User Agent Statis

python

import requests

# Tentukan header dengan User-Agent kustom

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

# Kirim permintaan dengan User-Agent kustom

response = requests.get("https://httpbin.org/headers", headers=headers)

# Cetak header respons

print(response.text)Output:

json

{

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

}Ini mengkonfirmasi bahwa server menerima dan mengenali string user agent dengan benar.

2. Memutar User Agent untuk Anonimitas yang Lebih Baik

Menggunakan satu user agent berulang kali dapat menyebabkan pemblokiran. Untuk menghindari hal ini, putar user agent menggunakan daftar yang telah ditentukan.

Contoh: Memutar User Agent dengan random

python

import requests

import random

# Daftar user agent yang berbeda

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Pilih user agent secara acak

headers = {"User-Agent": random.choice(user_agents)}

# Kirim permintaan dengan user agent yang dipilih secara acak

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Dengan memutar user agent, scraper Anda tampak lebih seperti manusia dan mengurangi kemungkinan deteksi.

3. Menggunakan fake_useragent untuk Pembuatan User Agent Dinamis

Alih-alih mempertahankan daftar statis, Anda dapat menghasilkan user agent secara dinamis menggunakan library fake_useragent.

Instalasi:

sh

pip install fake-useragentContoh: Menghasilkan User Agent Acak

python

from fake_useragent import UserAgent

import requests

# Buat objek UserAgent

ua = UserAgent()

# Hasilkan user agent acak

headers = {"User-Agent": ua.random}

# Kirim permintaan dengan user agent yang dihasilkan secara dinamis

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Metode ini menyediakan berbagai macam user agent sambil tetap memperbaruinya.

4. Mengatur User Agent Kustom di Selenium

Saat menggunakan Selenium untuk web scraping, pengaturan user agent memerlukan modifikasi opsi browser.

Contoh: Mengatur User Agent di Chrome

python

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

# Konfigurasikan opsi Chrome

chrome_options = Options()

chrome_options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36")

# Mulai browser dengan user agent kustom

driver = webdriver.Chrome(options=chrome_options)

# Buka halaman uji untuk memverifikasi user agent

driver.get("https://httpbin.org/headers")

# Ekstrak dan cetak konten halaman

print(driver.page_source)

driver.quit()Dengan menggunakan alat otomatisasi browser seperti Selenium, Anda dapat mensimulasikan perilaku pengguna nyata dan melewati langkah-langkah anti-bot tingkat lanjut.

5. Memverifikasi User Agent Anda

Untuk memastikan user agent Anda diatur dengan benar, gunakan metode berikut:

- Periksa header respons dari

https://httpbin.org/headers - Gunakan alat pengembang browser (F12 > Network > Headers) untuk memeriksa permintaan

- Gunakan logging untuk mengkonfirmasi rotasi user agent di scraper

Contoh: Logging User Agent dalam Loop

python

import requests

import random

import time

# Daftar user agent

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Loop melalui permintaan

for i in range(5):

user_agent = random.choice(user_agents)

headers = {"User-Agent": user_agent}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(f"Permintaan {i+1} - User-Agent: {user_agent}")

time.sleep(2) # Tambahkan penundaan untuk menghindari pembatasan kecepatanScript ini mencatat user agent yang berbeda selama beberapa permintaan, membantu Anda men-debug strategi rotasi.

Cara Memutar User Agent dalam Skala Besar

Alih-alih menggunakan satu user agent statis, lebih baik memutarnya secara dinamis untuk menghindari deteksi. Berikut cara Anda dapat memutar user agent di Python:

python

import requests

import random

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

]

headers = {"User-Agent": random.choice(user_agents)}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Script ini memilih secara acak user agent dari daftar, membuat scraper Anda lebih sulit dideteksi.

Praktik Terbaik Tambahan untuk Menghindari Pemblokiran

Bahkan dengan user agent terbaik, web scraping membutuhkan teknik tambahan untuk tetap tidak terdeteksi:

- Gunakan proxy untuk menghindari larangan IP.

- Terapkan penundaan & interval acak di antara permintaan.

- Putar header dan pola permintaan untuk meniru perilaku manusia.

- Hindari scraping yang berlebihan untuk mencegah pemicuan batas kecepatan.

- Pantau kode respons untuk mendeteksi pemblokiran dan beradaptasi sesuai kebutuhan.

Bahkan dengan rotasi user-agent dan proxy dan semua kiat tersebut, situs web mungkin masih menerapkan teknik deteksi tingkat lanjut, seperti fingerprinting, tantangan JavaScript, dan verifikasi Captcha. Di sinilah CapSolver berperan.

CapSolver berspesialisasi dalam menyelesaikan tantangan Capttcha, memastikan web scraping tanpa gangguan. Dengan mengintegrasikan CapSolver, Anda dapat secara otomatis menyelesaikan CAPTCHA dan menjaga scraper Anda tetap berjalan lancar

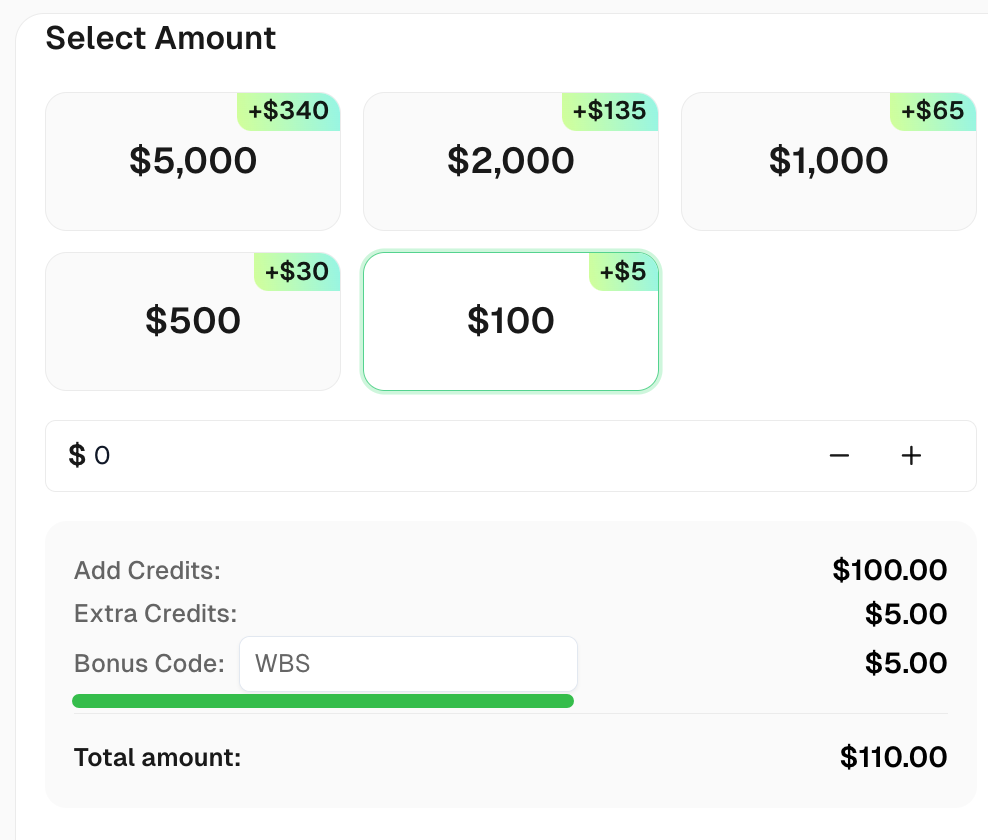

Klaim Kode Bonus Anda untuk solusi captcha terbaik - CapSolver: CAPTCHA. Setelah menukarkannya, Anda akan mendapatkan bonus tambahan 5% setelah setiap pengisian ulang, Tidak Terbatas

Kesimpulan

Menggunakan user agent yang tepat adalah langkah penting dalam web scraping. Dalam panduan ini, kami membahas:

✅ Apa itu user agent dan cara kerjanya

✅ Sebuah daftar user agent yang efektif untuk scraping

✅ Cara mengatur dan memutar user agent di Python

✅ Praktik terbaik tambahan untuk tetap tidak terdeteksi

Dengan menggabungkan rotasi user agent dengan teknik anti-deteksi lainnya, Anda dapat berhasil melakukan scraping data tanpa diblokir.

FAQ

1. Apa itu user agent dalam web scraping?

User agent adalah string yang mengidentifikasi browser atau perangkat lunak klien ke server web. Dalam web scraping, ini digunakan untuk meniru aktivitas pengguna nyata dan menghindari deteksi.

2. Apakah web scraping untuk penggunaan pribadi ilegal?

Web scraping umumnya legal untuk penggunaan pribadi, tetapi Anda harus menghormati ketentuan layanan situs web dan menghindari scraping data sensitif atau yang dilindungi hak cipta.

3. Apa tujuan rotasi user agent dalam web scraping?

Rotasi user agent membantu menghindari deteksi dan pemblokiran dengan membuat permintaan tampak berasal dari browser atau perangkat yang berbeda.

4. Bagaimana saya dapat mencegah pemblokiran saat melakukan web scraping?

Untuk menghindari pemblokiran, gunakan rotasi IP, pemecahan CAPTCHA, penundaan antara permintaan, dan pastikan kepatuhan dengan robots.txt situs.

5. Dapatkah web scraping memengaruhi kinerja situs web?

Ya, scraping terlalu sering dapat membebani server situs web. Penting untuk melakukan scraping secara bertanggung jawab dengan permintaan yang terbatas.

Pernyataan Kepatuhan: Informasi yang diberikan di blog ini hanya untuk tujuan informasi. CapSolver berkomitmen untuk mematuhi semua hukum dan peraturan yang berlaku. Penggunaan jaringan CapSolver untuk kegiatan ilegal, penipuan, atau penyalahgunaan sangat dilarang dan akan diselidiki. Solusi penyelesaian captcha kami meningkatkan pengalaman pengguna sambil memastikan kepatuhan 100% dalam membantu menyelesaikan kesulitan captcha selama pengambilan data publik. Kami mendorong penggunaan layanan kami secara bertanggung jawab. Untuk informasi lebih lanjut, silakan kunjungi Syarat Layanan dan Kebijakan Privasi.

Lebih lanjut

Larangan IP pada 2026: Bagaimana Cara Kerjanya dan Cara Praktis untuk Mengelaknya

Pelajari cara menghindari pembatasan IP pada 2026 dengan panduan lengkap kami. Temukan teknik pemblokiran IP modern dan solusi praktis seperti proxy residensial dan solver CAPTCHA.

Emma Foster

26-Jan-2026

Cara Menyelesaikan Captcha di Maxun dengan Integrasi CapSolver

Panduan praktis untuk mengintegrasikan CapSolver dengan Maxun dalam penggunaan nyata pengambilan data web. Pelajari cara mengelola reCAPTCHA, Cloudflare Turnstile, dan situs yang dilindungi CAPTCHA dengan menggunakan alur kerja pre-auth dan robot.

Adélia Cruz

21-Jan-2026

Cara menyelesaikan Captcha di Browser4 dengan integrasi CapSolver

Otomasi Browser4 dengan throughput tinggi dikombinasikan dengan CapSolver untuk menangani tantangan CAPTCHA dalam ekstraksi data web skala besar.

Anh Tuan

21-Jan-2026

Alat Ekstraksi Data Terbaik untuk 2026 (Perbandingan Lengkap)

Temukan alat ekstraksi data terbaik untuk 2026. Bandingkan platform terkemuka web scraping, ETL, dan berbasis AI untuk mengotomatisasi pengumpulan data dan alur kerja AI Anda.

Emma Foster

21-Jan-2026

Menyelesaikan Captcha Tanpa Batas dengan Pemecah Captcha Terbaik

Pelajari cara menyelesaikan Captcha tak terbatas dengan lancar menggunakan solver Captcha terbaik, panduan rinci tentang mengatur dan mengotomasi solusi Captcha secara efektif

Adélia Cruz

20-Jan-2026

Cara melewati verifikasi Cloudflare bahwa Anda manusia tanpa terjebak

Terjebak pada "memverifikasi bahwa Anda manusia" atau "Cloudflare Challenge"? Pelajari penyebab umum dan temukan solusi teknis untuk sistem otomatis agar melewati verifikasi setiap kali.

Rajinder Singh

20-Jan-2026